Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Информация по информатике

Содержание

- 1. Информация по информатике

- 2. ИНФОРМАТИКА Informanique -(франц.- INFORmation (информация) и autoMATIQUE

- 3. Цели исследования: Выяснить какая бывает информация. Почему

- 4. Растения вместе с микроорганизмами появившись

- 5. Почему появилась наука Информатика? К середине ХХ

- 6. С середины ХХ века стало уделяться внимание

- 7. Человек живет в мире информации,умножает информацию«… при

- 8. Какая бывает информация?Если до появления ЭВМ вопросы

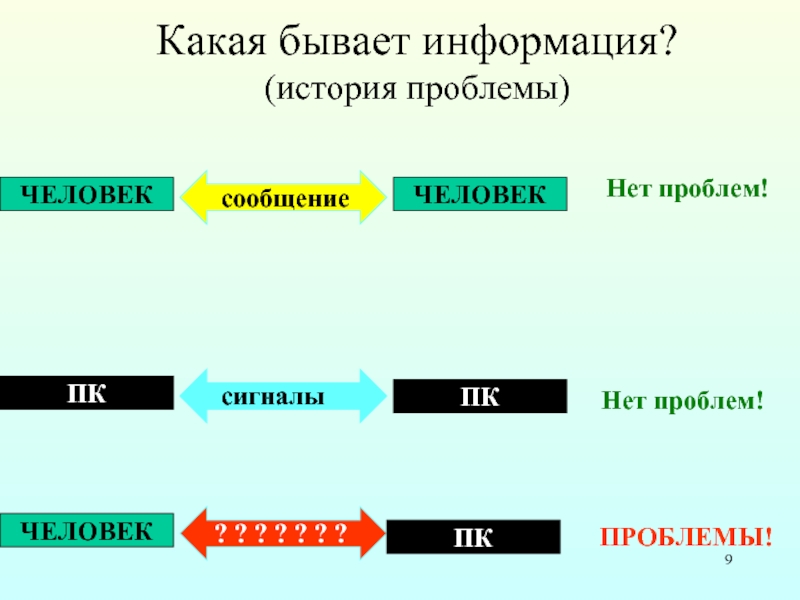

- 9. Какая бывает информация? (история проблемы)

- 10. Появилась ПРОБЛЕМАИ Н Ф О Р М

- 11. Три подхода к определению информацииСемантический подход;Технический подход;Научный подход.

- 12. Семантический подход (смысловой, житейский) Человек воспринимает информацию

- 13. Человек наблюдает, познает окружающий мир…Что он видит?Что

- 14. Не отдавая себе отчета, мы воспринимаем окружающий

- 15. По признанию специалистов, учение об информации возникло

- 16. Научный подход (вероятностный, энтропийный)Естественнонаучный подход в изучении

- 17. Научный подход к оценке сообщений был предложен

- 18. Энтропия – мера хаоса, количество информации –

- 19. Научное познание, используя принципы отождествления, идеализацию, упрощение,

- 20. Результаты исследованийИнформация, воспринимаемая органами чувств человека ,

- 21. БЛАГОДАРЮ ЗА ВНИМАНИЕ До новых встреч

- 22. Скачать презентанцию

Слайды и текст этой презентации

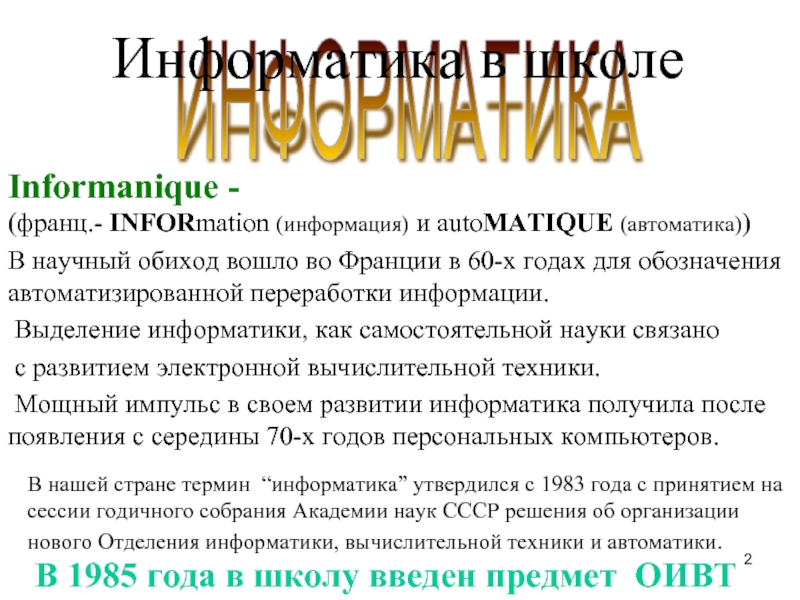

Слайд 2ИНФОРМАТИКА

Informanique -

(франц.- INFORmation (информация) и autoMATIQUE (автоматика))

В научный

обиход вошло во Франции в 60-х годах для обозначения автоматизированной

переработки информации.Выделение информатики, как самостоятельной науки связано

с развитием электронной вычислительной техники.

Мощный импульс в своем развитии информатика получила после появления с середины 70-х годов персональных компьютеров.

В нашей стране термин “информатика” утвердился с 1983 года с принятием на сессии годичного собрания Академии наук СССР решения об организации нового Отделения информатики, вычислительной техники и автоматики.

В 1985 года в школу введен предмет ОИВТ

Информатика в школе

Слайд 3Цели исследования:

Выяснить какая бывает информация.

Почему понятие «информация» не

имеет четкого, общепринятого определения?

Определить какая информация является предметом

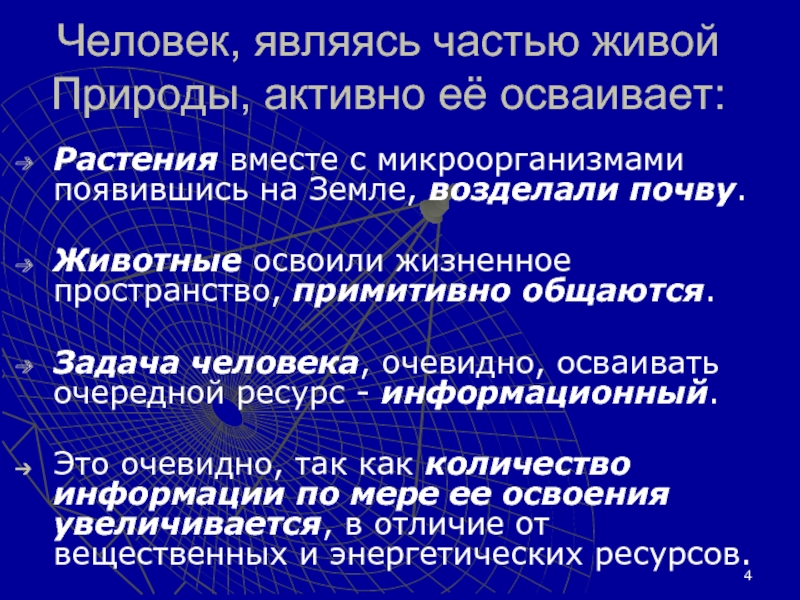

изучения Информатики?Слайд 4Растения вместе с микроорганизмами появившись на Земле, возделали

почву.

Животные освоили жизненное пространство, примитивно общаются.

Задача человека, очевидно,

осваивать очередной ресурс - информационный. Это очевидно, так как количество информации по мере ее освоения увеличивается, в отличие от вещественных и энергетических ресурсов.

Человек, являясь частью живой Природы, активно её осваивает:

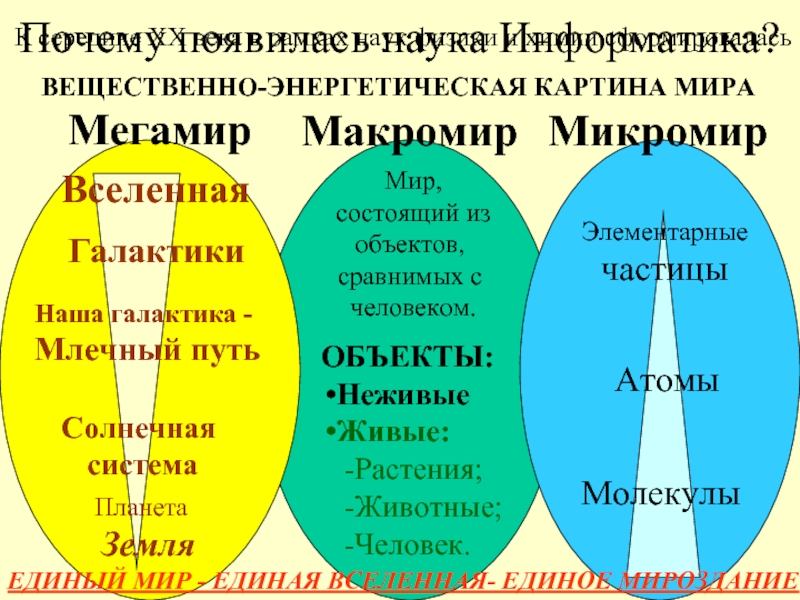

Слайд 5Почему появилась наука Информатика?

К середине ХХ века в рамках

наук физики и химии сформировалась

ВЕЩЕСТВЕННО-ЭНЕРГЕТИЧЕСКАЯ КАРТИНА МИРА

Микромир

Мегамир

ЕДИНЫЙ МИР -

ЕДИНАЯ ВСЕЛЕННАЯ- ЕДИНОЕ МИРОЗДАНИЕМакромир

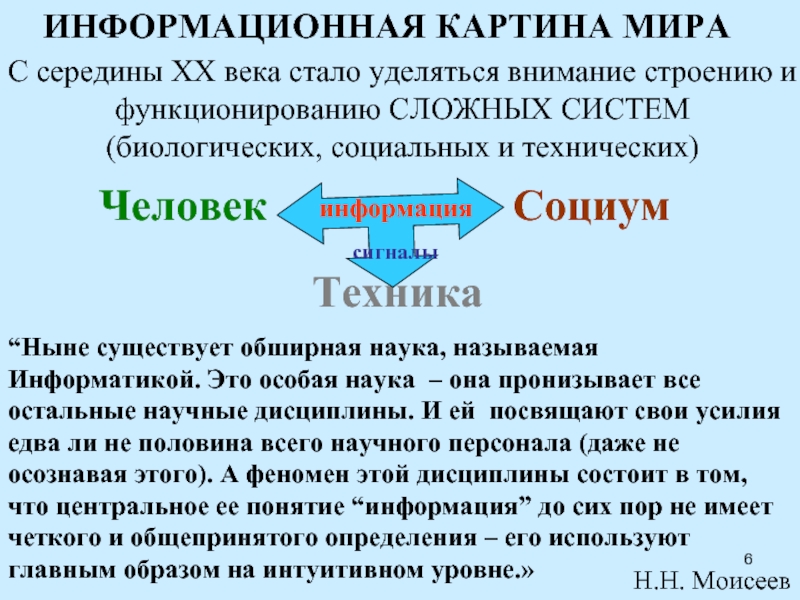

Слайд 6С середины ХХ века стало уделяться внимание строению и

функционированию СЛОЖНЫХ

СИСТЕМ

(биологических, социальных и технических)

ИНФОРМАЦИОННАЯ КАРТИНА МИРА

“Ныне существует обширная наука,

называемая Информатикой. Это особая наука – она пронизывает все остальные научные дисциплины. И ей посвящают свои усилия едва ли не половина всего научного персонала (даже не осознавая этого). А феномен этой дисциплины состоит в том, что центральное ее понятие “информация” до сих пор не имеет четкого и общепринятого определения – его используют главным образом на интуитивном уровне.»Н.Н. Моисеев

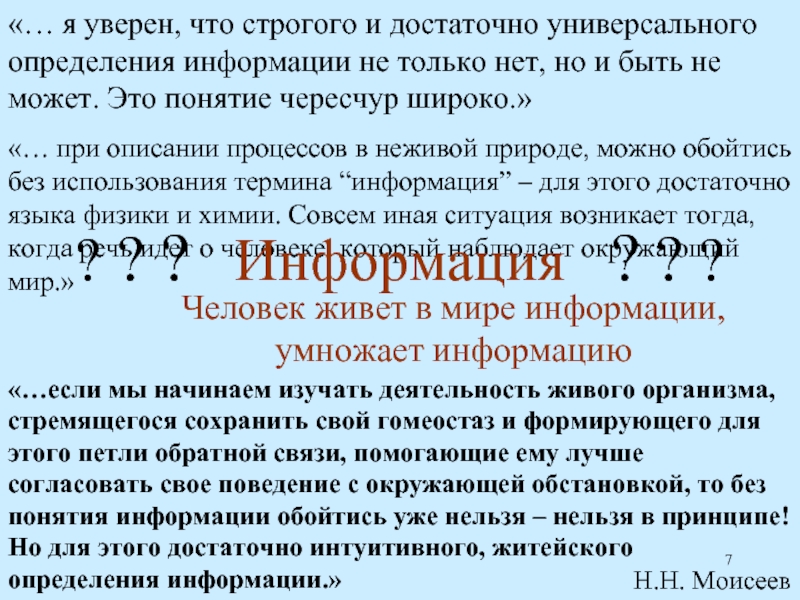

Слайд 7Человек живет в мире информации,

умножает информацию

«… при описании процессов в

неживой природе, можно обойтись без использования термина “информация” – для

этого достаточно языка физики и химии. Совсем иная ситуация возникает тогда, когда речь идет о человеке, который наблюдает окружающий мир.»? ? ? Информация ? ? ?

«… я уверен, что строгого и достаточно универсального определения информации не только нет, но и быть не может. Это понятие чересчур широко.»

«…если мы начинаем изучать деятельность живого организма, стремящегося сохранить свой гомеостаз и формирующего для этого петли обратной связи, помогающие ему лучше согласовать свое поведение с окружающей обстановкой, то без понятия информации обойтись уже нельзя – нельзя в принципе! Но для этого достаточно интуитивного, житейского определения информации.»

Н.Н. Моисеев

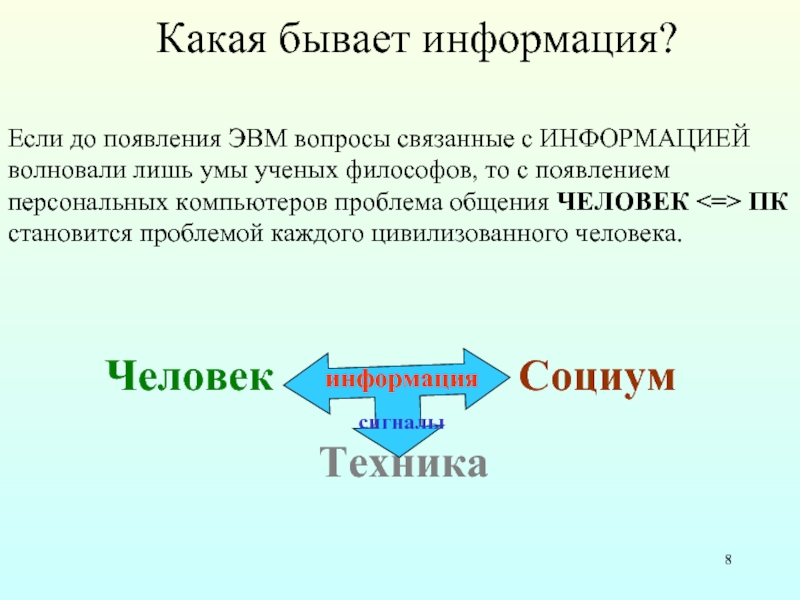

Слайд 8Какая бывает информация?

Если до появления ЭВМ вопросы связанные с ИНФОРМАЦИЕЙ

волновали

лишь умы ученых философов, то с появлением

персональных компьютеров проблема общения

ЧЕЛОВЕК <=> ПКстановится проблемой каждого цивилизованного человека.

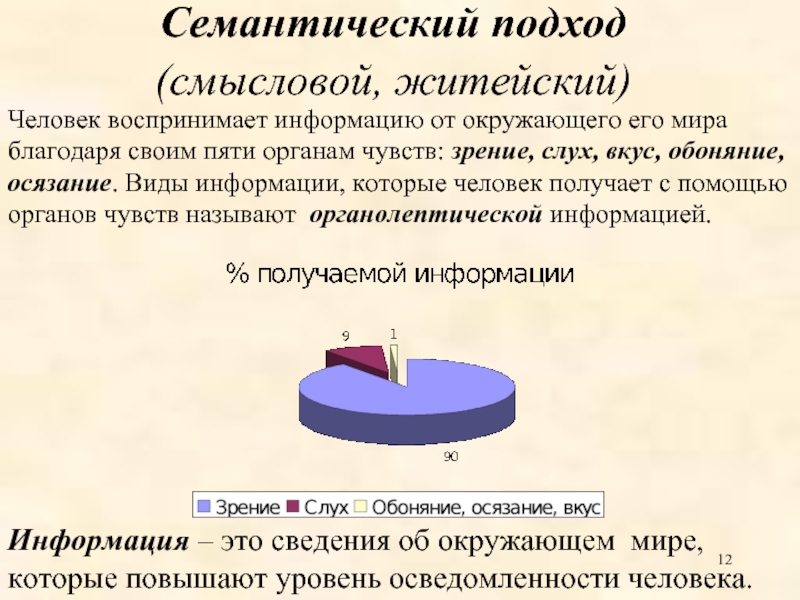

Слайд 12Семантический подход

(смысловой, житейский)

Человек воспринимает информацию от окружающего его мира

благодаря своим пяти органам чувств: зрение, слух, вкус, обоняние, осязание.

Виды информации, которые человек получает с помощью органов чувств называют органолептической информацией.Информация – это сведения об окружающем мире, которые повышают уровень осведомленности человека.

Слайд 13Человек наблюдает, познает окружающий мир…

Что он видит?

Что значит для него

та информация, на основании которой он будет принимать то или

иное решение?Что является носителем такой информации?

Можно ли оценить объем и нужно ли это?

Какие тайные пути ведут человека к использованию информации?

...оценка информации носит субъективный характер, поскольку зависит от способности субъекта ею воспользоваться.

...бессмысленно говорить о ценности информации как о некоторой абсолютной характеристике.

Только тогда, когда существует четко

поставленная цель и алгоритм принятия

решения, полностью раскрываются значение,

ценность и смысл информации.

Н.Н. Моисеев

Слайд 14Не отдавая себе отчета, мы воспринимаем

окружающий нас мир как

единое целое.

Но если мы захотим изучить некоторое явление, объект

или процесс мы начинаем рассматривать его как систему – совокупность объектов объединенных по определенным правилам.

Слайд 15По признанию специалистов, учение об информации возникло в силу потребностей

теории связи и кибернетики.

Ученые заявили, что они “полностью игнорировали

человеческую оценку информации”. Последовательному ряду из 100 букв,

например, они приписывают определенное значение информации,

не обращая внимание, имеет ли эта информация смысл и имеет ли

смысл практическое применение.

Количественный подход – наиболее разработанная ветвь теории информации.

В вычислительной технике приняты две стандартные единицы

измерения: бит и байт. Бит – один символ двоичного алфавита.

Байт (международная система СИ) – это восьмиразрядный

двоичный код. Алфавит этого представления – 28 = 256, и включает

все символы терминала ЭВМ. В силу малости этих величин её

измеряют также в килобайтах, мегабайтах, гигабайтах, терабайтах, петабайтах.

Технический подход

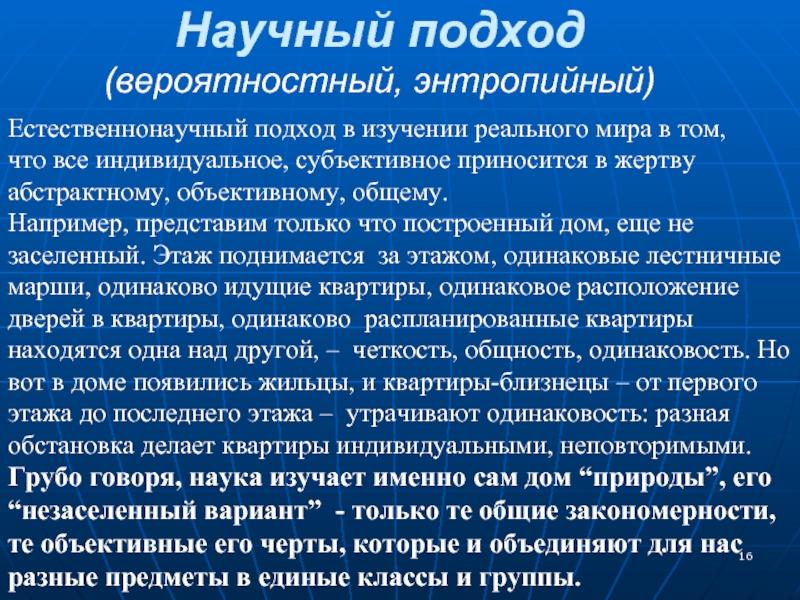

Слайд 16Научный подход

(вероятностный, энтропийный)

Естественнонаучный подход в изучении реального мира в том,

что все индивидуальное, субъективное приносится в жертву

абстрактному, объективному, общему.

Например, представим только что построенный дом, еще не заселенный. Этаж поднимается за этажом, одинаковые лестничные марши, одинаково идущие квартиры, одинаковое расположение дверей в квартиры, одинаково распланированные квартиры находятся одна над другой, – четкость, общность, одинаковость. Но вот в доме появились жильцы, и квартиры-близнецы – от первого этажа до последнего этажа – утрачивают одинаковость: разная обстановка делает квартиры индивидуальными, неповторимыми.

Грубо говоря, наука изучает именно сам дом “природы”, его

“незаселенный вариант” - только те общие закономерности, те объективные его черты, которые и объединяют для нас разные предметы в единые классы и группы.

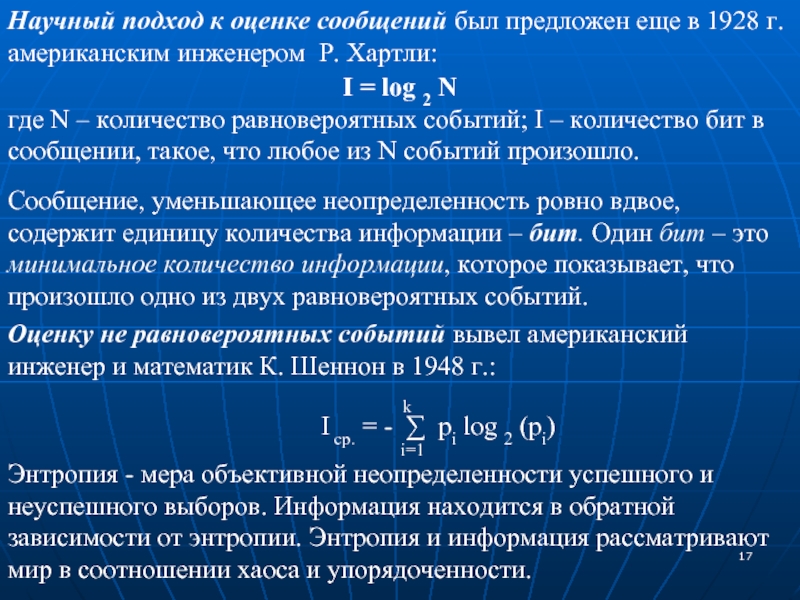

Слайд 17Научный подход к оценке сообщений был предложен еще в 1928

г. американским инженером Р. Хартли:

I = log 2 N

где N

– количество равновероятных событий; I – количество бит в сообщении, такое, что любое из N событий произошло.Сообщение, уменьшающее неопределенность ровно вдвое, содержит единицу количества информации – бит. Один бит – это минимальное количество информации, которое показывает, что произошло одно из двух равновероятных событий.

Оценку не равновероятных событий вывел американский инженер и математик К. Шеннон в 1948 г.:

k

I ср. = - ∑ pi log 2 (pi)

i=1

Энтропия - мера объективной неопределенности успешного и неуспешного выборов. Информация находится в обратной зависимости от энтропии. Энтропия и информация рассматривают мир в соотношении хаоса и упорядоченности.

Слайд 18Энтропия – мера хаоса,

количество информации – мера упорядоченности.

Чем

меньше мы знаем, тем больше неопределенность. Энтропию можно рассматривать как

меру недостатка информации, а информацию – как отрицательное слагаемое энтропии, ее негатив. Таким образом,информацию можно определить как негэнтропия.

Негэнтропийный принцип информации объединяет на новой основе энтропию и информацию – их нельзя трактовать порознь, они всегда должны исследоваться вместе.

Два способа измерения информации (технический и энтропийный), как правило, не совпадают, причем энтропийное (вероятностное) количество информации не может быть больше числа двоичных символов (битов) в сообщении. Если же оно меньше этого числа, говорят, что сообщение избыточно.

Слайд 19Научное познание, используя принципы отождествления, идеализацию, упрощение, абстракцию выявляет “жесткие”

черты изучаемого объекта, уточняет его свойства, очерчивает его контур, узнает

его “конструкцию” – формализует изучаемый процесс, явление.Формализация – упрощение изучаемого объекта, выявление его существенных свойств с целью применения к нему единообразных правил оперирования.

Основа формальной системы представлена совокупностью из четырех элементов:

исходящим алфавитом называется то, что формализуется;

системой синтаксических правил необходимой для того, чтобы из алфавита строить синтаксически правильные конструкции;

системой аксиом для осуществления этих правил;

системой семантических – смысловых – правил наполняющих синтаксические конструкции смыслом.

Формализованная информация

Слайд 20Результаты исследований

Информация, воспринимаемая органами чувств человека , не может быть

предметом изучения Информатики, так как она не может быть формализована.

Человек

познающий рефлексирует. В результате анализа полученная информация изменяет свою форму, становится дискретной и может быть представлена в виде символов, сигналов, … На этой стадии вырабатываются ЗНАНИЯ.Информация представленная в виде сигналов без проблем обрабатывается техникой.

Предметом изучения науки Информатика является формализованная информация. Один из примеров формализованной информации—высказывания Алгебры логики.

Оценка информации (знания) носит субъективный характер, поскольку зависит от способности субъекта ею воспользоваться