Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

В 1948 г. Клод Шеннон в своих работах по теории связи выписывает формулы для

Содержание

- 1. В 1948 г. Клод Шеннон в своих работах по теории связи выписывает формулы для

- 2. То, что событие случайно, означает отсутствие полной

- 3. Для определения явного вида функции f(n) рассмотрим

- 4. Следовательно, мера суммарной неопределенности должна быть равна

- 5. Вновь рассмотрим опыт с n равновероятными исходами.

- 6. Теперь попробуем обобщить формулу (2) на ситуацию,

- 7. Свойства энтропииЭнтропия сложного опыта, состоящего из нескольких

- 8. Поскольку α и β - независимы, то

- 9. Теперь рассмотрим ситуацию, когда имеются два опыта

- 10. Условная энтропия Найдем энтропию сложного опыта α ^

- 11. (8)(9)(10)

- 12. Свойства условной энтропии

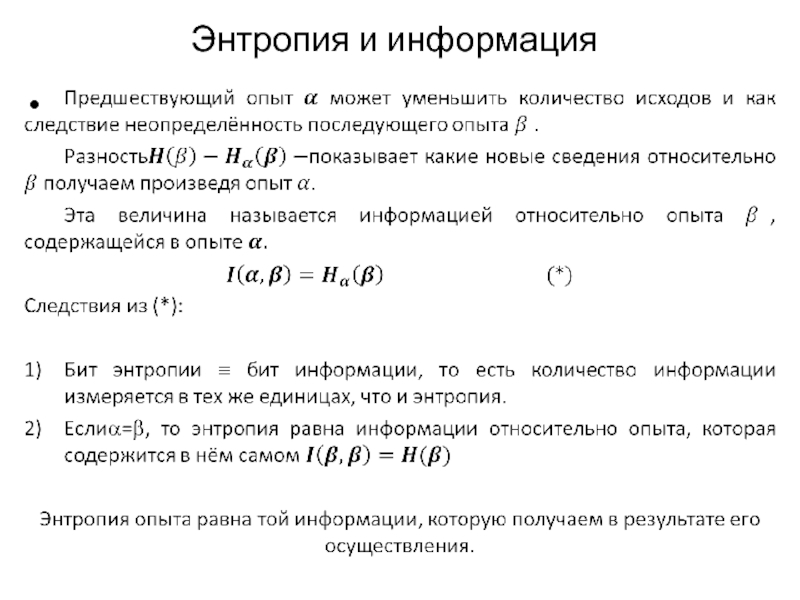

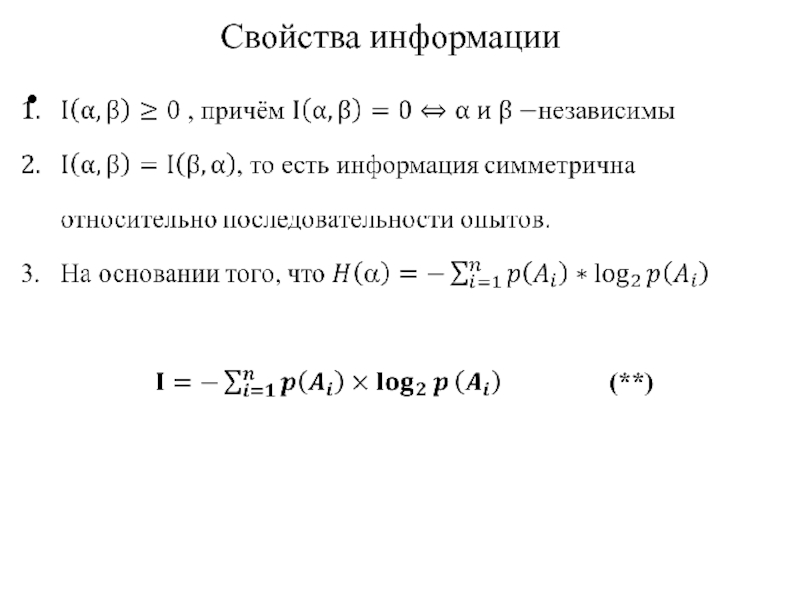

- 13. Энтропия и информация

- 14. Свойства информации

- 15. Задача 1Пусть опыт состоит в извлечении

- 16. Слайд 16

- 17. Задача 4Некто задумал целое число в интервале

- 18. Свойства количества информации и энтропии

- 19. Слайд 19

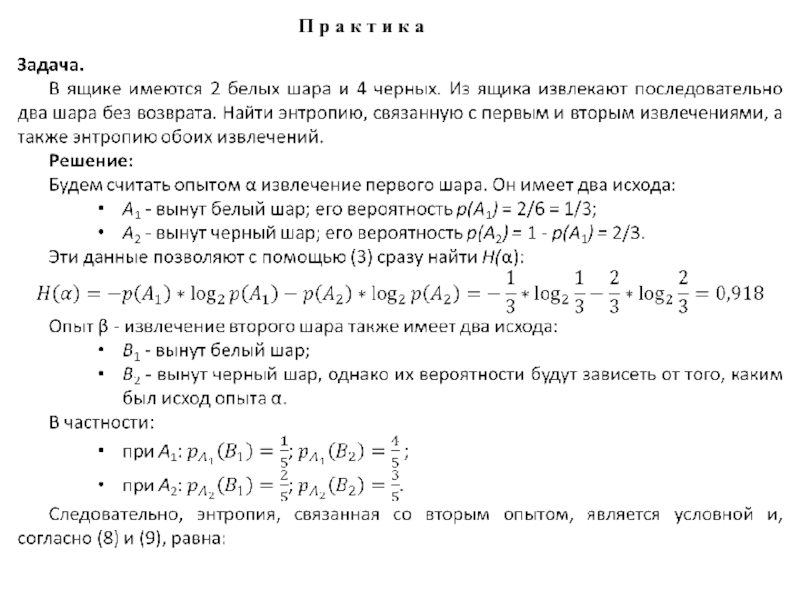

- 20. П р а к т и к а

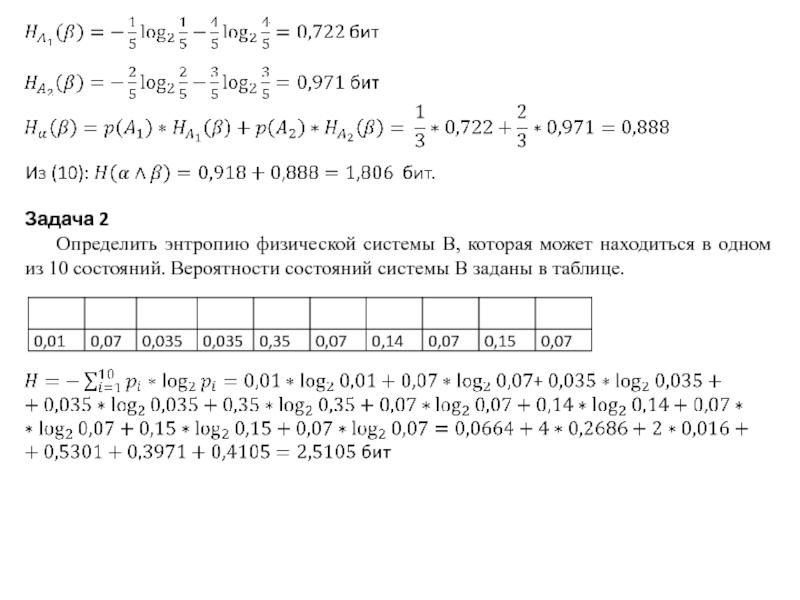

- 21. Задача 2Определить энтропию физической системы B, которая

- 22. Слайд 22

- 23. Слайд 23

- 24. Скачать презентанцию

Слайды и текст этой презентации

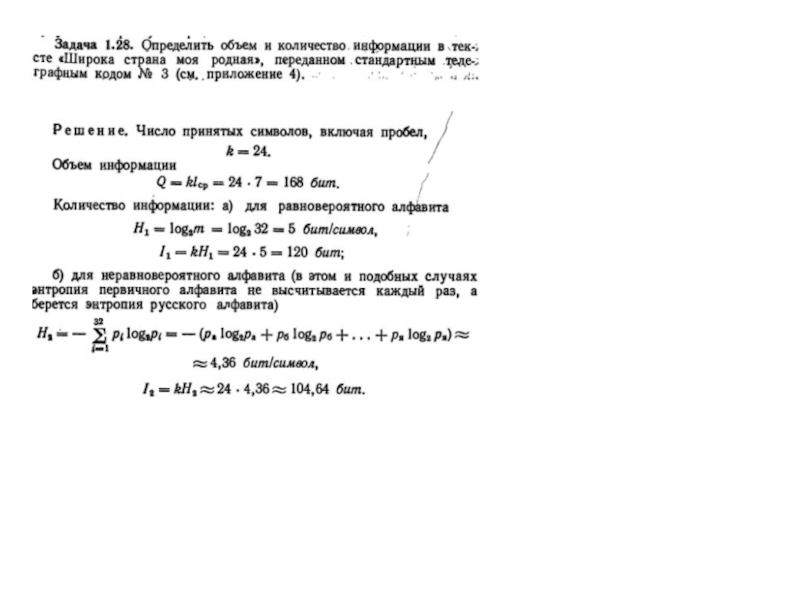

Слайд 1В 1948 г. Клод Шеннон в своих работах по теории

связи выписывает формулы для вычисления количества информация и энтропии.

по совету патриарха компьютерной эры фон Неймана, отметившего, что полученные Шенноном для теории связи формулы для ее расчета совпали с соответствующими формулами статистической физики, а также то, что "точно никто не знает" что же такое энтропия.Слайд 2То, что событие случайно, означает отсутствие полной уверенности в его

наступлении, что, в свою очередь, создает неопределенность в исходах опытов,

связанных с данным событием. Безусловно, степень неопределенности различна для разных ситуаций.Для практики важно иметь возможность произвести численную оценку неопределенности разных опытов. Попробуем ввести такую количественную меру неопределенности

Энтропия

Рассмотри опыт с п равновероятных исходов. Очевидно, что неопределенность каждого из них зависит от n, т.е. мера неопределенности является функцией числа исходов f(n).

Можно указать некоторые свойства этой функции:

f(1) = 0, поскольку при п = 1 исход опыта не является случайным и, следовательно, неопределенность отсутствует;

f(n) возрастает с ростом п, поскольку чем больше число возможных исходов, тем более затруднительным становится предсказание результата опыта.

Энтропия как мера неопределенности

Слайд 3Для определения явного вида функции f(n) рассмотрим два независимых опыта

α и β с количествами равновероятных исходов, соответственно пα и

пβ.Пусть имеет место сложный опыт, который состоит в одновременном выполнении опытов α и β; число возможных его исходов равно пα ∙ пβ, причем, все они равновероятны.

Очевидно, неопределенность исхода такого сложного опыта α ^ β будет больше неопределенности опыта α, поскольку к ней добавляется неопределенность β;

мера неопределенности сложного опыта равна f(nα ∙ nβ). С другой стороны, меры неопределенности отдельных α и β составляют, соответственно, f(nα) и f(nβ).

В первом случае (сложный опыт) проявляется общая (суммарная) неопределенность совместных событий, во втором - неопределенность каждого из событий в отдельности. Однако из независимости α и β следует, что в сложном опыте они никак не могут повлиять друг на друга и, в частности, α не может оказать воздействия на неопределенность β, и наоборот.

Слайд 4Следовательно, мера суммарной неопределенности должна быть равна сумме мер неопределенности

каждого из опытов, т.е. мера неопределенности аддитивна:

f(nα ∙ nβ). =

f(пα) + f(пβ)За меру неопределенности опыта с п равновероятными исходами можно принять число log(n).

То есть

f(n) = log (n) (1)

Следует заметить, что выбор основания логарифма в данном случае значения не имеет, поскольку в силу известной формулы преобразования логарифма от одного основания к другому (logbn=logba*logan)

Единица измерения неопределенности при двух возможных равновероятных исходах опыта называется бит.

Эта величина получила название энтропия. В дальнейшем будем обозначать ее Н.

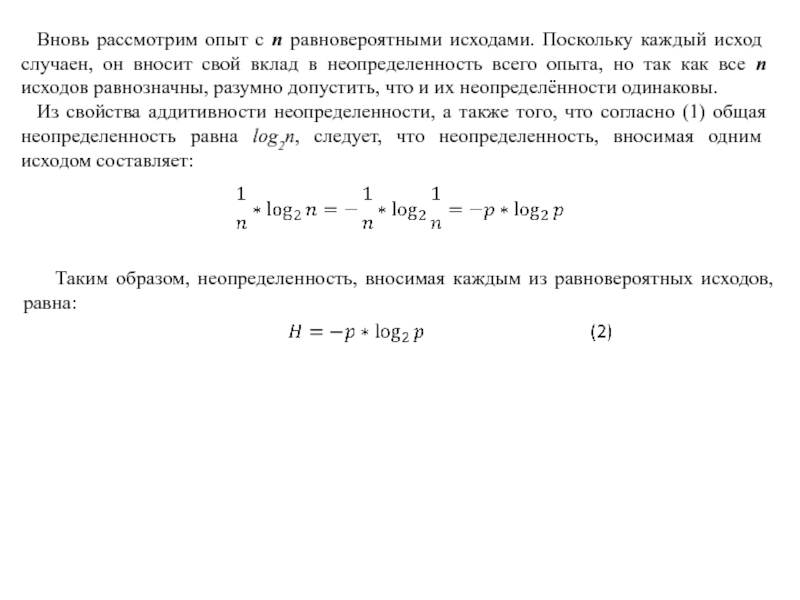

Слайд 5Вновь рассмотрим опыт с n равновероятными исходами. Поскольку каждый исход

случаен, он вносит свой вклад в неопределенность всего опыта, но

так как все n исходов равнозначны, разумно допустить, что и их неопределённости одинаковы.Из свойства аддитивности неопределенности, а также того, что согласно (1) общая неопределенность равна log2n, следует, что неопределенность, вносимая одним исходом составляет:

Таким образом, неопределенность, вносимая каждым из равновероятных исходов, равна:

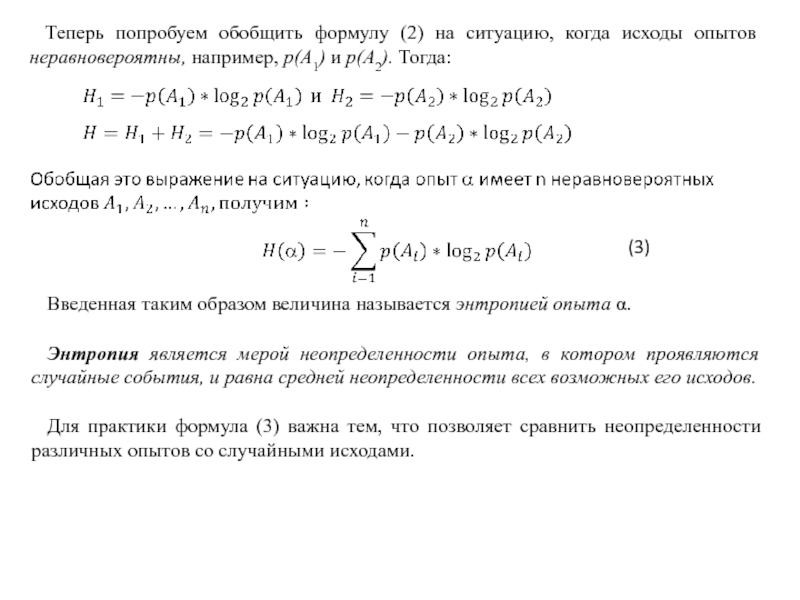

Слайд 6Теперь попробуем обобщить формулу (2) на ситуацию, когда исходы опытов

неравновероятны, например, р(А1) и р(А2). Тогда:

Введенная таким образом величина называется

энтропией опыта . Энтропия является мерой неопределенности опыта, в котором проявляются случайные события, и равна средней неопределенности всех возможных его исходов.

Для практики формула (3) важна тем, что позволяет сравнить неопределенности различных опытов со случайными исходами.

(3)

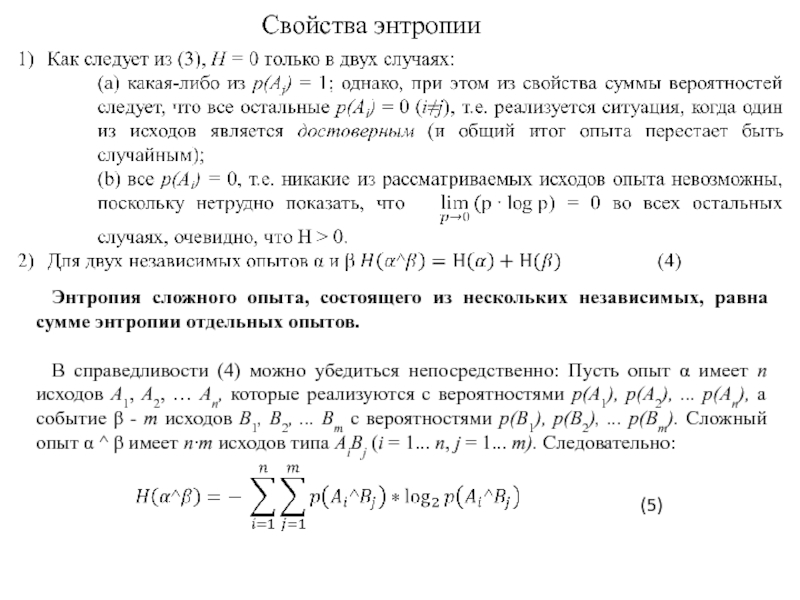

Слайд 7Свойства энтропии

Энтропия сложного опыта, состоящего из нескольких независимых, равна сумме

энтропии отдельных опытов.

В справедливости (4) можно убедиться непосредственно: Пусть опыт

α имеет п исходов А1, А2, … Ап, которые реализуются с вероятностями р(А1), р(А2), ... р(Ап), а событие β - т исходов B1, В2, ... Вт с вероятностями р(В1), р(В2), ... р(Вт). Сложный опыт α ^ β имеет п∙т исходов типа AiBj (i = 1... n, j = 1... т). Следовательно:(5)

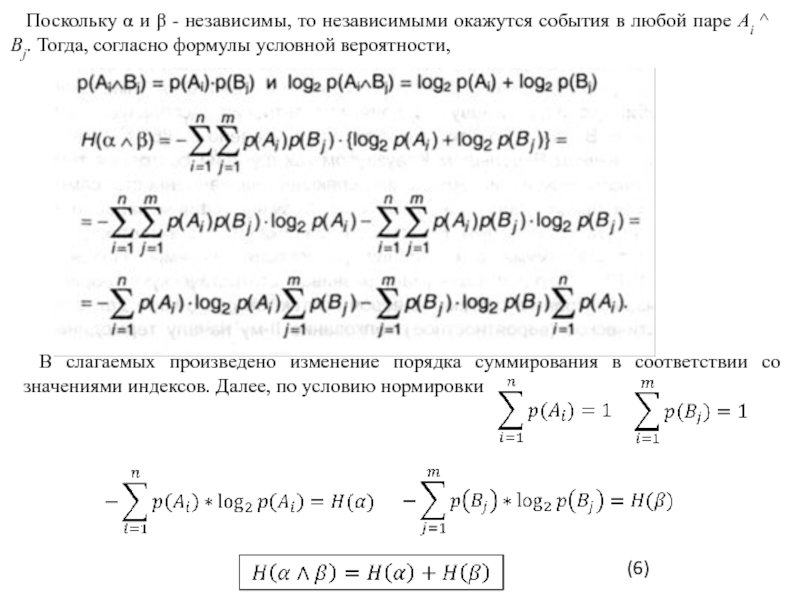

Слайд 8Поскольку α и β - независимы, то независимыми окажутся события

в любой паре Ai ^ Bj. Тогда, согласно формулы условной

вероятности,В слагаемых произведено изменение порядка суммирования в соответствии со значениями индексов. Далее, по условию нормировки

(6)

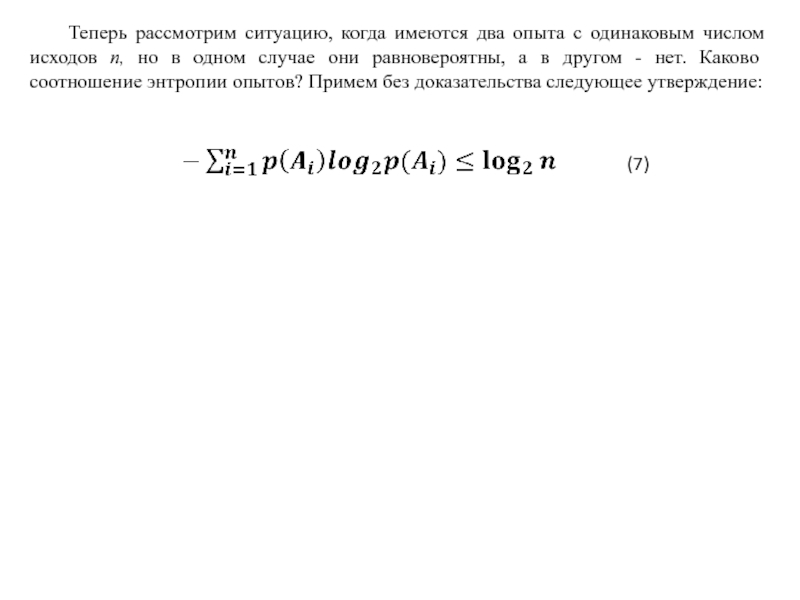

Слайд 9Теперь рассмотрим ситуацию, когда имеются два опыта с одинаковым числом

исходов п, но в одном случае они равновероятны, а в

другом - нет. Каково соотношение энтропии опытов? Примем без доказательства следующее утверждение:(7)

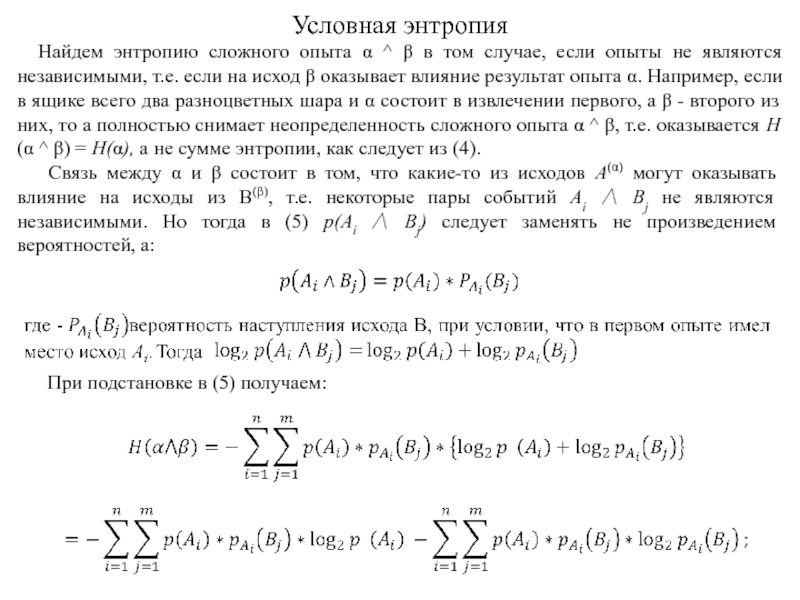

Слайд 10Условная энтропия

Найдем энтропию сложного опыта α ^ β в том

случае, если опыты не являются независимыми, т.е. если на исход

β оказывает влияние результат опыта α. Например, если в ящике всего два разноцветных шара и α состоит в извлечении первого, а β - второго из них, то а полностью снимает неопределенность сложного опыта α ^ β, т.е. оказывается Н(α ^ β) = H(α), a не сумме энтропии, как следует из (4).Связь между α и β состоит в том, что какие-то из исходов A(α) могут оказывать влияние на исходы из В(β), т.е. некоторые пары событий Ai Bj не являются независимыми. Но тогда в (5) p(Ai Bj) следует заменять не произведением вероятностей, а:

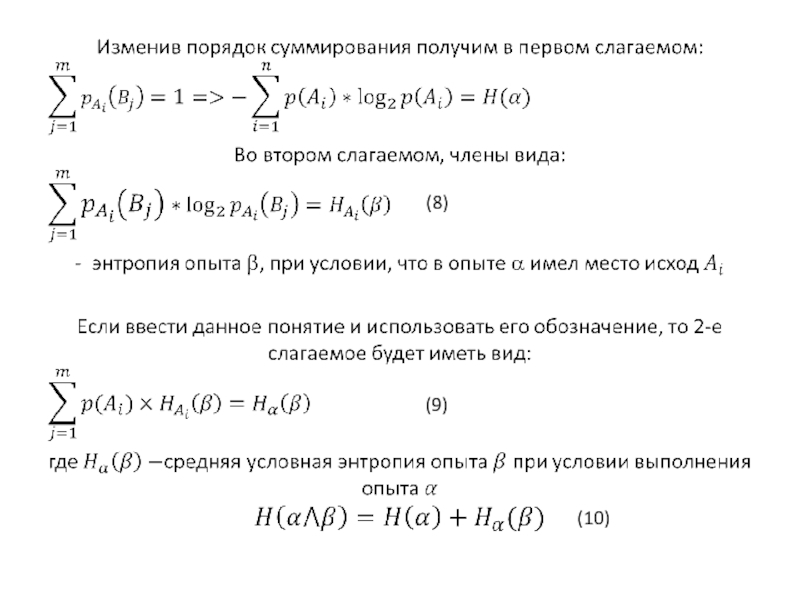

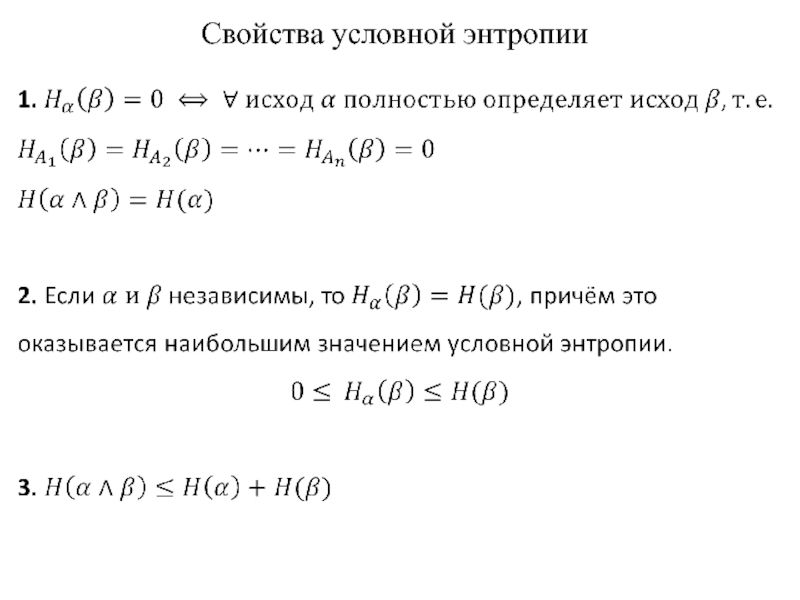

При подстановке в (5) получаем:

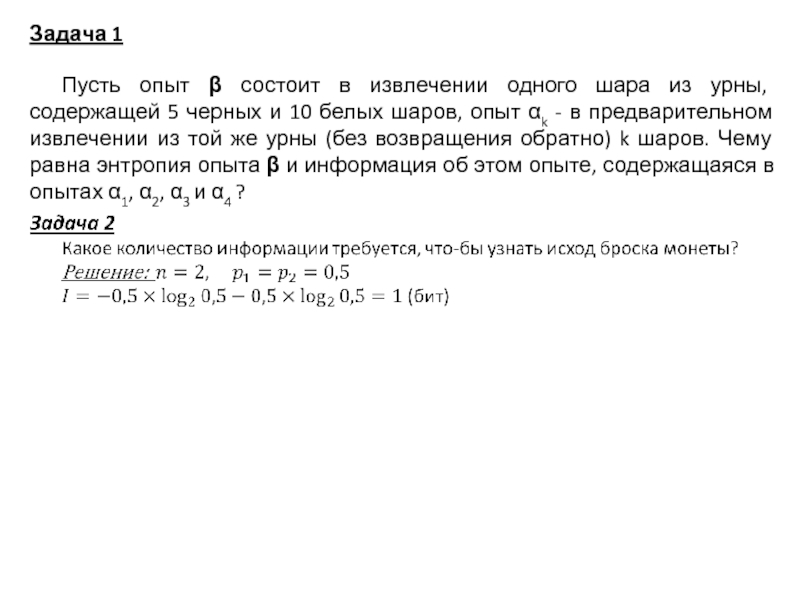

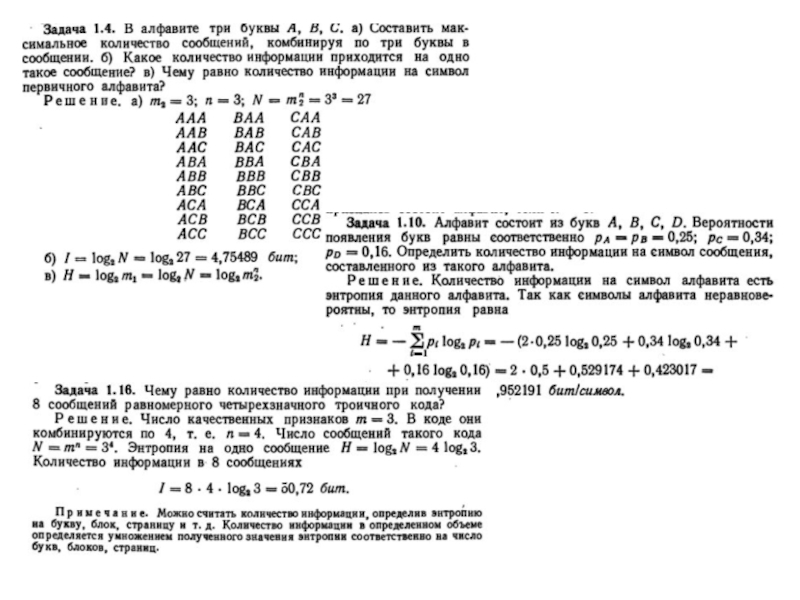

Слайд 15Задача 1

Пусть опыт состоит в извлечении одного шара из

урны, содержащей 5 черных и 10 белых шаров, опыт k

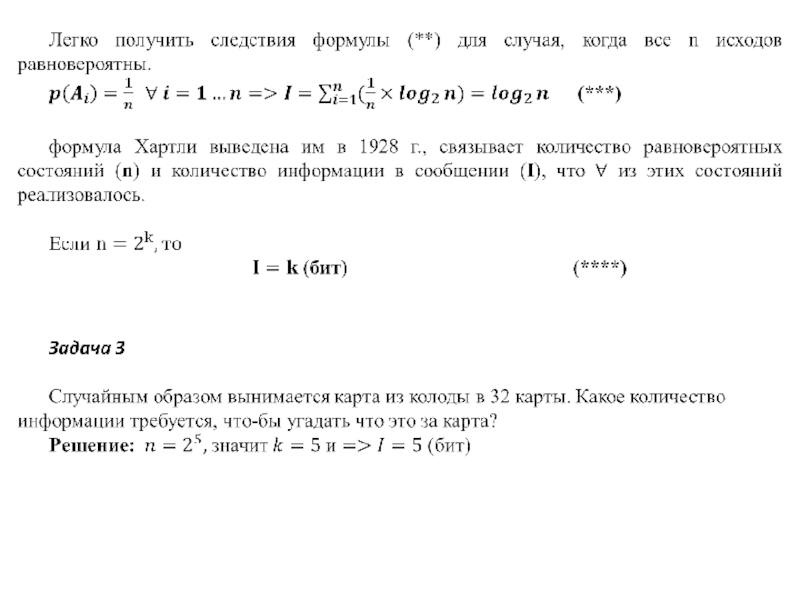

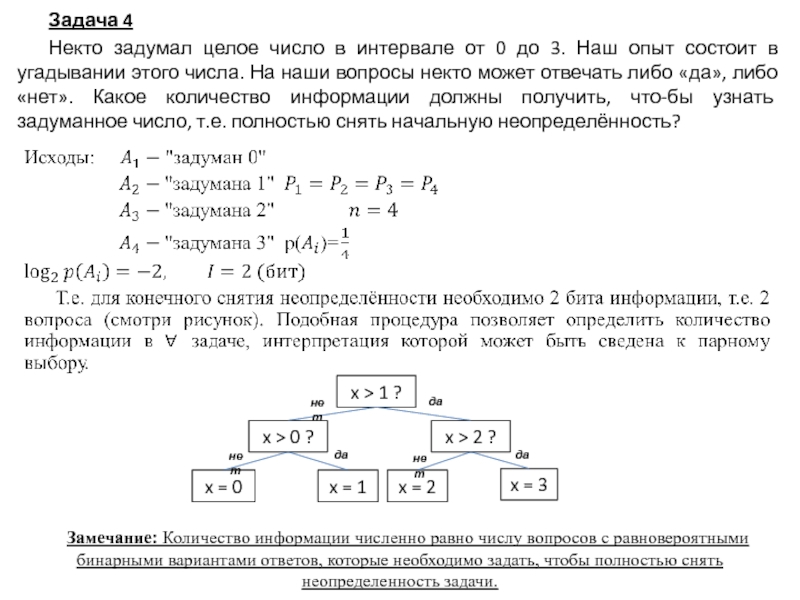

- в предварительном извлечении из той же урны (без возвращения обратно) k шаров. Чему равна энтропия опыта и информация об этом опыте, содержащаяся в опытах 1, 2, 3 и 4 ?Слайд 17Задача 4

Некто задумал целое число в интервале от 0 до

3. Наш опыт состоит в угадывании этого числа. На наши

вопросы некто может отвечать либо «да», либо «нет». Какое количество информации должны получить, что-бы узнать задуманное число, т.е. полностью снять начальную неопределённость?Замечание: Количество информации численно равно числу вопросов с равновероятными бинарными вариантами ответов, которые необходимо задать, чтобы полностью снять неопределенность задачи.