на основании последовательных вычислений целевой

функции f(x).

При решении задач нелинейного

программирования при отсутствии ограничений градиентные методы и методы, использующие вторые

производные, сходятся быстрее, чем прямые методы поиска. Тем не

менее, применяя на практике методы, использующие производные,

приходится сталкиваться с двумя главными препятствиями.

Во-первых, в задачах с достаточно большим числом переменных

довольно трудно или даже невозможно получить производные в виде

аналитических функций, необходимых для градиентного алгоритма или

алгоритма, использующего производные второго порядка.

Методы поиска не требуют регулярности и непрерывности целевой

функции и существования производных.

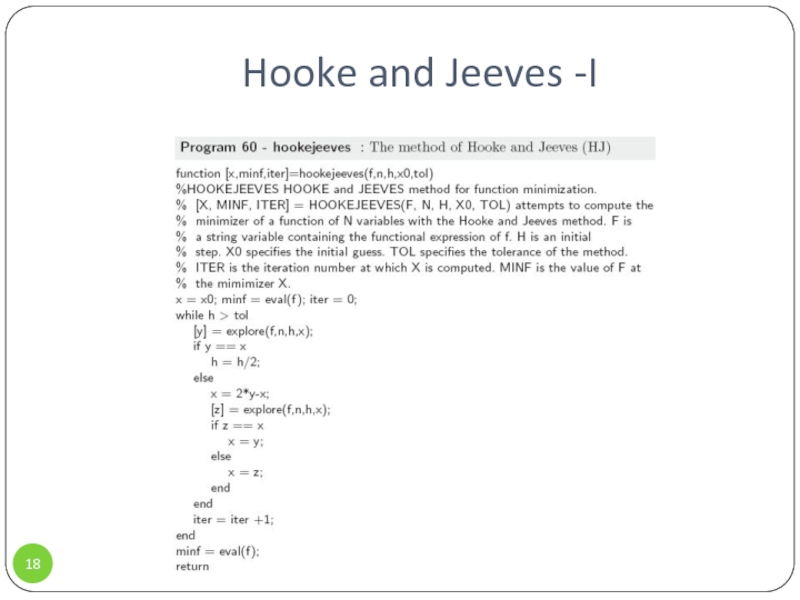

![Численные методы оптимизации Алгоритм Хука и Дживса , function [x,minf,iter]=hookejeeves(f,n,h,x0,tol){HOOKEJEEVES HOOKE and JEEVES method Алгоритм Хука и Дживса , function [x,minf,iter]=hookejeeves(f,n,h,x0,tol){HOOKEJEEVES HOOKE and JEEVES method for function minimization. [X, MINF, ITER]](/img/thumbs/a2ae17140c148b7f8c29e0979e3afe6f-800x.jpg)

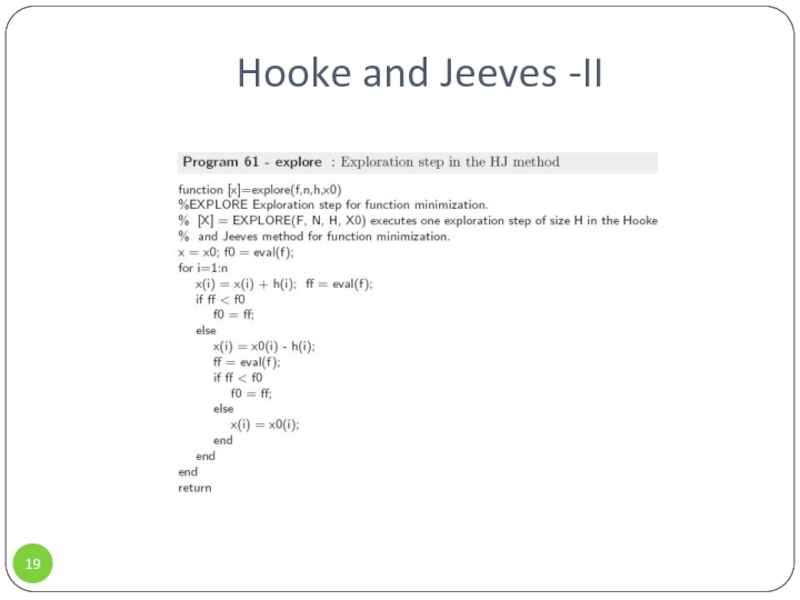

![Численные методы оптимизации Алгоритм Хука и Дживса , function [x]=explore(f,n,h,x0){ EXPLORE Exploration step for Алгоритм Хука и Дживса , function [x]=explore(f,n,h,x0){ EXPLORE Exploration step for function minimization. [X] = EXPLORE(F, N,](/img/thumbs/1091f661adb3face96b81d8998be5eef-800x.jpg)