Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ ПРОГРАММИРУЕМЫЕ ЛОГИЧЕСКИЕ ИНТЕГРАЛЬНЫЕ СХЕМЫ (П Л И С)

Содержание

- 1. КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ ПРОГРАММИРУЕМЫЕ ЛОГИЧЕСКИЕ ИНТЕГРАЛЬНЫЕ СХЕМЫ (П Л И С)

- 2. ОСНОВНЫЕ ТЕМЫ ЛЕКЦИИКОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОР-МАЦИИЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙПРОГРАММИРУЕМЫЕ ЛОГИЧЕСКИЕ МАТРИЦЫ (П Л М) ПРОГРАММИРУЕМЫЕ МАТРИЦЫ С ПАМЯТЬЮ

- 3. КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Всякая информация получается

- 4. Пусть опыт имеет два исхода Х1 и

- 5. В общем случае источник может передавать "n"

- 6. Более удобной является логарифмическая мера КОЛИЧЕСТВА ИНФОРМАЦИИ:Это

- 7. Количество информации и неопределенность для всей

- 8. Несмотря на совпадение формул для энтропии

- 9. Количество получаемой информации I(X) равно численно энтропии

- 10. Единицы измерения КОЛИЧЕСТВА ИНФОРМАЦИИ и ЭНТРОПИИ зависят

- 11. СВОЙСТВА ЭНТРОПИИ ДИСКРЕТНЫХ СООБЩЕНИЙ ⮚ Энтропия есть величина

- 12. ЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙ Реально наблюдаемые случайные

- 13. Следующий пример зависимых событий: на трамвайной

- 14. Допустим, при подходе к остановке отошел

- 15. Сумма вероятностей каждой строки матрицы равна 1,

- 16. Вероятность совместного появления двух событий равна произведению

- 17. Энтропия (неопределенность) появления в первом опыте

- 18. СВОЙСТВА ЭНТРОПИИ СЛОЖНЫХ СООБЩЕНИЙ ⮚ При статистически

- 19. ПРОГРАММИРУЕМЫЕ ЛОГИЧЕСКИЕ ИНТЕГРАЛЬНЫЕ СХЕМЫ (П Л

- 20. Одним из путей преодоления этого противоречия является

- 21. Основными параметрами ПЛМ являются:⮚ число входов -

- 22. ПЛМ отличается от РПЗУ (или ОППЗУ) тем,

- 23. На вход преобразователя кодов подается двоичный код

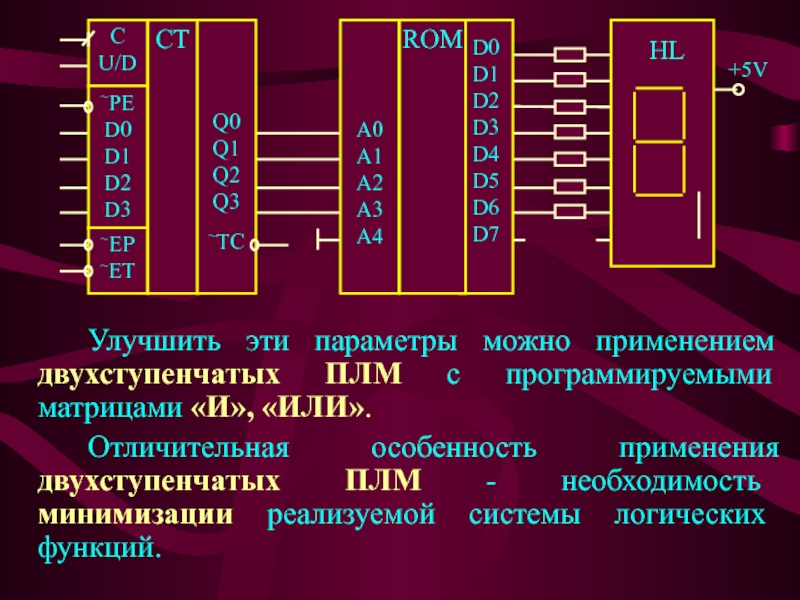

- 24. Улучшить эти параметры можно применением двухступенчатых ПЛМ

- 25. Слайд 25

- 26. Принципиальная схема двухступенчатой ПЛМ приведена на рис.

- 27. Рассмотрим реали-зацию на двухступен-чатой ПЛМ логических функций

- 28. ПРОГРАММИРУЕМЫЕ МАТРИЦЫ С ПАМЯТЬЮ Следующим шагом в

- 29. В настоящее время на мировом рынке полностью

- 30. КМОП ПЛИС обеспечивают высокую гибкость при отладке

- 31. Основные типы современных ПЛИС:⮚ MAX фирмы Altera;⮚

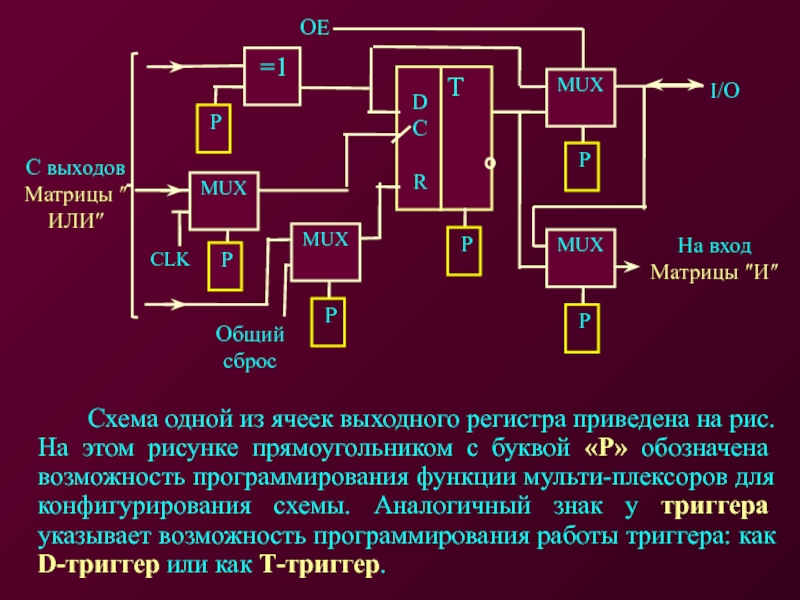

- 32. Схема одной из ячеек выходного регистра приведена

- 33. На управляющий вход триггера «С» может быть

- 34. Эффективное использование ПЛИС невозможно без применения средств

- 35. Вопросы для экспресс-контроля1. В чем различие и

- 36. Вопросы для экспресс-контроля7. Назовите основное назначение ПЛМ.8.

- 37. ЛЕКЦИЯ ОКОНЧЕНАСПАСИБО ЗА ВНИМАНИЕ

- 38. Скачать презентанцию

Слайды и текст этой презентации

Слайд 2ОСНОВНЫЕ ТЕМЫ ЛЕКЦИИ

КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОР-МАЦИИ

ЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙ

ПРОГРАММИРУЕМЫЕ ЛОГИЧЕСКИЕ МАТРИЦЫ (П

Л М)

ПРОГРАММИРУЕМЫЕ МАТРИЦЫ С ПАМЯТЬЮ

Слайд 3КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

Всякая информация получается потребителем после принятия

сообщения, т.е. в результате опыта. Сообщение, получаемое на приемной стороне,

несет полезную информацию лишь в том случае, если имеется неопределенность относительно состояния источника сообщений.Если опыт имеет лишь один исход и не содержит никакой неопределенности, то наблюдатель заранее будет знать исход этого опыта. В результате осуществления такого опыта наблюдатель не получит никакой информации.

Слайд 4Пусть опыт имеет два исхода Х1 и Х2 с вероятно-стями

Р(Х1) и Р(Х2). Например, результат контроля должен указать, что проверяемый

параметр находится в пределах нормы или за ее пределами. Переда-ваемое сообщение может принимать два значения и содержит определенную информацию.Если контролируемая в опыте величина (напряжение, температура, вес и т.п.) может принимать с опреде-ленными вероятностями, например 10 различных значений, то предварительная неопределенность относительно исхода опыта будет больше, а поступившее сообщение о конкретном исходе опыта дает более уточненную характеристику состояния источника (т.е. больше информации).

Слайд 5В общем случае источник может передавать "n" независимых и несовместимых

сообщений Х1, Х2,... Хn , с вероятностями Р(Х1), Р(Х2), ...

Р(Хn) соответ-ственно.Естественно, чем меньше априорная вероятность события, тем больше неопределенность о возможности наступления этого события.

Поэтому хотелось бы принять в качестве меры неопределенности отдельного сообщения, а также передаваемой им информации, величину, обратную его априорной вероятности: 1 / P(Xi) .

Однако, такая мера неудобна тем, что в случае, когда опыт имеет только один исход, т.е. вероятность такого события равна единице, – количество информации, согласно принятой мере, равно единице. В действительности результат такого опыта не дает никакой информации.

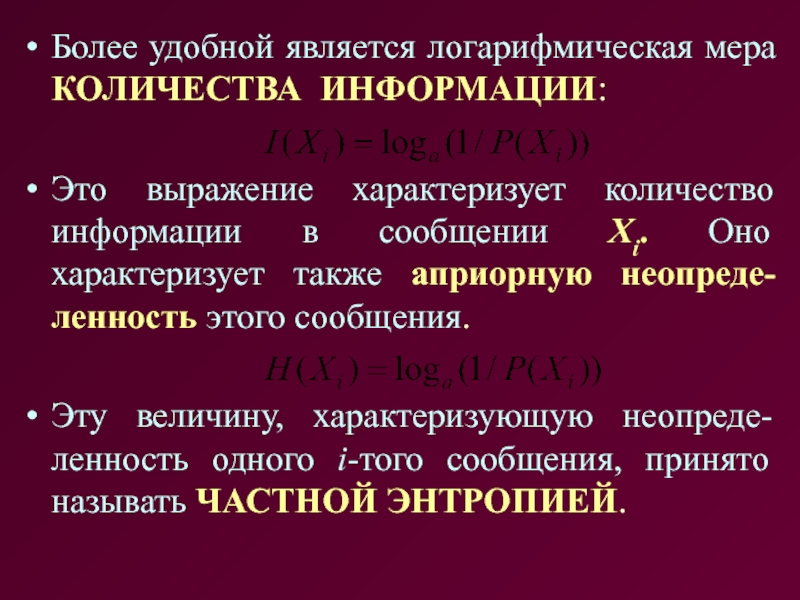

Слайд 6Более удобной является логарифмическая мера КОЛИЧЕСТВА ИНФОРМАЦИИ:

Это выражение характеризует количество

информации в сообщении Xi. Оно характеризует также априорную неопреде-ленность этого

сообщения.Эту величину, характеризующую неопреде-ленность одного i-того сообщения, принято называть ЧАСТНОЙ ЭНТРОПИЕЙ.

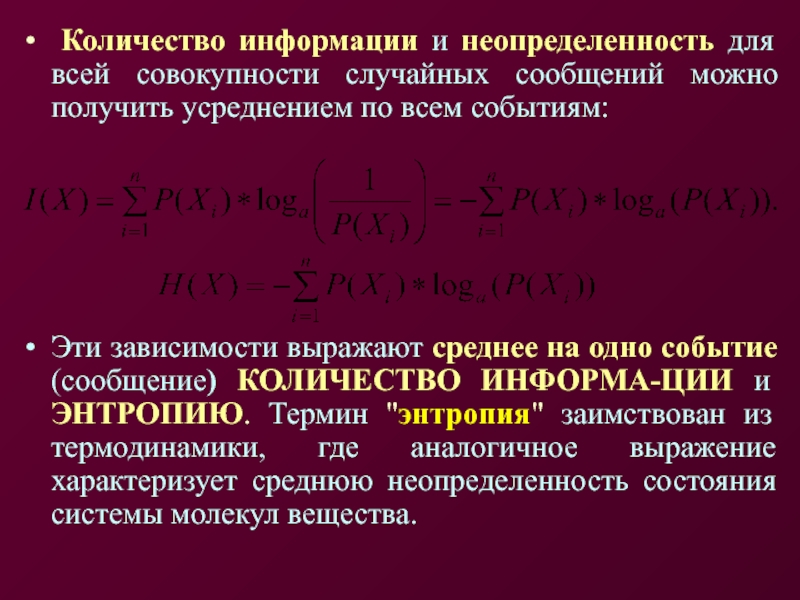

Слайд 7 Количество информации и неопределенность для всей совокупности случайных сообщений

можно получить усреднением по всем событиям:

Эти зависимости выражают среднее на

одно событие (сообщение) КОЛИЧЕСТВО ИНФОРМА-ЦИИ и ЭНТРОПИЮ. Термин "энтропия" заимствован из термодинамики, где аналогичное выражение характеризует среднюю неопределенность состояния системы молекул вещества.

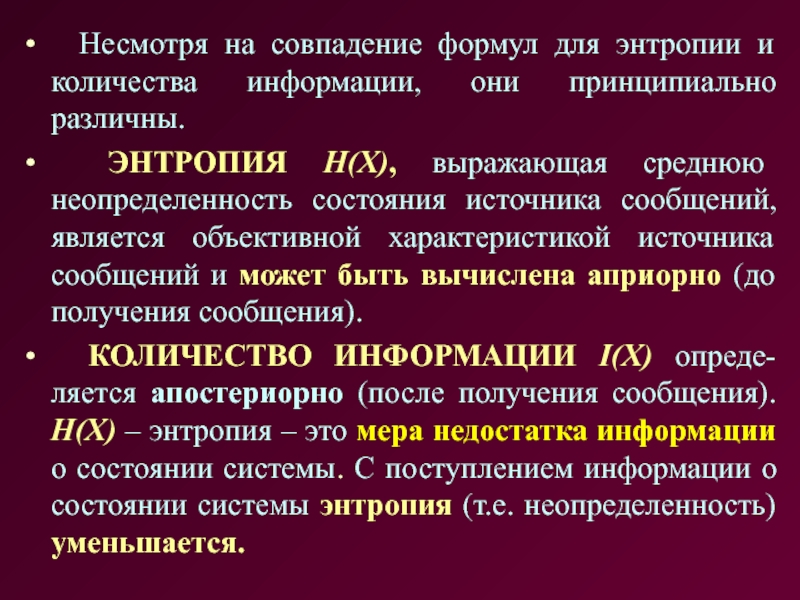

Слайд 8 Несмотря на совпадение формул для энтропии и количества информации,

они принципиально различны.

ЭНТРОПИЯ H(X), выражающая среднюю неопределенность состояния

источника сообщений, является объективной характеристикой источника сообщений и может быть вычислена априорно (до получения сообщения).КОЛИЧЕСТВО ИНФОРМАЦИИ I(X) опреде-ляется апостериорно (после получения сообщения). H(X) – энтропия – это мера недостатка информации о состоянии системы. С поступлением информации о состоянии системы энтропия (т.е. неопределенность) уменьшается.

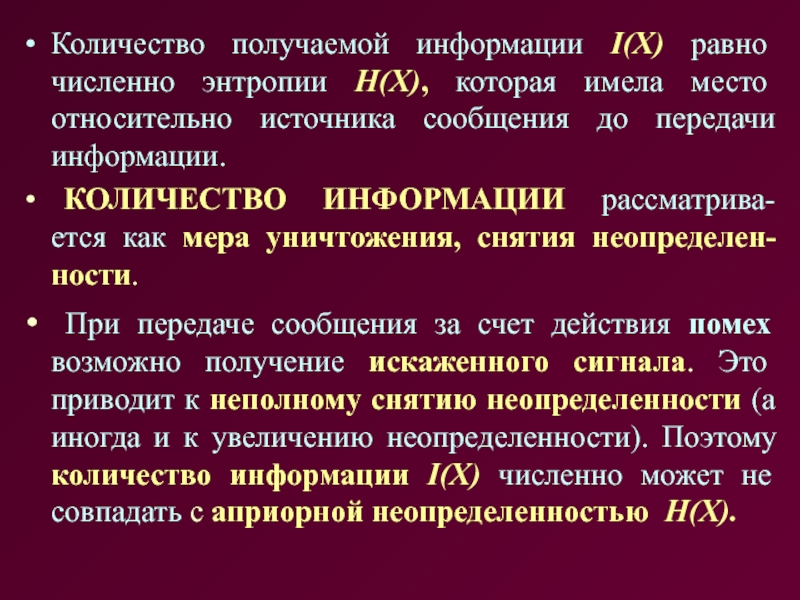

Слайд 9Количество получаемой информации I(X) равно численно энтропии Н(Х), которая имела

место относительно источника сообщения до передачи информации.

КОЛИЧЕСТВО ИНФОРМАЦИИ рассматрива-ется

как мера уничтожения, снятия неопределен-ности.При передаче сообщения за счет действия помех возможно получение искаженного сигнала. Это приводит к неполному снятию неопределенности (а иногда и к увеличению неопределенности). Поэтому количество информации I(X) численно может не совпадать с априорной неопределенностью H(X).

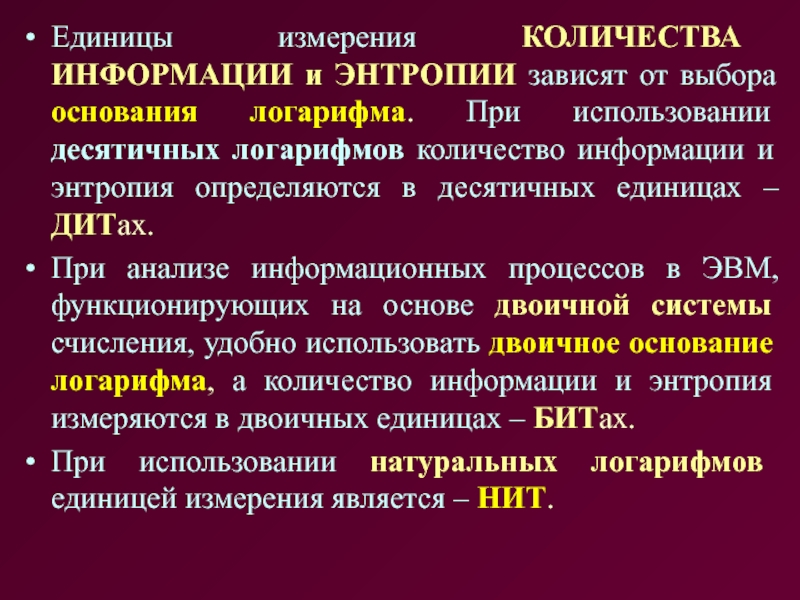

Слайд 10Единицы измерения КОЛИЧЕСТВА ИНФОРМАЦИИ и ЭНТРОПИИ зависят от выбора основания

логарифма. При использовании десятичных логарифмов количество информации и энтропия определяются

в десятичных единицах – ДИТах.При анализе информационных процессов в ЭВМ, функционирующих на основе двоичной системы счисления, удобно использовать двоичное основание логарифма, а количество информации и энтропия измеряются в двоичных единицах – БИТах.

При использовании натуральных логарифмов единицей измерения является – НИТ.

Слайд 11СВОЙСТВА ЭНТРОПИИ ДИСКРЕТНЫХ СООБЩЕНИЙ

⮚ Энтропия есть величина вещественная, неотрицательная и

ограниченная (если учесть, что: 0 ≤ P(X) ≤ 1

).⮚ Энтропия детерминированных сообщений равна нулю. Если заранее известно, что вероятность события Р(Х1) = 1, а вероятности остальных событий Р(Xi) = 0, то log (1) = 0, а остальные слагаемые равны нулю, поскольку предел lim (x log x) при x→0 также равен нулю.

⮚ Энтропия максимальна, если все события равновероятны.

⮚ Энтропия равновероятных событий возрастает с увеличением количества событий.

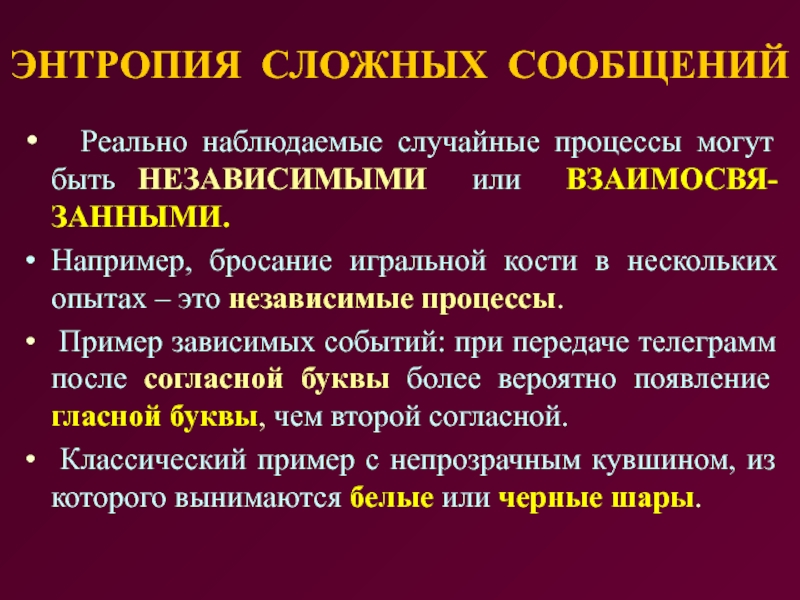

Слайд 12ЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙ

Реально наблюдаемые случайные процессы могут быть

НЕЗАВИСИМЫМИ или ВЗАИМОСВЯ-ЗАННЫМИ.

Например, бросание игральной кости в нескольких опытах –

это независимые процессы.Пример зависимых событий: при передаче телеграмм после согласной буквы более вероятно появление гласной буквы, чем второй согласной.

Классический пример с непрозрачным кувшином, из которого вынимаются белые или черные шары.

Слайд 13 Следующий пример зависимых событий: на трамвайной остановке возле нашего

дома остана-вливаются трамваи трех маршрутов. Условно назовем их «маршрут 1»,

«маршрут 2» и «маршрут 3».В результате многократных наблюдений мы установили: при ожидании трамвая вероятность прихода первым «маршрута 1» – Р(V1) = 0,15, вероятность прихода первым «маршрута 2» – P(V2) = 0,3, а – «маршрута 3» – P(V3) = 0,55.

Сумма всех вероятностей равна 1, потому что какой-нибудь маршрут приедет (независимо от времени ожидания).

Матрица вероятностей первого опыта имеет вид:

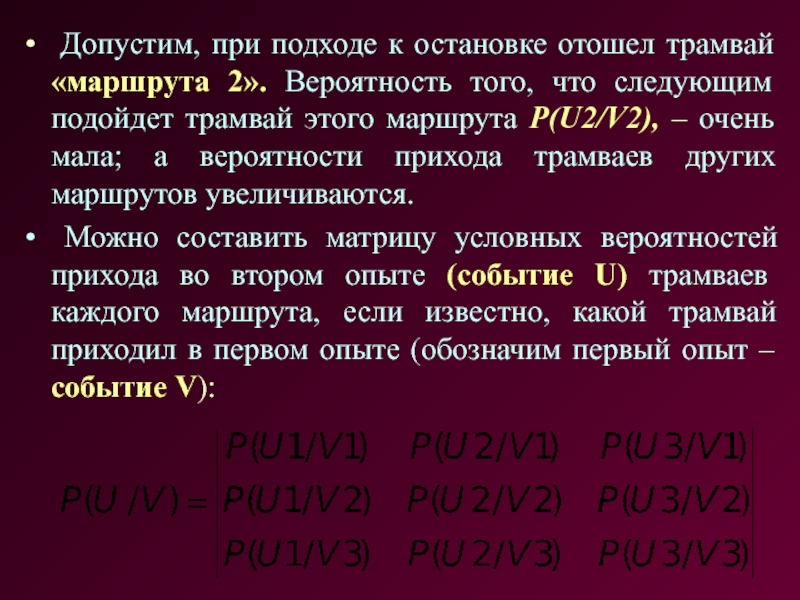

Слайд 14 Допустим, при подходе к остановке отошел трамвай «маршрута 2».

Вероятность того, что следующим подойдет трамвай этого маршрута P(U2/V2), –

очень мала; а вероятности прихода трамваев других маршрутов увеличиваются.Можно составить матрицу условных вероятностей прихода во втором опыте (событие U) трамваев каждого маршрута, если известно, какой трамвай приходил в первом опыте (обозначим первый опыт – событие V):

Слайд 15Сумма вероятностей каждой строки матрицы равна 1, потому что независимо

от исхода первого опыта, во втором опыте какой-нибудь маршрут обязательно

приедет.Кроме условных вероятностей можно составить матрицу вероятностей совместного появления двух событий:

где: P(U,V) – вероятность того, что в первом опыте приедет трамвай «маршрута 1», а во втором опыте – трамвай «маршрута 2».

Слайд 16Вероятность совместного появления двух событий равна произведению условной вероятности на

безусловную вероятность события в первом опыте:

Поэтому матрицу совместного появления двух

событий можно представить в таком виде: Из этого следует, что сумма всех элементов матрицы равна 1.

Слайд 17 Энтропия (неопределенность) появления в первом опыте события V, а

во втором, связанном с ним опыте, события U, равна:

где: Н(V) – энтропия первого события;H(U/V) – условная энтропия (условную энтропию нельзя вычислять по элементам матрицы, потому, что сумма всех элементов этой матрицы больше 1).

Основной смысл условной энтропии H(U/V) состоит в том, что она показывает, на сколько увеличивается энтропия второго события U, когда уже известна энтропия первого события V.

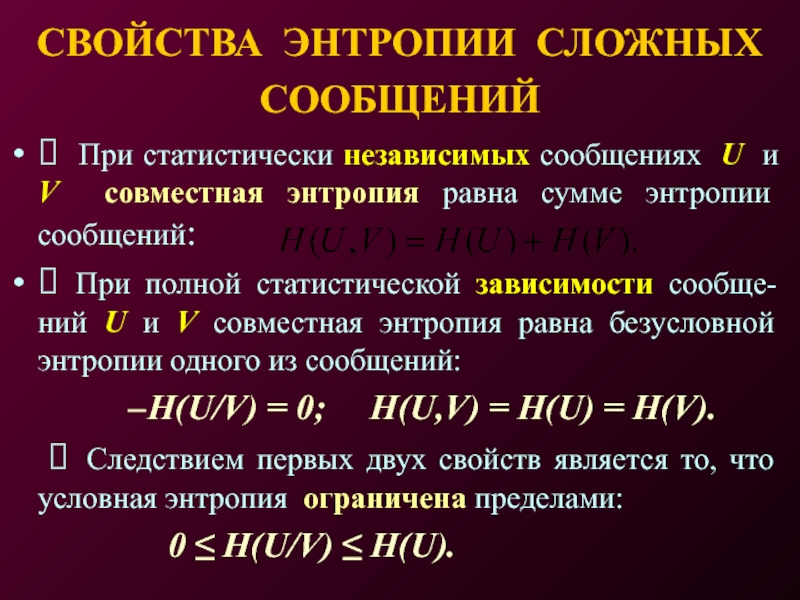

Слайд 18СВОЙСТВА ЭНТРОПИИ СЛОЖНЫХ СООБЩЕНИЙ

⮚ При статистически независимых сообщениях U

и V совместная энтропия равна сумме энтропии сообщений:

⮚ При полной

статистической зависимости сообще-ний U и V совместная энтропия равна безусловной энтропии одного из сообщений:H(U/V) = 0; H(U,V) = H(U) = H(V).

⮚ Следствием первых двух свойств является то, что условная энтропия ограничена пределами:

0 ≤ H(U/V) ≤ H(U).

Слайд 19ПРОГРАММИРУЕМЫЕ ЛОГИЧЕСКИЕ ИНТЕГРАЛЬНЫЕ СХЕМЫ (П Л И С)

ПРОГРАММИРУЕМЫЕ ЛОГИЧЕСКИЕ

МАТРИЦЫ (П Л М)

Развитие интегральных микросхем от Малых Интегральных

Схем (МИС) до СИС и БИС сопровождается, с одной стороны, усложнением схем и удорожанием процесса разработки, а с другой стороны - узкой специализацией БИС и, как следствие, сужением рынка сбыта. Возникает экономическое противоречие: большие затраты на разработку БИС могут быть оправданы только при массовом производстве, но узкая специализация БИС делает бессмысленным производство этих микросхем в больших количествах.

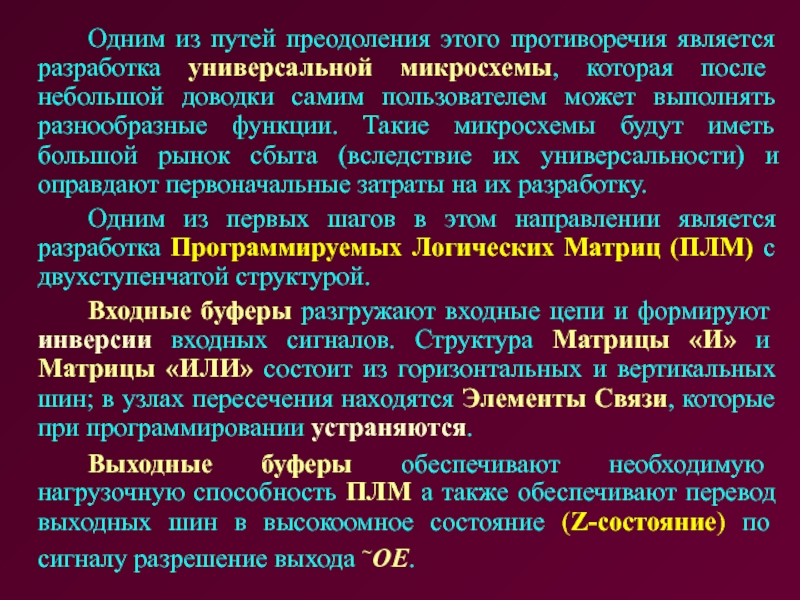

Слайд 20 Одним из путей преодоления этого противоречия является разработка универсальной микросхемы,

которая после небольшой доводки самим пользователем может выполнять разнообразные функции.

Такие микросхемы будут иметь большой рынок сбыта (вследствие их универсальности) и оправдают первоначальные затраты на их разработку.Одним из первых шагов в этом направлении является разработка Программируемых Логических Матриц (ПЛМ) с двухступенчатой структурой.

Входные буферы разгружают входные цепи и формируют инверсии входных сигналов. Структура Матрицы «И» и Матрицы «ИЛИ» состоит из горизонтальных и вертикальных шин; в узлах пересечения находятся Элементы Связи, которые при программировании устраняются.

Выходные буферы обеспечивают необходимую нагрузочную способность ПЛМ а также обеспечивают перевод выходных шин в высокоомное состояние (Z-состояние) по сигналу разрешение выхода ~ОЕ.

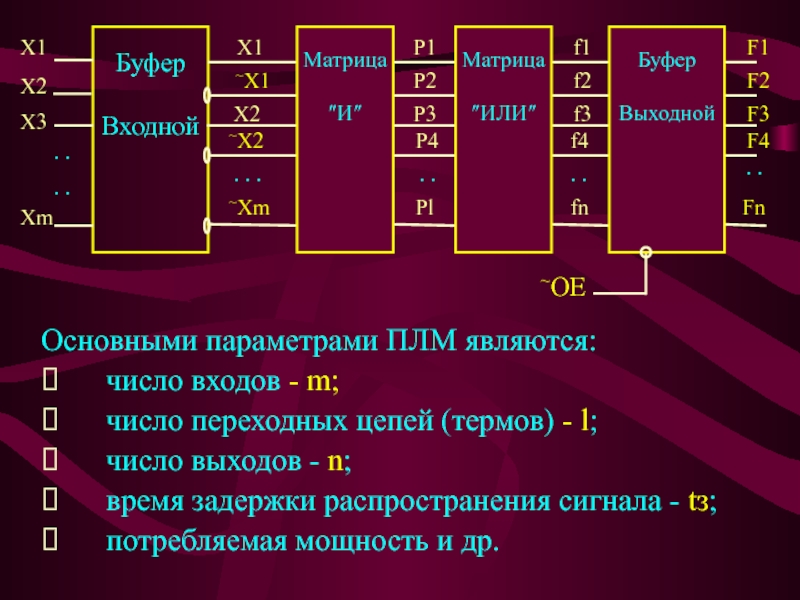

Слайд 21Основными параметрами ПЛМ являются:

⮚ число входов - m;

⮚ число переходных

цепей (термов) - l;

⮚ число выходов - n;

⮚ время задержки

распространения сигнала - tз;⮚ потребляемая мощность и др.

. .

. .

. .

Буфер

Входной

. .

. .

. . .

X1

X2

X3

Xm

X1

~X1

X2

~Xm

~X2

P1

P2

Pl

P3

P4

Матрица

″И″

f1

f2

fn

f3

f4

Матрица

″ИЛИ″

F1

F2

Fn

F3

F4

Буфер

Выходной

~OE

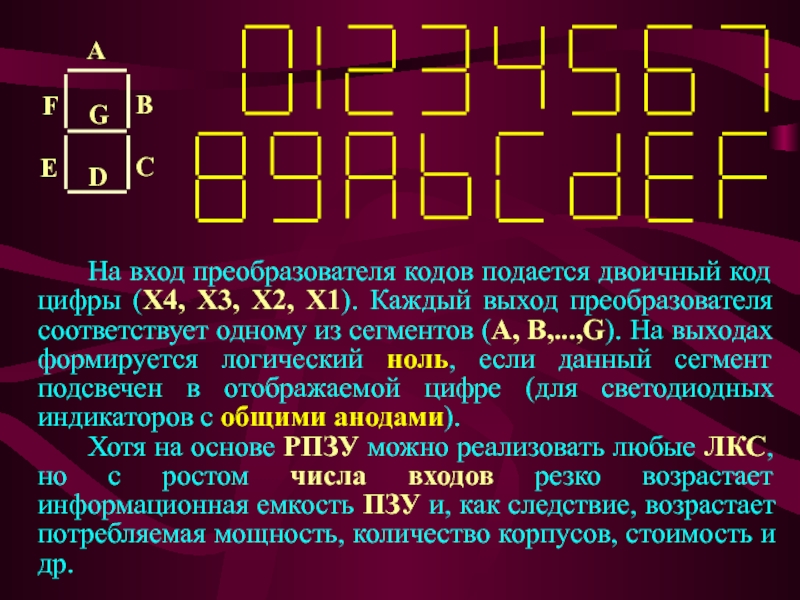

Слайд 22 ПЛМ отличается от РПЗУ (или ОППЗУ) тем, что в РПЗУ

матрица «И» - жесткая (роль матрицы «И» выполняет дешифратор адреса),

а матрица «ИЛИ» - программируемая (поэтому РПЗУ еще называют: одноступенчатой ПЛМ). В обычных (двухступенчатых) ПЛМ обе матрицы - программируемые.На основе РПЗУ (или ОППЗУ) возможна реализация любой Логической Комбинационной Схемы (ЛКС). При этом таблица состояний ЛКС является таблицей программирования РПЗУ. Минимизация логических функций не производится.

Рассмотрим реализацию ЛКС преобразователя двоичного кода в код семисегментного индикатора на примере ОППЗУ К155РЕ3. На рис. показаны шестнадцатеричные цифры, отображаемые семисегментным индикатором.

Слайд 23 На вход преобразователя кодов подается двоичный код цифры (X4, X3,

X2, X1). Каждый выход преобразователя соответствует одному из сегментов (A,

B,...,G). На выходах формируется логический ноль, если данный сегмент подсвечен в отображаемой цифре (для светодиодных индикаторов с общими анодами).Хотя на основе РПЗУ можно реализовать любые ЛКС, но с ростом числа входов резко возрастает информационная емкость ПЗУ и, как следствие, возрастает потребляемая мощность, количество корпусов, стоимость и др.

A

G

D

B

C

E

F

Слайд 24 Улучшить эти параметры можно применением двухступенчатых ПЛМ с программируемыми матрицами

«И», «ИЛИ».

Отличительная особенность применения двухступенчатых ПЛМ - необходимость минимизации реализуемой

системы логических функций.C

U/D

~PE

D0

D1

D2

D3

~EP

~ET

CT

Q0

Q1

Q2

Q3

~TC

A0

A1

A2

A3

A4

D0

D1

D2

D3

D4

D5

D6

D7

ROM

HL

+5V

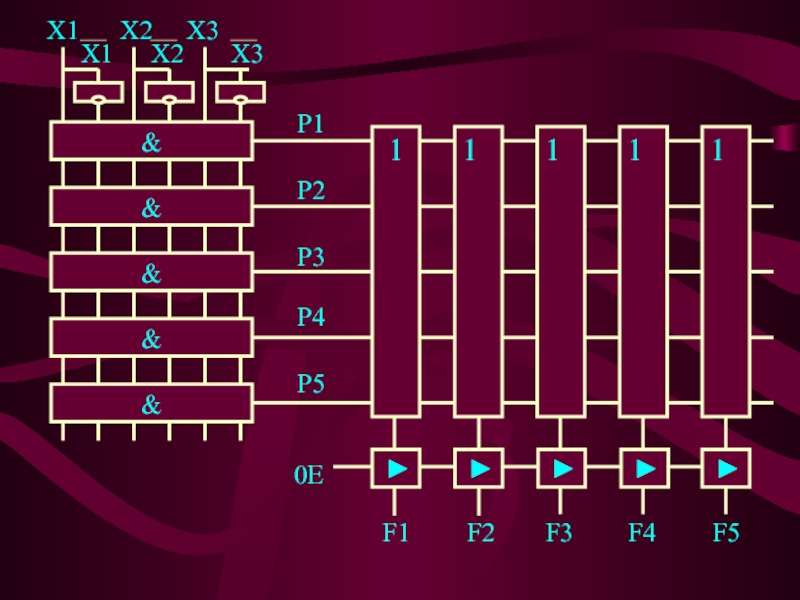

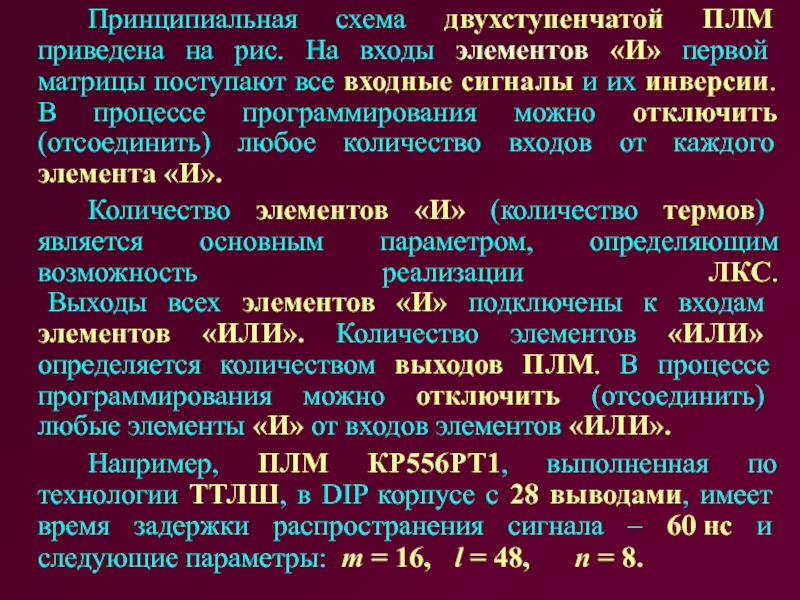

Слайд 26 Принципиальная схема двухступенчатой ПЛМ приведена на рис. На входы элементов

«И» первой матрицы поступают все входные сигналы и их инверсии.

В процессе программирования можно отключить (отсоединить) любое количество входов от каждого элемента «И».Количество элементов «И» (количество термов) является основным параметром, определяющим возможность реализации ЛКС. Выходы всех элементов «И» подключены к входам элементов «ИЛИ». Количество элементов «ИЛИ» определяется количеством выходов ПЛМ. В процессе программирования можно отключить (отсоединить) любые элементы «И» от входов элементов «ИЛИ».

Например, ПЛМ КР556РТ1, выполненная по технологии ТТЛШ, в DIP корпусе с 28 выводами, имеет время задержки распространения сигнала – 60 нс и следующие параметры: m = 16, l = 48, n = 8.

Слайд 27 Рассмотрим реали-зацию на двухступен-чатой ПЛМ логических функций сумматора.

Процесс програм-мирования ПЛМ

сво-дится к пережиганию перемычек на входах схем «И» а также

«ИЛИ». Разомкнутые в процессе программи-рования связи обозна-чены на рис. символом "x".Слайд 28ПРОГРАММИРУЕМЫЕ МАТРИЦЫ С ПАМЯТЬЮ

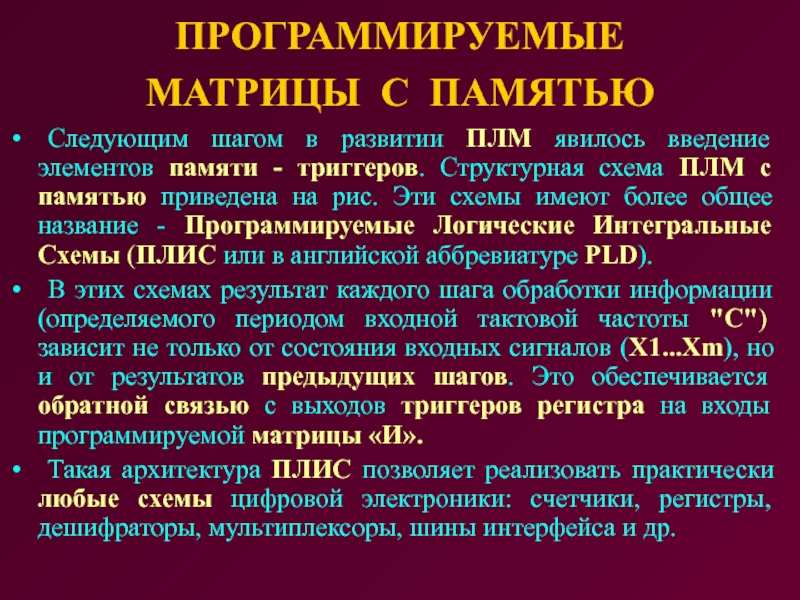

Следующим шагом в развитии ПЛМ явилось

введение элементов памяти - триггеров. Структурная схема ПЛМ с памятью

приведена на рис. Эти схемы имеют более общее название - Программируемые Логические Интегральные Схемы (ПЛИС или в английской аббревиатуре PLD).В этих схемах результат каждого шага обработки информации (определяемого периодом входной тактовой частоты "С") зависит не только от состояния входных сигналов (X1...Xm), но и от результатов предыдущих шагов. Это обеспечивается обратной связью с выходов триггеров регистра на входы программируемой матрицы «И».

Такая архитектура ПЛИС позволяет реализовать практически любые схемы цифровой электроники: счетчики, регистры, дешифраторы, мультиплексоры, шины интерфейса и др.

Слайд 29 В настоящее время на мировом рынке полностью доминируют ПЛИС, изготавливаемые

по технологии КМОП. Переход на субмикронные технологии позволил достичь быстродействия

150 МГц и более. Токи потребления зависят от рабочей частоты и увеличиваются в пропорции примерно 1 мА/МГц. Многие ПЛИС в статике потребляют 20..30 мкА. Нагрузочная способность большинства КМОП ПЛИС характеризуется величиной IO=10...16 мА, что упрощает совместное применение ПЛИС с микросхемами ТТЛШ. . .

. .

. .

Буфер

Входной

. .

. .

. . .

X1

X2

X3

Xm

X1

~X1

X2

~Xm

~X2

P1

P2

Pl

P3

P4

f1

f2

fn

f3

f4

Матрица

«ИЛИ»

F1

F2

F3

F4

Регистр

Выходной

C

Fn

. . . .

F1

F2

Fn

Матрица

«И»

Слайд 30 КМОП ПЛИС обеспечивают высокую гибкость при отладке посредством перепрограммирования, т.е.

стирание запрограммированных связей внутри микросхемы и загрузки в нее новой

конфигурации.Некоторые ПЛИС изготавливаются на основе технологии статического ОЗУ. Это обеспечивает неограниченное число загрузок конфигурации на этапе отладки, однако такая "прошивка" является энергозависимой и требует резервного электропитания от встроенных батарей.

Важной особенностью ПЛИС является наличие бита (перемычки) секретности. Если после программирования ПЛИС ее внутреннюю конфигурацию можно считать и полученный шаблон использовать для тиражирования схемы, то после разрыва бита секретности содержимое ПЛИС становится недоступным для чтения. Благодаря этому, ПЛИС могут применяться в качестве электронного ключа для защиты аппаратных и программных средств от несанкционированного доступа и копирования.

Слайд 31 Основные типы современных ПЛИС:

⮚ MAX фирмы Altera;

⮚ MACH фирмы AMD;

⮚

ACT фирмы Actel;

⮚ XC фирмы Xilinx и др.

Новые ПЛИС, выпускаемые

после 1995 года, достигли степени интеграции - более 10000 вентилей и содержат 300...500 триггеров на одном кристалле.Безусловным лидером мирового рынка ПЛИС является фирма Altera. Ее семейство MAX7000 считается своего рода стандартом на ПЛИС матричной архитектуры, обеспечивая при этом самую низкую удельную стоимость (соотношение цена/интеграция).

Наиболее широко ПЛИС используются в микропро-цессорной, вычислительной и радиотехнике. На их основе разрабатываются контроллеры шины, адресные дешифраторы, логика обрамления микропроцессоров, формирователи управляющих сигналов и др.

Слайд 32 Схема одной из ячеек выходного регистра приведена на рис. На

этом рисунке прямоугольником с буквой «Р» обозначена возможность программирования функции

мульти-плексоров для конфигурирования схемы. Аналогичный знак у триггера указывает возможность программирования работы триггера: как D-триггер или как Т-триггер.I/O

На вход Матрицы ″И″

С выходов Матрицы ″ИЛИ″

OE

CLK

Общий сброс

T

D

C

R

MUX

MUX

MUX

P

MUX

=1

P

P

P

P

P

Слайд 33 На управляющий вход триггера «С» может быть скоммутирован входной тактовый

сигнал CLK или один из выходов матрицы «ИЛИ».

Входной сигнал

D-триггера с помощью элемента "исключающее ИЛИ" может быть проинвертирован. Этот же сигнал может непосредственно подаваться на выходной контакт микросхемы (I/O). Выходной мультиплексор может быть переведен в Z-состояние. При этом контакт I/O может использоваться как вход ПЛИС и сконфигурирован на вход матрицы "И". На вход матрицы "И" может подключаться также выход триггера.

В последние годы появилась новая тенденция в развитии ПЛИС - так называемые ISP-микросхемы (in sistem programmable - программируемые в системе). Программирование и стирание таких ПЛИС выполняется непосредственно на плате посредством специального четырехканального кабеля, подключаемого к компьютеру через последовательный или параллельный порт.

Слайд 34 Эффективное использование ПЛИС невозможно без применения средств автоматизации проектирования -

САПР ПЛИС. Программное обеспечение САПР ПЛИС позволяет описать проектируемую схему

одним из стандартных способов:⮚ булевы уравнения;

⮚ таблицы состояний;

⮚ принципиальные схемы и др.

Любой из способов задания позволяет выполнить проектирование, т.е. сформировать так называемую таблицу прошивки ПЛИС. Большинству САПР ПЛИС присущи такие дополнительные функции, как минимизация, верификация, моделирование и др. Завершающим этапом создания схемы на основе ПЛИС является технологическое программирование.

За рубежом создано большое количество разнообразных систем проектирования ПЛИС (например, MAX-PLUS для ПЛИС фирмы ALTERA). Но стоимость их составляет несколько тысяч долларов.

Слайд 35Вопросы для экспресс-контроля

1. В чем различие и сходство терминов КОЛИ-ЧЕСТВО

ИНФОРМАЦИИ и ЭНТРОПИЯ?

2. Единицы измерения информации и энтропии.

3. Свойства энтропии

дискретных сообщений.4. Назовите примеры зависимых и независимых событий.

5. Дайте определение условной энтропии.

6. Свойства энтропии зависимых событий.

Слайд 36Вопросы для экспресс-контроля

7. Назовите основное назначение ПЛМ.

8. Перечислите основные параметры

ПЛМ.

9. Чем отличаются одноступенчатые ПЛМ от двух-ступенчатых ПЛМ?

10. Назовите основные

отличия ПЛМ с памятью от обычных ПЛМ.11. Перечислите области применения ПЛМ.

12. Какая технология используется при производ-стве современных ПЛИС?

13. Перечислите основные способы описания проектируемых схем на основе ПЛИС в современных САПР.