Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Лекция № 3 Задача классификации

Содержание

- 1. Лекция № 3 Задача классификации

- 2. Задача классификацииЗадача классификацииОбласти применения алгоритмов классификацииФормальное математическое определениеНесбалансированная классификацияКритерии качества классификации:Precision, Recall, F1 score, ROC AUC

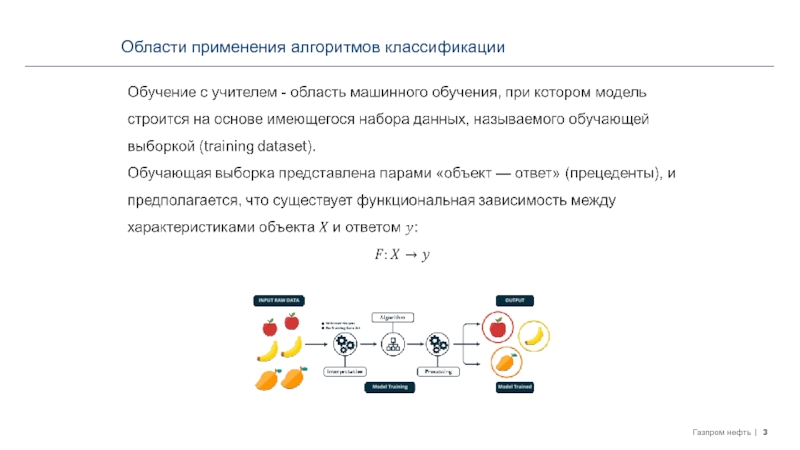

- 3. Области применения алгоритмов классификации

- 4. Области применения алгоритмов классификацииРегрессия - множество ответов

- 5. Области применения алгоритмов классификацииОценка кредитоспособности заемщиков.Задачи медицинской диагностикиОптическое распознавание символов.Распознавание речи.Обнаружение спама.Классификация документов и т.д.

- 6. Формальное математическое определение

- 7. Формальное математическое определениеРазделяющая гиперплоскость – это гиперплоскость,

- 8. Формальное математическое определение

- 9. Формальное математическое определение

- 10. Несбалансированная классификацияImbalanced Data : один из классов

- 11. Несбалансированная классификацияЗадачи, в которых несбалансированность данных не

- 12. Несбалансированная классификацияОбучение на несбалансированных данных осложняется расположением

- 13. Несбалансированная классификацияОсновные подходы к решению проблемы несбалансированных

- 14. Несбалансированная классификацияУменьшение большего класса (Undersampling)Случайный или синтетический

- 15. Несбалансированная классификацияУменьшение большего класса (Undersampling)Поиск связей Томека

- 16. Несбалансированная классификацияУменьшение большего класса (Undersampling)Правило сосредоточенного ближайшего

- 17. Несбалансированная классификацияУменьшение большего класса (Undersampling)Односторонний сэмплинг (One-side

- 18. Несбалансированная классификацияУменьшение большего класса (Undersampling)Правило «очищающего» соседа

- 19. Несбалансированная классификацияУвеличение меньшего класса (Oversampling)Добавление прецедентов миноритарного

- 20. Несбалансированная классификацияУвеличение меньшего класса (Oversampling)Алгоритм SMOTE (Synthetic

- 21. Несбалансированная классификацияУвеличение меньшего класса (Oversampling)Алгоритм ADASYN (Adaptive

- 22. Несбалансированная классификацияИзменение порога решения (Changing Performance Metric)Многие

- 23. Критерии качества классификацииОпределим ROC-кривую (receiver operating characteristic,

- 24. Критерии качества классификацииТочность и полнота (Precision and

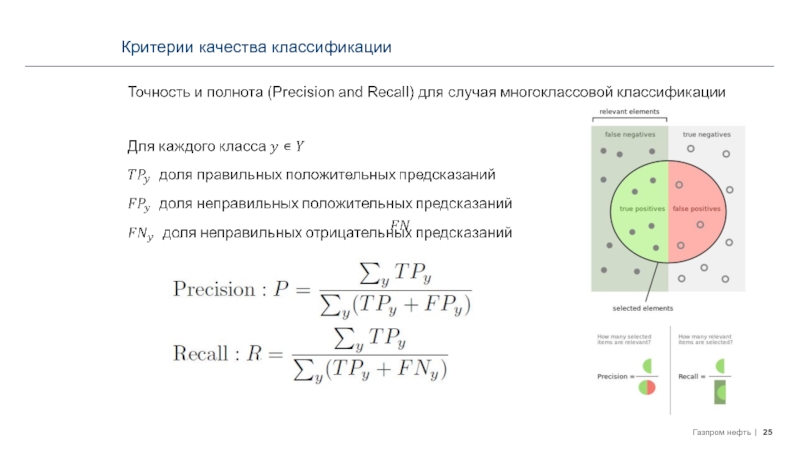

- 25. Критерии качества классификации

- 26. Ключевые концепцииЗадачи классификации оперируют множеством ответов с

- 27. Скачать презентанцию

Слайды и текст этой презентации

Слайд 2Задача классификации

Задача классификации

Области применения алгоритмов классификации

Формальное математическое определение

Несбалансированная классификация

Критерии качества

классификации:

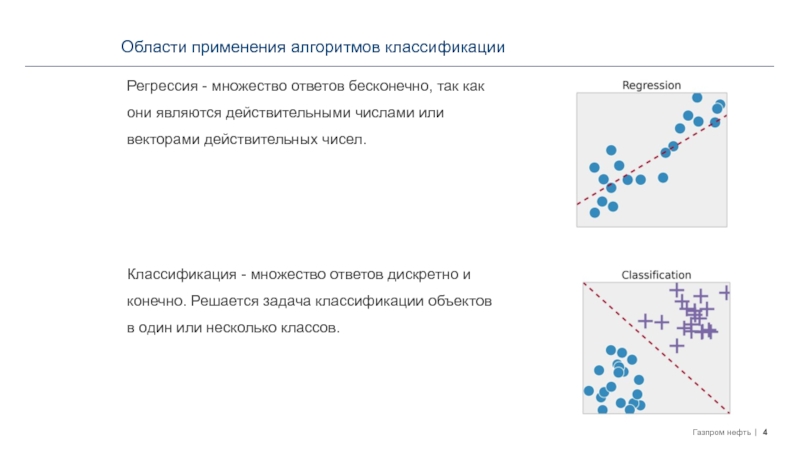

Слайд 4Области применения алгоритмов классификации

Регрессия - множество ответов бесконечно, так как

они являются действительными числами или векторами действительных чисел.

Классификация - множество

ответов дискретно и конечно. Решается задача классификации объектов в один или несколько классов.Слайд 5Области применения алгоритмов классификации

Оценка кредитоспособности заемщиков.

Задачи медицинской диагностики

Оптическое распознавание символов.

Распознавание

речи.

Обнаружение спама.

Классификация документов и т.д.

Слайд 7Формальное математическое определение

Разделяющая гиперплоскость – это гиперплоскость, которая отделяет группы

объектов, принадлежащим различным классам.

Если такая гиперплоскость существует, то говорят

о линейной разделимости выборки (A).Качество линейных методов классификации невысоко на линейно неразделимой выборке (B).

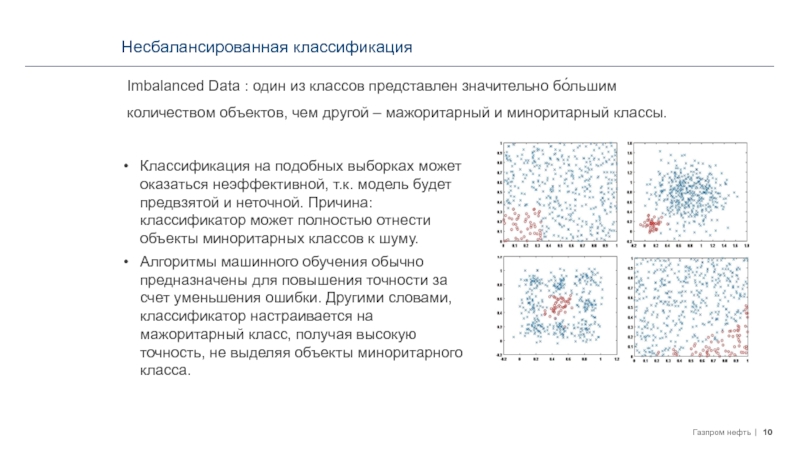

Слайд 10Несбалансированная классификация

Imbalanced Data : один из классов представлен значительно бо́льшим

количеством объектов, чем другой – мажоритарный и миноритарный классы.

Классификация на

подобных выборках может оказаться неэффективной, т.к. модель будет предвзятой и неточной. Причина: классификатор может полностью отнести объекты миноритарных классов к шуму.Алгоритмы машинного обучения обычно предназначены для повышения точности за счет уменьшения ошибки. Другими словами, классификатор настраивается на мажоритарный класс, получая высокую точность, не выделяя объекты миноритарного класса.

Слайд 11Несбалансированная классификация

Задачи, в которых несбалансированность данных не просто общая проблема,

а ожидаема в силу специфики области применения:

В медицинской диагностике объектам

миноритарного класса соответствует наличие редкого заболевания.Прогнозирование природных катастроф.

Обнаружение аномалий в сценариях обнаружения кражи электроэнергии.

Мошеннические транзакции – 1-2% транзакций, отличающихся от большинства.

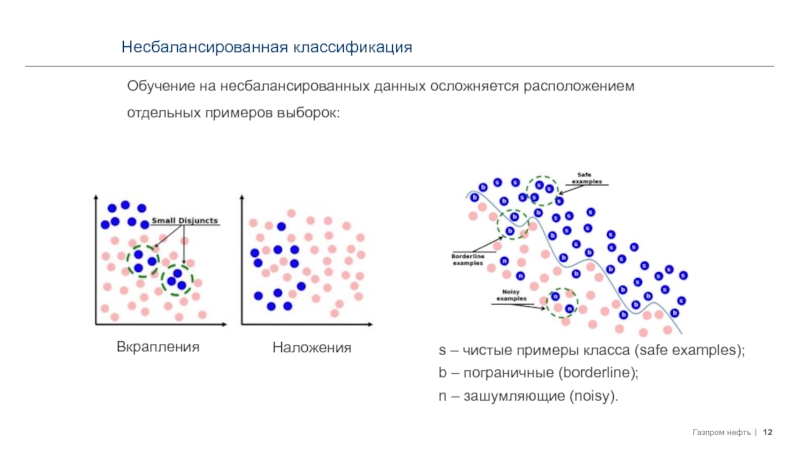

Слайд 12Несбалансированная классификация

Обучение на несбалансированных данных осложняется расположением отдельных примеров выборок:

Вкрапления

Наложения

s

– чистые примеры класса (safe examples);

b – пограничные (borderline);

n –

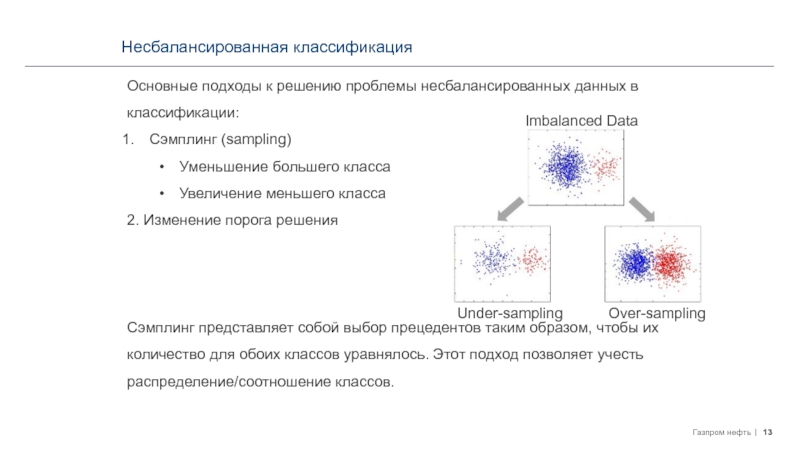

зашумляющие (noisy).Слайд 13Несбалансированная классификация

Основные подходы к решению проблемы несбалансированных данных в классификации:

Сэмплинг

(sampling)

Уменьшение большего класса

Увеличение меньшего класса

2. Изменение порога решения

Сэмплинг представляет собой

выбор прецедентов таким образом, чтобы их количество для обоих классов уравнялось. Этот подход позволяет учесть распределение/соотношение классов.Imbalanced Data

Over-sampling

Under-sampling

Слайд 14Несбалансированная классификация

Уменьшение большего класса (Undersampling)

Случайный или синтетический выбор прецедентов мажоритарного

класса в обучающую выборку.

Приводит к уменьшению тренировочной базы

Возможно исключение

важной информации и увеличение ошибкиСамый простой вариант — произвольный выбор прецедентов (Random Undersampling) — не учитывает положение прецедентов относительно друг друга и поверхности, разделяющей классы. Однако, на практике он оказывается наиболее эффективным.

Слайд 15Несбалансированная классификация

Уменьшение большего класса (Undersampling)

Поиск связей Томека (Tomek Links)

Этот способ

хорошо удаляет записи, которые можно рассматривать в качестве «зашумляющих».

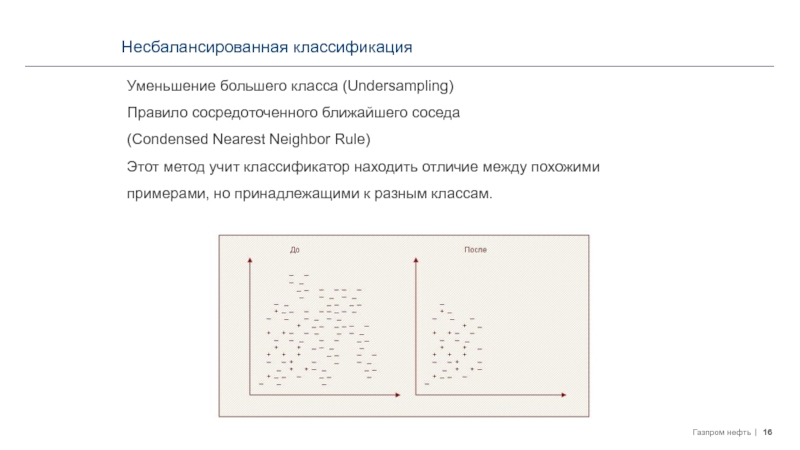

Слайд 16Несбалансированная классификация

Уменьшение большего класса (Undersampling)

Правило сосредоточенного ближайшего соседа

(Condensed Nearest

Neighbor Rule)

Этот метод учит классификатор находить отличие между похожими примерами,

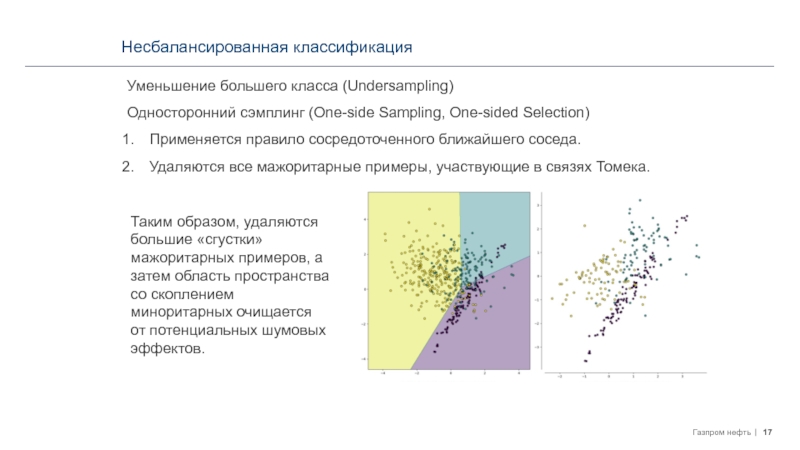

но принадлежащими к разным классам.Слайд 17Несбалансированная классификация

Уменьшение большего класса (Undersampling)

Односторонний сэмплинг (One-side Sampling, One-sided Selection)

Применяется

правило сосредоточенного ближайшего соседа.

Удаляются все мажоритарные примеры, участвующие в связях

Томека.Таким образом, удаляются большие «сгустки» мажоритарных примеров, а затем область пространства со скоплением миноритарных очищается от потенциальных шумовых эффектов.

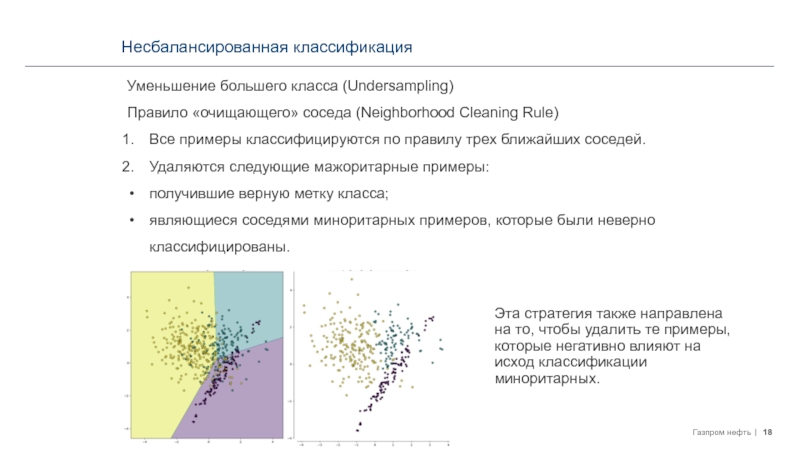

Слайд 18Несбалансированная классификация

Уменьшение большего класса (Undersampling)

Правило «очищающего» соседа (Neighborhood Cleaning Rule)

Все

примеры классифицируются по правилу трех ближайших соседей.

Удаляются следующие мажоритарные примеры:

получившие

верную метку класса;являющиеся соседями миноритарных примеров, которые были неверно классифицированы.

Эта стратегия также направлена на то, чтобы удалить те примеры, которые негативно влияют на исход классификации миноритарных.

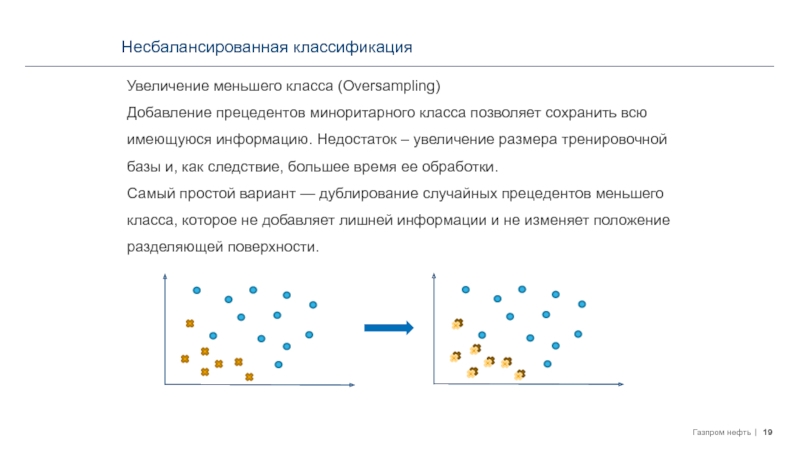

Слайд 19Несбалансированная классификация

Увеличение меньшего класса (Oversampling)

Добавление прецедентов миноритарного класса позволяет сохранить

всю имеющуюся информацию. Недостаток – увеличение размера тренировочной базы и,

как следствие, большее время ее обработки.Самый простой вариант — дублирование случайных прецедентов меньшего класса, которое не добавляет лишней информации и не изменяет положение разделяющей поверхности.

Слайд 20Несбалансированная классификация

Увеличение меньшего класса (Oversampling)

Алгоритм SMOTE (Synthetic Minority Oversampling Technique)

- генерация некоторого количества искусственных примеров, которые «похожи» на имеющиеся

в миноритарном классе, но при этом не дублируют их.Миноритарный пример

Мажоритарный пример

Искусственный пример

Алгоритм не подходит в случае, если миноритарные примеры равномерно распределены среди мажоритарных и имеют низкую плотность. Тогда SMOTE только сильнее перемешает классы.

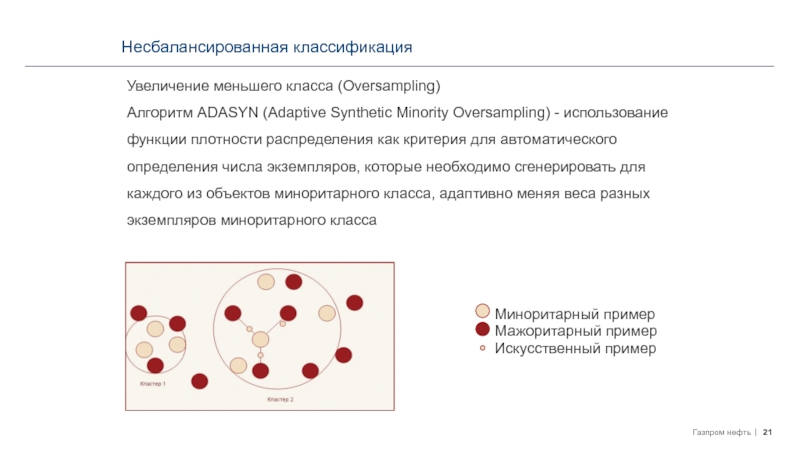

Слайд 21Несбалансированная классификация

Увеличение меньшего класса (Oversampling)

Алгоритм ADASYN (Adaptive Synthetic Minority Oversampling)

- использование функции плотности распределения как критерия для автоматического определения

числа экземпляров, которые необходимо сгенерировать для каждого из объектов миноритарного класса, адаптивно меняя веса разных экземпляров миноритарного классаМиноритарный пример

Мажоритарный пример

Искусственный пример

Слайд 22Несбалансированная классификация

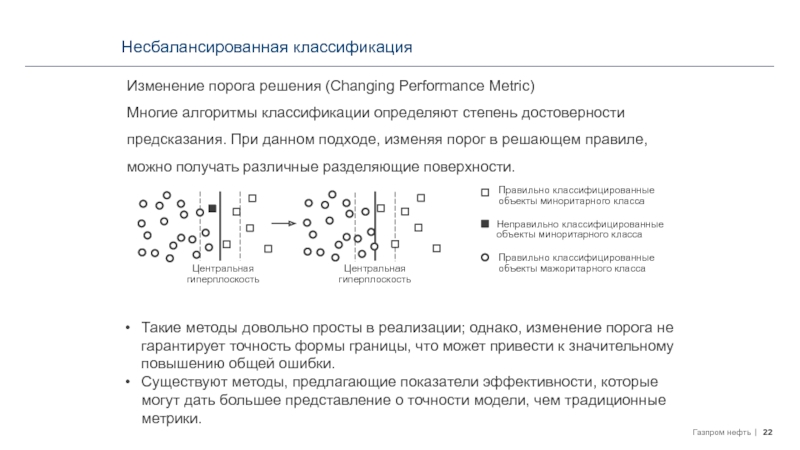

Изменение порога решения (Changing Performance Metric)

Многие алгоритмы классификации определяют

степень достоверности предсказания. При данном подходе, изменяя порог в решающем

правиле, можно получать различные разделяющие поверхности.Правильно классифицированные объекты миноритарного класса

Неправильно классифицированные объекты миноритарного класса

Правильно классифицированные объекты мажоритарного класса

Центральная гиперплоскость

Центральная гиперплоскость

Такие методы довольно просты в реализации; однако, изменение порога не гарантирует точность формы границы, что может привести к значительному повышению общей ошибки.

Существуют методы, предлагающие показатели эффективности, которые могут дать большее представление о точности модели, чем традиционные метрики.

Слайд 23Критерии качества классификации

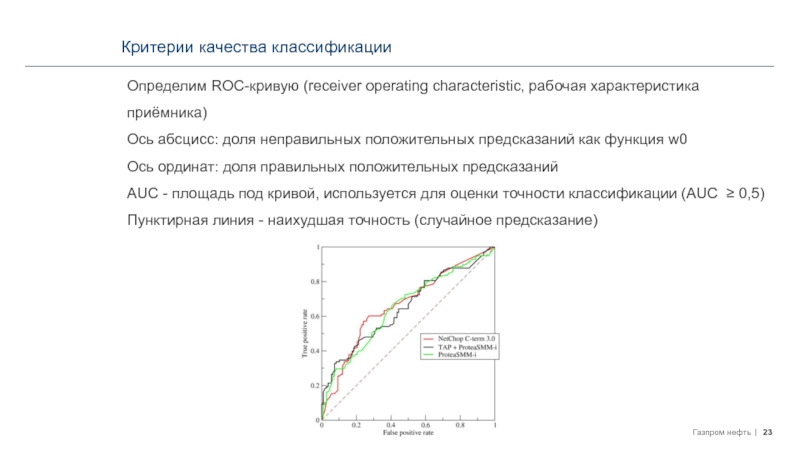

Определим ROC-кривую (receiver operating characteristic, рабочая характеристика приёмника)

Ось

абсцисс: доля неправильных положительных предсказаний как функция w0

Ось ординат: доля

правильных положительных предсказанийAUC - площадь под кривой, используется для оценки точности классификации (AUC ≥ 0,5)

Пунктирная линия - наихудшая точность (случайное предсказание)

Слайд 24Критерии качества классификации

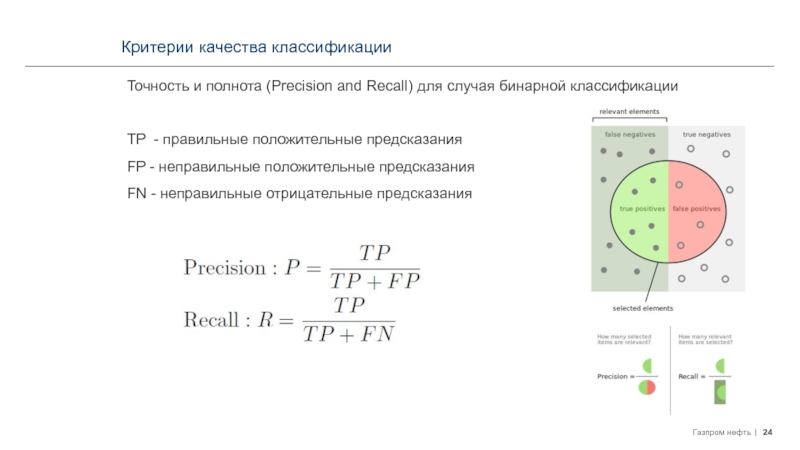

Точность и полнота (Precision and Recall) для случая

бинарной классификации

TP - правильные положительные предсказания

FP - неправильные положительные предсказания

FN

- неправильные отрицательные предсказанияСлайд 26Ключевые концепции

Задачи классификации оперируют множеством ответов с дискретными значениями, так

как цель таких задач — определить, к какому классу относится

пример.Чем дальше точка от гиперплоскости, являющейся границей решений (decision boundary), тем выше вероятность, что образец (sample), определяемый этой точкой, попадает в тот или иной класс.

Imbalanced Data : один из классов представлен значительно бо́льшим количеством объектов, чем другой – мажоритарный и миноритарный классы.

Основные подходы к решению проблемы несбалансированных данных в классификации:

1. Сэмплинг

2. Изменение порога решения

Многие алгоритмы классификации определяют степень достоверности предсказания. При данном подходе, изменяя порог в решающем правиле, можно получать различные разделяющие поверхности.