за счет их перекодировки.

Применяется практически во всех архиваторах типа

Rar, Zip и др. Позволяют сжать информацию в в 2-3, max в 4 раза, но при этом происходит полное восстановление сжатой информации «бит в бит»

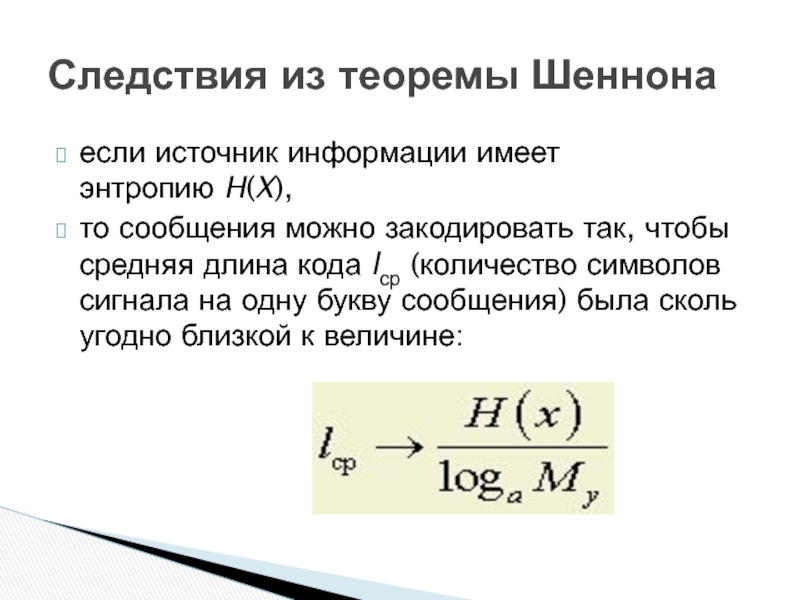

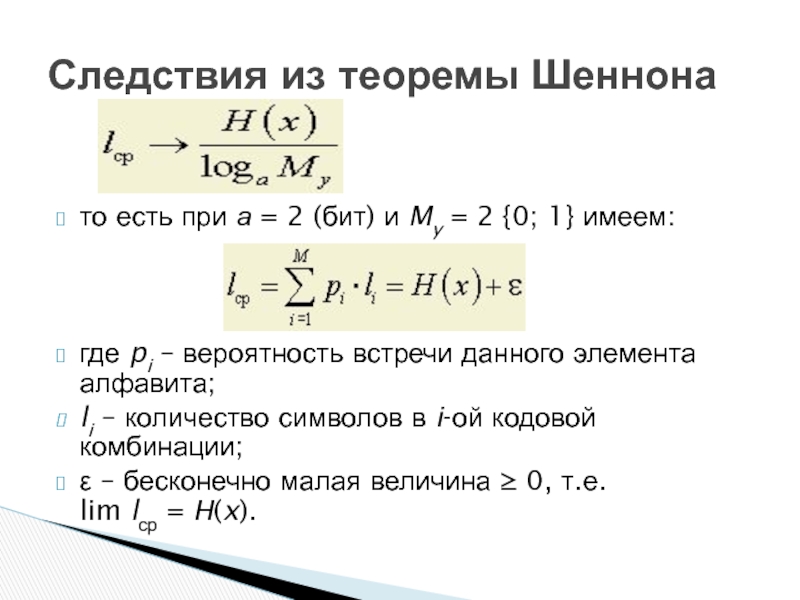

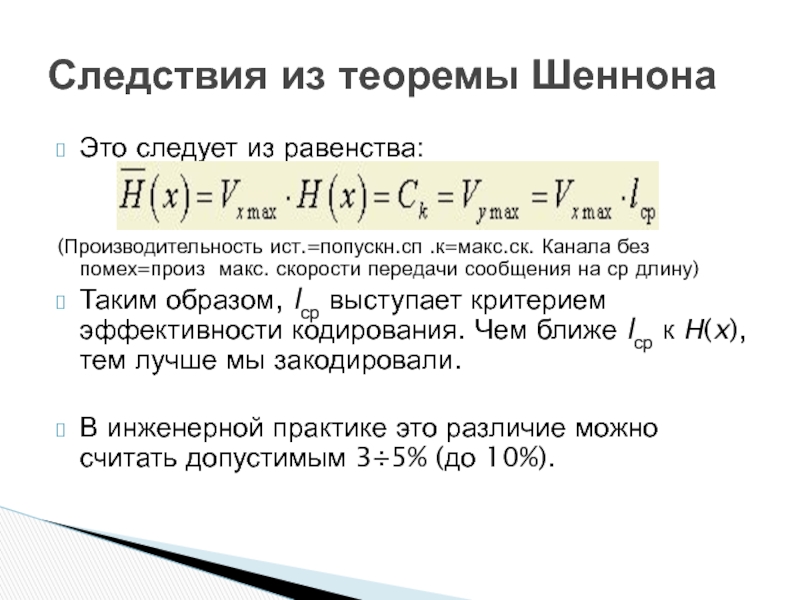

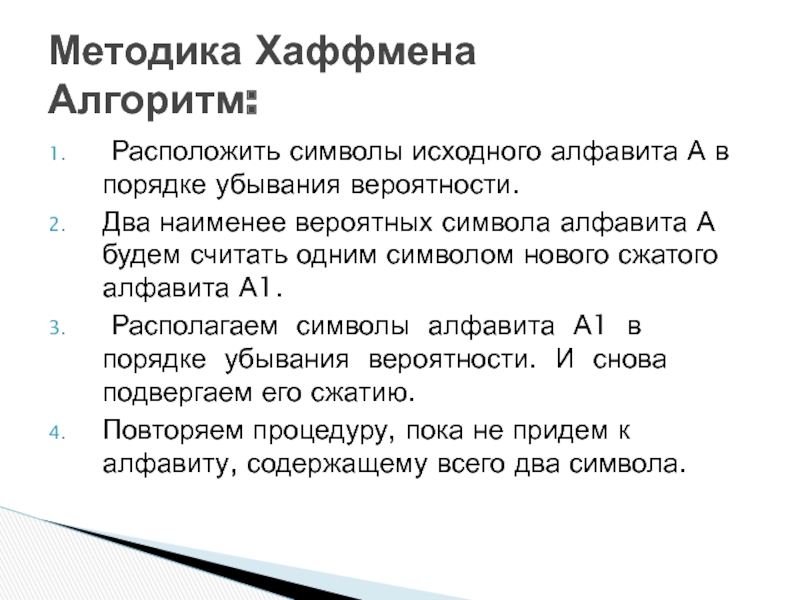

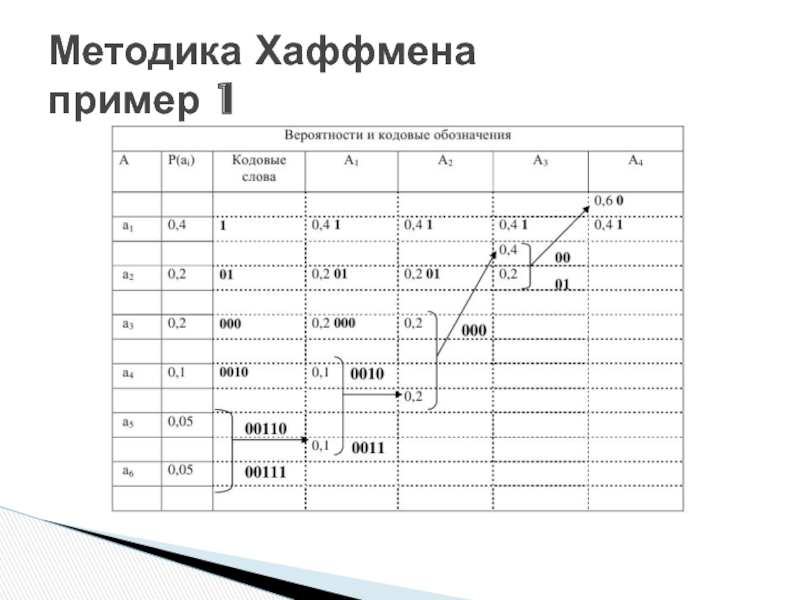

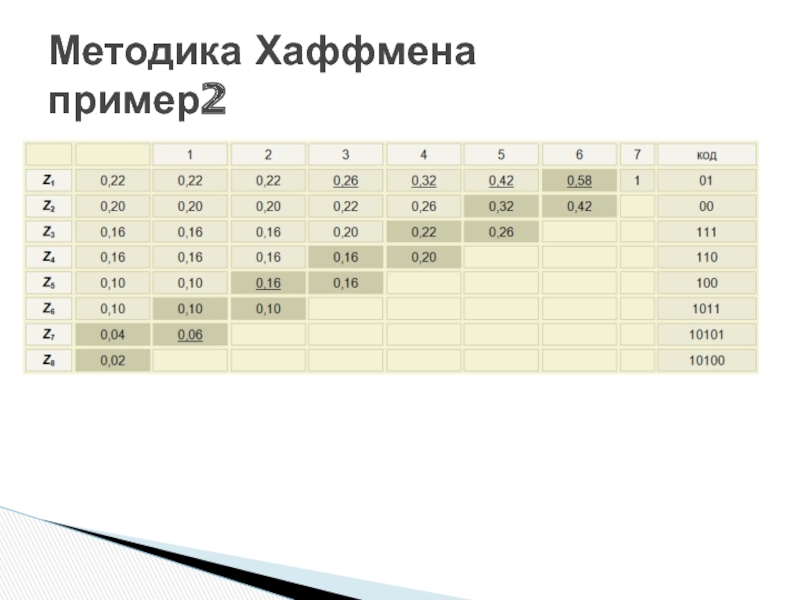

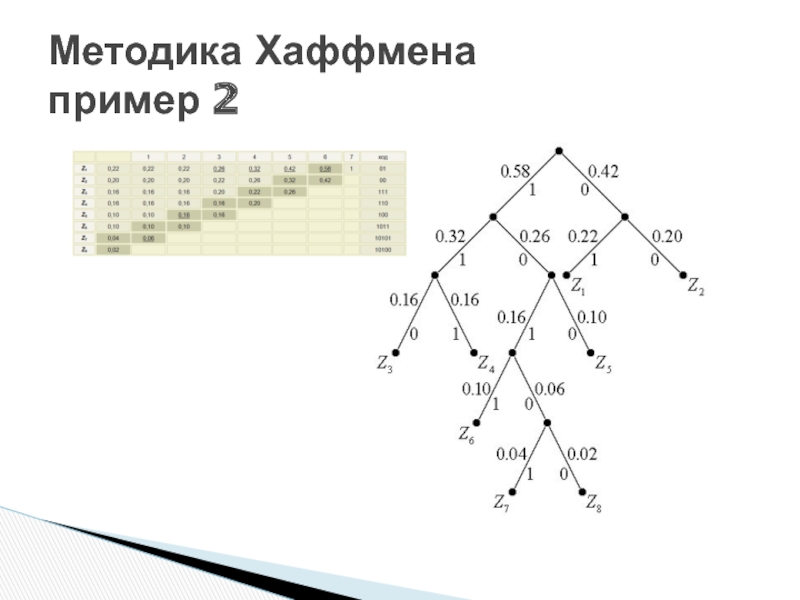

Эффективное кодирование