Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

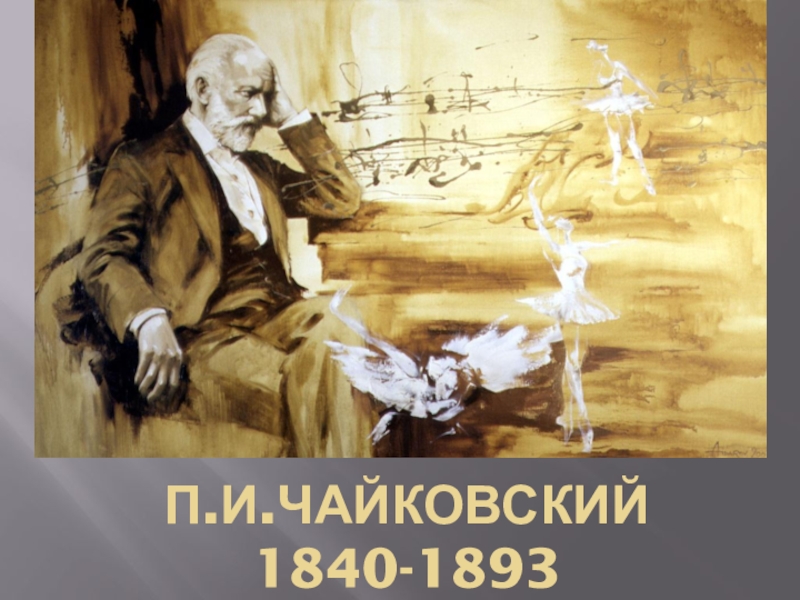

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Классификация нормально распределенных векторов при неизвестных параметрах распределения

Содержание

- 1. Классификация нормально распределенных векторов при неизвестных параметрах распределения

- 2. Основная задача при построении статистических решающих правил

- 3. В случае нормального распределения задача сводится к

- 4. Для m классов мы должны получить оценки

- 5. Линейное решающее правило на основе полученных оценок выглядит следующим образом:

- 6. Часто используются рекуррентные оценки, когда данные получаются

- 7. Слайд 7

- 8. Задача статистической классификации для количества классов больше

- 9. Область X k определяется в

- 10. Фактически мы получаем здесь два неравенства: j=2: q2

- 11. Самая простая интерпретация, когда мы рассматриваем следующий

- 12. Слайд 12

- 13. Возможное количество пар таких решений будет равно

- 14. Скачать презентанцию

Основная задача при построении статистических решающих правил – нахождение оценок вероятностных распределений классов. Для этого можно использовать принципы обучения, основанные на использовании обучающих множеств, состоящих из конечного набора объектов каждого класса.

Слайды и текст этой презентации

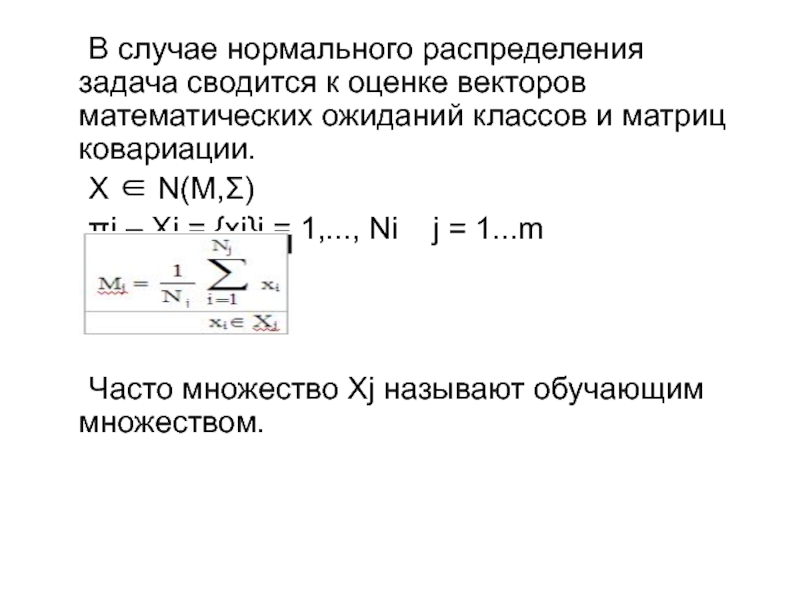

Слайд 3 В случае нормального распределения задача сводится к оценке векторов

математических ожиданий классов и матриц ковариации.

X ∈ N(M,Σ)

πi

– Xj = {xi}i = 1,..., Ni j = 1...mЧасто множество Xj называют обучающим множеством.

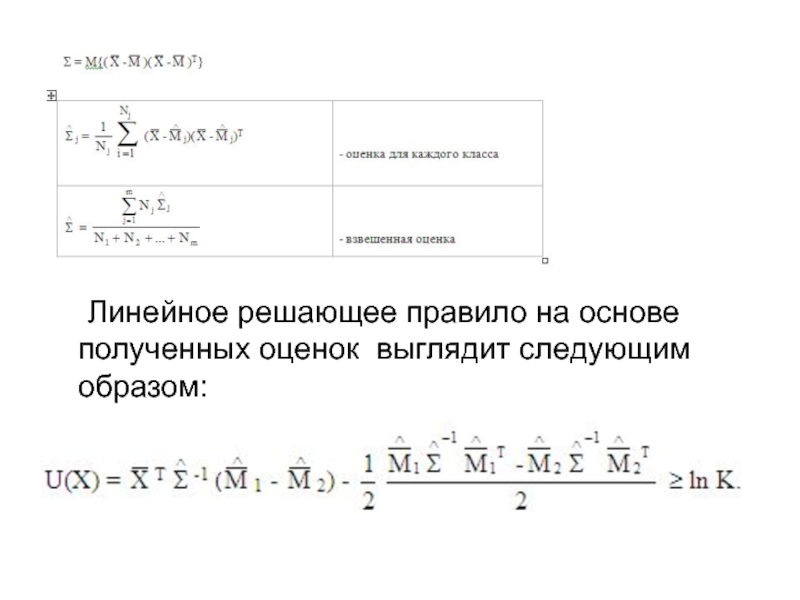

Слайд 4 Для m классов мы должны получить оценки максимального правдоподобия. Известно,

что оценка МП для математического ожидания нормально распределенного вектора является

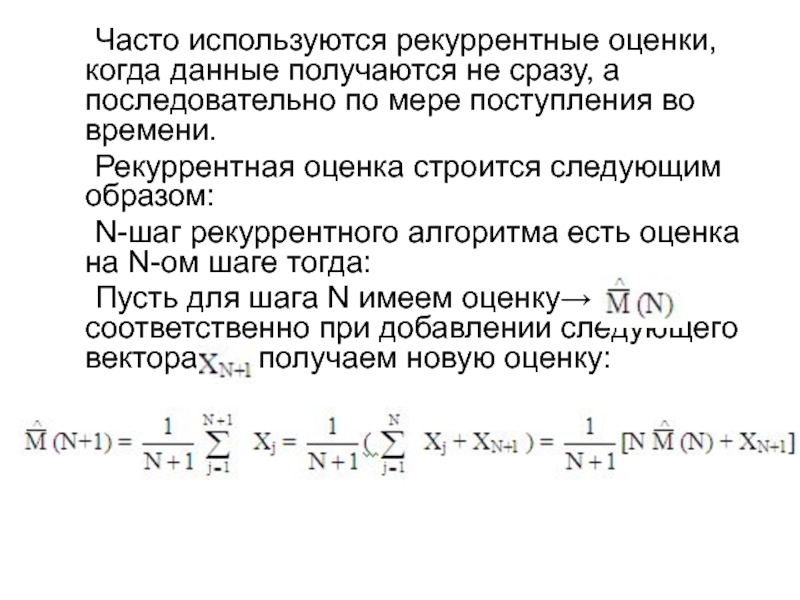

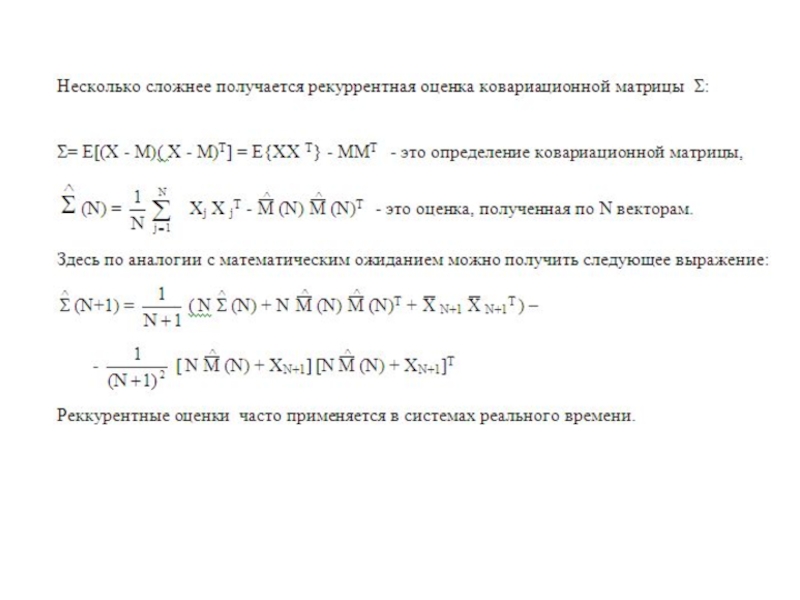

средним арифметическим по обучающему множеству, а соответственно оценка матрицы ковариации имеет вид, приведенный в таблице. Соответственно для случая равных матриц ковариации нужно получить усредненную по классам оценку.Слайд 6 Часто используются рекуррентные оценки, когда данные получаются не сразу, а

последовательно по мере поступления во времени.

Рекуррентная оценка строится следующим

образом:N-шаг рекуррентного алгоритма есть оценка на N-ом шаге тогда:

Пусть для шага N имеем оценку→ , соответственно при добавлении следующего вектора получаем новую оценку:

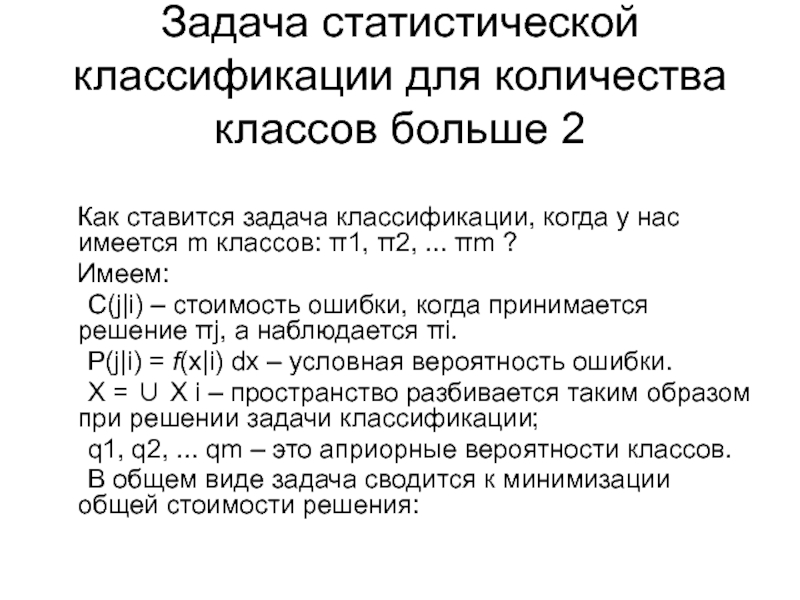

Слайд 8Задача статистической классификации для количества классов больше 2

Как ставится задача классификации, когда у нас имеется m классов:

π1, π2, ... πm ?Имеем:

C(j|i) – стоимость ошибки, когда принимается решение πj, а наблюдается πi.

P(j|i) = f(x|i) dx – условная вероятность ошибки.

X = ∪ X i – пространство разбивается таким образом при решении задачи классификации;

q1, q2, ... qm – это априорные вероятности классов.

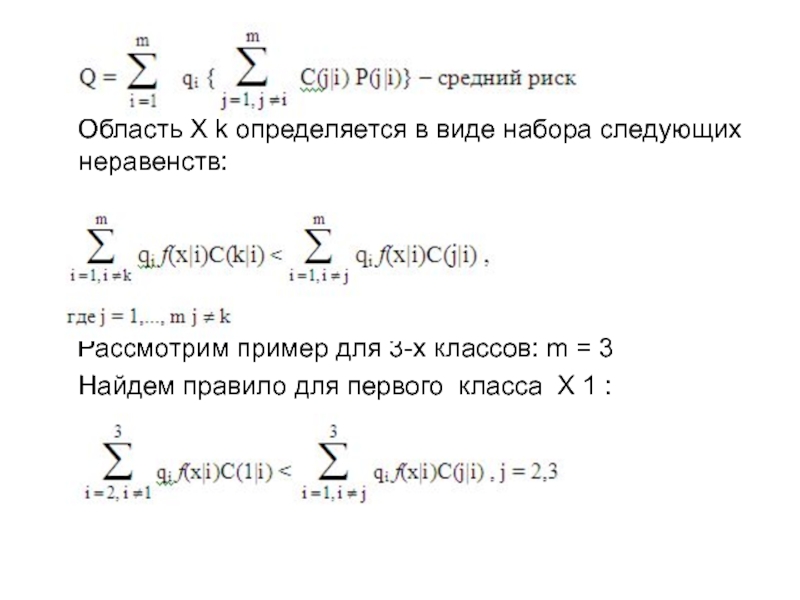

В общем виде задача сводится к минимизации общей стоимости решения:

Слайд 9

Область X k определяется в виде набора следующих

неравенств:

Рассмотрим пример для 3-х классов: m = 3

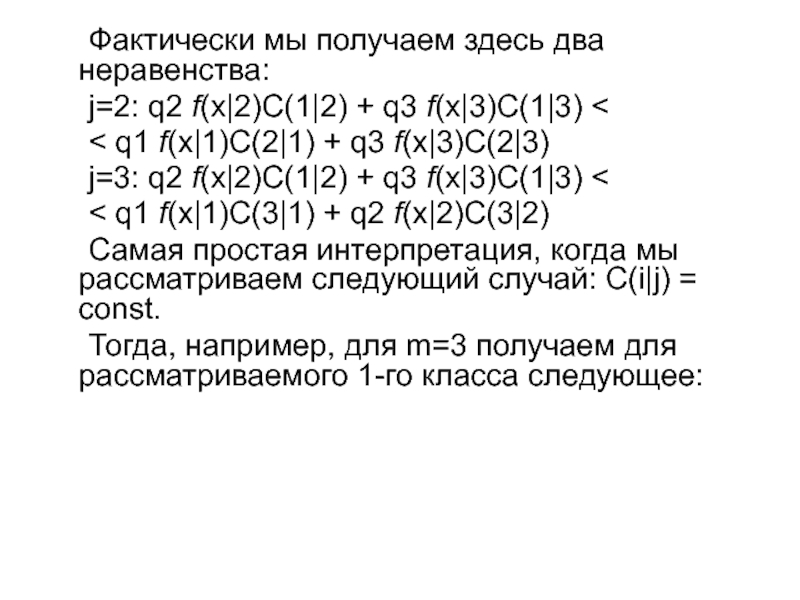

Найдем правило для первого класса X 1 :Слайд 10 Фактически мы получаем здесь два неравенства:

j=2: q2 f(x|2)C(1|2) + q3

f(x|3)C(1|3) <

< q1 f(x|1)C(2|1) + q3 f(x|3)C(2|3)

j=3: q2 f(x|2)C(1|2)

+ q3 f(x|3)C(1|3) < < q1 f(x|1)C(3|1) + q2 f(x|2)C(3|2)

Самая простая интерпретация, когда мы рассматриваем следующий случай: C(i|j) = const.

Тогда, например, для m=3 получаем для рассматриваемого 1-го класса следующее:

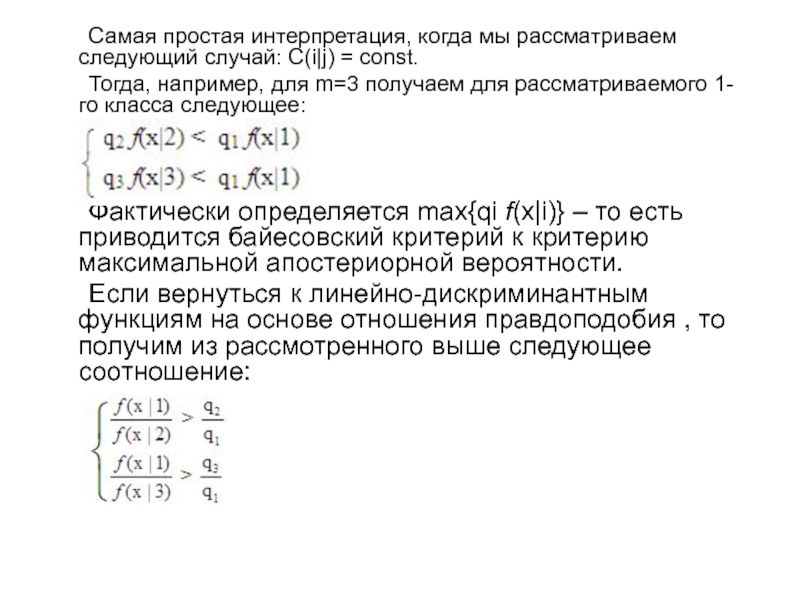

Слайд 11 Самая простая интерпретация, когда мы рассматриваем следующий случай: C(i|j) =

const.

Тогда, например, для m=3 получаем для рассматриваемого 1-го класса следующее:

Фактически

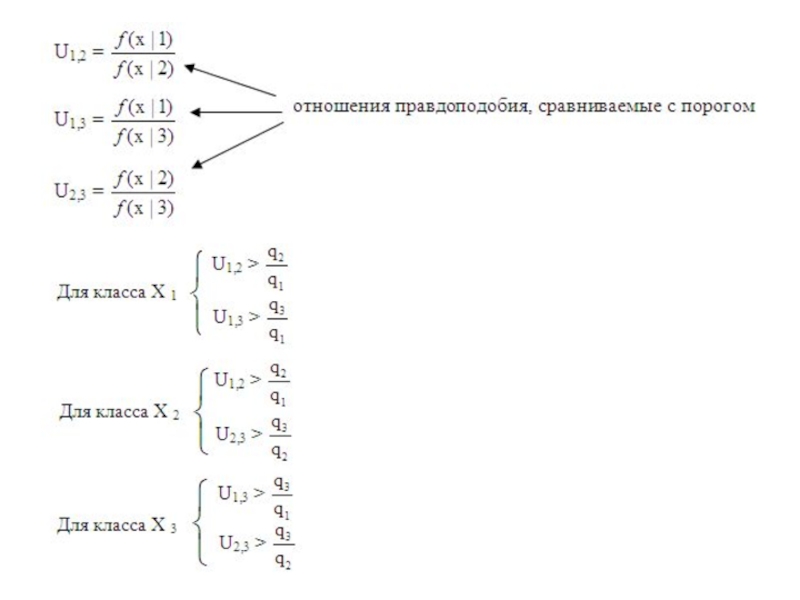

определяется max{qi f(x|i)} – то есть приводится байесовский критерий к критерию максимальной апостериорной вероятности.Если вернуться к линейно-дискриминантным функциям на основе отношения правдоподобия , то получим из рассмотренного выше следующее соотношение:

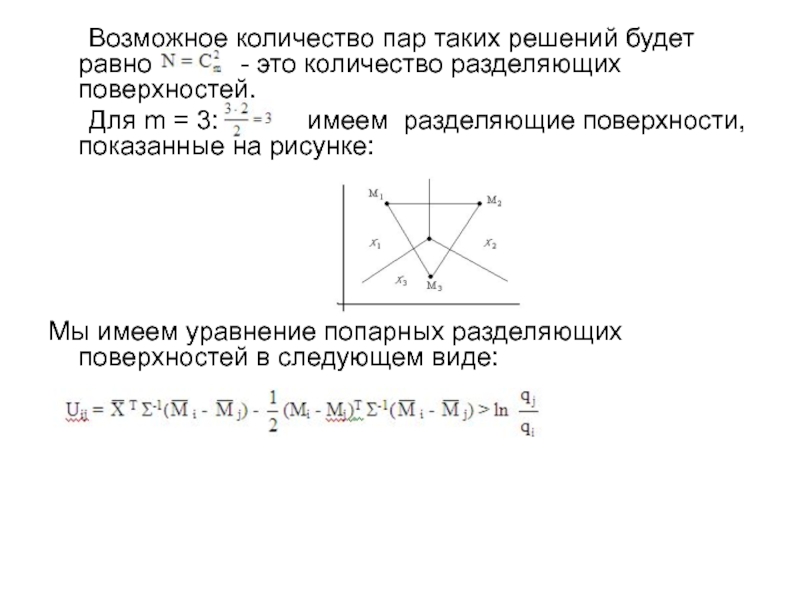

Слайд 13 Возможное количество пар таких решений будет равно

- это количество разделяющих поверхностей.

Для m = 3:

имеем разделяющие поверхности, показанные на рисунке:Мы имеем уравнение попарных разделяющих поверхностей в следующем виде: