Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Количество информации

Содержание

- 1. Количество информации

- 2. Комбинаторная мера Комбинаторная мера информации Q -

- 3. Пример 1Проведем опыт. Возьмем игральный кубик. Он

- 4. Пример 2 Пусть задана одна из десятичных

- 5. Из рассмотренного примера можно сделать вывод, что

- 6. Минимальное количество цифр в основании имеет только

- 7. Известны различные формы представления информации. Однако, электронно-вычислительная

- 8. В технических устройствах двоичная система счисления используется

- 9. Логарифмическая мераАнглийский инженер Р. Хартли предложил измерять

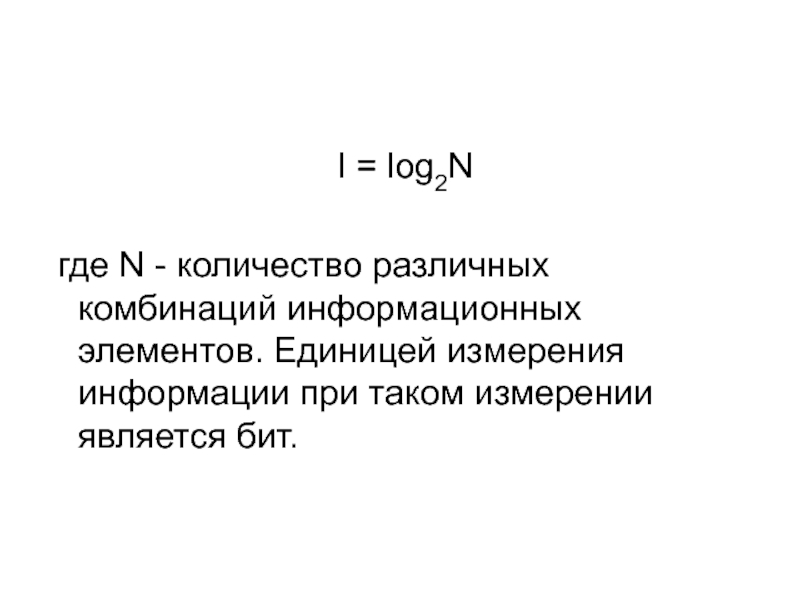

- 10. I = log2N где N -

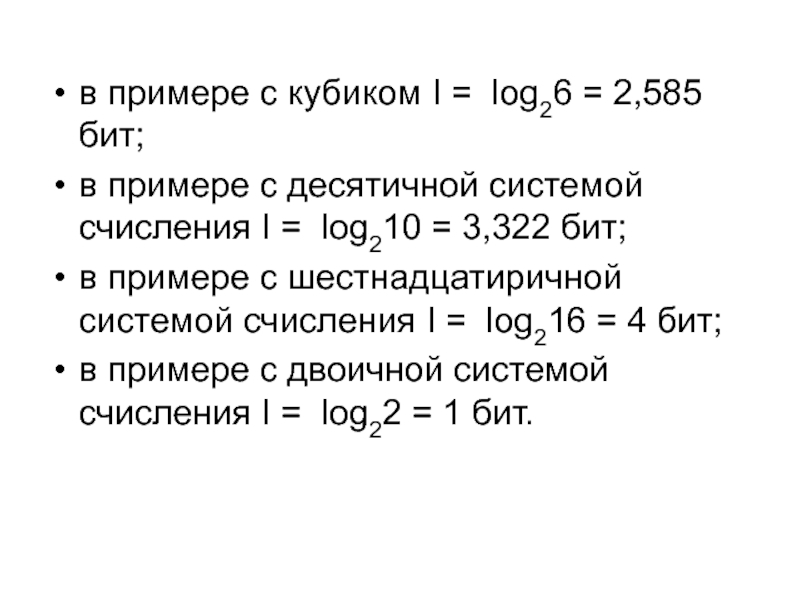

- 11. в примере с кубиком I = log26

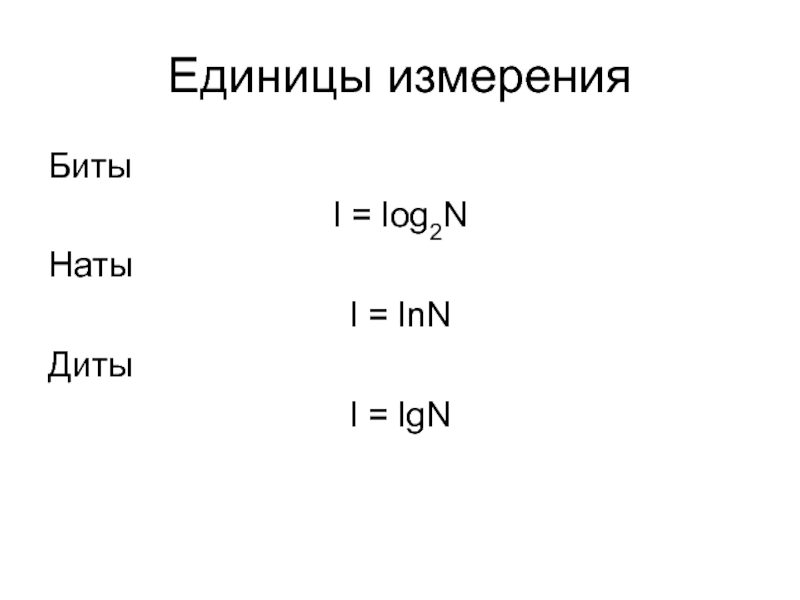

- 12. Единицы измеренияБитыI = log2NНатыI = lnNДитыI = lgN

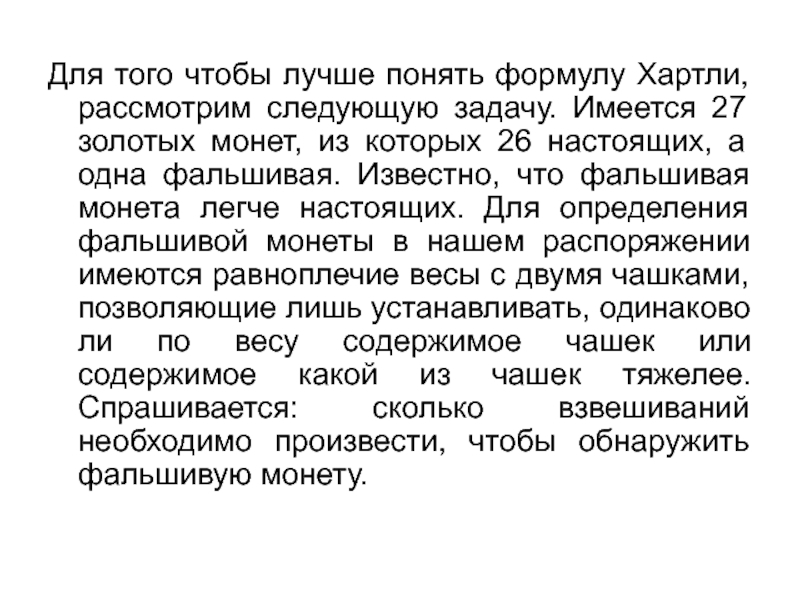

- 13. Для того чтобы лучше понять формулу Хартли,

- 14. Фальшивой монетой может оказаться любая из 27

- 15. Статистическая мера информацииЭнтропия группы событий – есть

- 16. Пусть N – количество возможных исходовк –

- 17. Свойства энтропии1.Энтропия всегда неотрицательна.2.Энтропия равна 0 когда

- 18. Объемный подходVд – объем информации (данных)Объем информации равен количеству символов в сообщении.

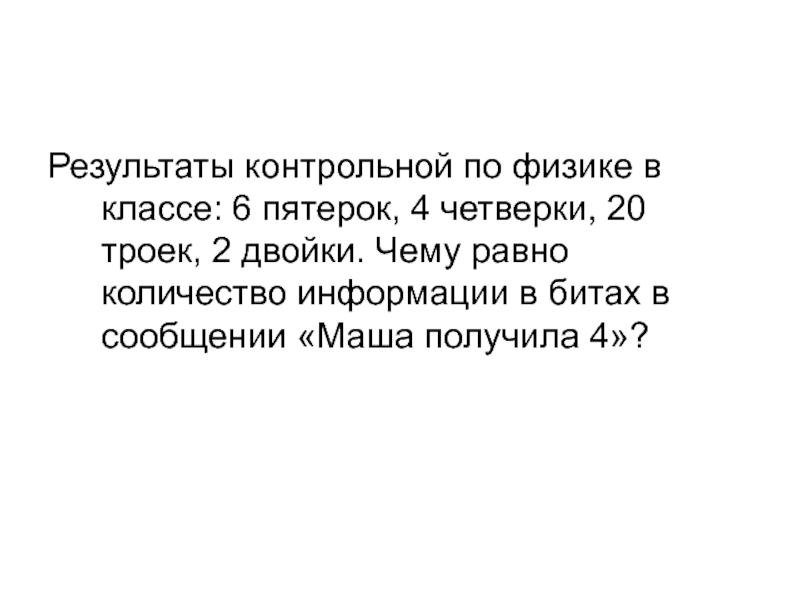

- 19. Результаты контрольной по физике в классе: 6

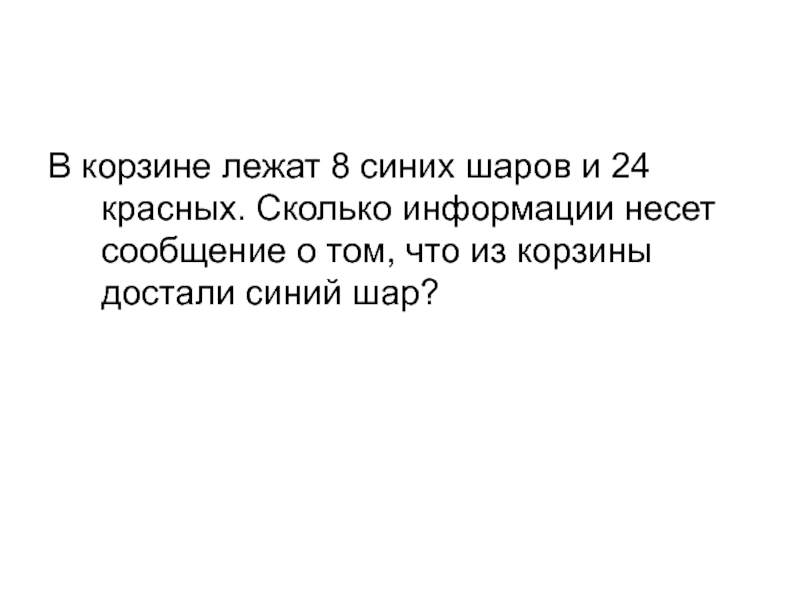

- 20. В корзине лежат 8 синих шаров и

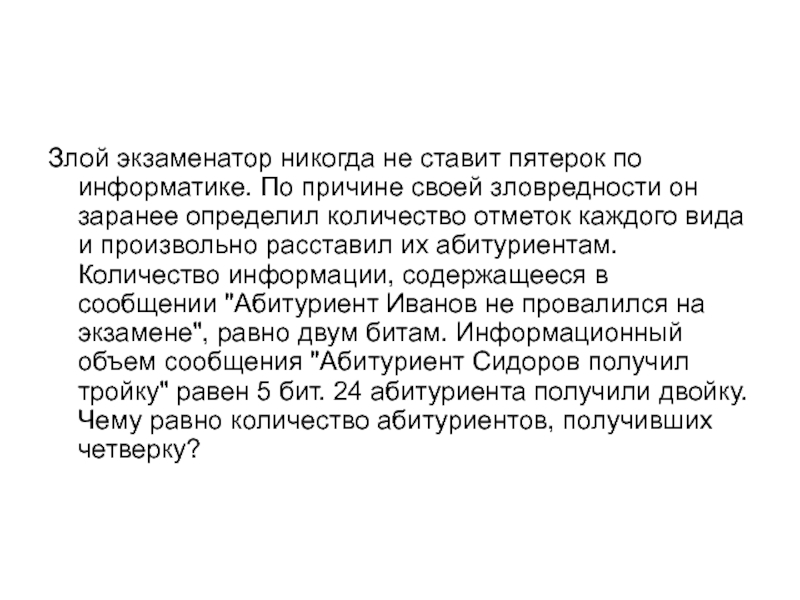

- 21. Злой экзаменатор никогда не ставит пятерок по

- 22. Скачать презентанцию

Комбинаторная мера Комбинаторная мера информации Q - это способ измерения количества информации путем оценки количества возможных комбинаций информационных элементов.

Слайды и текст этой презентации

Слайд 2Комбинаторная мера

Комбинаторная мера информации Q - это способ измерения

количества информации путем оценки количества возможных комбинаций информационных элементов.

Слайд 3Пример 1

Проведем опыт. Возьмем игральный кубик. Он имеет шесть сторон,

на каждой из которых изображены числа от одного до шести.

Подбрасывая игральный кубик сколь угодно раз, мы можем получить только шесть возможных чисел. Обозначим это какQ = 6.

Слайд 4Пример 2

Пусть задана одна из десятичных цифр, например, цифра

8 и одна из шестнадцатиричных – к примеру, цифра 6

(можно было взять любую другую шестнадцатиричную - 8, В, F и т. д.). Теперь, в соответствии с определением комбинаторной меры, определим количество информации, заключенное в каждой из этих цифр. Поскольку цифра 8 является десятичной, а значит, представляет один символ из десяти, то Q(8)= 10 комбинаций. Аналогично, цифра 6 представляет один из шестнадцати символов, а поэтому Q(6) = 16 комбинаций. Следовательно, что шестнадцатиричная цифра содержит больше информации, чем десятичная.Слайд 5Из рассмотренного примера можно сделать вывод, что чем меньше цифр

находится в основании системы счисления, тем меньше информации несет в

себе один ее элемент.Слайд 6Минимальное количество цифр в основании имеет только двоичная система счисления,

состоящая из двоичных цифр 0 и 1. Нетрудно посчитать, что,

в соответствии с комбинаторной мерой, количество информации в одной цифре двоичной системы счисления Q = 2 комбинации. Такое количество информации является минимальным.Слайд 7Известны различные формы представления информации. Однако, электронно-вычислительная машина – это

техническое устройство, основанное на работе электронных компонентов, а значит, обладающее

определенными физическими характеристиками. Поэтому, данные, предназначенные для ЭВМ, должна иметь физическое представление, причем это представление должно быть наиболее простым.Этим требованиям отвечает, так называемое, битовое представление информации, основанное на двоичной системе счисления, при котором каждая запоминаемая частица может принимать только два значения - либо 0, либо 1.

Слайд 8В технических устройствах двоичная система счисления используется для обозначения систем

с двумя возможными состояниями. Например:

- есть отверстие - нет

отверстия;- есть сигнал – нет сигнала;

- есть напряжение - нет напряжения.

Причем каждая двоичная цифра содержит один бит информации.

Слайд 9Логарифмическая мера

Английский инженер Р. Хартли предложил измерять количество информации двоичной

логарифмической мерой:

Если в заданном множестве H, содержащем N элементов, выделен

какой-то элемент x, о котором заранее известно, что он принадлежит множеству H, то чтобы найти x, необходимо получить количество информации, равное log2N битам.Слайд 10

I = log2N

где N - количество различных комбинаций

информационных элементов. Единицей измерения информации при таком измерении является бит.

Слайд 11в примере с кубиком I = log26 = 2,585 бит;

в

примере с десятичной системой счисления I = log210 = 3,322

бит;в примере с шестнадцатиричной системой счисления I = log216 = 4 бит;

в примере с двоичной системой счисления I = log22 = 1 бит.

Слайд 13Для того чтобы лучше понять формулу Хартли, рассмотрим следующую задачу.

Имеется 27 золотых монет, из которых 26 настоящих, а одна

фальшивая. Известно, что фальшивая монета легче настоящих. Для определения фальшивой монеты в нашем распоряжении имеются равноплечие весы с двумя чашками, позволяющие лишь устанавливать, одинаково ли по весу содержимое чашек или содержимое какой из чашек тяжелее. Спрашивается: сколько взвешиваний необходимо произвести, чтобы обнаружить фальшивую монету.Слайд 14

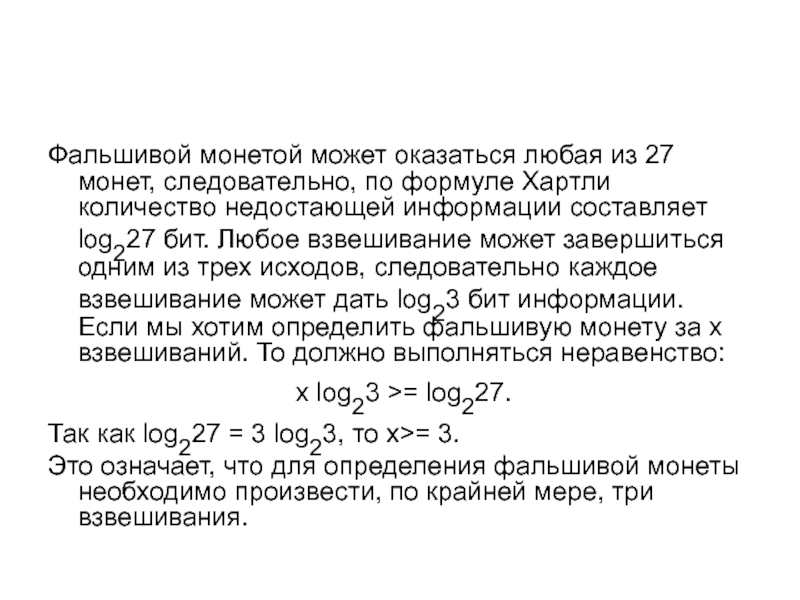

Фальшивой монетой может оказаться любая из 27 монет, следовательно, по

формуле Хартли количество недостающей информации составляет log227 бит. Любое взвешивание

может завершиться одним из трех исходов, следовательно каждое взвешивание может дать log23 бит информации. Если мы хотим определить фальшивую монету за x взвешиваний. То должно выполняться неравенство:x log23 >= log227.

Так как log227 = 3 log23, то x>= 3.

Это означает, что для определения фальшивой монеты необходимо произвести, по крайней мере, три взвешивания.

Слайд 15Статистическая мера информации

Энтропия группы событий – есть количественная мера его

неопределенности и следовательно информативности количественно выражаемая как средняя функция множества

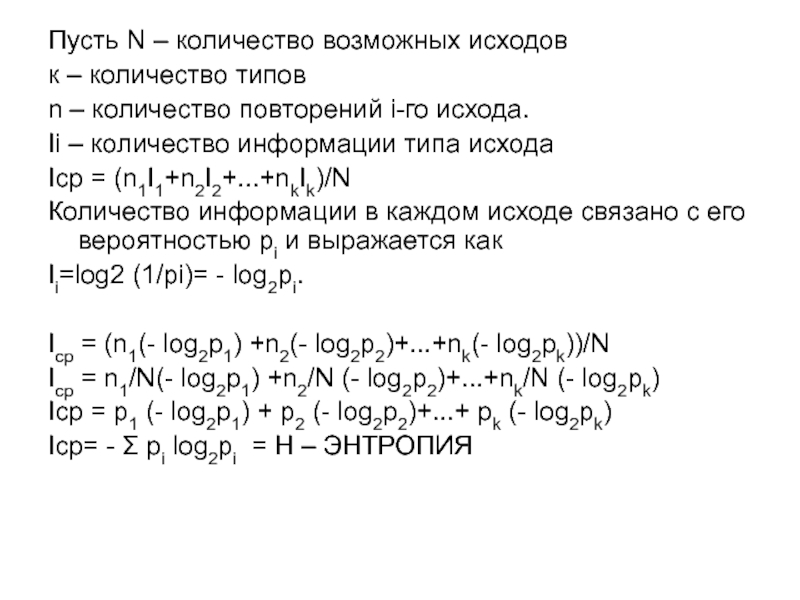

вероятностей каждого из возможных исходов опыта.Слайд 16Пусть N – количество возможных исходов

к – количество типов

n –

количество повторений i-го исхода.

Ii – количество информации типа исхода

Iср =

(n1I1+n2I2+...+nkIk)/NКоличество информации в каждом исходе связано с его вероятностью pi и выражается как

Ii=log2 (1/pi)= - log2pi.

Iср = (n1(- log2p1) +n2(- log2p2)+...+nk(- log2pk))/N

Iср = n1/N(- log2p1) +n2/N (- log2p2)+...+nk/N (- log2pk)

Iср = p1 (- log2p1) + p2 (- log2p2)+...+ pk (- log2pk)

Iср= - Σ pi log2pi = H – ЭНТРОПИЯ

Слайд 17Свойства энтропии

1.Энтропия всегда неотрицательна.

2.Энтропия равна 0 когда одно из pi

=1 а остальные равны 0.

3. Энтропия имеет наибольшее значение, когда

все вероятности равны между собой.4.Энтропия объекта, состояния которого образуются совместной реализацией состояний двух других объектов, равна сумме энтропий исходных объектов.