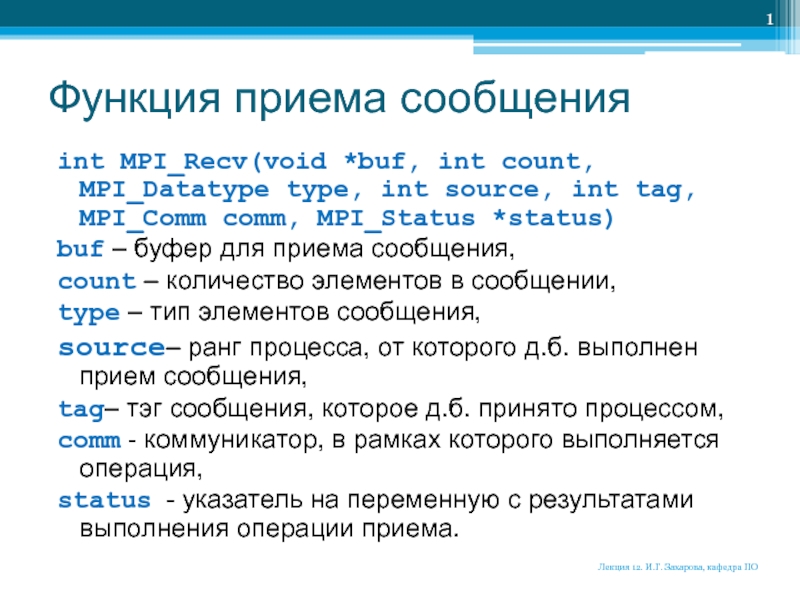

source, int tag, MPI_Comm comm, MPI_Status *status)

buf – буфер для

приема сообщения,count – количество элементов в сообщении,

type – тип элементов сообщения,

source– ранг процесса, от которого д.б. выполнен прием сообщения,

tag– тэг сообщения, которое д.б. принято процессом,

comm - коммуникатор, в рамках которого выполняется операция,

status - указатель на переменную с результатами выполнения операции приема.

Лекция 12. И.Г. Захарова, кафедра ПО

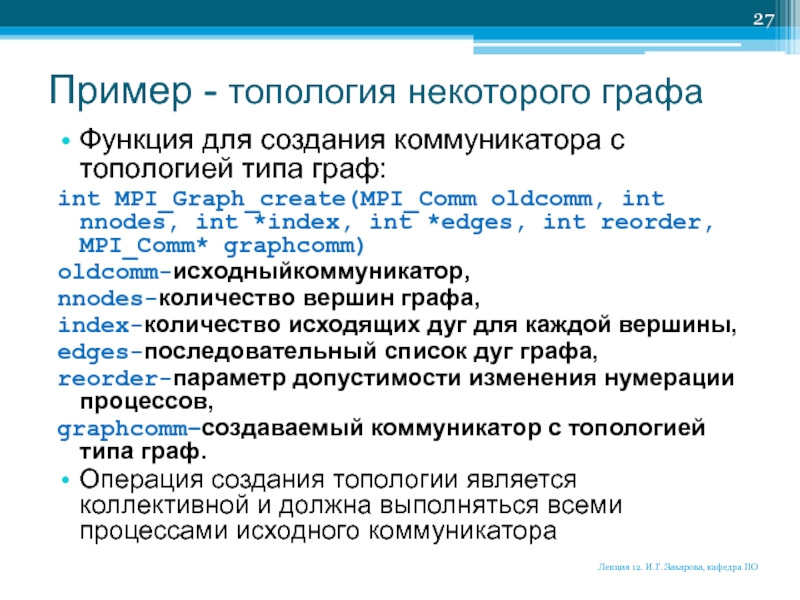

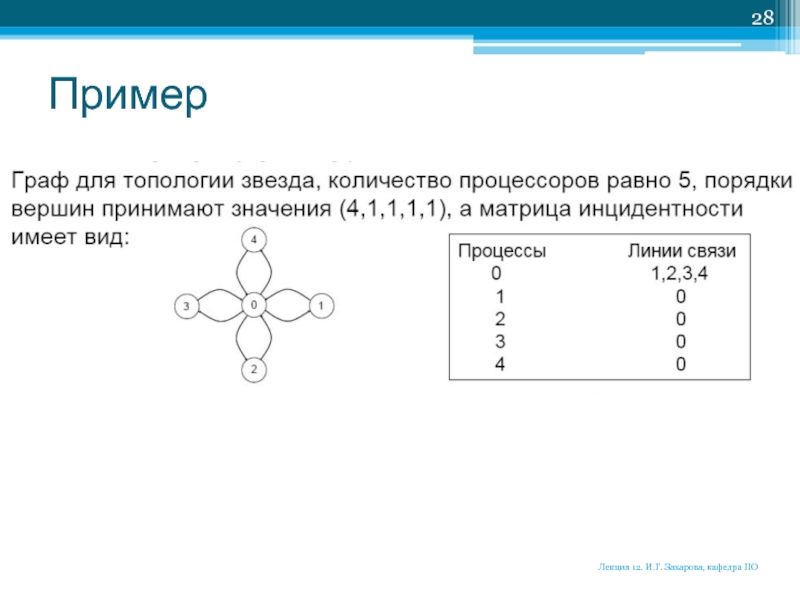

![lec12ПП.pptx Для создания топологии с графом данного вида необходимо добавить в программу Для создания топологии с графом данного вида необходимо добавить в программу код: ...int index[] = { 4,1,1,1,1](/img/thumbs/f267a0474e48d5f5a0f2cfb9e035325f-800x.jpg)