Мичиганского университета Клод Шеннон, которому было тогда 21 год, имея

два диплома бакалавра - по электротехнике и по математике, сумел ликвидировать разрыв между алгебраической теорией логики и ее практическим приложением. Свои идеи относительно связи между двоичным исчислением, булевой алгеброй и электрическими схемами Шеннон развил в докторской диссертации, опубликованной в 1938 году

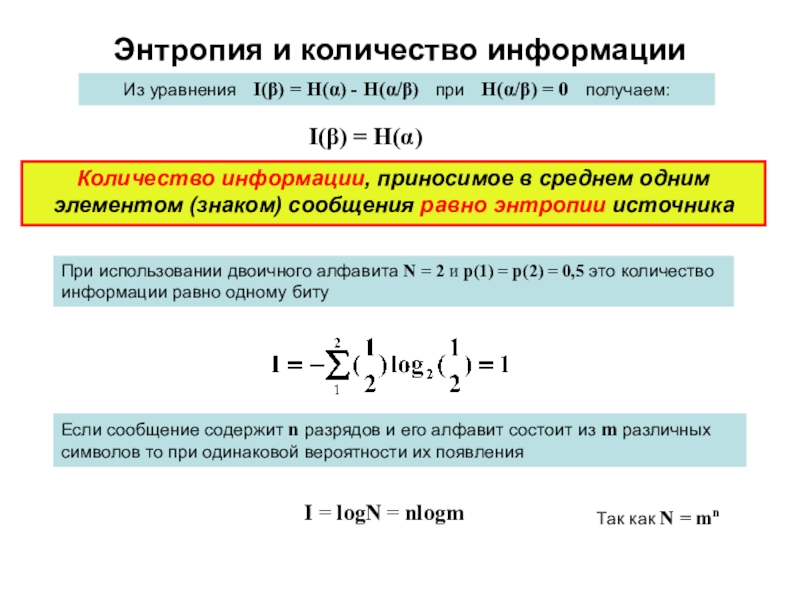

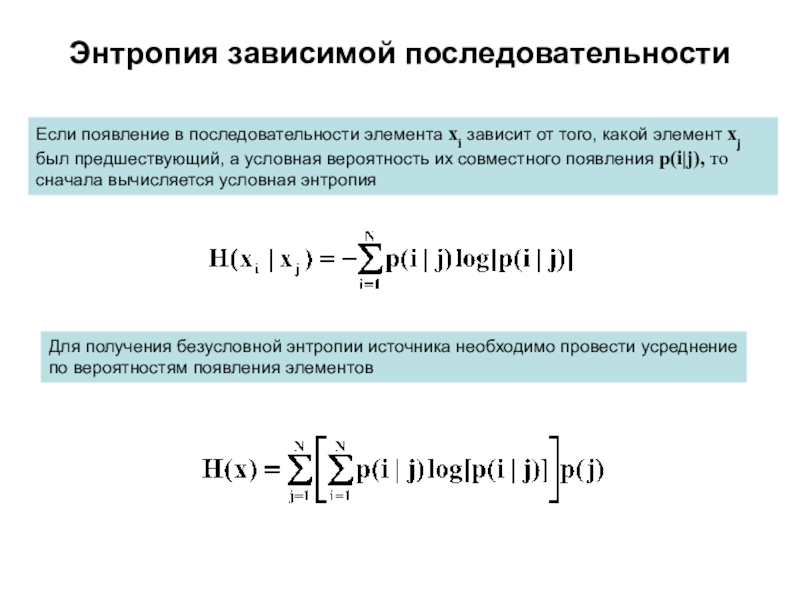

В 1948 году опубликовал фундаментальную работу A Mathematical Theory of Communication, в которой сформулированы основы теории информации.

Большую ценность представляет другая работа – Communication Theory of Secrecy Systems (1949), в которой сформулированы математические основы криптографии.

C 1956 – член Национальной академии наук США и Американской академии искусств и наук.

Клод Элвуд Шеннон – один из создателей математической теории информации, в значительной мере предопределил своими результатами развитие общей теории дискретных автоматов, которые являются важными составляющими кибернетики