Слайд 1

РАСПРЕДЕЛЕННАЯ ГРИД-ИНФРАСТРУКТУРА ДЛЯ ОБРАБОТКИ И АНАЛИЗА ДАННЫХ С БОЛЬШОГО АДРОННОГО

КОЛЛАЙДЕРА

Кореньков В.В.

заместитель директора Лаборатории информационных технологий ОИЯИ, заведующий кафедрой

распределенных информационных вычислительных систем Международного университета «Дубна»

XX Международная научно-техническая конференция

«Информационные средства и технологии»

Москва, МЭИ, 20.11.12

Слайд 2Cовременные научные исследования требует совместной работы многих организаций по обработке

большого объема данных в относительно короткие сроки.

Необходимы географически распределенные

вычислительные системы, способные передавать и принимать данные порядка сотен терабайт в сутки, одновременно обрабатывать сотни тысяч задач и долговременно хранить сотни петабайт данных.

Современные Грид-инфраструктуры обеспечивают интеграцию аппаратурных и программных ресурсов, находящихся в разных организациях в масштабах стран, регионов, континентов в единую вычислительную среду, позволяющую решать задачи по обработке сверхбольших объемов данных, чего в настоящее время невозможно достичь в локальных вычислительных центрах.

Слайд 3На семинаре 4 июля 2012 года, посвященном наблюдению бозона Хиггса,

директор ЦЕРНа Р.Хойер дал высокую оценку грид-технологиям и их значимости

для мировой науки.

Без организации грид-инфраструктуры на LHC было бы невозможно обрабатывать и хранить колоссальный объем данных, поступающих с коллайдера, а значит, - и совершать научные открытия.

Сегодня уже ни один крупный проект не осуществим без использования распределенной инфраструктуры для обработки данных.

Роль распределенной компьютерной инфраструктуры для обработки данных

Слайд 4«Грид - это система, которая:

· координирует использование ресурсов при отсутствии

централизованного управления этими ресурсами

· использует стандартные, открытые, универсальные

протоколы и

интерфейсы.

· обеспечивает высококачественное обслуживание»

(Ian Foster: "What is the grid? ", 2002 г.)

Концепция Грид

Модели грид:

Distributed Computing

High-Throughput Computing

On-Demand Computing

Data-Intensive Computing

Collaborative Computing

Междисциплинарный характер грид: развиваемые технологии применяются в физике высоких энергий, космофизике, микробиологии, экологии, метеорологии, различных инженерных и бизнес приложениях.

Виртуальные организации (VO)

Слайд 5

Грид - это средство для совместного использования вычислительных мощностей и

хранилищ данных посредством интернета

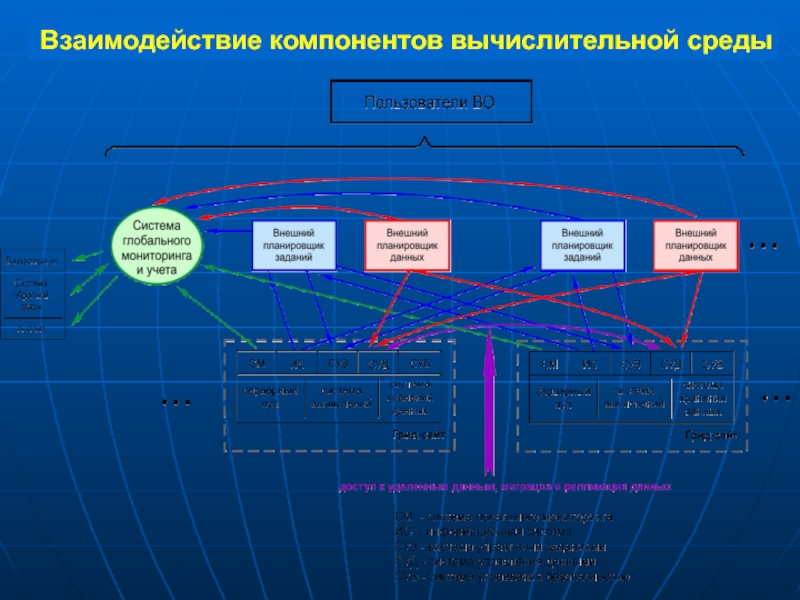

Слайд 6Взаимодействие компонентов вычислительной среды

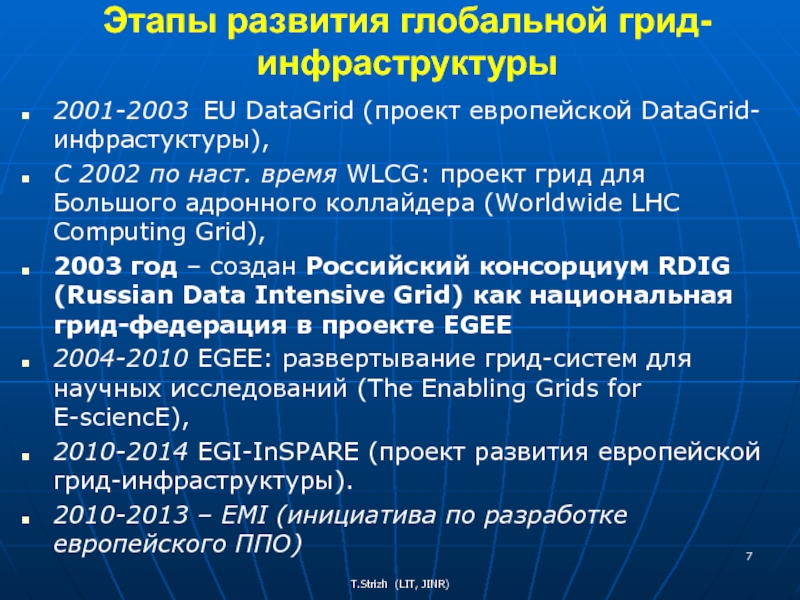

Слайд 7Этапы развития глобальной грид-инфраструктуры

2001-2003 EU DataGrid (проект европейской DataGrid-инфрастуктуры),

С 2002

по наст. время WLCG: проект грид для Большого адронного коллайдера

(Worldwide LHC Computing Grid),

2003 год – создан Российский консорциум RDIG (Russian Data Intensive Grid) как национальная грид-федерация в проекте EGEE

2004-2010 EGEE: развертывание грид-систем для научных исследований (The Enabling Grids for E-sciencE),

2010-2014 EGI-InSPARE (проект развития европейской грид-инфраструктуры).

2010-2013 – EMI (инициатива по разработке европейского ППО)

Слайд 8T. Strizh

Acting as the gatekeeper and matchmaker for the Grid,

middleware

monitors the Grid,

decides where to send computing jobs,

manages

users, data and storage,

check the identity of the user through the use of digital certificates.

For users the Grid will enable them to treat the distributed resources as one integrated computer system, with one single log on, and the middleware will handle all the negotiations, the submission of jobs and the collation of the results.

dCache

Слайд 9Основные подсистемы gLite

Вычислительный элемент (Computing Element – CE) –

это служба, представляющая ресурсный узел грид и выполняющая на нем

функции управления заданиями (запуск, удаление и т.д.).

Подсистема управления загрузкой (Workload Management System - WMS) состоит из ряда компонентов, ответственных за распределение заданий между ресурсами грид, а также обеспечивающих управление заданиями.

Подсистема управления данными (Data Management Subsystem - DM) включает три службы, поддерживающие доступ к файлам: элемент памяти (Storage Element – SE), службы каталога (Catalog Services – CS) и диспетчер данных (Data Scheduling –DS).

Подсистема безопасности рассматривается как средство защиты служб

Подсистема информационного обслуживания и мониторинга грид (Relational Grid Monitoring Architecture - R-GMA) решает задачу сбора и управления данными о состоянии грид, получая информацию от множества распределенных источников – поставщиков.

Подсистема учета (Accounting Subsystem - DGAS) аккумулирует информацию об использовании ресурсов грид отдельными пользователями, группами пользователей и виртуальными организациями.

Подсистема протоколирования (Logging and Bookkeeping - LB) отслеживает выполняющиеся в разных точных грид шаги обработки задания, фиксируя происходящие с ним события.

Слайд 10

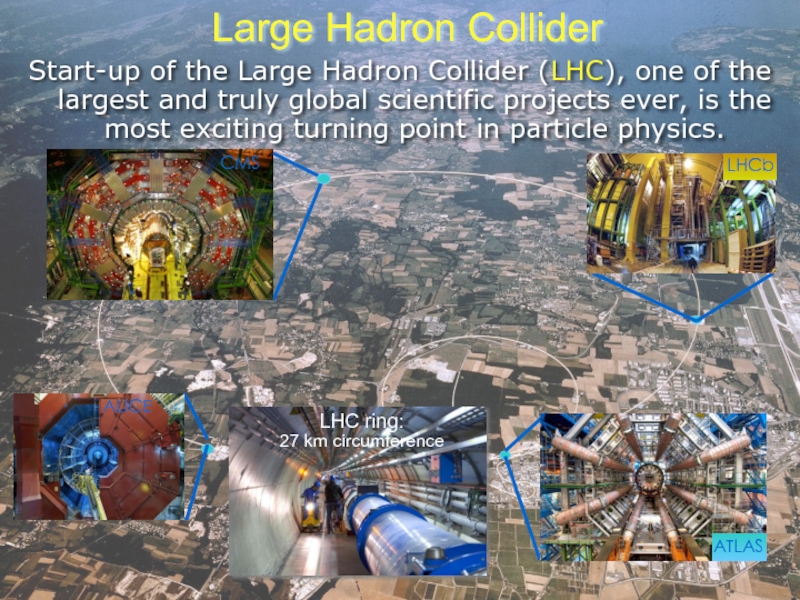

Large Hadron Collider

Start-up of the Large Hadron Collider (LHC), one

of the largest and truly global scientific projects ever, is

the most exciting turning point in particle physics.

LHC ring:

27 km circumference

Слайд 11Параметры детектора АТЛАС

Энергия центра масс 14 TeV

Частота столкновений пучков 40

MHz

Светимость :

начальная: 1031 см-2с-1

низкая: 2*1033 см-2с-1

целевая: 1034 см-2с-1

Вес 7000

тонн,

Диаметр 25м,

Длина 46м

Количество регистрирующих каналов 100 000 000

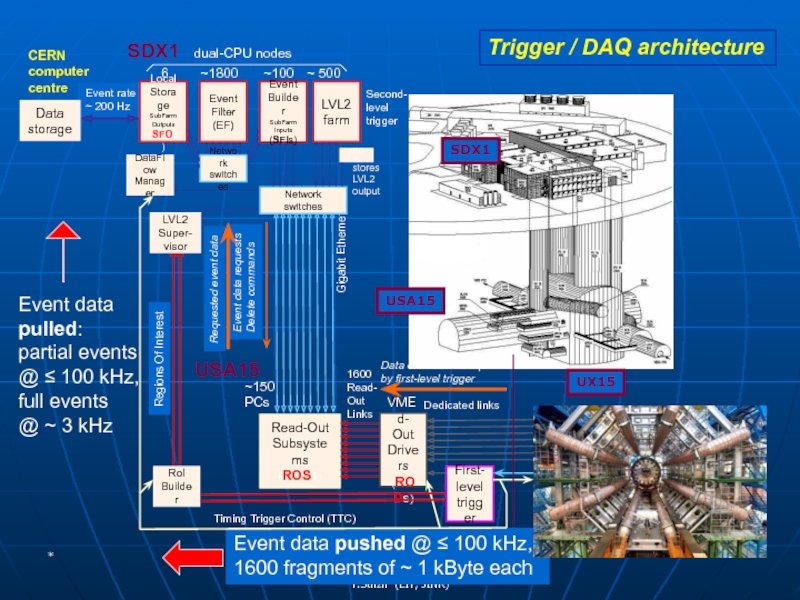

Слайд 12*

Event data

pulled:

partial events

@ ≤ 100 kHz,

full events

@ ~ 3 kHz

Trigger / DAQ architecture

LVL2

Super-

visor

Слайд 13Ian.Bird@cern.ch

1.25 GB/sec (ions)

Потоки данных от физических установок БАК до вычислительного

центра ЦЕРН (Tier 0 at CERN)

Слайд 14Взаимодействие уровней

Tier 0 – Tier 1 – Tier 2

Tier-0

(CERN): 15%

Прием данных

Начальная реконструкция данных

Распределение данных

Tier-1 (11 centres): 40%

Постоянное хранение

данных

Реконструкция и обработка

Анализ

Tier-2 (200 centres): 45%

Моделирование

Физический анализ

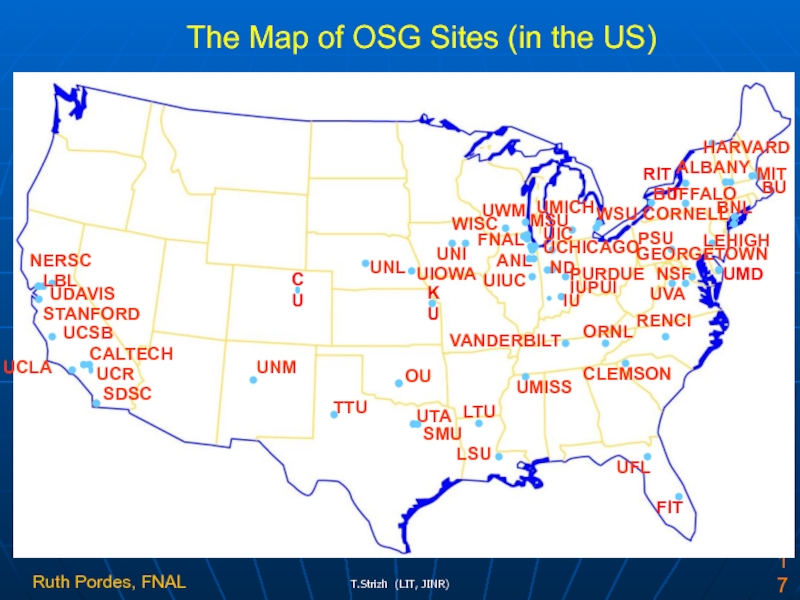

Слайд 17

NERSC

BU

UNM

SDSC

UTA

OU

FNAL

ANL

WISC

BNL

VANDERBILT

PSU

UVA

CALTECH

PURDUE

IU

BUFFALO

TTU

CORNELL

ALBANY

UMICH

IUPUI

STANFORD

CU

UWM

UNL

UFL

KU

UNI

WSU

MSU

LTU

LSU

CLEMSON

UMISS

UIUC

UCR

UCLA

LEHIGH

NSF

ORNL

HARVARD

UIC

SMU

UCHICAGO

MIT

RENCI

LBL

GEORGETOWN

UIOWA

UDAVIS

ND

UCSB

FIT

UMD

T

RIT

The Map of OSG Sites (in the US)

Ruth Pordes, FNAL

Слайд 18Tier 0

Tier 1

Tier 2

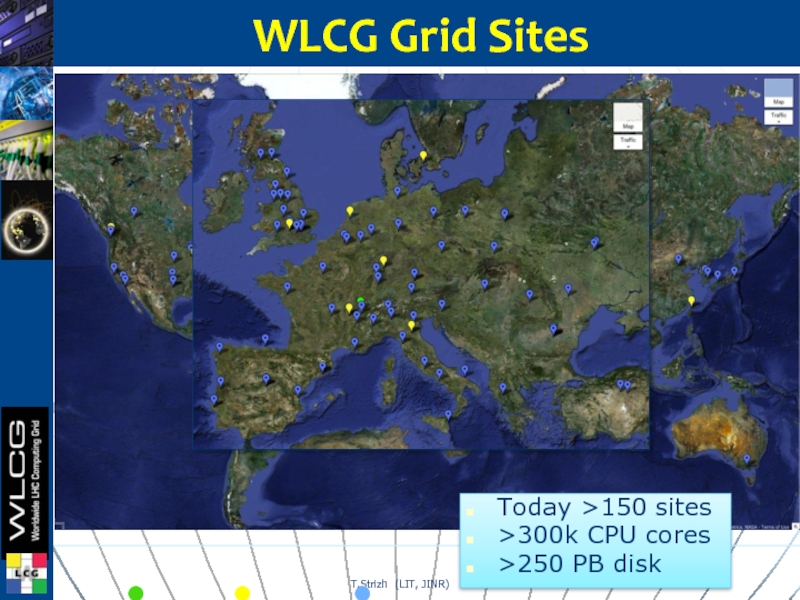

WLCG Grid Sites

Today >150 sites

>300k CPU cores

>250

PB disk

Слайд 19Российский консорциум RDIG (Russian Data Intensive Grid) был создан в

2003 году как национальная грид-федерация в проекте EGEE.

В настоящее

время RDIG –инфраструктура состоит из 16 ресурсных центров, в которых доступно около 7000 процессоров и более

4000 TB дискового пространства.

РДИГ инфраструктура

RDIG центры:

– ITEP

– JINR-LCG2

– Kharkov-KIPT

– RRC-KI

– RU-Moscow-KIAM

– RU-Phys-SPbSU

– RU-Protvino-IHEP

– RU-SPbSU

– Ru-Troitsk-INR

– ru-IMPB-LCG2

– ru-Moscow-FIAN

– ru-Moscow-GCRAS

– ru-Moscow-MEPHI

– ru-PNPI-LCG2

– ru-Moscow-SINP

- BY-NCPHEP

Слайд 20 Ресурсы:

2582 вычислительных узлов

Дисковое хранилище более 2 PB (Петабайт)

В

2012 году выполнено более 6 миллионов задач пользователей,

которые использовали 135

млн. часов в единицах HEPSpec06

(46 % от всех российских грид-сайтов)

Надежность и доступность = 99%

Вычислительный комплекс ОИЯИ

Слайд 22Система мониторинга ресурсного центра ОИЯИ

(http://litmon.jinr.ru)

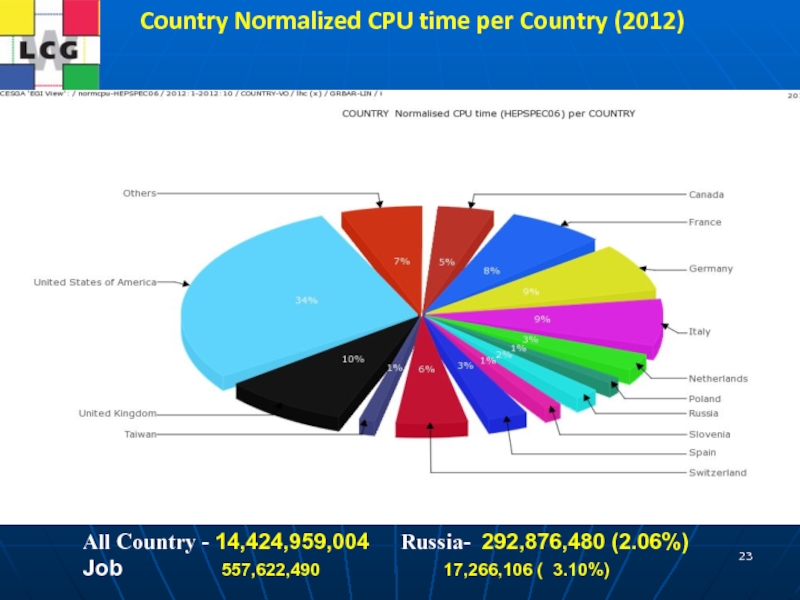

Слайд 23Country Normalized CPU time per Country (2012)

All Country - 14,424,959,004

Russia- 292,876,480 (2.06%) Job

557,622,490 17,266,106 ( 3.10%)

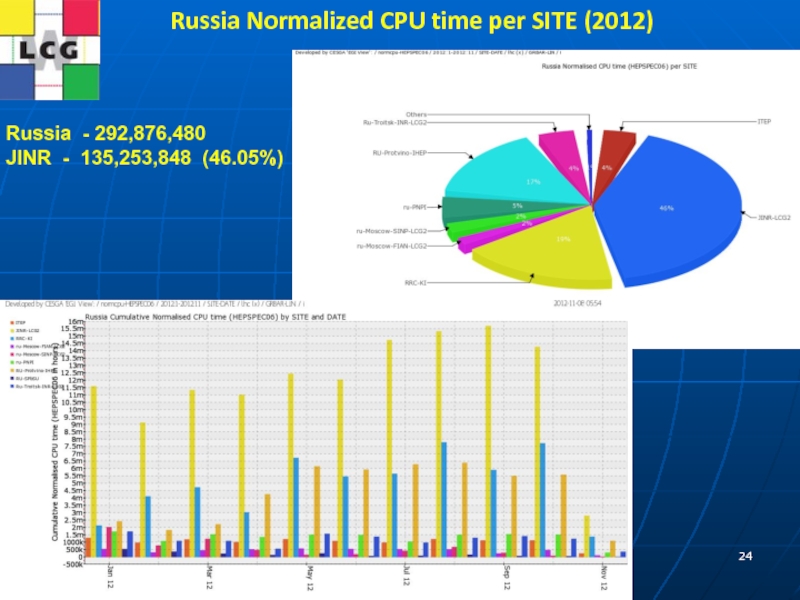

Слайд 24Russia Normalized CPU time per SITE (2012)

Russia - 292,876,480

JINR

- 135,253,848 (46.05%)

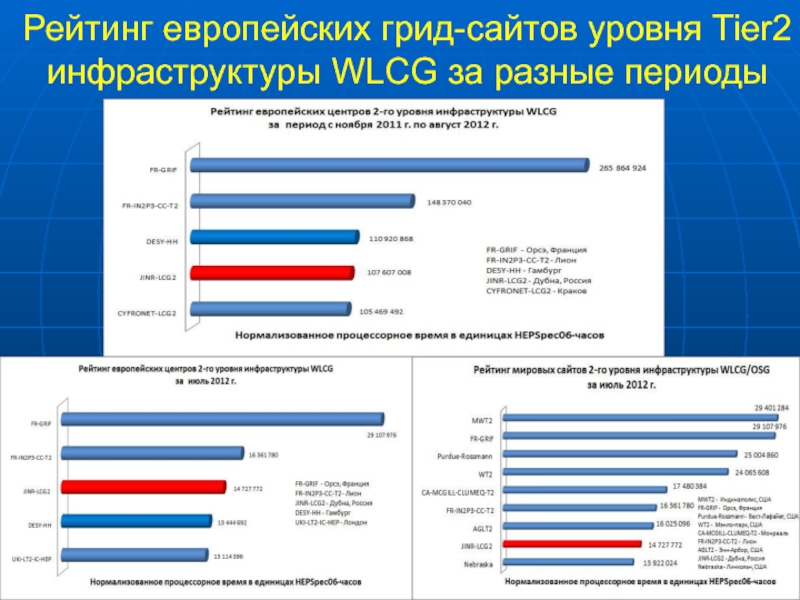

Слайд 25Рейтинг европейских грид-сайтов уровня Tier2 инфраструктуры WLCG за разные периоды

Слайд 26Worldwide LHC Computing Grid Project (WLCG)

Основной задачей проекта WLCG является

создание глобальной инфраструктуры региональных центров для обработки, хранения и анализа

данных физических экспериментов LHC.

Грид-технологии являются основой построения этой инфраструктуры.

Протокол между ЦЕРН, Россией и ОИЯИ об участии в проекте LCG был подписан в 2003 году.

MoU об участии в проекте WLCG был подписан в 2007 году.

Задачи российских центров и ОИЯИ в проекте WLCG в 2012 году:

Создание комплекса тестов для gLite

Внедрение сервисов WLCG для экспериментов

Развитие систем мониторинга WLCG

Система глобального мониторинга Tier3 центров

Развитие пакетов моделирования для экспериментов

Разработка архитектуры Tier1 центра в России

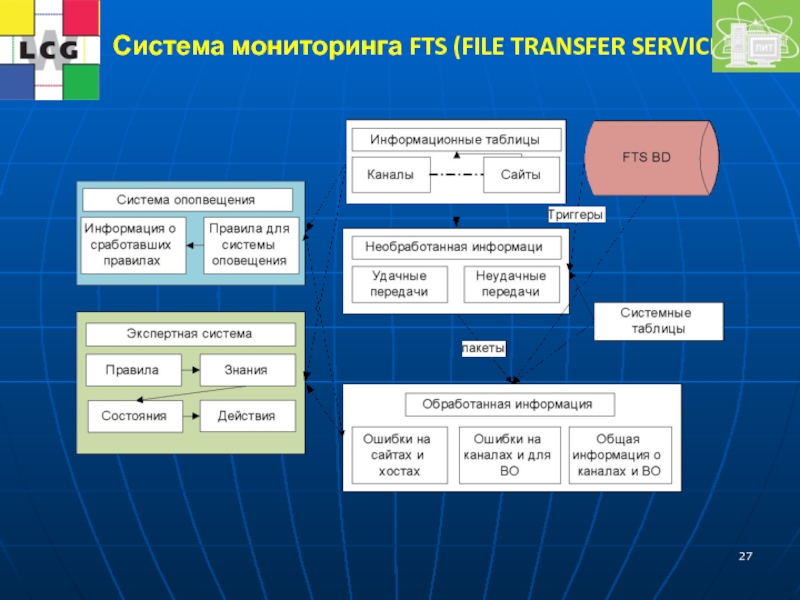

Слайд 27Система мониторинга FTS (FILE TRANSFER SERVICE)

Слайд 28

WLCG – no stop for computing

Activity on 3rd Jan

Слайд 29Архитектура системы распределенного хранения данных эксперимента ATLAS

В 2010 году возникла

необходимость разработать новую архитектуру сервиса удаления данных для обеспечения целостности

распределенного хранения информации эксперимента ATLAS.

Сервис удаления данных один из основных сервисов DQ2:

обслуживает запросы на удаление,

организует балансировку нагрузки,

обеспечивает масштабируемость и отказоустойчивость системы DQ2,

корректную обработку исключений, возникающих в процессе работы,

стратегию повтора операций в случае возникновения отказов.

Разработаны:

новый интерфейс между компонентами сервиса удаления (основанного на технологии веб-сервисов),

создана новая схема базы данных,

перестроено ядра сервиса,

созданы интерфейсы с системами массового хранения,

модернизирована система мониторинга работы сервиса.

Созданный сервис обеспечивает целостность хранения информации в географически распределенной среде. Данные эксперимента ATLAS распределены более, чем на 130 грид-сайтах с общим объемом дискового пространства более 120 петабайт, в котором хранятся сотни миллионов файлов. Недельный объем удаляемых данных составляет 2 Пб (20 000 000 файлов).

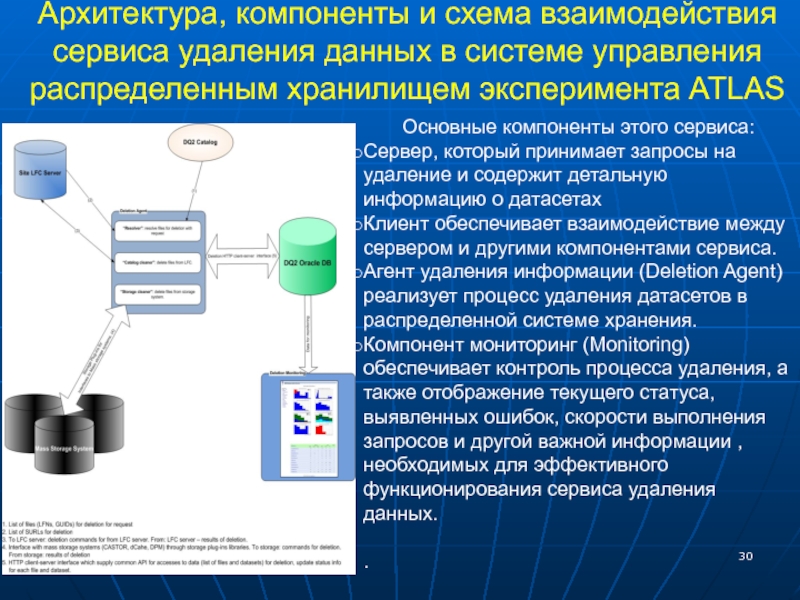

Слайд 30Архитектура, компоненты и схема взаимодействия сервиса удаления данных в системе

управления распределенным хранилищем эксперимента ATLAS

Основные компоненты

этого сервиса:

Сервер, который принимает запросы на удаление и содержит детальную информацию о датасетах

Клиент обеспечивает взаимодействие между сервером и другими компонентами сервиса.

Агент удаления информации (Deletion Agent) реализует процесс удаления датасетов в распределенной системе хранения.

Компонент мониторинг (Monitoring) обеспечивает контроль процесса удаления, а также отображение текущего статуса, выявленных ошибок, скорости выполнения запросов и другой важной информации , необходимых для эффективного функционирования сервиса удаления данных.

.

Рис. х.

Слайд 31Функционирование сервиса

Скорость удаления данных может достигать довольно больших величин: это

миллионы файлов в день и терабайты очищенного дискового пространства. Удаление

данных за 24-часовой период. Скорость удаления - более 350 тысяч файлов в час.

Слайд 32Систематизация и классификация центров уровня Tier3

Co-located Tier3 - функционируют

вместе

с Tier2 центрами, используют общую

инфраструктуру или часть сервисов

Tier3gs - кластер с полным набором

функциональности грид-сайта

Tier3g - кластер с частичной

грид-функциональностью

Tier3w - рабочая станция с набором

программ для доступа к грид-сайтам

в качестве потребителя

Диаграмма 1. Системы хранения

Диаграмма 2. Доступ к системам хранения

Диаграмма 3. Batch-системы

Слайд 33Архитектура тестовой среды на базе виртуальных кластеров для Tier3 центров

Слайд 34:

.

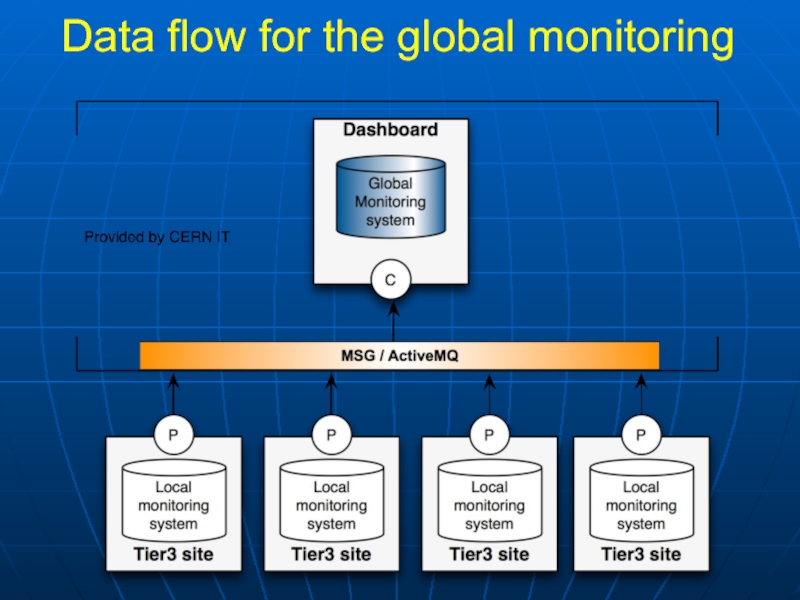

Система мониторинга Tier3-центров для анализа данных экспериментов БАК

Реализация системы мониторинга

Tier3 – центров (не-грид) имеет огромное значение для координации работ

в рамках виртуальной организации, так как обеспечивается глобальный взгляд на вклад Tier3 сайтов в вычислительный процесс.

Для исследования центров уровня Tier3 в ОИЯИ была разработана архитектура тестовой инфраструктуры, которая позволяет создавать прототипы различных конфигураций центров уровня Tier3. С применением технологий виртуализации такая инфраструктура была реализована на базе виртуальных кластеров, что позволило разработать для каждого варианта конфигурации документацию, настроить или разработать средства локального мониторинга, выработать полные рекомендации по системе сбора информации для глобального мониторинга центров уровня Tier3.

Слайд 35Data flow for the global monitoring

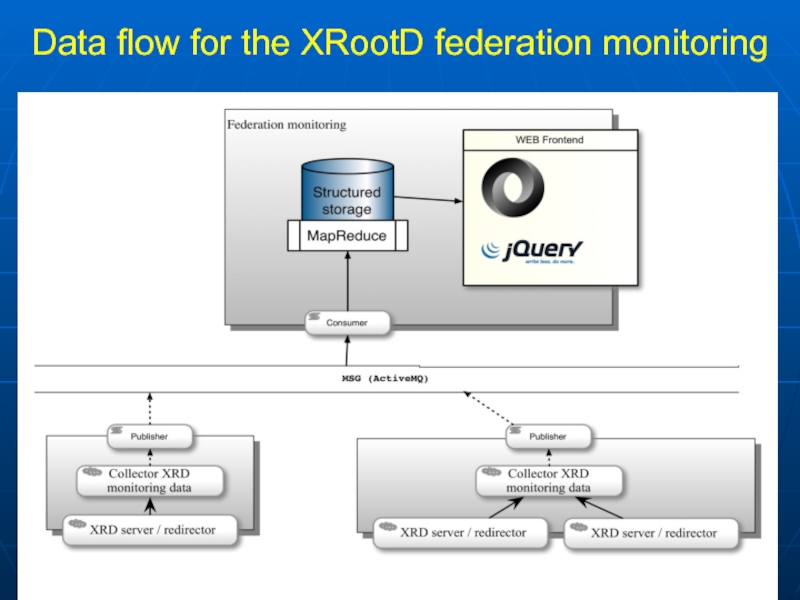

Слайд 36Data flow for the XRootD federation monitoring

Слайд 37Глобальная система мониторинга передачи данных в инфраструктуре WLCG

Суть проекта состоит

в создании универсальной системы мониторинга, способной собирать подробную информацию :

о

каждой передаче данных (около 1 Петабайта в день),

независимо от метода осуществления передачи (несколько протоколов и сервисов передачи файлов, FTS, xROOTd),

уровень ресурсного центра (Tier-0,Tier-1,Tier-2,Tier-3)

принадлежности данных определенной виртуальной организации;

передавать с высокой степенью надежности собранную информацию в центральное хранилище;

обрабатывать собранные данные для предоставления различным потребителям;

предоставлять пользовательские и программные интерфейсы для получения данных.

Система позволяет полностью удовлетворить потребности в информации различных типов пользователей и администраторов инфраструктуры WLCG.

Слайд 38Архитектура глобальной системы мониторинга передачи данных в инфраструктуре WLCG

Слайд 39Архитектура учебно-исследовательской и тестовой инфраструктуры стран-участниц ОИЯИ

Разработана архитектура учебно-исследовательской и

тестовой инфраструктуры на базе технологий виртуализации, которая включает конвергенцию технологий:

различные платформы грид (gLite, ARC, GT 5), платформу добровольных вычислений BOINC, платформу облачных вычислений на базе программного продукта OpenNebula.

.

Эта инфраструктура состоит из 10 ресурсных центров (Россия, Украина, Болгария, Узбекистан, Казахстан, Монголия) и служит для обучения и тренинга пользователей, системных администраторов и разработчиков грид-приложений

Слайд 40Архитектура российской национальной нанотехнологической грид-сети (ГридННС)

Совместно с другими научными центрами

России была разработана архитектура проекта российской национальной нанотехнологической грид-сети (ГридННС),

который выполнялся в рамках федеральной целевой программы "Развитие инфраструктуры наноиндустрии в Российской Федерации на 2008-2010 годы". ГридННС является полномасштабной вычислительной грид-инфраструктурой, базирующейся на специально разработанном, учитывающем особенности прикладной области, промежуточном программном обеспечении (ППО), основанном на Globus Toolkit (4/5) и современных REST сервисах. ППО ГридННС является оригинальной разработкой данного проекта, направленной на удовлетворение ключевых запросов в области наноиндустрии.

В ГридННС включены суперкомпьтерные центры России, что позволяет решать сложные вычислительные задачи в области нанотехнологий, аэро- и гидродинамики. В рамках этого проекта разработаны и реализованы системы мониторинга, учёта использования ресурсов, поддержки системы регистрации грид-сервисов и сайтов, поддержки виртуальных организаций.

Слайд 41Инфраструктура ГридННС

10 ресурсных центров (суперкомпьютеров) разных регионов России включены в

инфраструктуру ГридННС

Слайд 42Российская грид-сеть

Программа реализуется при поддержке Минкомсвязи для создания инфраструктуры распределенных

вычислений в России, объединяющая суперкомпьютерные центры, центры хранения данных, на

которых поддерживаются современные пакеты программ для науки и сектора высоких технологий.

Необходимо объединить усилия, чтобы создать единую межведомственную инфраструктуру распределенных вычислений в России (грид, облака, суперкомпьютеры, центры хранения данных), на которой можно организовать много виртуальных сред для различных задач.

Слайд 43Ускорительный комплекс НИКА

Для проекта НИКА поток данных имеет следующие параметры:

высокая

скорость набора событий (до 6 КГц),

в центральном столкновении Au-Au при

энергиях НИКА образуется до 1000 заряженных частиц,

Прогнозируемое количество событий 19 миллиардов;

общий объем исходных данных может быть оценен в 30 PB ежегодно, или 8.4 PB после обработки.

Слайд 44

Моделирование системы обработки экспериментов

на ускорительном комплексе НИКА

а) Какие вычислительные ресурсы

необходимы для обработки данных;

b) Какая должна быть архитектура грид системы;

c)

Какое количество ресурсных центров должно быть;

d) Какая стратегия запуска задач будет оптимальна;

e) Какие ресурсы хранения данных необходимы.

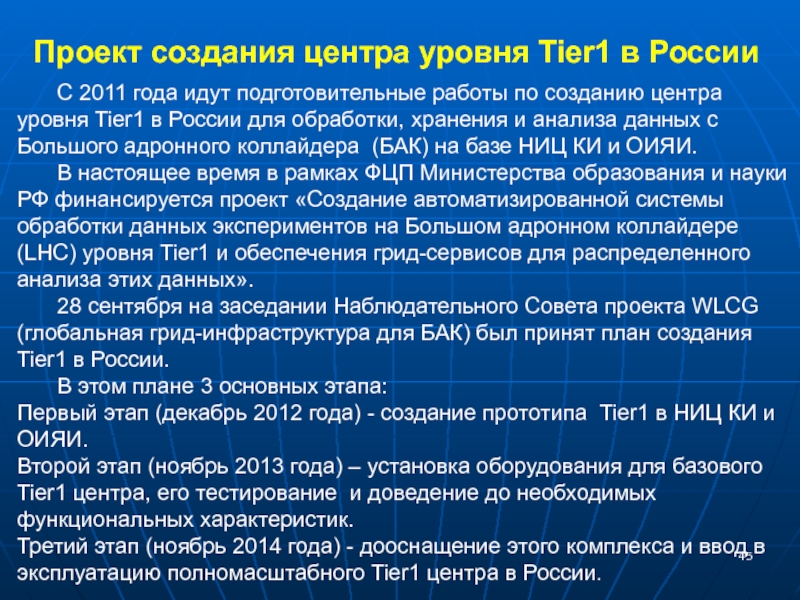

Слайд 45 С 2011 года идут подготовительные работы по созданию центра уровня

Tier1 в России для обработки, хранения и анализа данных с

Большого адронного коллайдера (БАК) на базе НИЦ КИ и ОИЯИ.

В настоящее время в рамках ФЦП Министерства образования и науки РФ финансируется проект «Создание автоматизированной системы обработки данных экспериментов на Большом адронном коллайдере (LHC) уровня Tier1 и обеспечения грид-сервисов для распределенного анализа этих данных».

28 сентября на заседании Наблюдательного Совета проекта WLCG (глобальная грид-инфраструктура для БАК) был принят план создания Tier1 в России.

В этом плане 3 основных этапа:

Первый этап (декабрь 2012 года) - создание прототипа Tier1 в НИЦ КИ и ОИЯИ.

Второй этап (ноябрь 2013 года) – установка оборудования для базового Tier1 центра, его тестирование и доведение до необходимых функциональных характеристик.

Третий этап (ноябрь 2014 года) - дооснащение этого комплекса и ввод в эксплуатацию полномасштабного Tier1 центра в России.

Проект создания центра уровня Tier1 в России

Слайд 46Joint NRC "Kurchatov Institute" – JINR

Tier1 Computing Centre

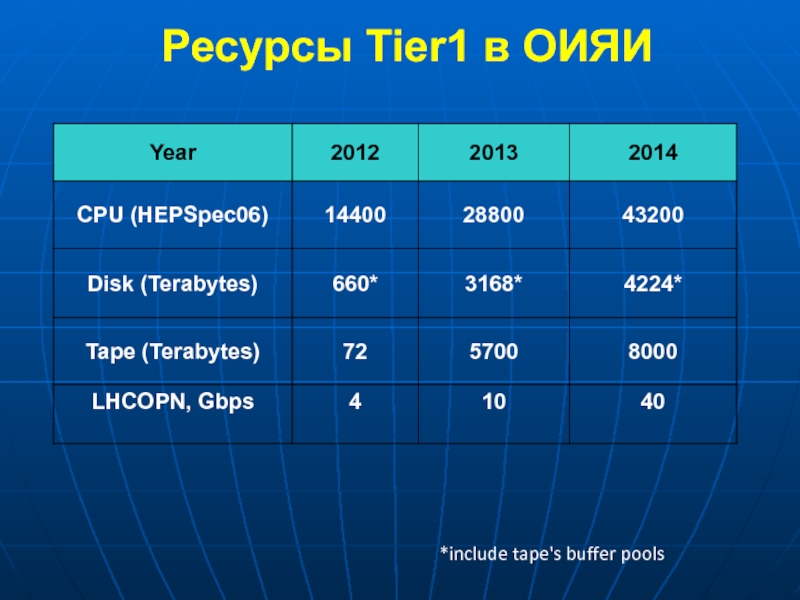

Слайд 47Ресурсы Tier1 в ОИЯИ

*include tape's buffer pools

Слайд 48Milestones of the JINR CMS Tier-1 Deployment and Commissioning

Слайд 49Barcelona/PIC

Ian Bird, CERN

26 June 2009

Russia:

NRC KI and JINR

Слайд 50 Были проработаны требования к ресурсам и функции региональных центров уровней

Tier0, Tier1, Tier2.

Разработанная модель была реализована и успешно функционирует

с момента запуска Большого адронного коллайдера в 2009 году. Ежегодно собираются и обрабатываются данные объемом в десятки и даже сотни петабайт.

Эта централизованная модель компьютинга хорошо зарекомендовала себя в первые годы работы экспериментов на БАК, однако постепенно наблюдается тенденция к децентрализации сервисов и переносу акцентов с массовой обработки данных на обеспечение индивидуального анализа.

Происходит эволюция модели компьютинга экспериментов на БАК:

переход от иерархической структуры к сетевой, а в идеале к полно-связной, где возможны связи между центрами всех уровней;

развитие средств распределенного управления данными, поддержка очень высоких скоростей передачи огромных массивов данных;

создание мощных и разнообразных центров уровня Tier3 для индивидуального анализа данных;

развитие и применение средств виртуализации и облачных вычислений (проект «Helix Nebula – научное облако»)

Эволюция распределенной инфраструктуры и модели компьютинга постоянно развивается в направлении конвергенции технологий.

Эволюция инфраструктуры и модели компьютинга экспериментов на БАК:

Слайд 51

Новые решения и перспективы в обработке «Больших Данных»

Постоянно растущие

объёмы научных данных ставят новые задачи перед технологиями распределённых вычислений

и Грид. Набирающая размах революция Больших Данных ведёт к открытиям в самых различных областях науки, включая нанотехнологии, астрофизику, физику высоких энергий, биологию и медицину. Новые проекты и разработки преображают исследования, основанные на данных, расширяя границы применения Больших Данных и требуя массивной обработки данных новыми методами. При обработке массивов данных объемами порядка петабайтов, современные учёные имеют дело не с отдельными файлами, а с наборами данных. В результате, единицей обработки петабайтного массива в системах Грид становится вычислительная задача, состоящая из многих подзадач. Разбиение обработки на отдельные задачи ведёт к созданию контрольных точек с высокой степенью детальности и обеспечивается отказоустойчивость обработки данных в системах Грид: прерванные в результате сбоев задания могут быть автоматически перезапущены, чем достигается качество обработки. Необходимость повторного исполнения отдельных заданий ведёт к непредсказуемому снижению эффективности использования вычислительного ресурса. Опыт компьютерной обработки данных на LHC позволяет изучить связь между отказоустойчивыми решениями и эффективностью, и разработать новые масштабируемые подходы к применению технологий Грид для обработки объемов данных, превышающих сотни петабайт.

Слайд 52Frames for Grid cooperation of JINR

Worldwide LHC Computing Grid

(WLCG);

EGI-InSPIRE

RDIG Development

CERN-RFBR project “Global data transfer monitoring system for WLCG infrastructure”

NASU-RFBR project “Development and support of LIT JINR and NSC KIPT grid-infrastructures for distributed CMS data processing of the LHC operation”

BMBF grant “Development of the Grid-infrastructure and tools to provide joint investigations performed with participation of JINR and German research centers”

“Development of Grid segment for the LHC experiments” was supported in frames of JINR-South Africa cooperation agreement;

Development of Grid segment at Cairo University and its integration to the JINR GridEdu infrastructure

JINR - FZU AS Czech Republic Project “The GRID for the physics experiments”

JINR-Romania cooperation Hulubei-Meshcheryakov programme

JINR-Moldova cooperation (MD-GRID, RENAM)

JINR-Mongolia cooperation (Mongol-Grid)

JINR-Slovakia cooperation

JINR- Kazakhstan cooperation (ENU Gumelev)

Project “Russian Grid Network”

Слайд 53 GRID’2012 Conference

22 countries,

256 participants,

40

Universities and Institutes from Russia,

31 Plenary,

89 Section talks

MPAMCS 2012

Conference-School for Young Scientists “Modern Problems of Applied Mathematics & Computer Science”

17 invited lectures

47 talk from young scientists

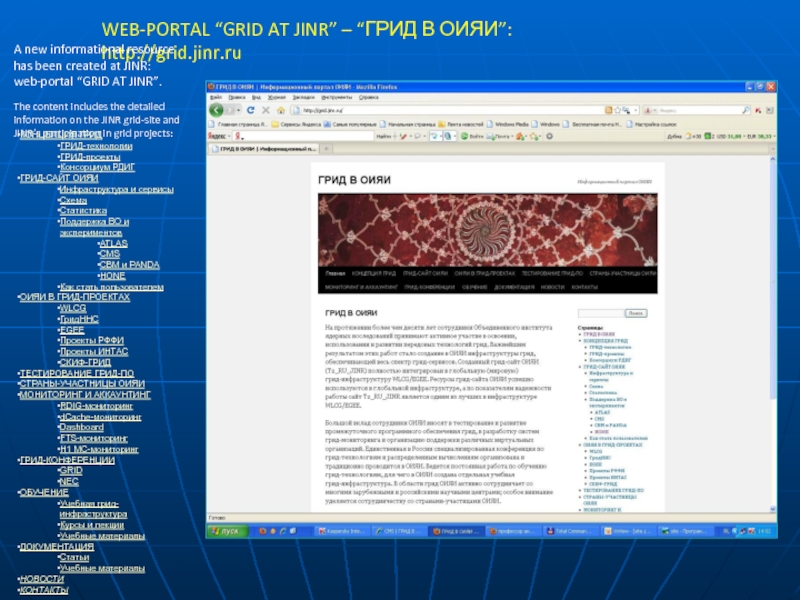

Слайд 55WEB-PORTAL “GRID AT JINR” – “ГРИД В ОИЯИ”: http://grid.jinr.ru

A

new informational resource

has been created at JINR:

web-portal “GRID AT JINR”.

The

content includes the detailed

information on the JINR grid-site and

JINR’s participation in grid projects:

КОНЦЕПЦИЯ ГРИД

ГРИД-технологии

ГРИД-проекты

Консорциум РДИГ

ГРИД-САЙТ ОИЯИ

Инфраструктура и сервисы

Схема

Статистика

Поддержка ВО и экспериментов

ATLAS

CMS

CBM и PANDA

HONE

Как стать пользователем

ОИЯИ В ГРИД-ПРОЕКТАХ

WLCG

ГридННС

EGEE

Проекты РФФИ

Проекты ИНТАС

СКИФ-ГРИД

ТЕСТИРОВАНИЕ ГРИД-ПО

СТРАНЫ-УЧАСТНИЦЫ ОИЯИ

МОНИТОРИНГ И АККАУНТИНГ

RDIG-мониторинг

dCache-мониторинг

Dashboard

FTS-мониторинг

Н1 МС-мониторинг

ГРИД-КОНФЕРЕНЦИИ

GRID

NEC

ОБУЧЕНИЕ

Учебная грид-инфраструктура

Курсы и лекции

Учебные материалы

ДОКУМЕНТАЦИЯ

Статьи

Учебные материалы

НОВОСТИ

КОНТАКТЫ