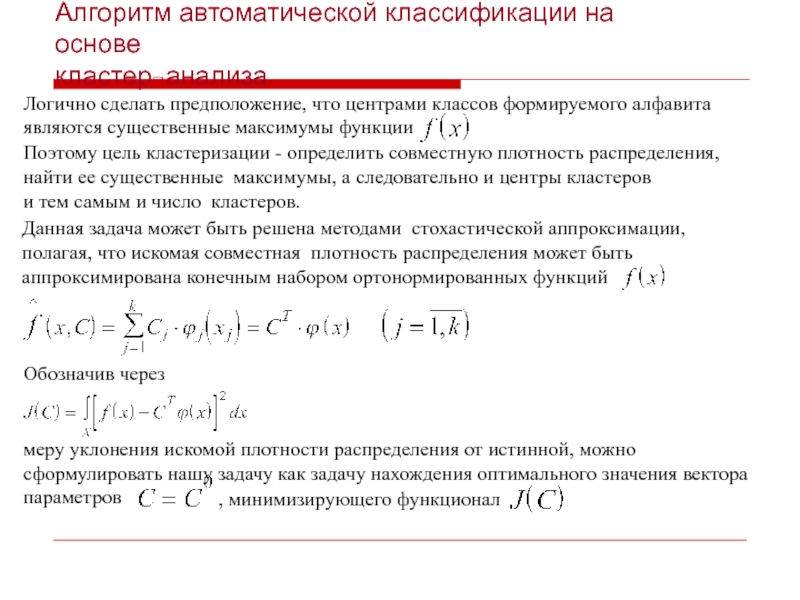

основываются на вероятностной

оценки наших данных , при этом мы

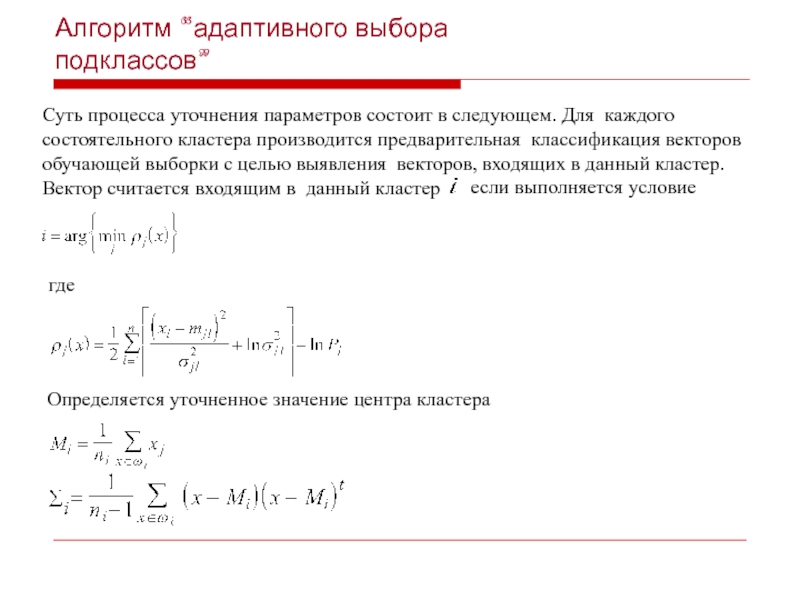

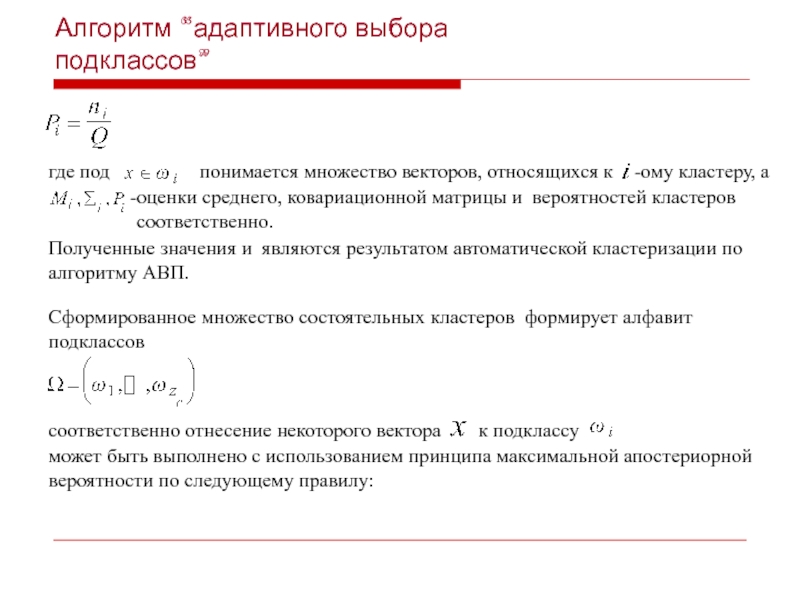

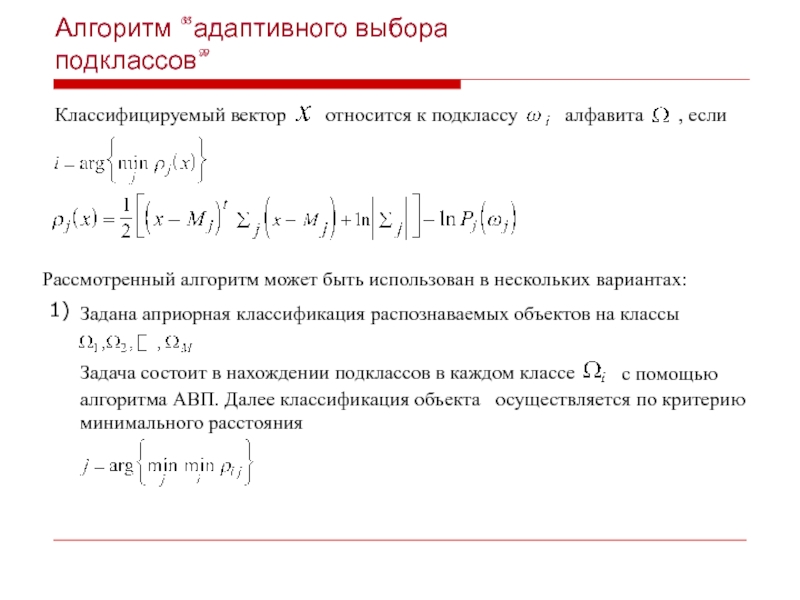

предполагаем, что наши данные могут относится к одному из возможных распределений (количеству групп).

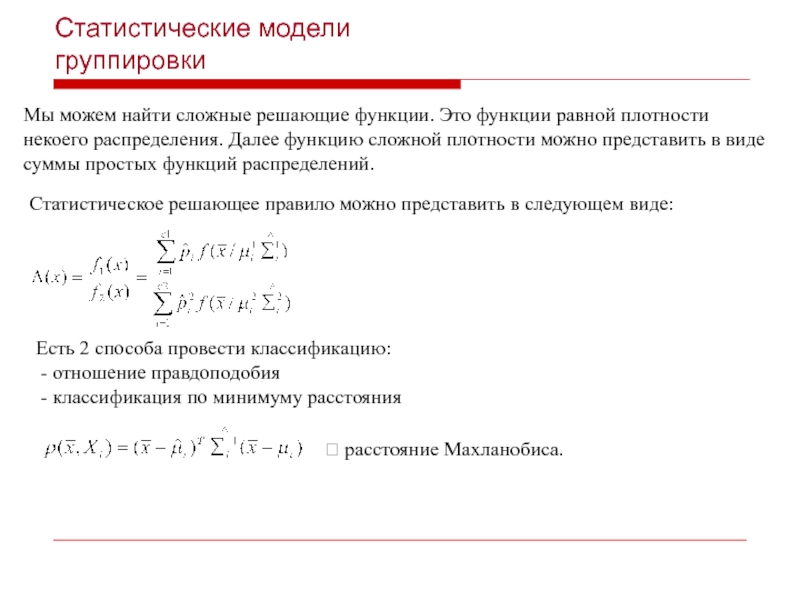

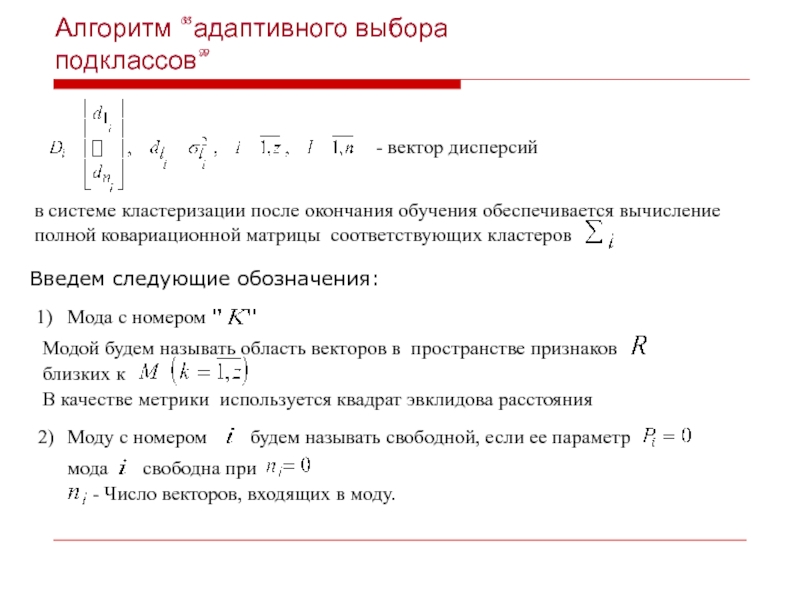

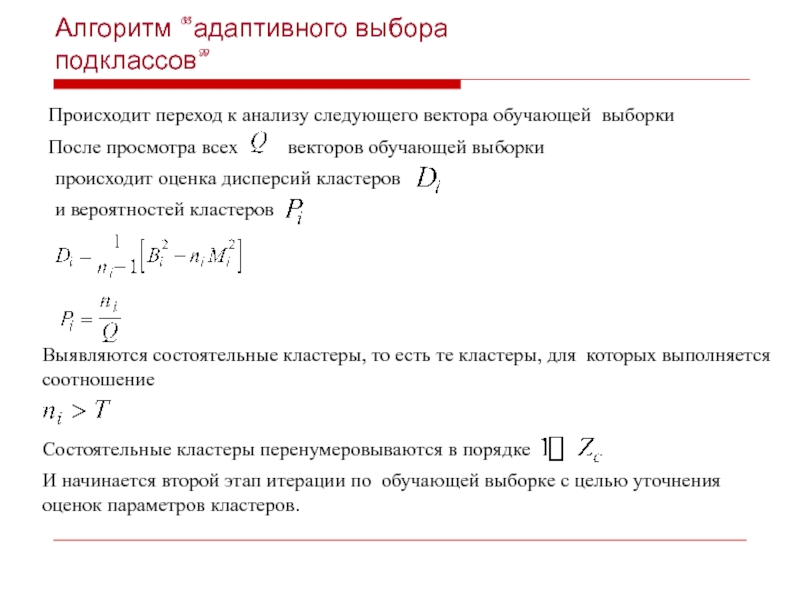

Для каждой группы задается априорная вероятность Р1,Р2 ,…Рс

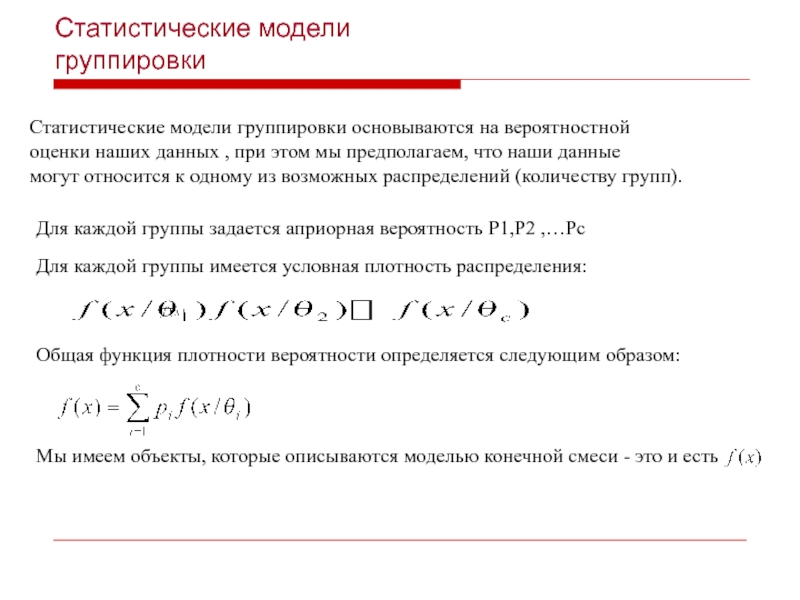

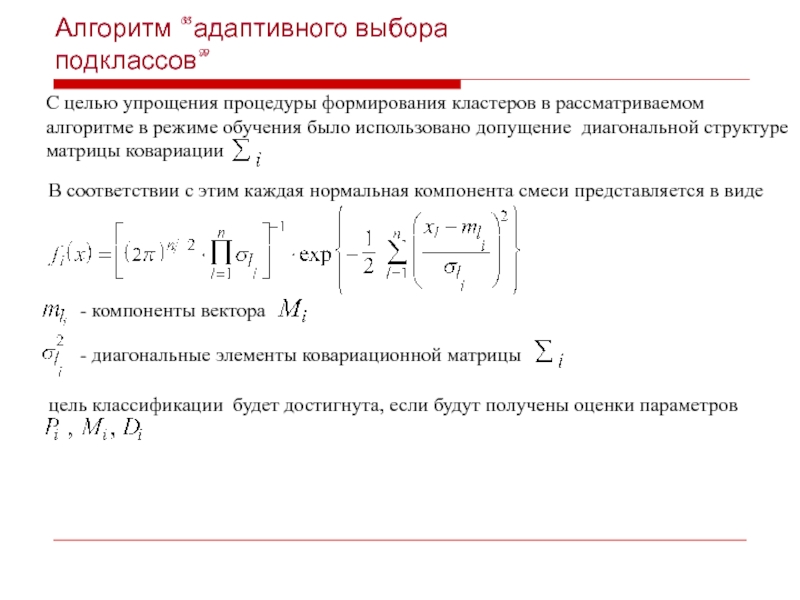

Для каждой группы имеется условная плотность распределения:

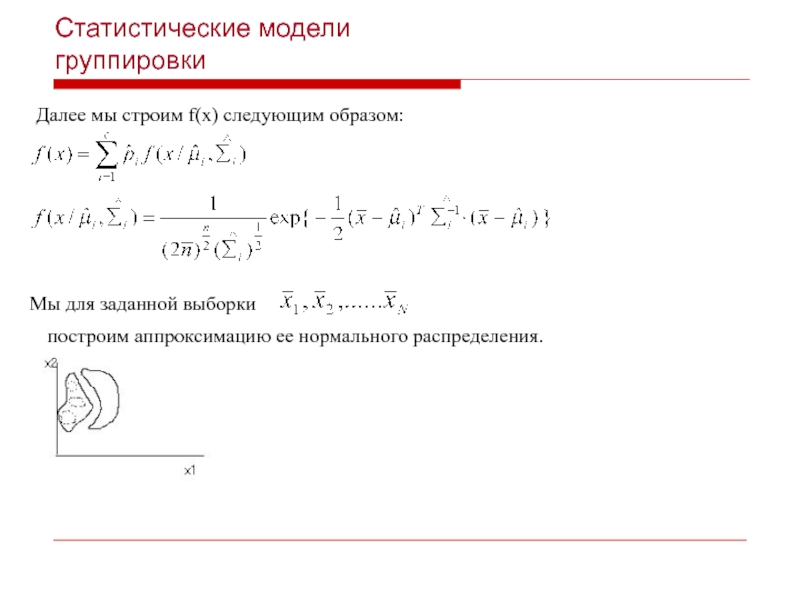

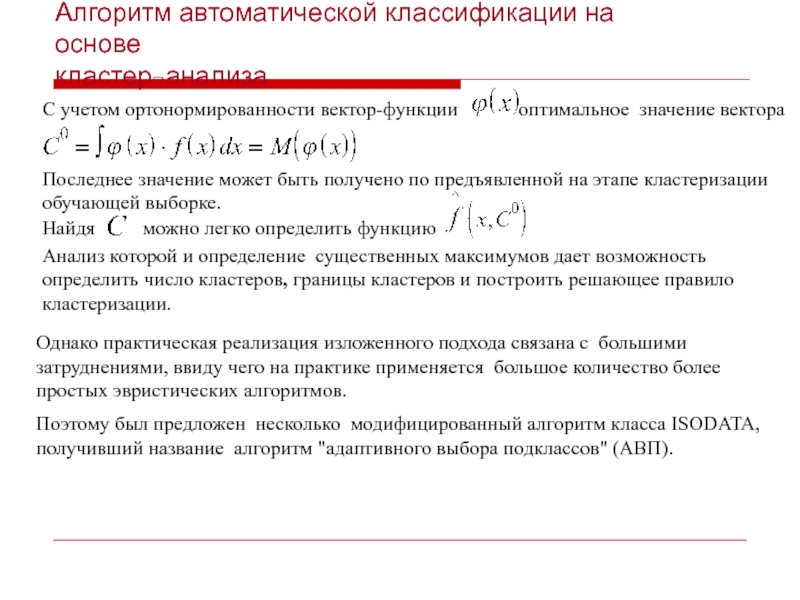

Общая функция плотности вероятности определяется следующим образом:

Мы имеем объекты, которые описываются моделью конечной смеси - это и есть