Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Deep Learning Club

Содержание

- 1. Deep Learning Club

- 2. Искусственный интеллект

- 3. Решение уравненийРаспознавание образовПример задач

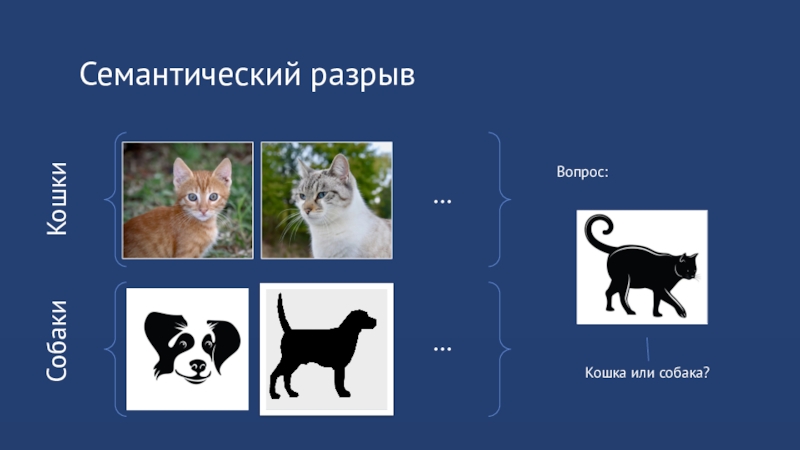

- 4. Эксперименты на животныхЗадача: по фотографии определять кошка или собака

- 5. Пример формальной постановкиКошкиСобакиКошка или собака?Вопрос:……

- 6. Семантический разрывКошкиСобакиКошка или собака?Вопрос:……

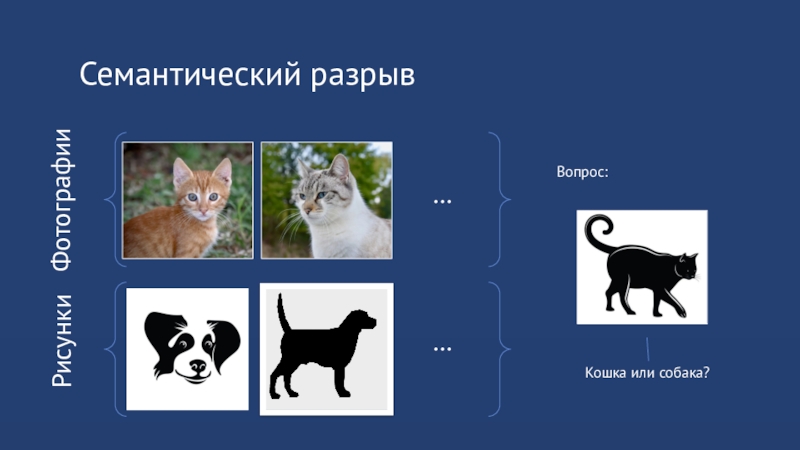

- 7. Семантический разрывКошкиСобакиКошка или собака?Вопрос:……

- 8. Семантический разрывФотографииРисункиКошка или собака?Вопрос:……

- 9. Решение задачс семантическим разрывомв формальной постановке–основной предмет науки«Машинное обучение»

- 10. Машинное обучениеПостроение моделей по данным=То есть алгоритм

- 11. Модели можно использовать дляПрогнозированияАнализа зависимостей в данныхПостроения других моделей

- 12. Обучающие данныеML-АлгоритмВходные данныеПредсказания1122ОбучениеВывод (inference)

- 13. Историческая справка

- 14. История~1800: Интерполяционный полином Лагранжа~1912: Метод максимального правдоподобия1963: SVM1992: Kernel SVM1993: Gradient Boosting

- 15. Нейронные сети1957: Перцептрон Розенблатта1986: Метод обратного распространения

- 16. Компьютерное зрение1970s: Stages of Visual Representation1997: Normalized

- 17. Соревнования по CVPASCAL Visual Object Challenge (2006

- 18. ML работает хорошо,когда естьбольшое количество качественно размеченныхданных

- 19. Основные виды обучения

- 20. Обучение с учителем

- 21. Обучение без учителяПрецеденты – сами объектыДанные не размеченыВсё равно можно извлечь пользуВыявить закономерностиРешать традиционные задачи, используя эвристики

- 22. Обучение с частичным привлечением учителяС учителем +

- 23. Обучение с подкреплениемПрецеденты вида «состояние – действие – награда»Агент взаимодействует со средойНаблюдает состояниеСовершает действиеПолучает награду

- 24. Задачи машинного обучения

- 25. КлассификацияДан набор значений признаков объектаТребуется определить к какому классу относится объектМножество классов – дискретное

- 26. Классификация. Пример

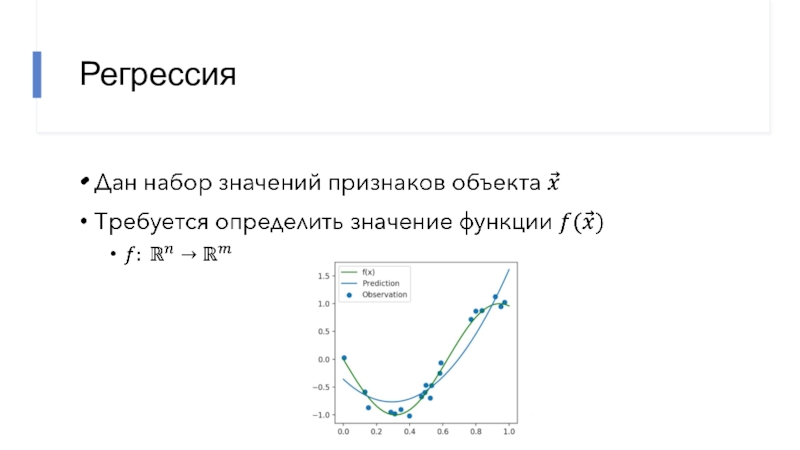

- 27. Регрессия

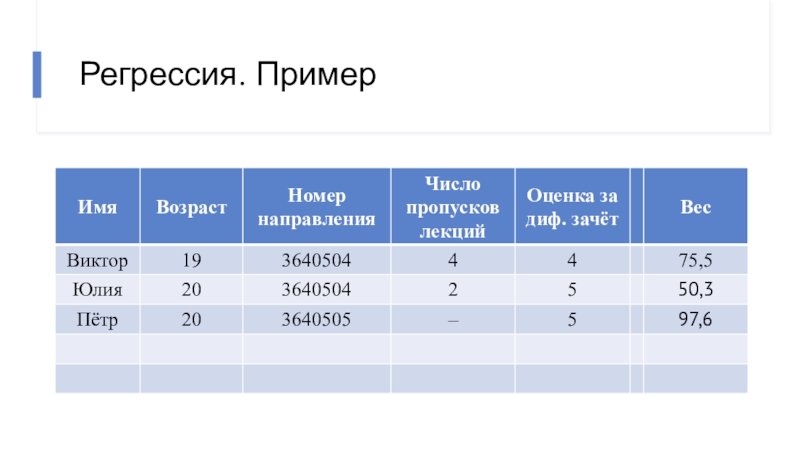

- 28. Регрессия. Пример

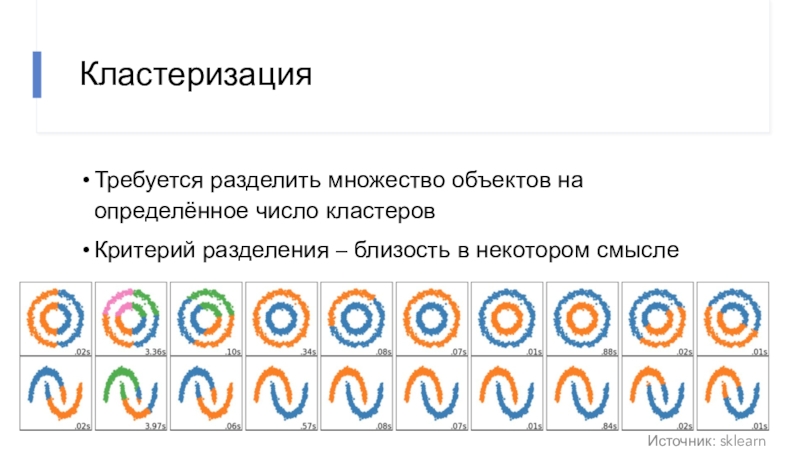

- 29. КластеризацияТребуется разделить множество объектов на определённое число кластеровКритерий разделения – близость в некотором смыслеИсточник: sklearn

- 30. На самом деле задач большеОбучение без учителяПоиск ассоциативных правил;Понижение размерности;Поиск выбросов.Обучение с учителемРанжирование;Анализ выживаемости / рисков.

- 31. На самом деле задач сильно большеMultiple-instance Learning

- 32. Регрессия с помощью классификатораМожно дискретизировать множество значений целевой переменнойКаждый класс соответствует корзинеВ чём проблема?0.01.00.5

- 33. Отношение порядка (>)Цена промаха в классификации одинаковаяВне

- 34. Отношение порядка для признаковАналогичная проблема с признакамиЕсли

- 35. Трудности с отношением порядкаСредний балл студентовЧисло научных публикацийРанжируем университеты

- 36. Обучение

- 37. Обучение

- 38. Примеры функций потерь

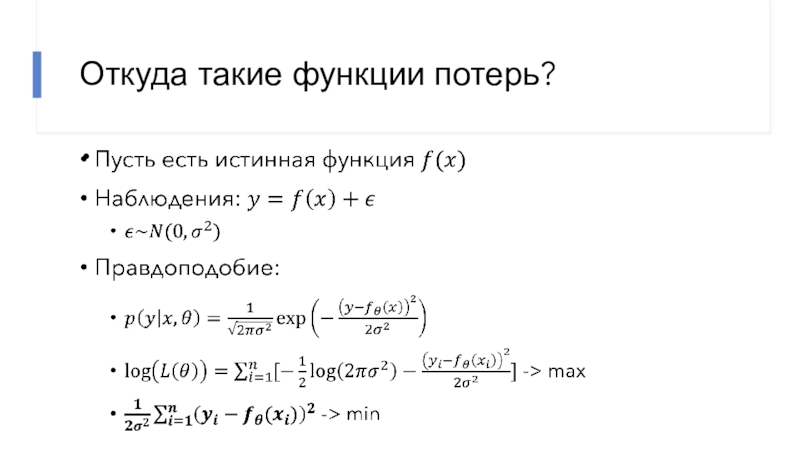

- 39. Откуда такие функции потерь?

- 40. Функция потерь подразумевает определённое распределение шума

- 41. Переобучение–отсутствие способности к обобщению

- 42. ПереобучениеАлгоритм обучения сошёлся на тренировочном множествеФункция потерь

- 43. Обнаружение переобученияВыделение валидационного множестваМножество, используемое только для оценки качестваКросс-валидацияПроверка воздействия малых отклонений (шума)

- 44. Переобучение (2)Вводим validation setПроверяем модель на нём

- 45. Переобучение (3)

- 46. Кросс-валидация (CV)Данные разбиваются на K блоковОбучение проводится

- 47. Переобучение (5)

- 48. Переобучение: причиныМного параметровПереусложнённая модельМало данных – могут не

- 49. Борьба с переобучениемУвеличение размера набора данных для

- 50. РегуляризацияОбратная задача – получить параметры модели по даннымНапример:

- 51. Простые модели

- 52. Интерполяционный полином

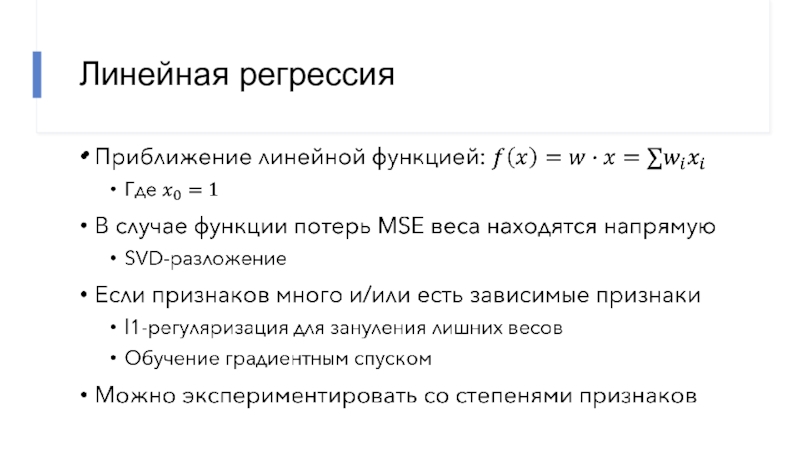

- 53. Линейная регрессия

- 54. Логистическая регрессия

- 55. SVMБинарный линейный классификаторГиперплоскость с максимальным отступомОбучается через решение задачи квадратичного программирования

- 56. SVM + Kernel TrickЕсли данные непротиворечивыМожно найти

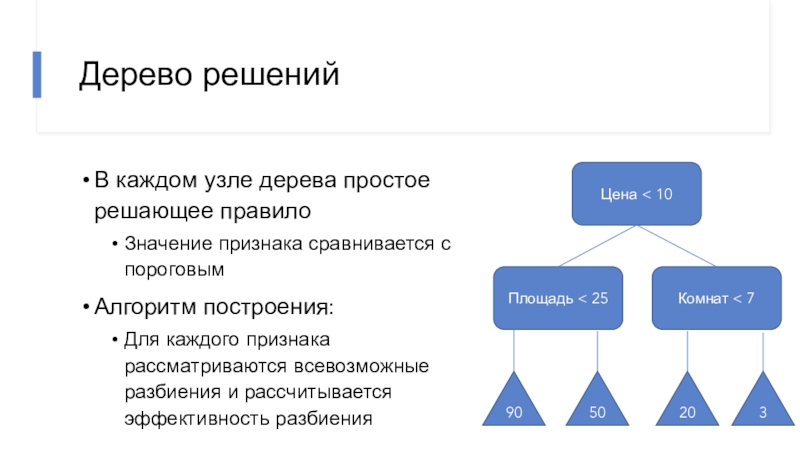

- 57. Дерево решенийВ каждом узле дерева простое решающее

- 58. Нейронные сети

- 59. Ключевые отличия от других алгоритмовГибкая дифференцируемая параметризация

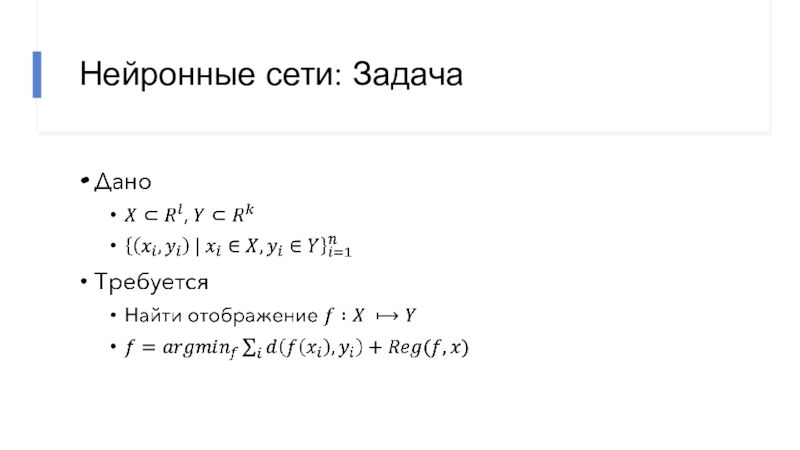

- 60. Нейронные сети: Задача

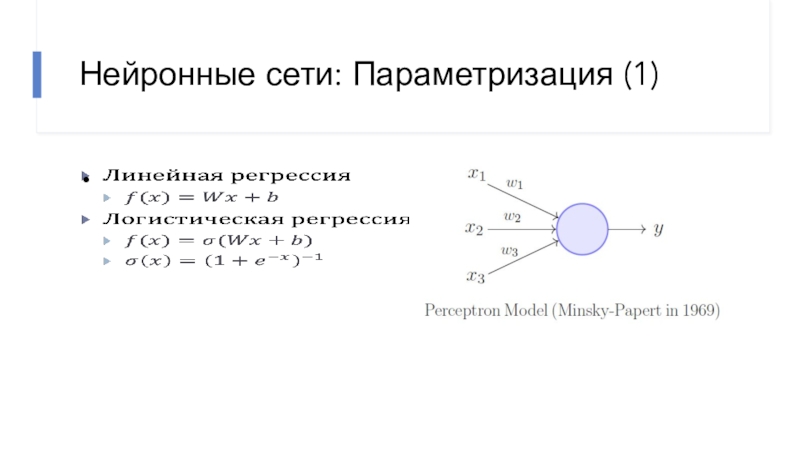

- 61. Нейронные сети: Параметризация (1)

- 62. Нейронные сети: Параметризация (2)

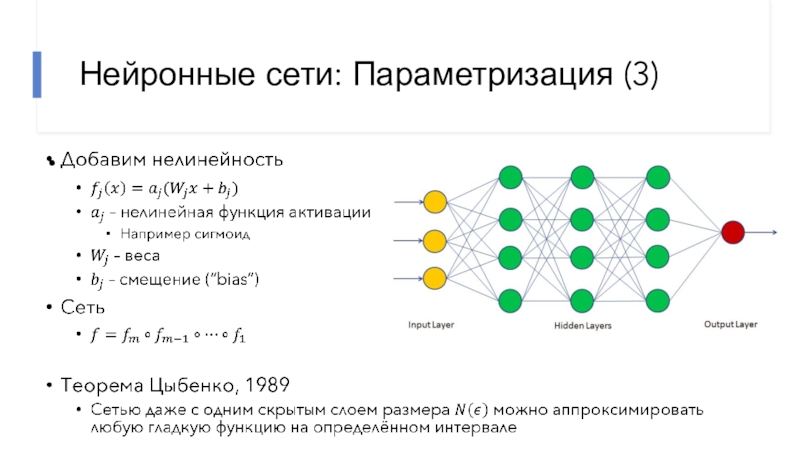

- 63. Нейронные сети: Параметризация (3)

- 64. В следующий разОбучение нейронных сетейСвёрточные нейронные сетиАугментация

- 65. ЛитератураDeepLearningBook.org (Ian Goodfellow et al.)Scikit-Learn User Guidecs231n

- 66. Скачать презентанцию

Искусственный интеллект

Слайды и текст этой презентации

Слайд 9Решение задач

с семантическим разрывом

в формальной постановке

–

основной предмет науки

«Машинное обучение»

Слайд 10Машинное обучение

Построение моделей по данным

=

То есть алгоритм способен научиться решать

задачу с использованием данных

Слайд 11Модели можно использовать для

Прогнозирования

Анализа зависимостей в данных

Построения других моделей

Слайд 14История

~1800: Интерполяционный полином Лагранжа

~1912: Метод максимального правдоподобия

1963: SVM

1992: Kernel SVM

1993:

Gradient Boosting

Слайд 15Нейронные сети

1957: Перцептрон Розенблатта

1986: Метод обратного распространения ошибки

1988: Свёрточная нейронная

сеть

1997: Долгая краткосрочная память (LSTM)

2012: AlexNet побеждает на ImageNet LSVRC

2014:

Генеративные состязательные сети 2015: U-Net

2017: Transformer

Слайд 16Компьютерное зрение

1970s: Stages of Visual Representation

1997: Normalized Cut, Shi &

Malik

1999: “SIFT” & Object Recognition, David Lowe

2001: Face Detection, Viola

& Jones2005: Histogram of Gradients, Dalal & Triggs

2009: Deformable Part Model, Felzenswalb, McAllester, Ramanan

Слайд 17Соревнования по CV

PASCAL Visual Object Challenge (2006 – 2012)

20 категорий

IMAGENET (2009)

22

тыс. категорий

15 млн. изображений

LJCV: 1000 классов; 1,5 млн. изображений; топ-5

Слайд 21Обучение без учителя

Прецеденты – сами объекты

Данные не размечены

Всё равно можно извлечь

пользу

Выявить закономерности

Решать традиционные задачи, используя эвристики

Слайд 22Обучение с частичным привлечением учителя

С учителем + без учителя

Часть данных

размечена

Наиболее часто встречается на практике

Разметка затратна

Но данных много, и их

не стоит игнорироватьСлайд 23Обучение с подкреплением

Прецеденты вида «состояние – действие – награда»

Агент взаимодействует со средой

Наблюдает

состояние

Совершает действие

Получает награду

Слайд 25Классификация

Дан набор значений признаков объекта

Требуется определить к какому классу относится

объект

Множество классов – дискретное

Слайд 29Кластеризация

Требуется разделить множество объектов на определённое число кластеров

Критерий разделения – близость

в некотором смысле

Источник: sklearn

Слайд 30На самом деле задач больше

Обучение без учителя

Поиск ассоциативных правил;

Понижение размерности;

Поиск

выбросов.

Обучение с учителем

Ранжирование;

Анализ выживаемости / рисков.

Слайд 31На самом деле задач сильно больше

Multiple-instance Learning - целевые значения

сопоставлены группам (bag) наблюдений;

One-shot Learning - классификация с одним обучающим

примером для каждого класса;Similarity Learning - поиск меры схожести объектов;

Collaborative Filtering - построение рекомендаций;

Natural Language Processing (Tagging, перевод, анализ тональности)

Style Transfer

Generative Modeling

Не стоит всегда сводить задачу к

классификации / регрессии

Слайд 32Регрессия с помощью классификатора

Можно дискретизировать множество значений целевой переменной

Каждый класс

соответствует корзине

В чём проблема?

0.0

1.0

0.5

Слайд 33Отношение порядка (>)

Цена промаха в классификации одинаковая

Вне зависимости от того,

какой класс с каким перепутан

В регрессии чем дальше предсказание от

истинного значения, тем хужеЗначит можем построить хорошую классификационную модель, но очень плохую с точки зрения регрессии

Слайд 34Отношение порядка для признаков

Аналогичная проблема с признаками

Если отсутствует отношение порядка,

нужна

специальная модель, игнорирующая (>),

либо предобработка признаков

Например: One-hot-encoding

Слайд 35Трудности с отношением порядка

Средний балл студентов

Число научных публикаций

Ранжируем университеты

Слайд 42Переобучение

Алгоритм обучения сошёлся на тренировочном множестве

Функция потерь достигла минимума

При этом

Упущены

реальные закономерности в данных

Найдены несуществующие закономерности в шуме

Слайд 43Обнаружение переобучения

Выделение валидационного множества

Множество, используемое только для оценки качества

Кросс-валидация

Проверка воздействия

малых отклонений (шума)

Слайд 46Кросс-валидация (CV)

Данные разбиваются на K блоков

Обучение проводится на (K –

1) блоке

Тестирование на 1 блоке

Ещё полезна для стохастического перебора гиперпараметров

Слайд 48Переобучение: причины

Много параметров

Переусложнённая модель

Мало данных – могут не покрывать test set

Возможно

train/test split неправильный

Кросс-валидация говорит, что модель не переобучена

Но на test

set не работаетИ модель, например, слишком простая (!)

Слайд 49Борьба с переобучением

Увеличение размера набора данных для обучения

В том числе

искусственное: аугментация

Улучшение качества данных

Например, удаление заведомо несущественных факторов

Построение ансамблей

Выбор стабильного

метода оценки параметровНапример, RANSAC

Регуляризация

Слайд 50Регуляризация

Обратная задача – получить параметры модели по данным

Например: восстановить форму объекта

по тени

Регуляризация – добавление искусственных ограничений

Исходя из представлений о решении, не

заложенных в данных (априорное распределение)Примеры: l1, l2-нормы весов

Слайд 55SVM

Бинарный линейный классификатор

Гиперплоскость с максимальным отступом

Обучается через решение задачи квадратичного

программирования

Слайд 56SVM + Kernel Trick

Если данные непротиворечивы

Можно найти отображение в высокоразмерное

пространство

В котором точки линейно разделимы

Трюк: подменяется скалярное произведение

Плата: долгое время

предсказанийСлайд 57Дерево решений

В каждом узле дерева простое решающее правило

Значение признака сравнивается

с пороговым

Алгоритм построения:

Для каждого признака рассматриваются всевозможные разбиения и рассчитывается

эффективность разбиенияЦена < 10

Площадь < 25

Комнат < 7

90

50

20

3

Слайд 59Ключевые отличия от других алгоритмов

Гибкая дифференцируемая параметризация произвольной функции

Возможность составлять

сети из готовых блоков

Блоки могут быть предобученными

Функции ошибки могут быть

параметризованными нейронными сетямиЭффективная реализация на GPU инференса и +- обучения