Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

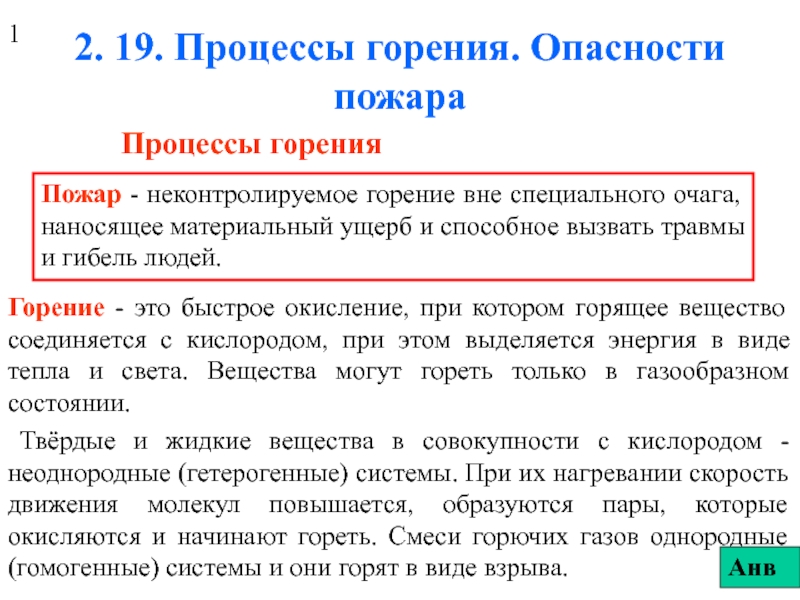

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Информатика I семестр: 20ч. лекций, 28 ч. практ. занятий II семестр: 16ч

Содержание

- 1. Информатика I семестр: 20ч. лекций, 28 ч. практ. занятий II семестр: 16ч

- 2. Информатика – наука об общих свойствах информации,

- 3. Информатика как наукаПредметом Информатики как науки являются

- 4. Происхождение термина информатикаВ СССР в 60-е годы

- 5. 1978г. Международный конгресс по информатикеПонятие Информатики -

- 6. Структура информатики как научной и прикладной дисциплины

- 7. Слайд 7

- 8. Естественные науки - имеют дело с объективными

- 9. Информация – сведения и данные, отражающие свойства

- 10. Информация – сведения об объектах и явлениях,

- 11. Цель информатики - поиск нового знания.Информатика -

- 12. Знание - форма существования и систематизации результатов

- 13. Физическая информация: третий компонент материального мира (наряду

- 14. Смысловая (семантическая) информация: информация, которую воспринимает человек

- 15. Техническая информация (она же кибернетическая или компьютерная)

- 16. Свойства смысловой информациизапоминаемость,

- 17. Хранение информацииПисьменность — графическое изображение символов на камне,

- 18. Хранение информации

- 19. Хранение информации

- 20. Обработка информацииИнформация, предназначенная для обработки, называется данными.

- 21. Передача информацииПередачей информации называется процесс её пространственного

- 22. Передача информации

- 23. Лекция 3. Количество информации

- 24. Меры информации

- 25. Меры информации семантического уровняТезаурус — совокупность сведений,

- 26. Меры информации семантического уровняКоэффициент содержательности C - относительная

- 27. Компоненты обмена информациейСигнал - это физический процесс, несущий информа-цию о событии или состоянии объекта наблюдения

- 28. Спектр электромагнитных волн

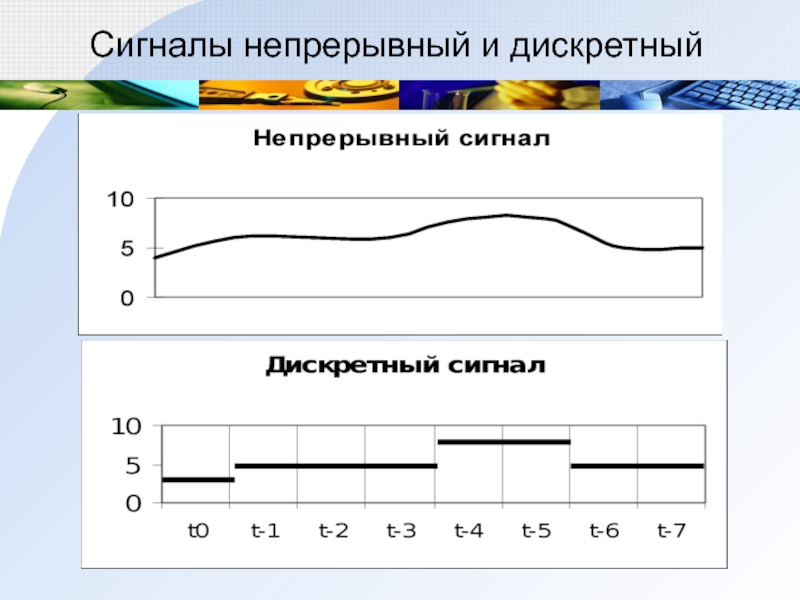

- 29. Сигналы непрерывный и дискретный

- 30. Количество информации, воспринятой приемником, характеризуется не длиной

- 31. Минимальное разнообразие обеспечивается наличием двух состояний. Информационная

- 32. Клод Шеннон: «Информация - снятая неопределенность».Неопределенность возникает

- 33. Минимальное разнообразие обеспечивается наличием двух состояний.Информационная ёмкость

- 34. 1928 г. Р. Хартли: процесс получения информации -

- 35. Равновероятны ли сообщения "первой выйдет из дверей здания

- 36. 1948 г. Клод Шеннон. Формула определения количества информации,

- 37. Энтропия (H) – мера неопределенности, или мера

- 38. Связь между энтропией и количеством информацииI –

- 39. Количество информации в сообщенииВ общем случае, энтропия

- 40. Пример. Пусть в некотором учреждении состав работников

- 41. Количество информации в сообщенииФормула Хартли – частный

- 42. Количество информации в сообщенииНеопределенность может быть снята

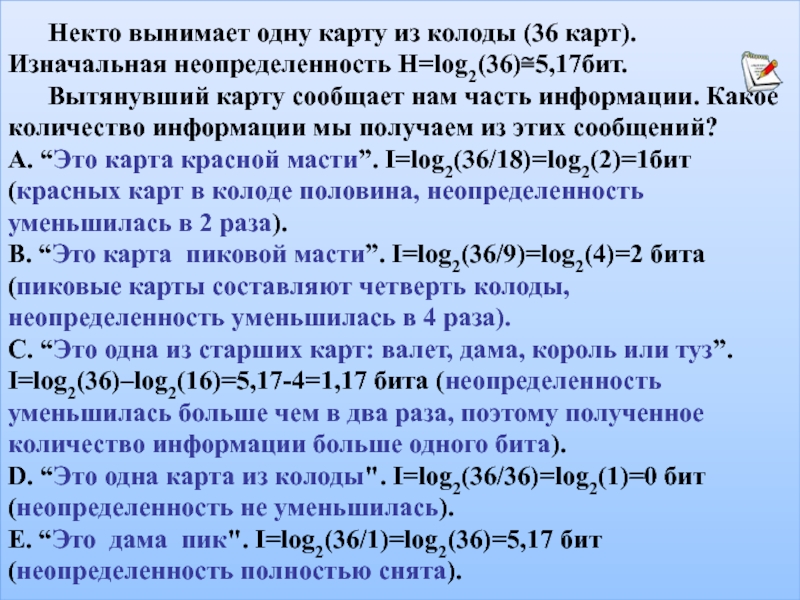

- 43. Некто вынимает одну карту из колоды (36

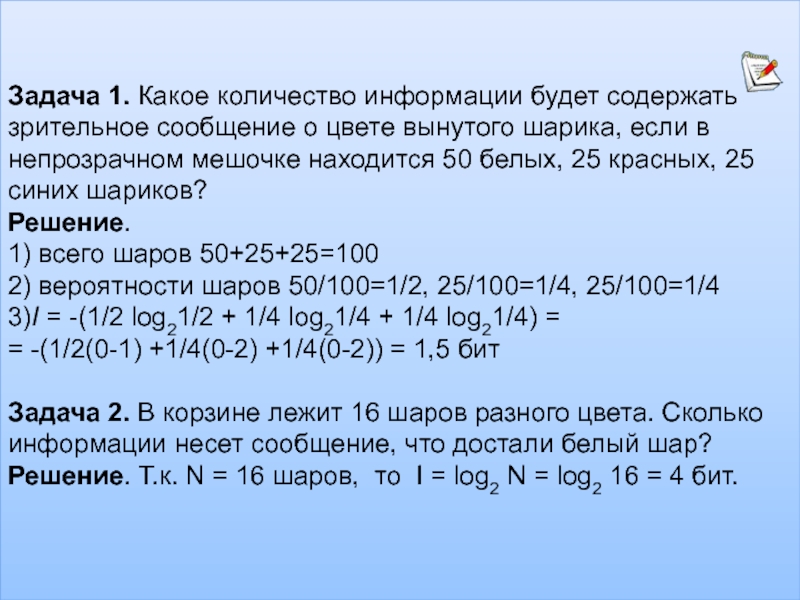

- 44. Задача 1. Какое количество информации будет содержать

- 45. Задача 3. В корзине лежат черные и

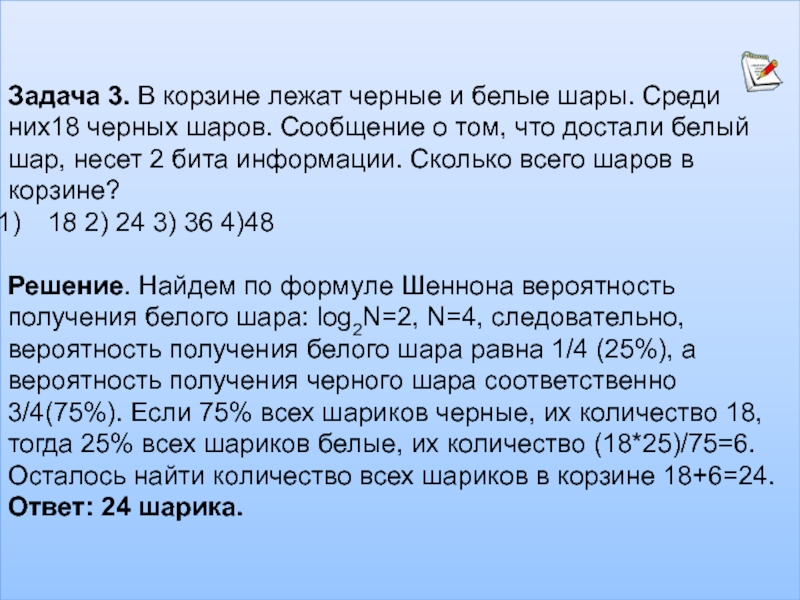

- 46. Задача 3. В корзине лежат черные и

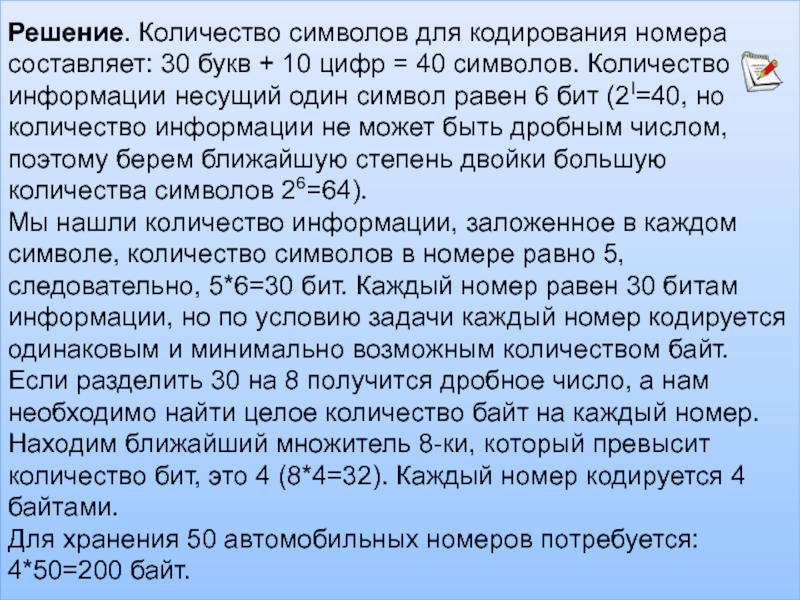

- 47. Решение. Количество символов для кодирования номера составляет:

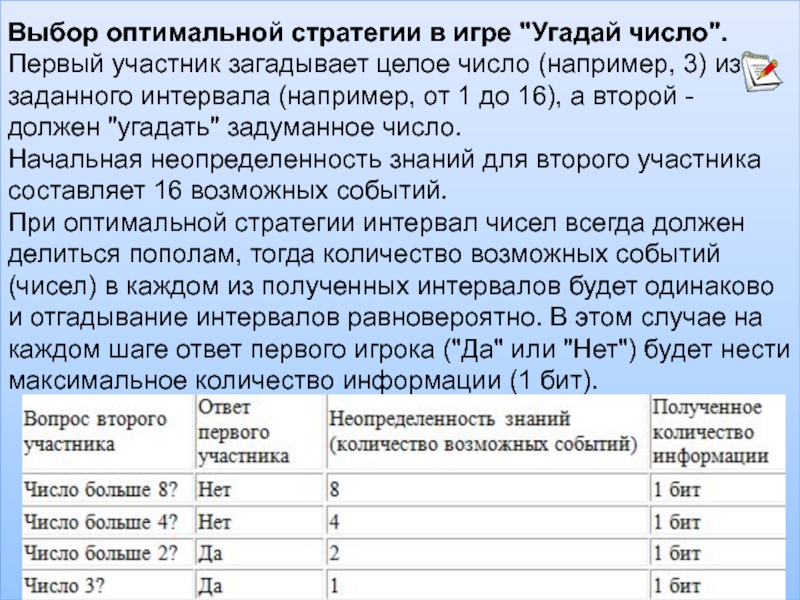

- 48. Выбор оптимальной стратегии в игре "Угадай число". Первый

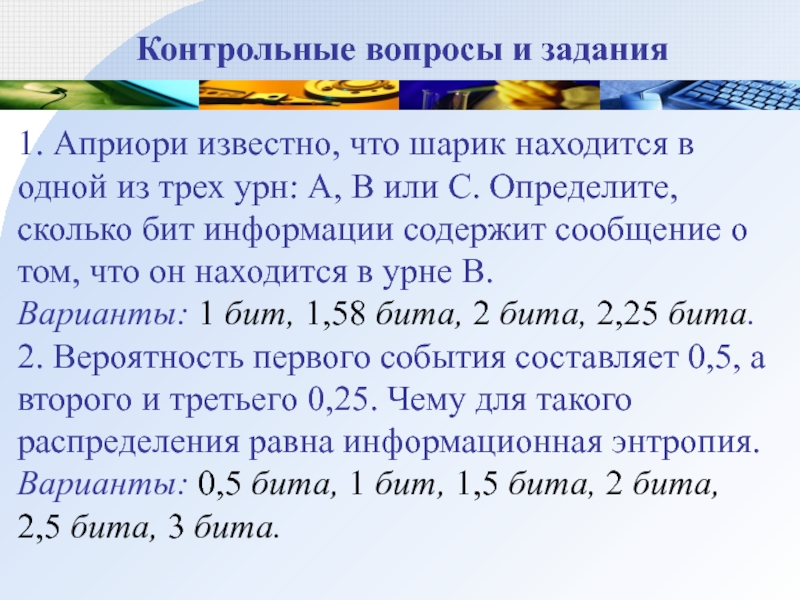

- 49. Контрольные вопросы и задания1. Априори известно, что

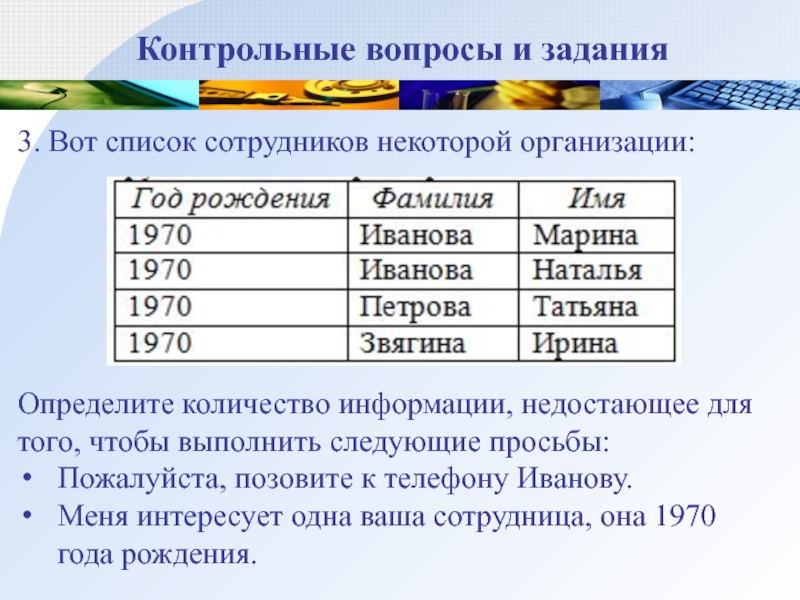

- 50. Контрольные вопросы и задания3. Вот список сотрудников

- 51. Слайд 51

- 52. Скачать презентанцию

Слайды и текст этой презентации

Слайд 2Информатика – наука об общих свойствах информации, закономерностях и методах

её поиска и получения, хранения, передачи, переработке и распространения, а

также науку о способах её использования для решения различных прикладных задач.Наше понятие информатики

Слайд 3Информатика как наука

Предметом Информатики как науки являются общие закономерности управления

данными, принципы организации и поиска данных и т.д..

Объектом приложений Информатики

стали различные сферы деятельности.Наиболее впечатляют реализации Информационных Технологий.

Слайд 4Происхождение термина информатика

В СССР в 60-е годы – кибернетика.

Кибернетика -

наука об общих закономерностях в управлении и связи в различных

системах: искусственных, биологических, социальных.1948 г. Н. Винер: "Кибернетика или управление и связь в животном и машине".

В США и англоязычных странах: computer since – компьютерная наука.

Термин информатика предложен Карлом Штейнбухом в 1957.

Фр. Ф. Дрейфус : Informatique: информатика = информация + автоматика.

Слайд 51978г. Международный конгресс по информатике

Понятие Информатики - охватывает области, связанные

с разработкой, созданием, использованием, и материально-техническим обслуживанием систем обработки информации,

включая машины, оборудование, математическое обеспечение, организационные аспекты, а также комплекс промышленного, коммерческого, административного и социального воздействия.Слайд 8Естественные науки - имеют дело с объективными сущностями мира, существующими

независимо от нашего сознания.

Гуманитарные науки - связаны с вкладом

в развитие социальной сферы.Технические науки - позволяют создать машинные системы.

Общественные науки – социальные

Математические науки – изучают величины, их количественные отношения, а также пространственные формы.

Технические науки - позволяют создать машинные системы

Слайд 9Информация – сведения и данные,

отражающие свойства объектов в природных,

социальных и технических системах и передаваемые звуковым, графическим (в т.ч.

письменным) или иным способом без применения или сприменением технических средств.

Интуитивное понятие информации

Слайд 10Информация – сведения об объектах и явлениях, их параметрах, свойствах

и состоянии, которые уменьшают степень неопределенности о них или неполноты

знаний. Интуитивное понятие информации

Слайд 11Цель информатики - поиск нового знания.

Информатика - технология обработки накопленного

знания и построения нового знания. Информатика изучает методы анализа знания

о методах построения нового знания как своего собственного, так и знания других наук. Интуитивное понятие информации

Слайд 12Знание - форма существования и систематизации результатов познавательной деятельности человека.

Виды знания:

научное, обыденное (здравый смысл), интуитивное, религиозное и др.

научное и вненаучное (пара-, анти-, псевдо-,

личностные,

«народные знания»

Слайд 13Физическая информация: третий компонент материального мира (наряду с веществом и

энергией), управляющий порядком и хаосом в микромире, в космосе, в

термодинамике, статистической физике, биосистемах и т. п. Не было человека на Земле, информация была, не будет его – информация будет. Физическая информация имеет два подвида: термодинамическую и статистическую. Именно на примере физической информации мы попытаемся установить связь между информацией и энтропией (информация, как отрицательная энтропия).Информация

Слайд 14Смысловая (семантическая) информация: информация, которую воспринимает человек (и которая, к

примеру, передаётся средствами массовой информации). Это то, что можно осмыслить,

оценить, купить-продать-подарить, накапливать, хранить, охранять, терять; она способна исчезать и появляться, может быть полезной и вредной, истинной и ложной, переходя в дезинформацию.Информация

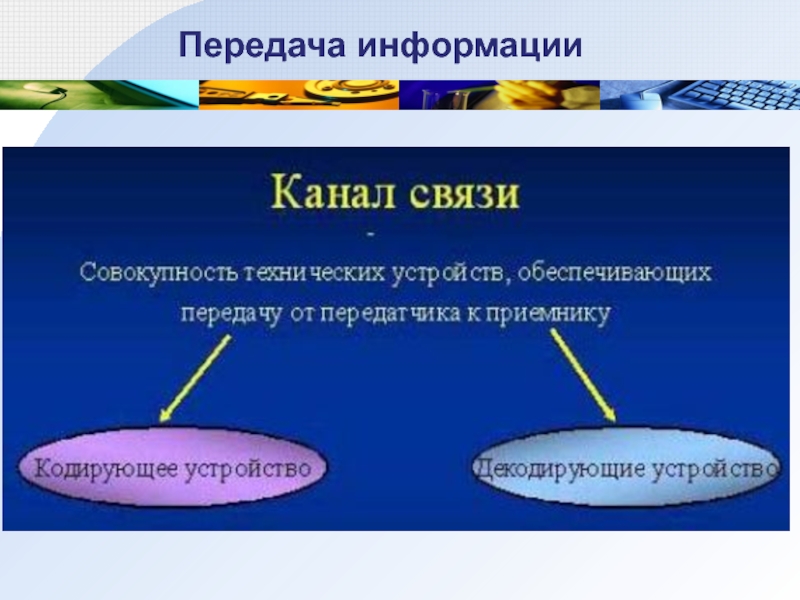

Слайд 15Техническая информация (она же кибернетическая или компьютерная) – информация, передаваемая

азбукой Морзе, по радио- или телеканалу, информация в компьютерах и

прочих технических машинах. К ней относятся вопросы передачи информации по линии связи, вопросы кодирования-декодирования информации, и способы переработки информации компьютерамиИнформация

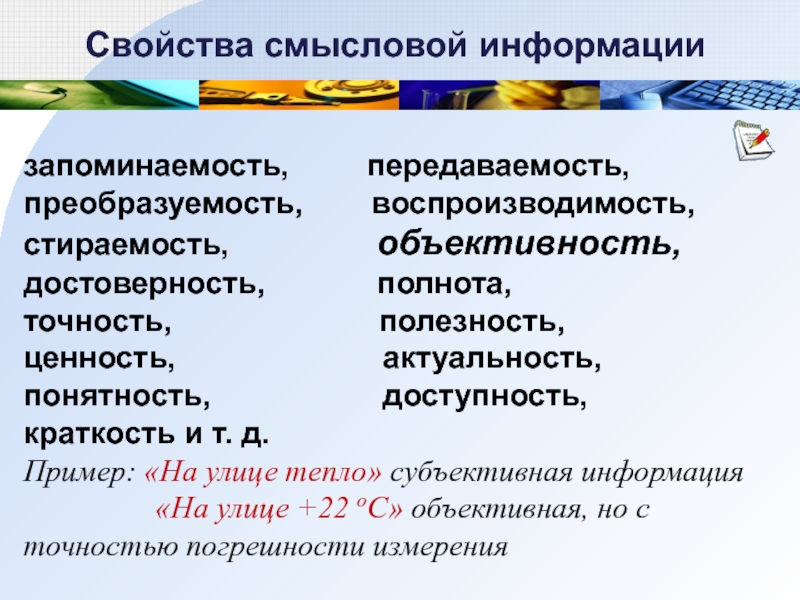

Слайд 16 Свойства смысловой информации

запоминаемость, передаваемость,

преобразуемость, воспроизводимость,

стираемость,

объективность, достоверность, полнота,

точность, полезность,

ценность, актуальность,

понятность, доступность,

краткость и т. д.

Пример: «На улице тепло» субъективная информация

«На улице +22 оС» объективная, но с точностью погрешности измерения

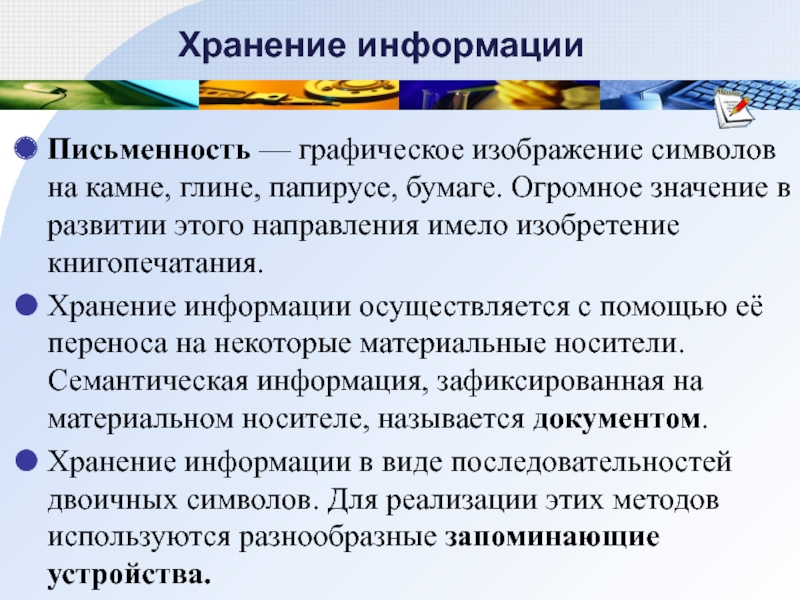

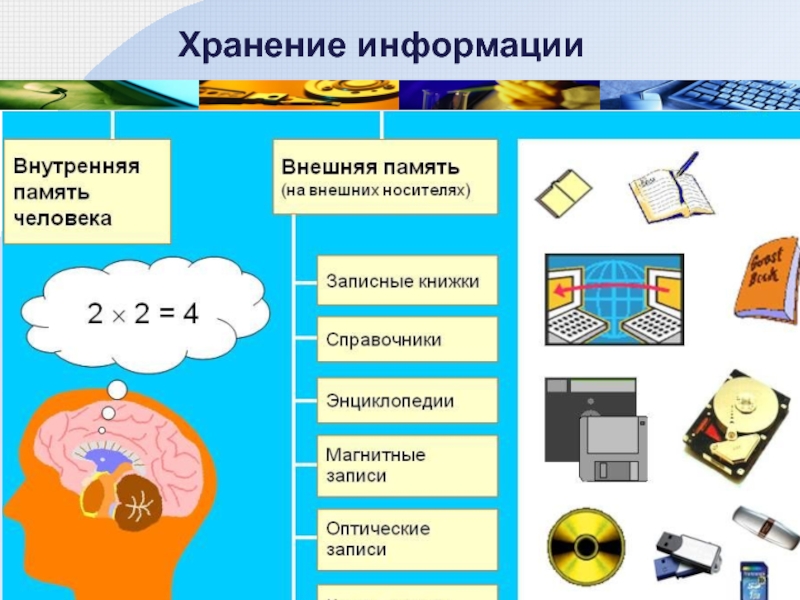

Слайд 17Хранение информации

Письменность — графическое изображение символов на камне, глине, папирусе, бумаге.

Огромное значение в развитии этого направления имело изобретение книгопечатания.

Хранение

информации осуществляется с помощью её переноса на некоторые материальные носители. Семантическая информация, зафиксированная на материальном носителе, называется документом.Хранение информации в виде последовательностей двоичных символов. Для реализации этих методов используются разнообразные запоминающие устройства.

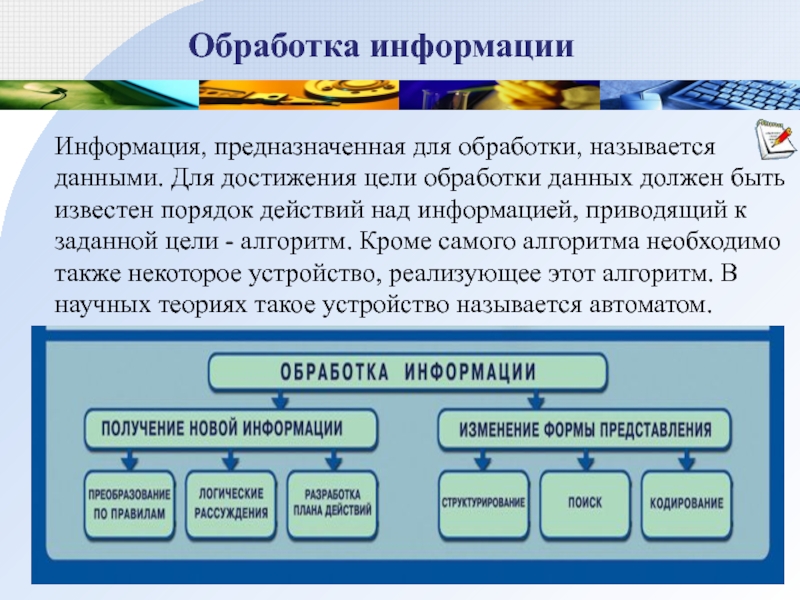

Слайд 20Обработка информации

Информация, предназначенная для обработки, называется данными. Для достижения цели

обработки данных должен быть известен порядок действий над информацией, приводящий

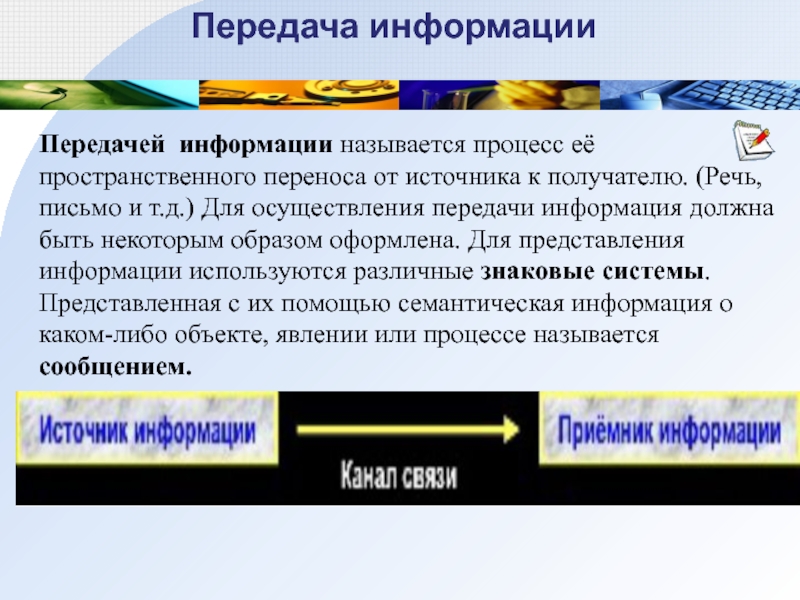

к заданной цели - алгоритм. Кроме самого алгоритма необходимо также некоторое устройство, реализующее этот алгоритм. В научных теориях такое устройство называется автоматом.Слайд 21Передача информации

Передачей информации называется процесс её пространственного переноса от источника

к получателю. (Речь, письмо и т.д.) Для осуществления передачи информация

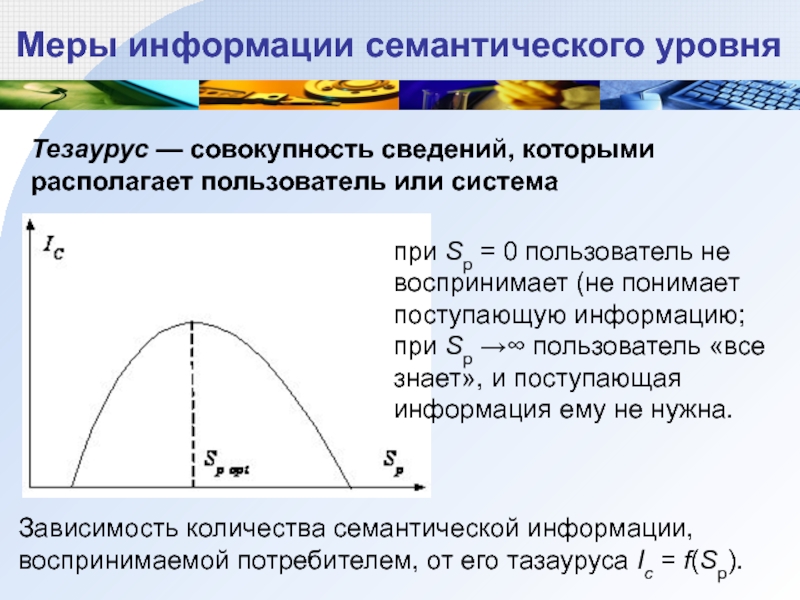

должна быть некоторым образом оформлена. Для представления информации используются различные знаковые системы. Представленная с их помощью семантическая информация о каком-либо объекте, явлении или процессе называется сообщением.Слайд 25Меры информации семантического уровня

Тезаурус — совокупность сведений, которыми располагает пользователь

или система

Зависимость количества семантической информации, воспринимаемой потребителем, от его тазауруса Ic = f(Sp).

при Sp = 0

пользователь не воспринимает (не понимает поступающую информацию;при Sp →∞ пользователь «все знает», и поступающая информация ему не нужна.

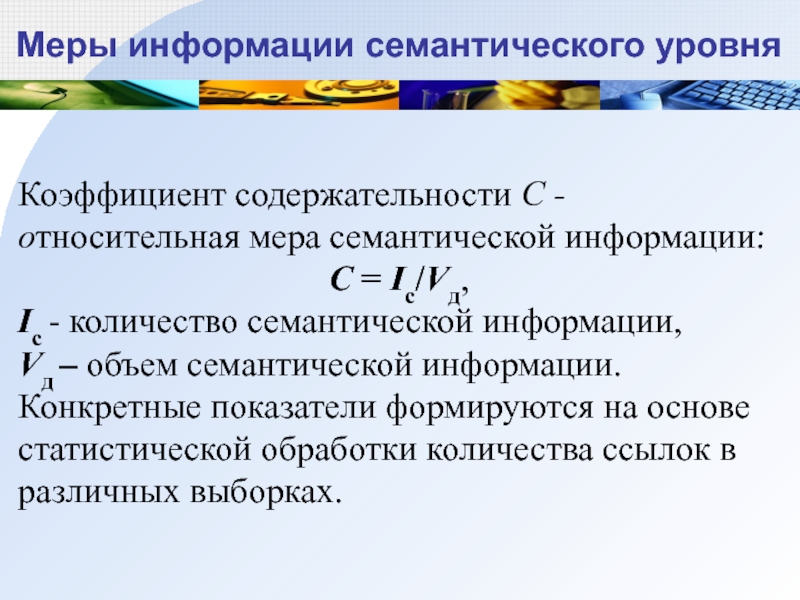

Слайд 26Меры информации семантического уровня

Коэффициент содержательности C - относительная мера семантической информации:

C = Ic/Vд,

Ic - количество семантической информации,

Vд – объем семантической

информации.Конкретные показатели формируются на основе статистической обработки количества ссылок в различных выборках.

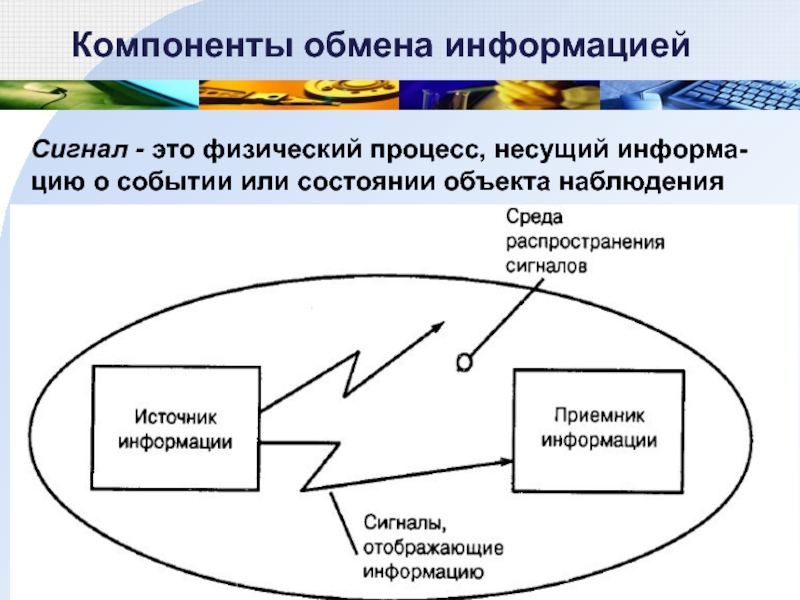

Слайд 27Компоненты обмена информацией

Сигнал - это физический процесс, несущий информа-цию о

событии или состоянии объекта наблюдения

Слайд 30Количество информации, воспринятой приемником, характеризуется не длиной сообщения, а разнообразием

сигнала порожденного в приемнике этим сообщением.

Память носителя информации имеет некоторую

физическую ёмкость, в которой она способна накапливать образы, и количество накопленной в памяти информации, характеризуется в итоге именно разнообразием заполнения этой ёмкости.Слайд 31Минимальное разнообразие обеспечивается наличием двух состояний. Информационная ёмкость одной ячейки

памяти, способной находиться в двух различных состояниях, принята за единицу

измерения количества информации - 1 бит.Количество получаемой информации может быть и меньше, чем 1 бит. Это происходит тогда, когда варианты ответов «да» и «нет» не равновероятны.

Количество информации

Слайд 32Клод Шеннон: «Информация - снятая неопределенность».

Неопределенность возникает в ситуации выбора.

Задача снятия неопределенности – уменьшение количества рассматриваемых вариантов (уменьшение разнообразия),

выбор одного соответствующего ситуации варианта из числа возможных. Снятие неопределенности дает возможность принимать обоснованные решения и действовать. В этом управляющая роль информации.Слайд 33Минимальное разнообразие обеспечивается наличием двух состояний.

Информационная ёмкость одной ячейки памяти,

способной находиться в двух различных состояниях, принята за единицу измерения

количества информации - 1 бит.1 бит (bit - сокращение от англ. binary digit - двоичное число) - единица измерения информационной емкости и количества информации, а также и еще одной величины – информационной энтропии.

** Это справедливо только для равновероятно-го случая

Слайд 341928 г. Р. Хартли: процесс получения информации - выбор одного сообщения

из конечного наперёд заданного множества из N равновероятных сообщений.

Формула Хартли:

I = log2N. Примеры равновероятных сообщений:

при бросании монеты: "выпала решка", "выпал орел";

на странице книги: "количество букв чётное", "количество букв нечётное".

угадать одно число из набора чисел от единицы до ста: I = log2100 6,644.

Слайд 35Равновероятны ли сообщения "первой выйдет из дверей здания женщина" и "первым выйдет из

дверей здания мужчина".

Однозначно ответить на этот вопрос нельзя. Все зависит

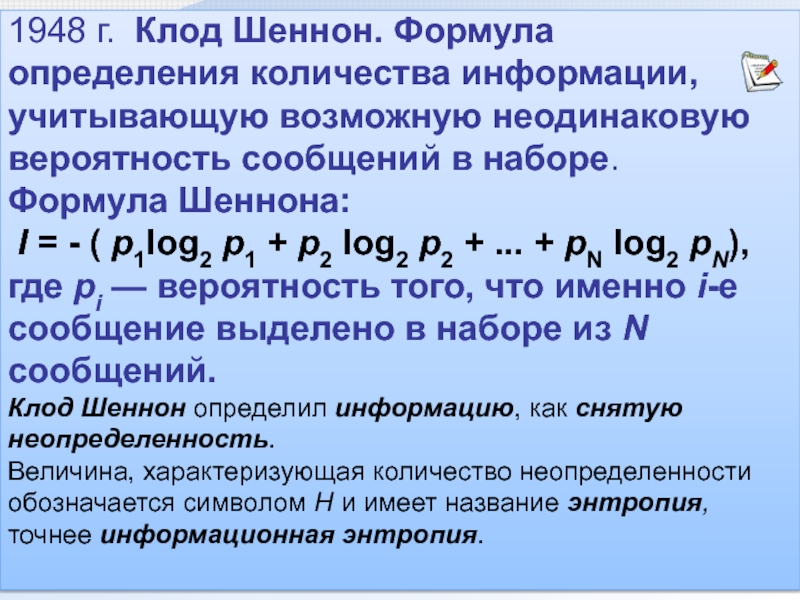

от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины. Слайд 361948 г. Клод Шеннон. Формула определения количества информации, учитывающую возможную неодинаковую

вероятность сообщений в наборе.

Формула Шеннона:

I = - ( p1log2 p1 + p2 log2 p2 +

... + pN log2 pN),где pi — вероятность того, что именно i-е сообщение выделено в наборе из N сообщений.

Клод Шеннон определил информацию, как снятую неопределенность.

Величина, характеризующая количество неопределенности обозначается символом H и имеет название энтропия, точнее информационная энтропия.

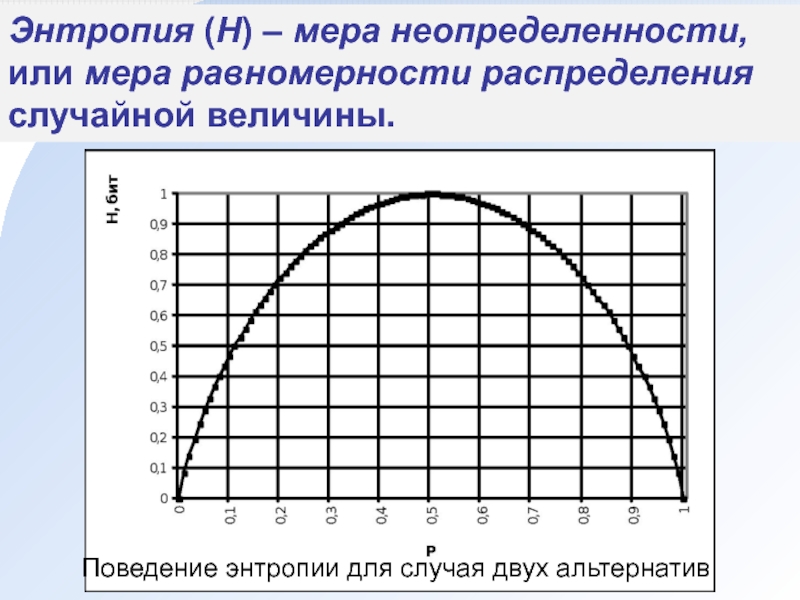

Слайд 37Энтропия (H) – мера неопределенности, или мера равномерности распределения случайной

величины.

Поведение энтропии для случая двух альтернатив

Слайд 38Связь между энтропией и количеством информации

I – это количество информации,

которое требуется для снятия неопределенности H.

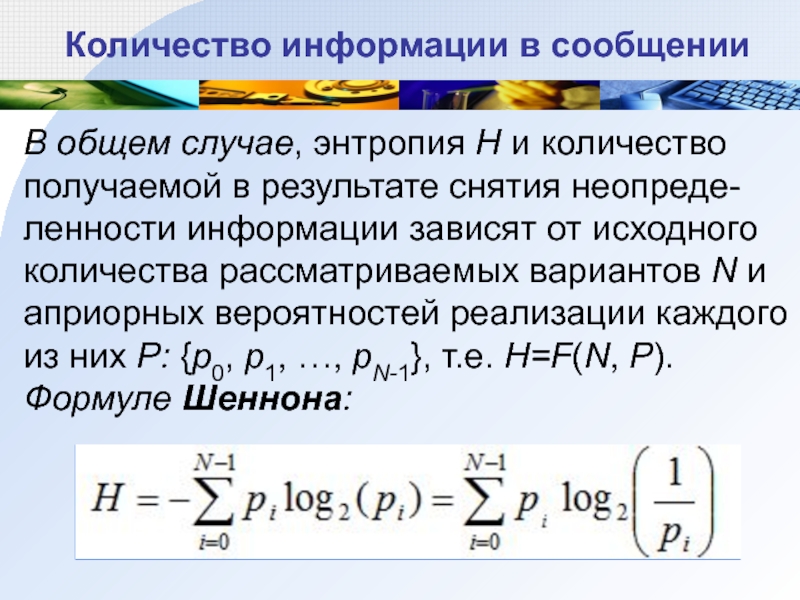

Слайд 39Количество информации в сообщении

В общем случае, энтропия H и количество

получаемой в результате снятия неопреде-ленности информации зависят от исходного количества

рассматриваемых вариантов N и априорных вероятностей реализации каждого из них P: {p0, p1, …, pN-1}, т.е. H=F(N, P).Формуле Шеннона:

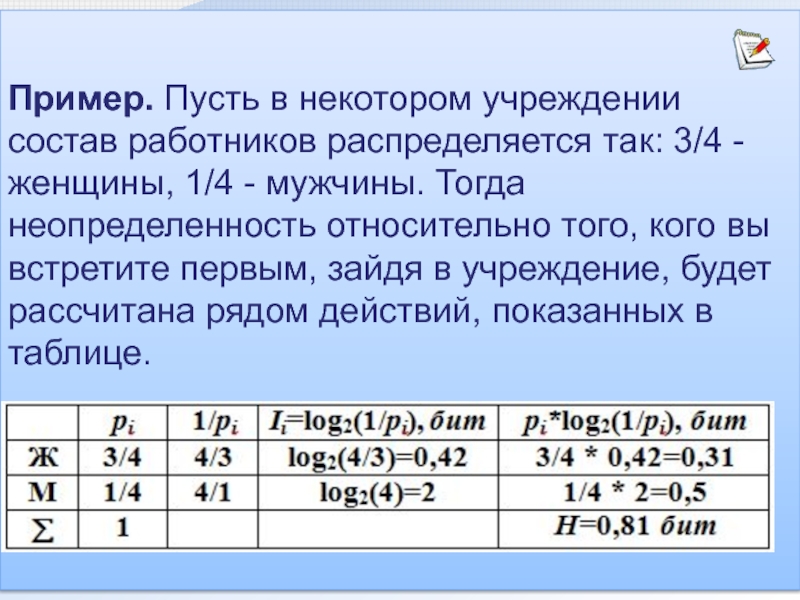

Слайд 40Пример. Пусть в некотором учреждении состав работников распределяется так: 3/4

- женщины, 1/4 - мужчины. Тогда неопределенность относительно того, кого

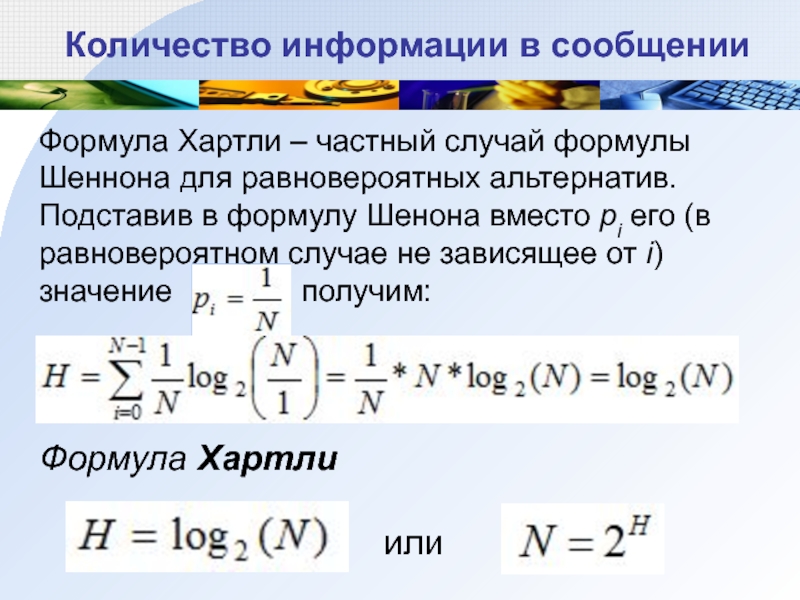

вы встретите первым, зайдя в учреждение, будет рассчитана рядом действий, показанных в таблице.Слайд 41Количество информации в сообщении

Формула Хартли – частный случай формулы Шеннона

для равновероятных альтернатив.

Подставив в формулу Шенона вместо pi его

(в равновероятном случае не зависящее от i) значение , получим:Формула Хартли

или

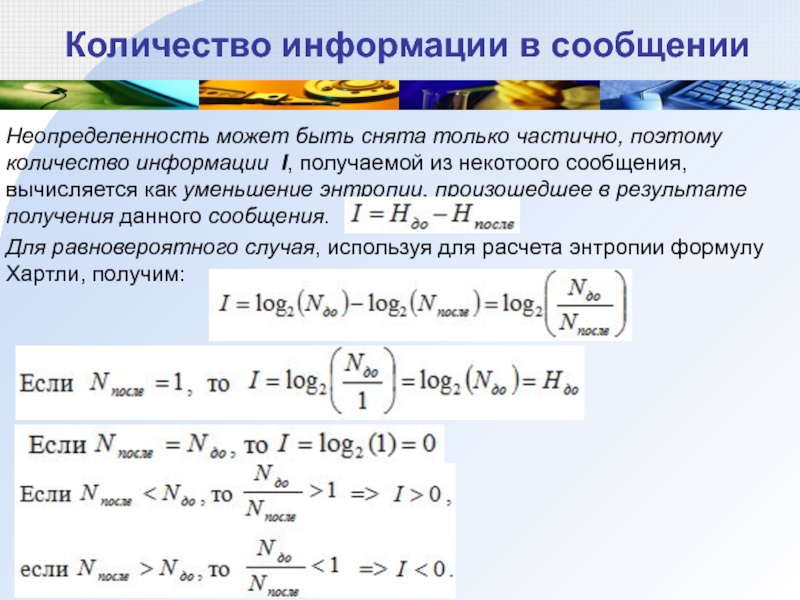

Слайд 42Количество информации в сообщении

Неопределенность может быть снята только частично, поэтому

количество информации I, получаемой из некотоого сообщения, вычисляется как уменьшение

энтропии, произошедшее в результате получения данного сообщения.Для равновероятного случая, используя для расчета энтропии формулу Хартли, получим:

Слайд 43 Некто вынимает одну карту из колоды (36 карт). Изначальная неопределенность

H=log2(36)5,17бит.

Вытянувший карту сообщает нам часть информации. Какое количество информации

мы получаем из этих сообщений?A. “Это карта красной масти”. I=log2(36/18)=log2(2)=1бит (красных карт в колоде половина, неопределенность уменьшилась в 2 раза).

B. “Это карта пиковой масти”. I=log2(36/9)=log2(4)=2 бита (пиковые карты составляют четверть колоды, неопределенность уменьшилась в 4 раза).

С. “Это одна из старших карт: валет, дама, король или туз”.

I=log2(36)–log2(16)=5,17-4=1,17 бита (неопределенность уменьшилась больше чем в два раза, поэтому полученное количество информации больше одного бита).

D. “Это одна карта из колоды". I=log2(36/36)=log2(1)=0 бит (неопределенность не уменьшилась).

E. “Это дама пик". I=log2(36/1)=log2(36)=5,17 бит (неопределенность полностью снята).

Слайд 44Задача 1. Какое количество информации будет содержать зрительное сообщение о

цвете вынутого шарика, если в непрозрачном мешочке находится 50 белых,

25 красных, 25 синих шариков?Решение.

1) всего шаров 50+25+25=100

2) вероятности шаров 50/100=1/2, 25/100=1/4, 25/100=1/4

3)I = -(1/2 log21/2 + 1/4 log21/4 + 1/4 log21/4) =

= -(1/2(0-1) +1/4(0-2) +1/4(0-2)) = 1,5 бит

Задача 2. В корзине лежит 16 шаров разного цвета. Сколько информации несет сообщение, что достали белый шар?

Решение. Т.к. N = 16 шаров, то I = log2 N = log2 16 = 4 бит.

Слайд 45Задача 3. В корзине лежат черные и белые шары. Среди

них18 черных шаров. Сообщение о том, что достали белый шар,

несет 2 бита информации. Сколько всего шаров в корзине?18 2) 24 3) 36 4)48

Слайд 46Задача 3. В корзине лежат черные и белые шары. Среди

них18 черных шаров. Сообщение о том, что достали белый шар,

несет 2 бита информации. Сколько всего шаров в корзине?18 2) 24 3) 36 4)48

Решение. Найдем по формуле Шеннона вероятность получения белого шара: log2N=2, N=4, следовательно, вероятность получения белого шара равна 1/4 (25%), а вероятность получения черного шара соответственно 3/4(75%). Если 75% всех шариков черные, их количество 18, тогда 25% всех шариков белые, их количество (18*25)/75=6.

Осталось найти количество всех шариков в корзине 18+6=24.

Ответ: 24 шарика.

Слайд 47

Решение. Количество символов для кодирования номера составляет: 30 букв +

10 цифр = 40 символов. Количество информации несущий один символ

равен 6 бит (2I=40, но количество информации не может быть дробным числом, поэтому берем ближайшую степень двойки большую количества символов 26=64).Мы нашли количество информации, заложенное в каждом символе, количество символов в номере равно 5, следовательно, 5*6=30 бит. Каждый номер равен 30 битам информации, но по условию задачи каждый номер кодируется одинаковым и минимально возможным количеством байт. Если разделить 30 на 8 получится дробное число, а нам необходимо найти целое количество байт на каждый номер. Находим ближайший множитель 8-ки, который превысит количество бит, это 4 (8*4=32). Каждый номер кодируется 4 байтами.

Для хранения 50 автомобильных номеров потребуется: 4*50=200 байт.

Слайд 48

Выбор оптимальной стратегии в игре "Угадай число".

Первый участник загадывает целое

число (например, 3) из заданного интервала (например, от 1 до

16), а второй - должен "угадать" задуманное число.Начальная неопределенность знаний для второго участника составляет 16 возможных событий.

При оптимальной стратегии интервал чисел всегда должен делиться пополам, тогда количество возможных событий (чисел) в каждом из полученных интервалов будет одинаково и отгадывание интервалов равновероятно. В этом случае на каждом шаге ответ первого игрока ("Да" или "Нет") будет нести максимальное количество информации (1 бит).

Слайд 49Контрольные вопросы и задания

1. Априори известно, что шарик находится в

одной из трех урн: А, В или С. Определите, сколько

бит информации содержит сообщение о том, что он находится в урне В.Варианты: 1 бит, 1,58 бита, 2 бита, 2,25 бита.

2. Вероятность первого события составляет 0,5, а второго и третьего 0,25. Чему для такого распределения равна информационная энтропия. Варианты: 0,5 бита, 1 бит, 1,5 бита, 2 бита, 2,5 бита, 3 бита.

Слайд 50Контрольные вопросы и задания

3. Вот список сотрудников некоторой организации:

Определите количество

информации, недостающее для того, чтобы выполнить следующие просьбы:

Пожалуйста, позовите к

телефону Иванову.Меня интересует одна ваша сотрудница, она 1970 года рождения.