повышают уровень

осведомленности человека, уменьшают меру неопределенности его знаний.

Данные – это результат наблюдений, зарегистрированные сигналы, которые не используются, а только хранятся. Как только данные начинают использоваться в практических целях, появляется информация. Данные и информация

Р. Хартли первым ввел в теорию передачи информации методологию

«измерения количества информации». При этом Хартли считал, что

информация, которую он собирался измерять, это «…группа физических

символов – слов, точек, тире и т. п., имеющих по общему соглашению

известный смысл для корреспондирующих сторон».

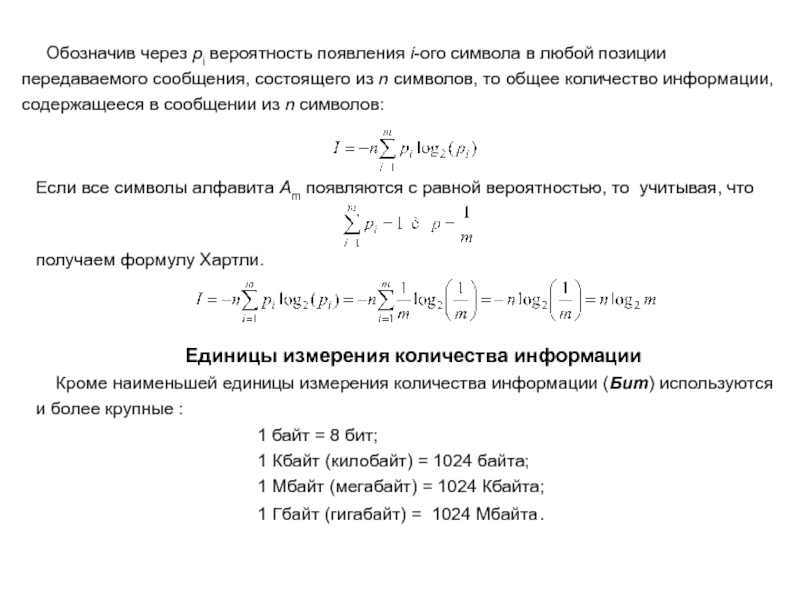

Если передаётся последовательность из n символов а1, а2, а3,…, аn,

каждый из которых принадлежит алфавиту Аm, состоящему из m

символов, то число различных вариантов таких последовательностей K

для n = 1 (передаётся один символ) - K = m, а для n = 2 (передаётся 2 символа), то K = m2?

в общем случае для последовательности из n символов - K = mn.

Количество информации, содержащееся в такой последовательности, Хартли

предложил вычислять как логарифм числа K по основанию 2:

I = log2 K, где K = mn,

а количество информации, содержащееся в последовательности из n символов из

алфавита Am, в соответствии с формулой Хартли равно

I = log2(mn) = n log2m .