Слайд 1КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

Слайд 2ОСНОВНЫЕ ТЕМЫ ЛЕКЦИИ

КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОР-МАЦИИ

ЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙ

Слайд 3КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

Всякая информация получается потребителем после принятия

сообщения, т.е. в результате опыта. Сообщение, получаемое на приемной стороне,

несет полезную информацию лишь в том случае, если имеется неопределенность относительно состояния источника сообщений.

Если опыт имеет лишь один исход и не содержит никакой неопределенности, то наблюдатель заранее будет знать исход этого опыта. В результате осуществления такого опыта наблюдатель не получит никакой информации.

Слайд 4Пусть опыт имеет два исхода Х1 и Х2 с вероятно-стями

Р(Х1) и Р(Х2). Например, результат контроля должен указать, что проверяемый

параметр находится в пределах нормы или за ее пределами. Переда-ваемое сообщение может принимать два значения и содержит определенную информацию.

Если контролируемая в опыте величина (напряжение, температура, вес и т.п.) может принимать с опреде-ленными вероятностями, например 10 различных значений, то предварительная неопределенность относительно исхода опыта будет больше, а поступившее сообщение о конкретном исходе опыта дает более уточненную характеристику состояния источника (т.е. больше информации).

Слайд 5В общем случае источник может передавать "n" независимых и несовместимых

сообщений Х1, Х2,... Хn , с вероятностями Р(Х1), Р(Х2), ...

Р(Хn) соответ-ственно.

Естественно, чем меньше априорная вероятность события, тем больше неопределенность о возможности наступления этого события.

Поэтому хотелось бы принять в качестве меры неопределенности отдельного сообщения, а также передаваемой им информации, величину, обратную его априорной вероятности: 1 / P(Xi) .

Однако, такая мера неудобна тем, что в случае, когда опыт имеет только один исход, т.е. вероятность такого события равна единице, – количество информации, согласно принятой мере, равно единице. В действительности результат такого опыта не дает никакой информации.

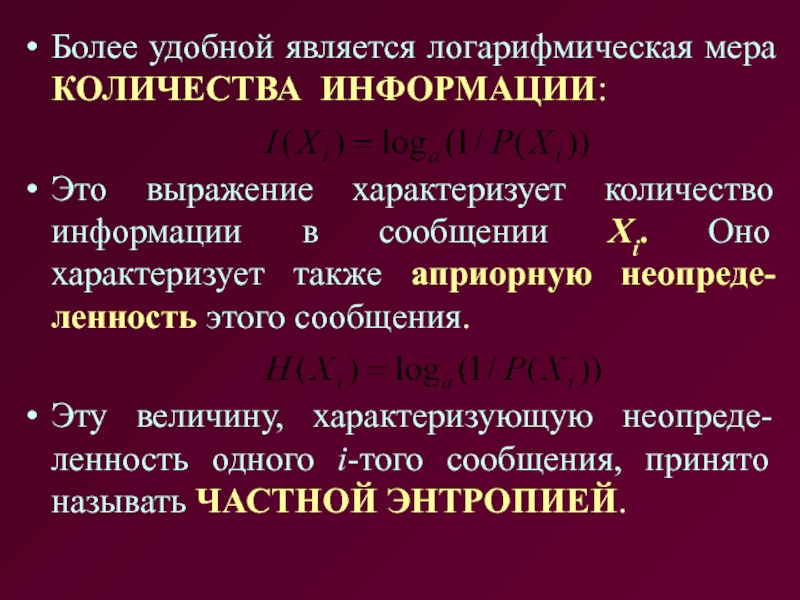

Слайд 6Более удобной является логарифмическая мера КОЛИЧЕСТВА ИНФОРМАЦИИ:

Это выражение характеризует количество

информации в сообщении Xi. Оно характеризует также априорную неопреде-ленность этого

сообщения.

Эту величину, характеризующую неопреде-ленность одного i-того сообщения, принято называть ЧАСТНОЙ ЭНТРОПИЕЙ.

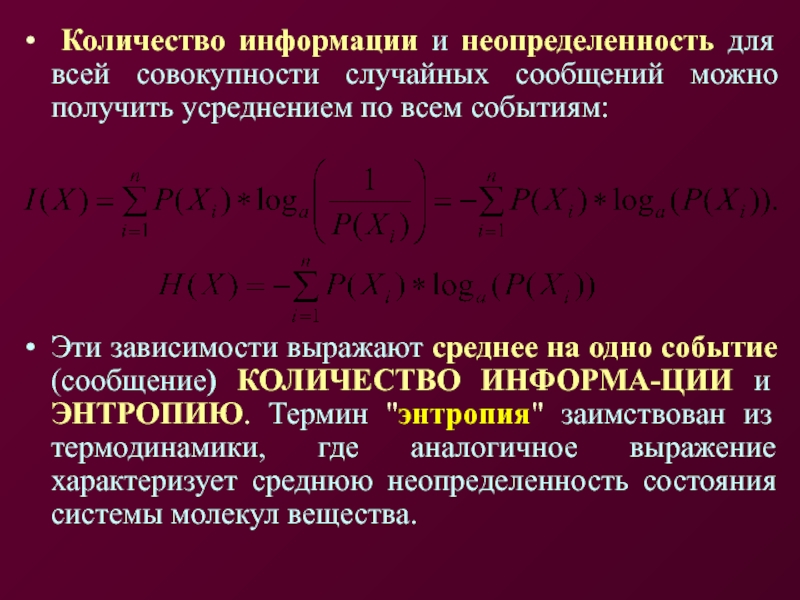

Слайд 7 Количество информации и неопределенность для всей совокупности случайных сообщений

можно получить усреднением по всем событиям:

Эти зависимости выражают среднее на

одно событие (сообщение) КОЛИЧЕСТВО ИНФОРМА-ЦИИ и ЭНТРОПИЮ. Термин "энтропия" заимствован из термодинамики, где аналогичное выражение характеризует среднюю неопределенность состояния системы молекул вещества.

Слайд 8 Несмотря на совпадение формул для энтропии и количества информации,

они принципиально различны.

ЭНТРОПИЯ H(X), выражающая среднюю неопределенность состояния

источника сообщений, является объективной характеристикой источника сообщений и может быть вычислена априорно (до получения сообщения).

КОЛИЧЕСТВО ИНФОРМАЦИИ I(X) опреде-ляется апостериорно (после получения сообщения). H(X) – энтропия – это мера недостатка информации о состоянии системы. С поступлением информации о состоянии системы энтропия (т.е. неопределенность) уменьшается.

Слайд 9Количество получаемой информации I(X) равно численно энтропии Н(Х), которая имела

место относительно источника сообщения до передачи информации.

КОЛИЧЕСТВО ИНФОРМАЦИИ рассматрива-ется

как мера уничтожения, снятия неопределен-ности.

При передаче сообщения за счет действия помех возможно получение искаженного сигнала. Это приводит к неполному снятию неопределенности (а иногда и к увеличению неопределенности). Поэтому количество информации I(X) численно может не совпадать с априорной неопределенностью H(X).

Слайд 10Единицы измерения КОЛИЧЕСТВА ИНФОРМАЦИИ и ЭНТРОПИИ зависят от выбора основания

логарифма. При использовании десятичных логарифмов количество информации и энтропия определяются

в десятичных единицах – ДИТах.

При анализе информационных процессов в ЭВМ, функционирующих на основе двоичной системы счисления, удобно использовать двоичное основание логарифма, а количество информации и энтропия измеряются в двоичных единицах – БИТах.

При использовании натуральных логарифмов единицей измерения является – НИТ.

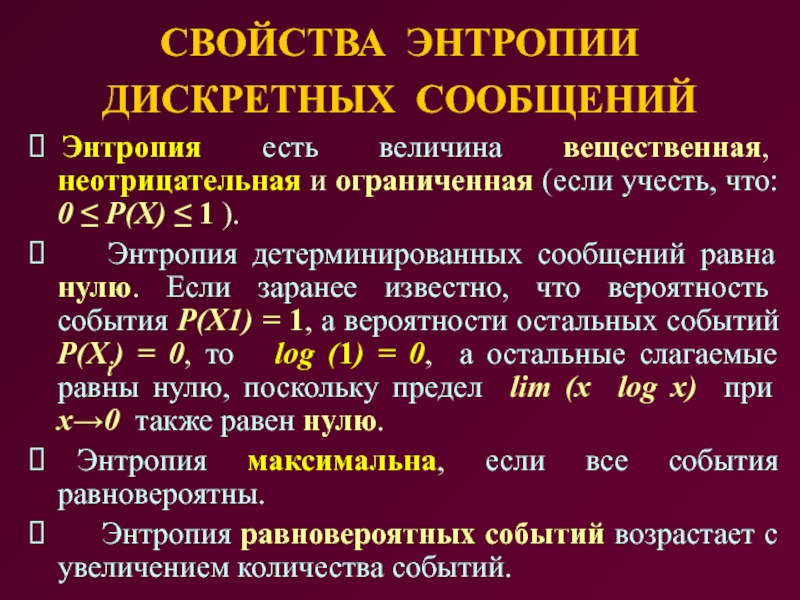

Слайд 11СВОЙСТВА ЭНТРОПИИ ДИСКРЕТНЫХ СООБЩЕНИЙ

⮚ Энтропия есть величина вещественная, неотрицательная и

ограниченная (если учесть, что: 0 ≤ P(X) ≤ 1

).

⮚ Энтропия детерминированных сообщений равна нулю. Если заранее известно, что вероятность события Р(Х1) = 1, а вероятности остальных событий Р(Xi) = 0, то log (1) = 0, а остальные слагаемые равны нулю, поскольку предел lim (x log x) при x→0 также равен нулю.

⮚ Энтропия максимальна, если все события равновероятны.

⮚ Энтропия равновероятных событий возрастает с увеличением количества событий.

Слайд 12ЭНТРОПИЯ СЛОЖНЫХ СООБЩЕНИЙ

Реально наблюдаемые случайные процессы могут быть

НЕЗАВИСИМЫМИ или ВЗАИМОСВЯ-ЗАННЫМИ.

Например, бросание игральной кости в нескольких опытах –

это независимые процессы.

Пример зависимых событий: при передаче телеграмм после согласной буквы более вероятно появление гласной буквы, чем второй согласной.

Классический пример с непрозрачным кувшином, из которого вынимаются белые или черные шары.

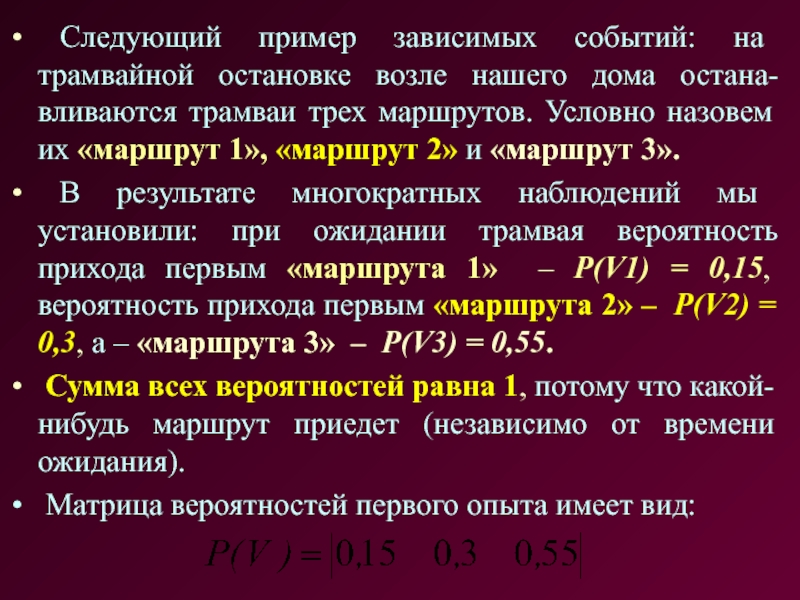

Слайд 13 Следующий пример зависимых событий: на трамвайной остановке возле нашего

дома остана-вливаются трамваи трех маршрутов. Условно назовем их «маршрут 1»,

«маршрут 2» и «маршрут 3».

В результате многократных наблюдений мы установили: при ожидании трамвая вероятность прихода первым «маршрута 1» – Р(V1) = 0,15, вероятность прихода первым «маршрута 2» – P(V2) = 0,3, а – «маршрута 3» – P(V3) = 0,55.

Сумма всех вероятностей равна 1, потому что какой-нибудь маршрут приедет (независимо от времени ожидания).

Матрица вероятностей первого опыта имеет вид:

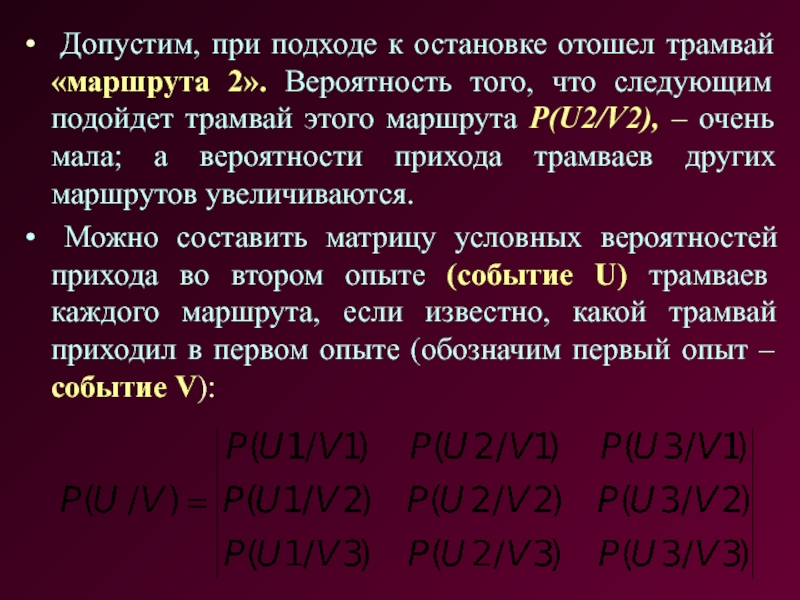

Слайд 14 Допустим, при подходе к остановке отошел трамвай «маршрута 2».

Вероятность того, что следующим подойдет трамвай этого маршрута P(U2/V2), –

очень мала; а вероятности прихода трамваев других маршрутов увеличиваются.

Можно составить матрицу условных вероятностей прихода во втором опыте (событие U) трамваев каждого маршрута, если известно, какой трамвай приходил в первом опыте (обозначим первый опыт – событие V):

Слайд 15Сумма вероятностей каждой строки матрицы равна 1, потому что независимо

от исхода первого опыта, во втором опыте какой-нибудь маршрут обязательно

приедет.

Кроме условных вероятностей можно составить матрицу вероятностей совместного появления двух событий:

где: P(U,V) – вероятность того, что в первом опыте приедет трамвай «маршрута 1», а во втором опыте – трамвай «маршрута 2».

Слайд 16Вероятность совместного появления двух событий равна произведению условной вероятности на

безусловную вероятность события в первом опыте:

Поэтому матрицу совместного появления двух

событий можно представить в таком виде:

Из этого следует, что сумма всех элементов матрицы равна 1.

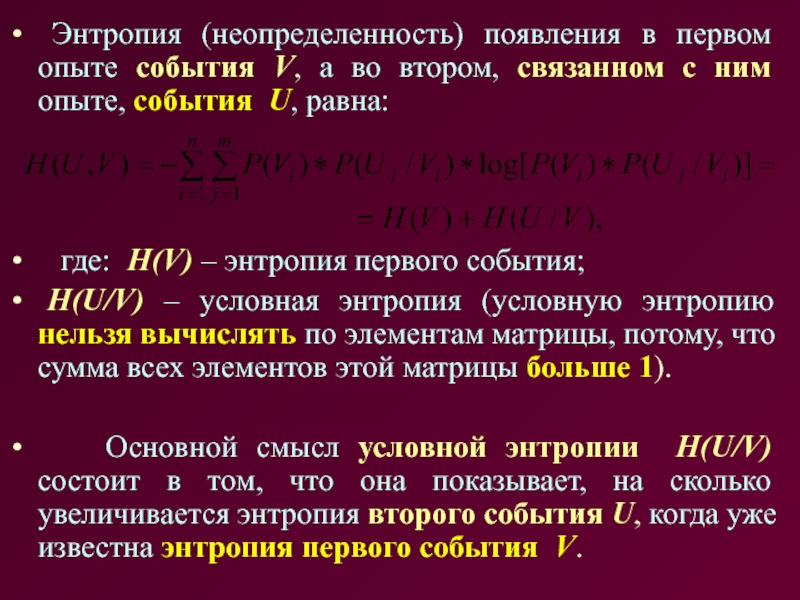

Слайд 17 Энтропия (неопределенность) появления в первом опыте события V, а

во втором, связанном с ним опыте, события U, равна:

где: Н(V) – энтропия первого события;

H(U/V) – условная энтропия (условную энтропию нельзя вычислять по элементам матрицы, потому, что сумма всех элементов этой матрицы больше 1).

Основной смысл условной энтропии H(U/V) состоит в том, что она показывает, на сколько увеличивается энтропия второго события U, когда уже известна энтропия первого события V.

Слайд 18СВОЙСТВА ЭНТРОПИИ СЛОЖНЫХ СООБЩЕНИЙ

⮚ При статистически независимых сообщениях U

и V совместная энтропия равна сумме энтропии сообщений:

⮚ При полной

статистической зависимости сообще-ний U и V совместная энтропия равна безусловной энтропии одного из сообщений:

H(U/V) = 0; H(U,V) = H(U) = H(V).

⮚ Следствием первых двух свойств является то, что условная энтропия ограничена пределами:

0 ≤ H(U/V) ≤ H(U).

Слайд 19Вопросы для экспресс-контроля

1. В чем различие и сходство терминов КОЛИ-ЧЕСТВО

ИНФОРМАЦИИ и ЭНТРОПИЯ?

2. Единицы измерения информации и энтропии.

3. Свойства энтропии

дискретных сообщений.

4. Назовите примеры зависимых и независимых событий.

5. Дайте определение условной энтропии.

6. Свойства энтропии зависимых событий.

Слайд 20ЛЕКЦИЯ ОКОНЧЕНА

СПАСИБО ЗА

ВНИМАНИЕ