Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

1 НЕЛИНЕЙНАЯ РЕГРЕССИЯ Предположим, что переменная Y зависит от переменной X в

Содержание

- 1. 1 НЕЛИНЕЙНАЯ РЕГРЕССИЯ Предположим, что переменная Y зависит от переменной X в

- 2. Представленное выше уравнение не может быть преобразовано

- 3. Тем не менее, все же можно использовать

- 4. Начинаем с оценивания правдоподобных значений параметров. 4НЕЛИНЕЙНАЯ РЕГРЕССИЯАлгоритм

- 5. Вычисляем соответствующие установленные значения Y из данных

- 6. 6НЕЛИНЕЙНАЯ РЕГРЕССИЯВычисляем остатки для каждого наблюдения в

- 7. 7НЕЛИНЕЙНАЯ РЕГРЕССИЯЗатем вносим небольшие изменения в одну

- 8. Используя новые оценки b1, b2, и b3

- 9. Если RSS меньше стал меньше предыдущего, новые

- 10. Вы повторяете шаги 5, 6 и 7

- 11. Делается вывод о том, что величина RSS

- 12. Следует подчеркнуть, что математики давно разработали сложные

- 13. Мы вернемся к взаимосвязи между темпами роста

- 14. Согласно этой спецификации, когда g становится большим,

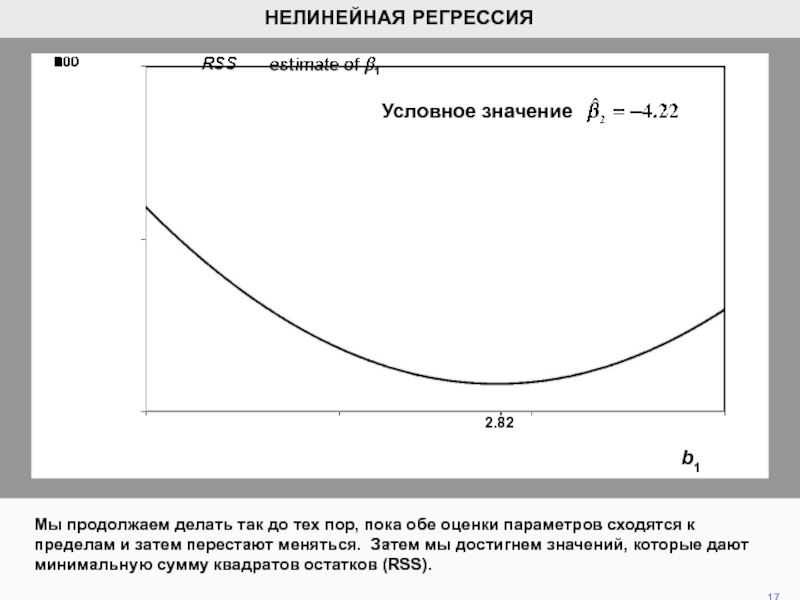

- 15. На рисунке показано, как RSS отображается в

- 16. Затем, фиксируя на уровне -4.22,

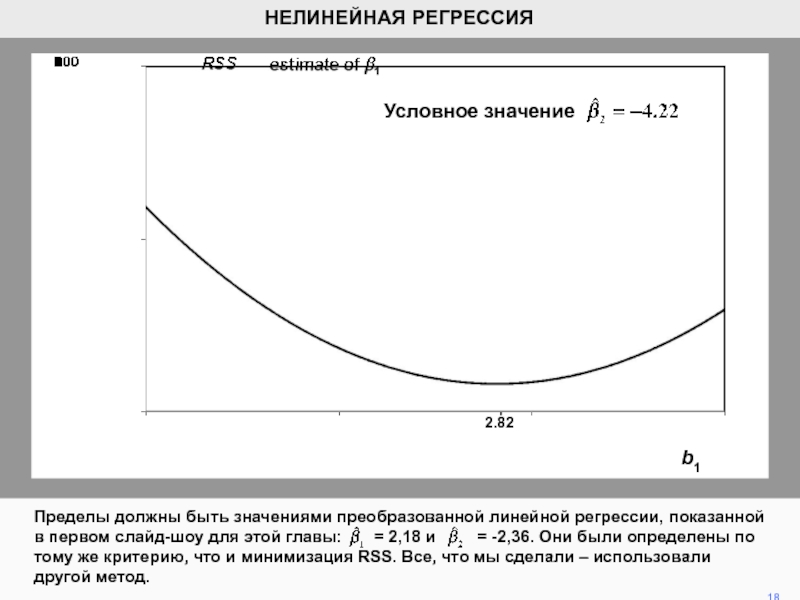

- 17. Мы продолжаем делать так до тех пор,

- 18. Пределы должны быть значениями преобразованной линейной регрессии,

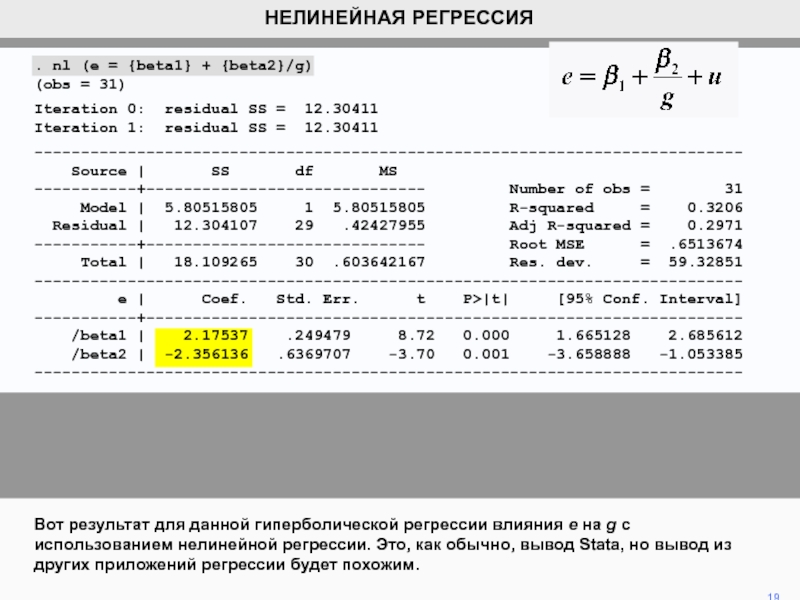

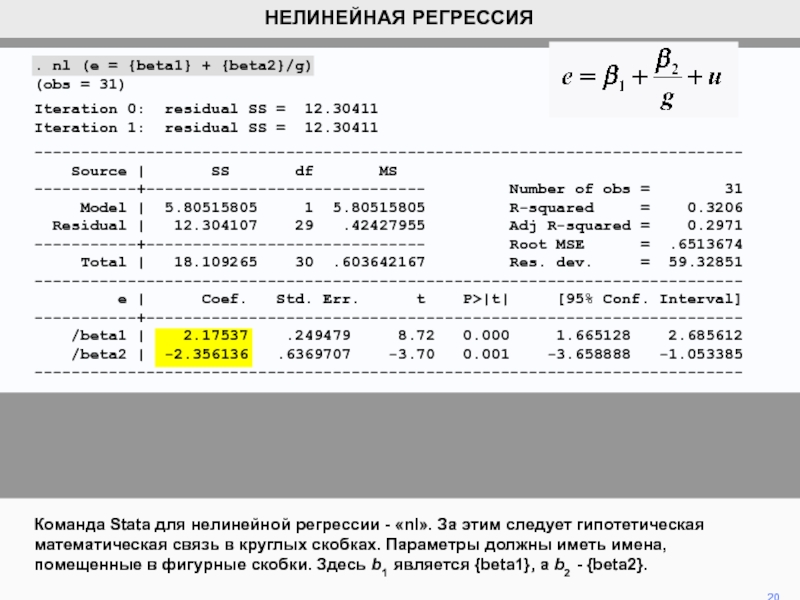

- 19. Вот результат для данной гиперболической регрессии влияния

- 20. Команда Stata для нелинейной регрессии - «nl».

- 21. . gen z = 1/g. reg e

- 22. Гиперболическая функция вводит такое ограничение, что функция

- 23. Эта особенность может быть ослаблена путем использование

- 24. . nl (e = {beta1} + {beta2}/({beta3}

- 25. На рисунке сравниваются оригинальные (черные) и новые

- 26. Скачать презентанцию

Слайды и текст этой презентации

Слайд 2Представленное выше уравнение не может быть преобразовано в уравнение линейного

вида, поэтому в этом случае невозможно применение обычной процедуры оценивания

регрессии. 2

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Слайд 3Тем не менее, все же можно использовать принцип минимизации суммы

квадратов остатков для получения оценок параметров. Мы опишем простой нелинейный

регрессионный алгоритм, который использует принцип, состоящий из серии повторяющихся шагов. 3

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Слайд 4Начинаем с оценивания правдоподобных значений параметров.

4

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Алгоритм нелинейной регрессии

1. Предположение b1,

b2, и b3. , ,

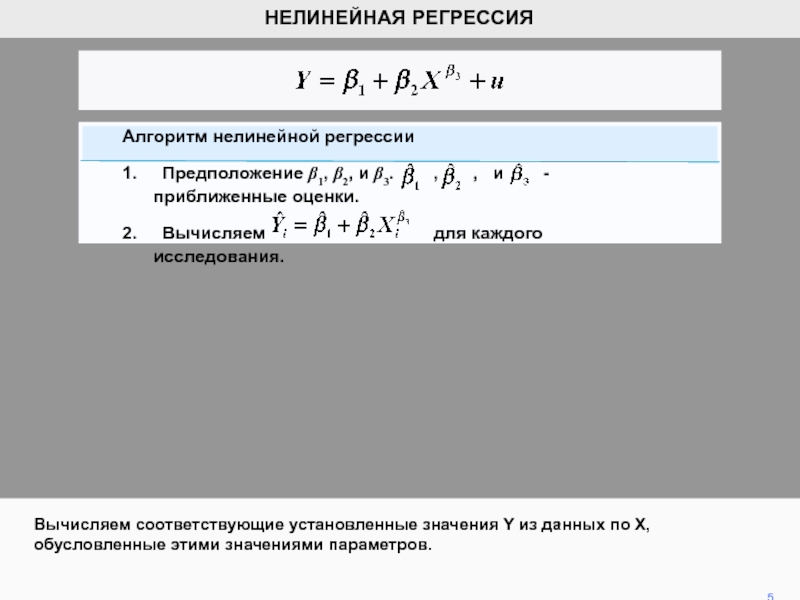

и - приближенные оценки.Слайд 5Вычисляем соответствующие установленные значения Y из данных по X, обусловленные

этими значениями параметров.

5

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Алгоритм нелинейной регрессии

1. Предположение b1, b2, и b3.

, , и - приближенные оценки.2. Вычисляем для каждого исследования.

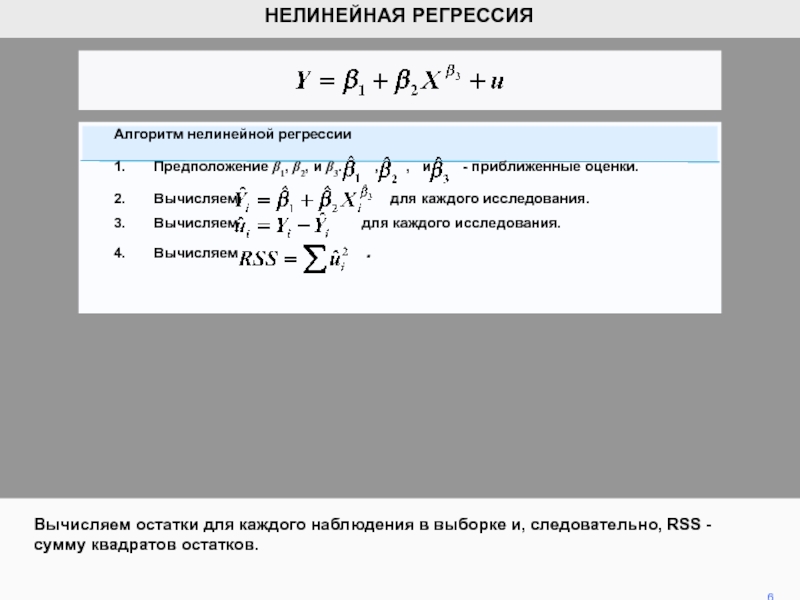

Слайд 6 6

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Вычисляем остатки для каждого наблюдения в выборке и, следовательно,

RSS - сумму квадратов остатков.

Алгоритм нелинейной регрессии

1. Предположение b1, b2, и

b3. , , и - приближенные оценки.2. Вычисляем для каждого исследования.

3. Вычисляем для каждого исследования.

4. Вычисляем .

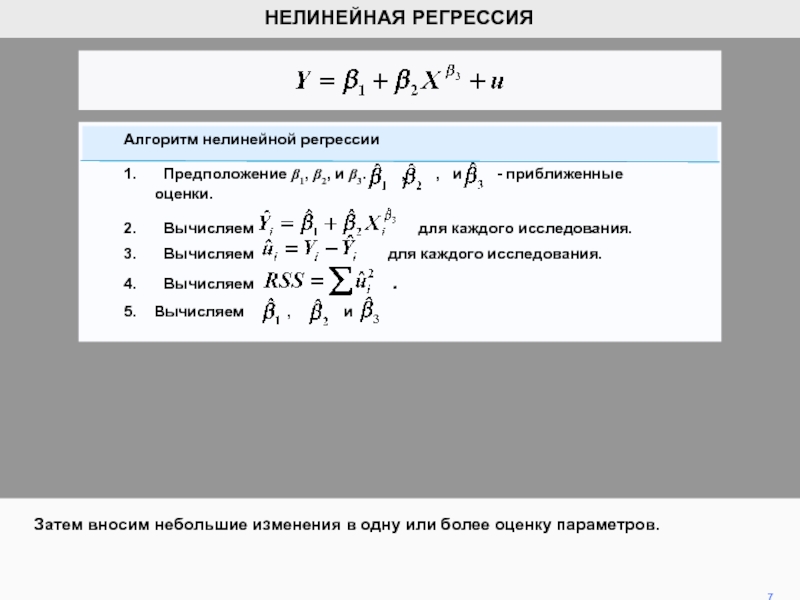

Слайд 7 7

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Затем вносим небольшие изменения в одну или более оценку

параметров.

Алгоритм нелинейной регрессии

1. Предположение b1, b2, и b3.

, , и - приближенные оценки.2. Вычисляем для каждого исследования.

3. Вычисляем для каждого исследования.

4. Вычисляем .

5. Вычисляем , и

Слайд 8Используя новые оценки b1, b2, и b3 , пересчитываем установленные

значения Y. Затем пересчитываем остатки и RSS.

8

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Nonlinear regression algorithm

1. Guess

b1, b2, and b3. b1, b2, and b3 are the guesses.2. Calculate Yi = b1 + b2Xi for each observation.

3. Calculate ei = Yi – Yi for each observation.

4. Calculate RSS = ∑ei.

5. Adjust b1, b2, and b3.

6. Re-calculate Yi, ei, RSS.

Алгоритм нелинейной регрессии

1. Предположение b1, b2, и b3. , , и - приближенные оценки.

2. Вычисляем для каждого исследования.

3. Вычисляем для каждого исследования.

4. Вычисляем .

5. Вычисляем , и

6. Пересчитываем Yi, , RSS.

Слайд 9Если RSS меньше стал меньше предыдущего, новые оценки параметров лучше

предыдущих, необходимо продолжать корректировать оценки в одном направлении. В противном

случае необходимо выполнить различные вычисления методом наименьших квадратов. 9

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Алгоритм нелинейной регрессии

1. Предположение b1, b2, и b3. , , и - приближенные оценки.

2. Вычисляем для каждого исследования.

3. Вычисляем для каждого исследования.

4. Вычисляем .

5. Вычисляем , и

7. Если новый RSS < предыдущего RSS, продолжить вычисление методом наименьших квадратов.

В противном случае выполнить другое вычисление.

6. Пересчитываем Yi, , RSS.

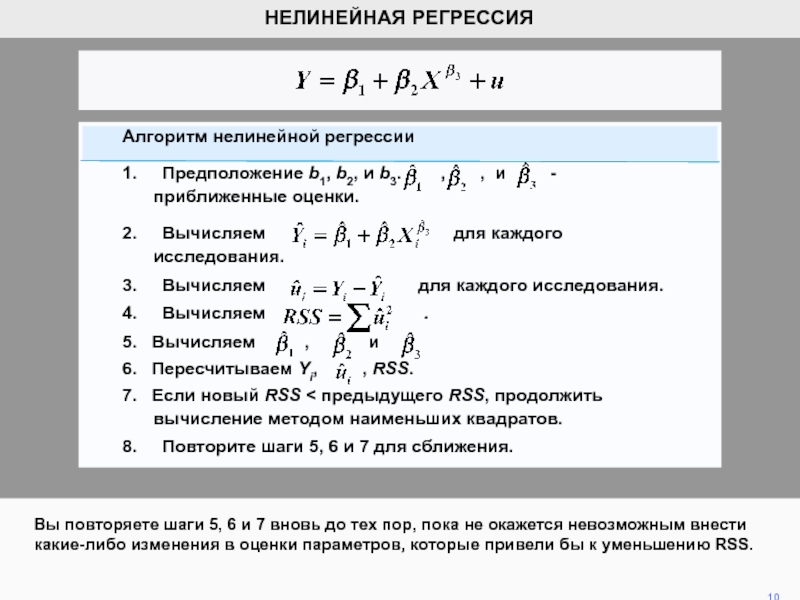

Слайд 10Вы повторяете шаги 5, 6 и 7 вновь до тех

пор, пока не окажется невозможным внести какие-либо изменения в оценки

параметров, которые привели бы к уменьшению RSS. 10

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Алгоритм нелинейной регрессии

1. Предположение b1, b2, и b3. , , и - приближенные оценки.

2. Вычисляем для каждого исследования.

3. Вычисляем для каждого исследования.

4. Вычисляем .

5. Вычисляем , и

6. Пересчитываем Yi, , RSS.

7. Если новый RSS < предыдущего RSS, продолжить вычисление методом наименьших квадратов.

8. Повторите шаги 5, 6 и 7 для сближения.

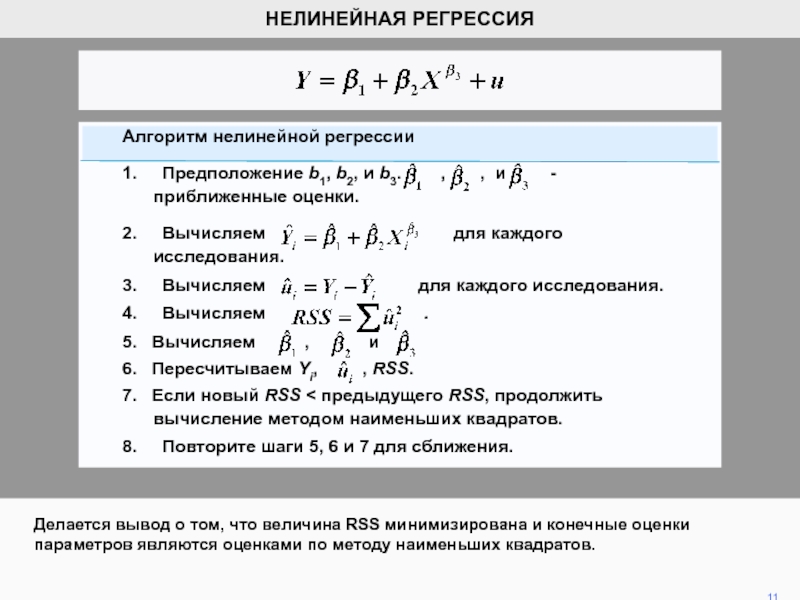

Слайд 11Делается вывод о том, что величина RSS минимизирована и конечные

оценки параметров являются оценками по методу наименьших квадратов.

11

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Алгоритм нелинейной

регрессии1. Предположение b1, b2, и b3. , , и - приближенные оценки.

2. Вычисляем для каждого исследования.

3. Вычисляем для каждого исследования.

4. Вычисляем .

5. Вычисляем , и

6. Пересчитываем Yi, , RSS.

7. Если новый RSS < предыдущего RSS, продолжить вычисление методом наименьших квадратов.

8. Повторите шаги 5, 6 и 7 для сближения.

Слайд 12Следует подчеркнуть, что математики давно разработали сложные методы, чтобы свести

к минимуму количество шагов, требуемых алгоритмами этого типа.

12

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Алгоритм нелинейной

регрессии1. Предположение b1, b2, и b3. , , и - приближенные оценки.

2. Вычисляем для каждого исследования.

3. Вычисляем для каждого исследования.

4. Вычисляем .

5. Вычисляем , и

6. Пересчитываем Yi, , RSS.

7. Если новый RSS < предыдущего RSS, продолжить вычисление методом наименьших квадратов.

8. Повторите шаги 5, 6 и 7 для сближения.

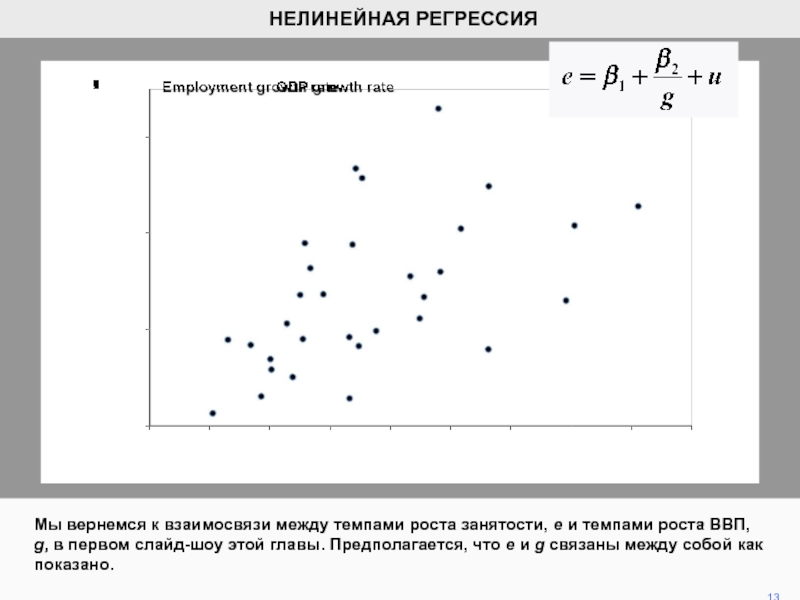

Слайд 13Мы вернемся к взаимосвязи между темпами роста занятости, е и

темпами роста ВВП, g, в первом слайд-шоу этой главы. Предполагается,

что e и g связаны между собой как показано. 13

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

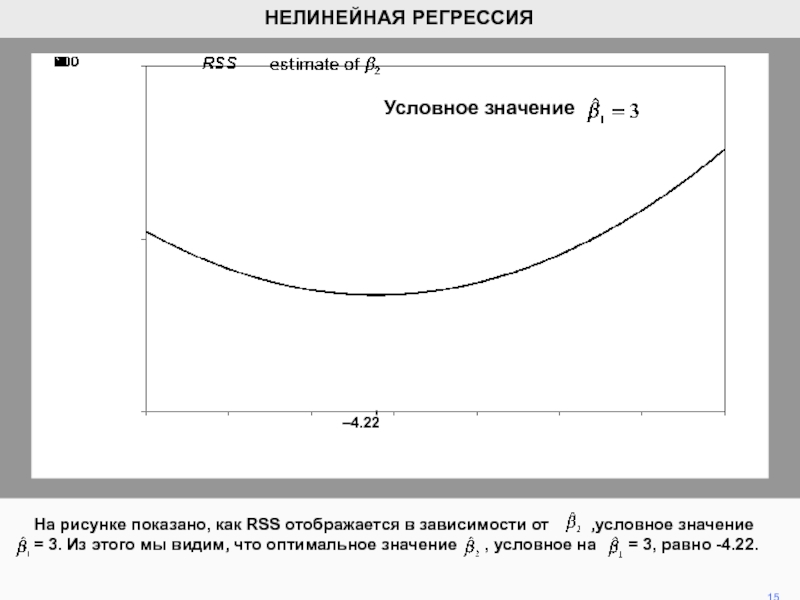

Слайд 14Согласно этой спецификации, когда g становится большим, e будет стремиться

к пределу b1. На рисунке видно, что максимальное значение e

равно 3. Поэтому будем считать его начальным значением для b1. Затем мы ищем оптимальное значение b2, обусловленное этой предпосылкой для b1. 14

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

Слайд 15На рисунке показано, как RSS отображается в зависимости от

,условное значение = 3. Из

этого мы видим, что оптимальное значение , условное на = 3, равно -4.22. 15

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

–4.22

Условное значение

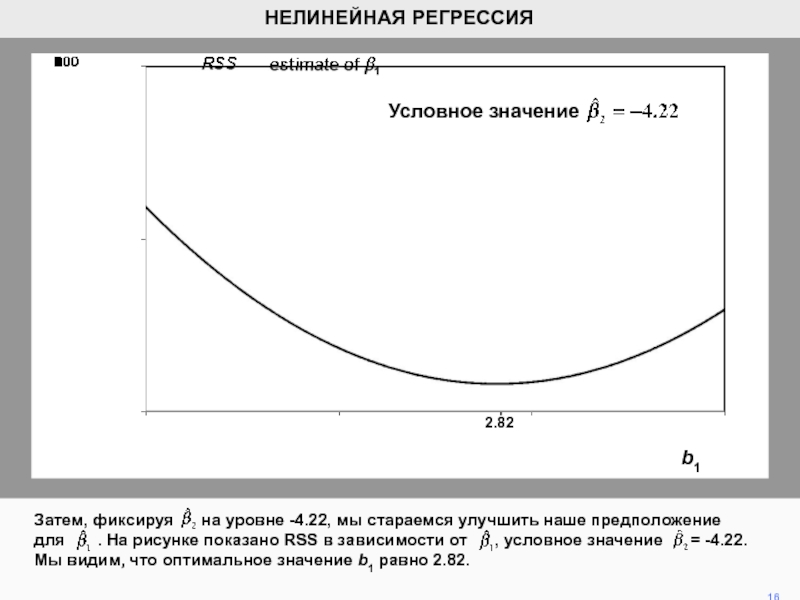

Слайд 16Затем, фиксируя на уровне -4.22, мы стараемся улучшить

наше предположение для . На рисунке

показано RSS в зависимости от , условное значение = -4.22. Мы видим, что оптимальное значение b1 равно 2.82. 16

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

b1

Условное значение

2.82

Слайд 17Мы продолжаем делать так до тех пор, пока обе оценки

параметров сходятся к пределам и затем перестают меняться. Затем мы

достигнем значений, которые дают минимальную сумму квадратов остатков (RSS). 17

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

b1

Условное значение

2.82

Слайд 18Пределы должны быть значениями преобразованной линейной регрессии, показанной в первом

слайд-шоу для этой главы: = 2,18 и

= -2,36. Они были определены по тому же критерию, что и минимизация RSS. Все, что мы сделали – использовали другой метод. 18

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

b1

Условное значение

2.82

Слайд 19Вот результат для данной гиперболической регрессии влияния e на g

с использованием нелинейной регрессии. Это, как обычно, вывод Stata, но

вывод из других приложений регрессии будет похожим. 19

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

. nl (e = {beta1} + {beta2}/g)

(obs = 31)

Iteration 0: residual SS = 12.30411

Iteration 1: residual SS = 12.30411

----------------------------------------------------------------------------

Source | SS df MS

-----------+------------------------------ Number of obs = 31

Model | 5.80515805 1 5.80515805 R-squared = 0.3206

Residual | 12.304107 29 .42427955 Adj R-squared = 0.2971

-----------+------------------------------ Root MSE = .6513674

Total | 18.109265 30 .603642167 Res. dev. = 59.32851

----------------------------------------------------------------------------

e | Coef. Std. Err. t P>|t| [95% Conf. Interval]

-----------+----------------------------------------------------------------

/beta1 | 2.17537 .249479 8.72 0.000 1.665128 2.685612

/beta2 | -2.356136 .6369707 -3.70 0.001 -3.658888 -1.053385

----------------------------------------------------------------------------

Слайд 20Команда Stata для нелинейной регрессии - «nl». За этим следует

гипотетическая математическая связь в круглых скобках. Параметры должны иметь имена,

помещенные в фигурные скобки. Здесь b1 является {beta1}, а b2 - {beta2}. 20

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

. nl (e = {beta1} + {beta2}/g)

(obs = 31)

Iteration 0: residual SS = 12.30411

Iteration 1: residual SS = 12.30411

----------------------------------------------------------------------------

Source | SS df MS

-----------+------------------------------ Number of obs = 31

Model | 5.80515805 1 5.80515805 R-squared = 0.3206

Residual | 12.304107 29 .42427955 Adj R-squared = 0.2971

-----------+------------------------------ Root MSE = .6513674

Total | 18.109265 30 .603642167 Res. dev. = 59.32851

----------------------------------------------------------------------------

e | Coef. Std. Err. t P>|t| [95% Conf. Interval]

-----------+----------------------------------------------------------------

/beta1 | 2.17537 .249479 8.72 0.000 1.665128 2.685612

/beta2 | -2.356136 .6369707 -3.70 0.001 -3.658888 -1.053385

----------------------------------------------------------------------------

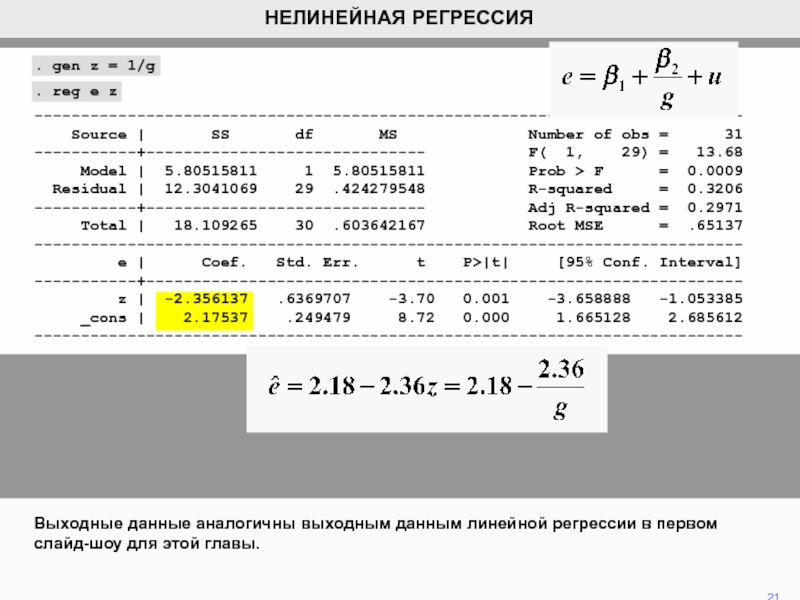

Слайд 21. gen z = 1/g

. reg e z

----------------------------------------------------------------------------

Source

| SS df

MS Number of obs = 31-----------+------------------------------ F( 1, 29) = 13.68

Model | 5.80515811 1 5.80515811 Prob > F = 0.0009

Residual | 12.3041069 29 .424279548 R-squared = 0.3206

-----------+------------------------------ Adj R-squared = 0.2971

Total | 18.109265 30 .603642167 Root MSE = .65137

----------------------------------------------------------------------------

e | Coef. Std. Err. t P>|t| [95% Conf. Interval]

-----------+----------------------------------------------------------------

z | -2.356137 .6369707 -3.70 0.001 -3.658888 -1.053385

_cons | 2.17537 .249479 8.72 0.000 1.665128 2.685612

----------------------------------------------------------------------------

Выходные данные аналогичны выходным данным линейной регрессии в первом слайд-шоу для этой главы.

21

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

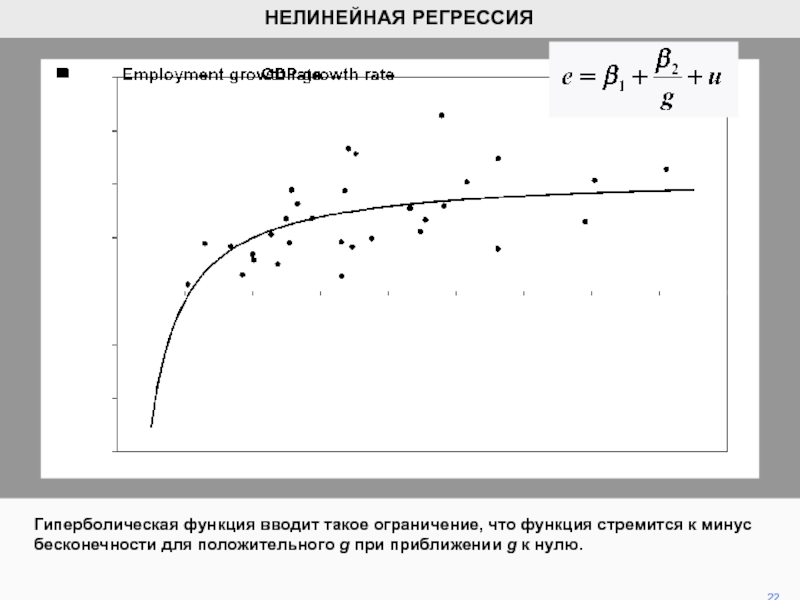

Слайд 22Гиперболическая функция вводит такое ограничение, что функция стремится к минус

бесконечности для положительного g при приближении g к нулю.

22

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

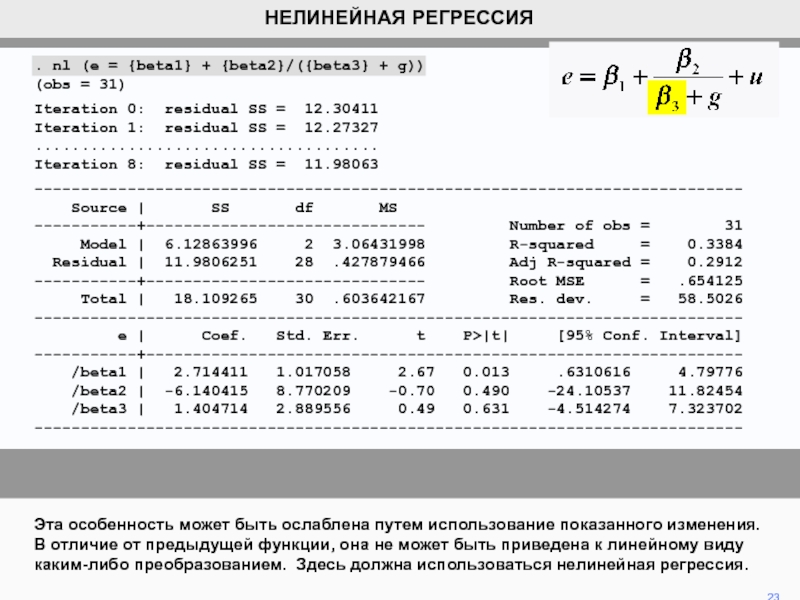

Слайд 23Эта особенность может быть ослаблена путем использование показанного изменения. В

отличие от предыдущей функции, она не может быть приведена к

линейному виду каким-либо преобразованием. Здесь должна использоваться нелинейная регрессия. 23

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

. nl (e = {beta1} + {beta2}/({beta3} + g))

(obs = 31)

Iteration 0: residual SS = 12.30411

Iteration 1: residual SS = 12.27327

.....................................

Iteration 8: residual SS = 11.98063

----------------------------------------------------------------------------

Source | SS df MS

-----------+------------------------------ Number of obs = 31

Model | 6.12863996 2 3.06431998 R-squared = 0.3384

Residual | 11.9806251 28 .427879466 Adj R-squared = 0.2912

-----------+------------------------------ Root MSE = .654125

Total | 18.109265 30 .603642167 Res. dev. = 58.5026

----------------------------------------------------------------------------

e | Coef. Std. Err. t P>|t| [95% Conf. Interval]

-----------+----------------------------------------------------------------

/beta1 | 2.714411 1.017058 2.67 0.013 .6310616 4.79776

/beta2 | -6.140415 8.770209 -0.70 0.490 -24.10537 11.82454

/beta3 | 1.404714 2.889556 0.49 0.631 -4.514274 7.323702

----------------------------------------------------------------------------

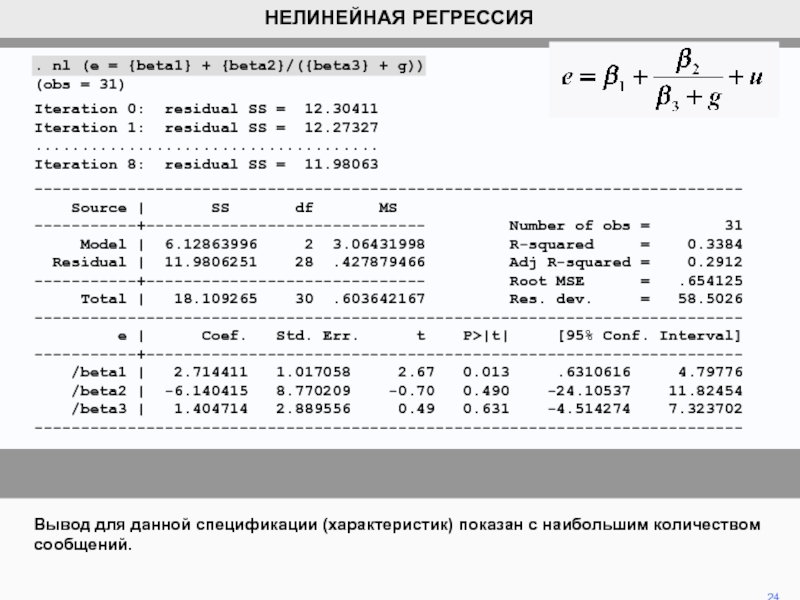

Слайд 24. nl (e = {beta1} + {beta2}/({beta3} + g))

(obs =

31)

Iteration 0: residual SS = 12.30411

Iteration 1: residual SS =

12.27327.....................................

Iteration 8: residual SS = 11.98063

----------------------------------------------------------------------------

Source | SS df MS

-----------+------------------------------ Number of obs = 31

Model | 6.12863996 2 3.06431998 R-squared = 0.3384

Residual | 11.9806251 28 .427879466 Adj R-squared = 0.2912

-----------+------------------------------ Root MSE = .654125

Total | 18.109265 30 .603642167 Res. dev. = 58.5026

----------------------------------------------------------------------------

e | Coef. Std. Err. t P>|t| [95% Conf. Interval]

-----------+----------------------------------------------------------------

/beta1 | 2.714411 1.017058 2.67 0.013 .6310616 4.79776

/beta2 | -6.140415 8.770209 -0.70 0.490 -24.10537 11.82454

/beta3 | 1.404714 2.889556 0.49 0.631 -4.514274 7.323702

----------------------------------------------------------------------------

Вывод для данной спецификации (характеристик) показан с наибольшим количеством сообщений.

24

НЕЛИНЕЙНАЯ РЕГРЕССИЯ

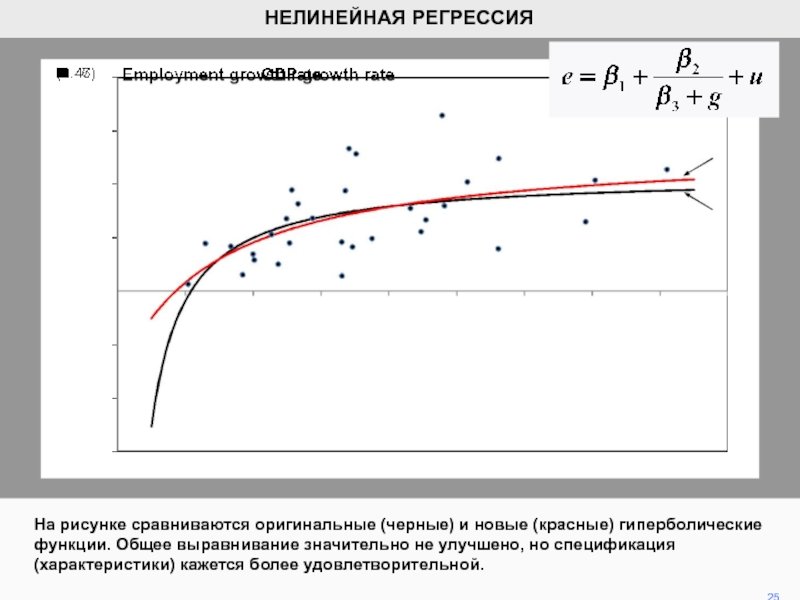

Слайд 25На рисунке сравниваются оригинальные (черные) и новые (красные) гиперболические функции.

Общее выравнивание значительно не улучшено, но спецификация (характеристики) кажется более

удовлетворительной. 25

НЕЛИНЕЙНАЯ РЕГРЕССИЯ