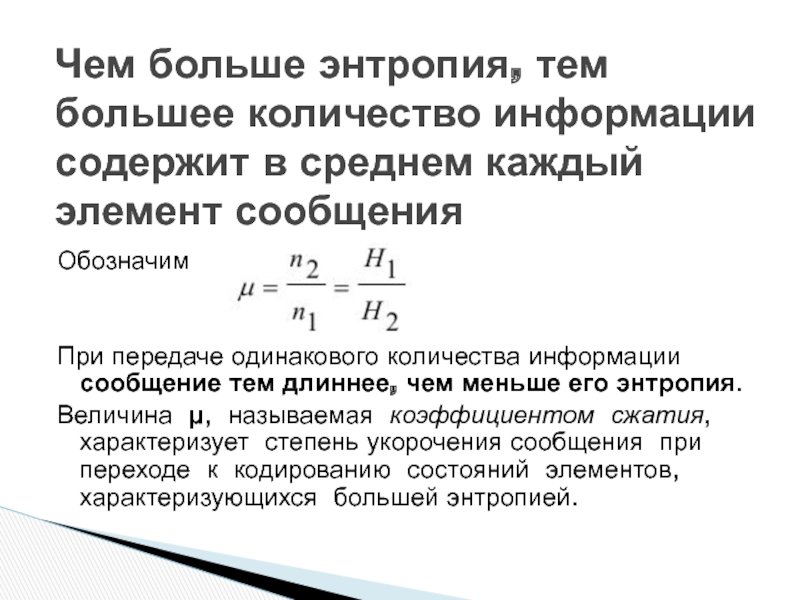

от них одинаковое, т.е.

I = n1H1 = n2H2,

где

n1 и n2 - длина сообщения от первого и второго источников

Чем больше энтропия, тем большее количество информации содержит в среднем каждый элемент сообщения

![БМ [Восстановленный] - копия](/img/thumbs/1fbbafc5dd4e436e6a7edb8068bf50b3-800x.jpg)