Слайд 1 Кластерные архитектуры

концепция, особенности организации, примеры разработок

Слайд 2Введение

Кластер - это группа вычислительных машин, которые связаны между собою

и функционируют как один узел обработки информации.

Самым важным при построении

кластерной системы является то ,что для пользователя или прикладной задачи вся совокупность вычислительной техники выглядит как один компьютер.

Узлы кластера - серверы, рабочие станции и даже обычные персональные компьютеры.

Преимущество кластеризации для повышения работоспособности становится очевидным в случае сбоя какого-либо узла: при этом другой узел кластера может взять на себя нагрузку неисправного узла, и пользователи не заметят прерывания в доступе.

Слайд 3

История развития кластерной архитектуры.

Впервые в классификации вычислительных систем термин "кластер”

определила DEC (Digital Equipment Corporation) 1983 г.

До середины 80-х годов

под технологиями суперкомпьютеров понимали исключительно создание особо мощных процессоров.

Первые кластеры компании Digital были построены на машинах VAX. Эти машины уже не производятся, но все еще работают на площадках, где были установлены много лет назад.

Общие принципы, заложенные при их проектировании, остаются основой при построении кластерных систем и сегодня.

В 1998 году в Лос-Аламосской национальной лаборатории астрофизик Майкл Уоррен c коллегами построили суперкомпьютер Avalon, который представлял собой Linux-кластер на базе процессоров Alpha 21164A с тактовой частотой 533 МГц.

Первоначально Avalon состоял из 68 процессоров, затем был расширен до 140. В каждом узле установлено по 256 Мбайт оперативной памяти, жесткий диск на 3 Гбайт и сетевой адаптер Fast Ethernet. Общая стоимость проекта Avalon составила 313 тыс. долл.

Создание кластеров на основе дешёвых персональных компьютеров, объединённых сетью передачи данных, продолжилось в 1993 г. силами Американского аэрокосмического агентства (NASA), затем в 1995 г. получили развитие кластеры Beowulf, специально разработанные на основе этого принципа. Успехи таких систем подтолкнули развитие grid-сетей.

Слайд 4Общие требование к системам.

Высокая готовность

В

случае сбоя программного обеспечения на одном узле приложение продолжает функционировать

(либо автоматически перезапускается) на других узлах кластера;

Сбой или отказ узла (или узлов) кластера по любой причине (включая ошибки персонала) не означает выхода из строя кластера в целом;

Масштабирование

Вертикальное (увеличение числа процессоров в многопроцессорных системах или добавление новых адаптеров или дисков)

Горизонтальное (предоставляет возможность добавлять в систему дополнительные компьютеры и распределять работу между ними)

Высокое быстродействие

Общий доступ к ресурсам

Удобство обслуживания

Слайд 5

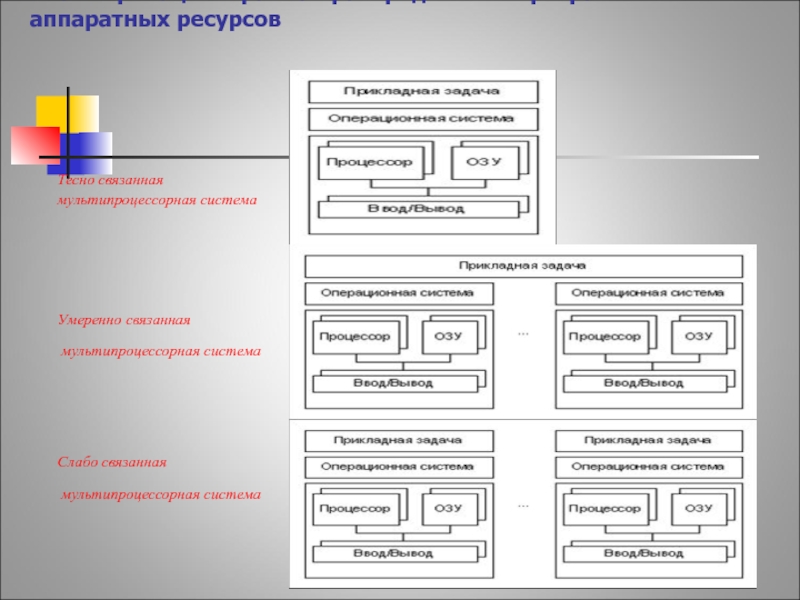

Классификация в рамках распределения программно-аппаратных ресурсов

Тесно связанная

мультипроцессорная система

Умеренно

связанная

мультипроцессорная система

Слабо связанная

мультипроцессорная система

Слайд 6Функциональная классификиция.

Высокоскоростные кластеры используются для задач, которые требуют значительной вычислительной

мощности.

Классическими областями, в которых используются подобные системы, являются:

обработка изображений

научные исследования

промышленность

Системы высокой готовности используются везде, где стоимость возможного простоя превышает стоимость затрат, необходимых для построения кластерной системы, например:

биллинговые системы

банковские операции

электронная коммерция

управление предприятием

Слайд 7Системы высокой готовности.

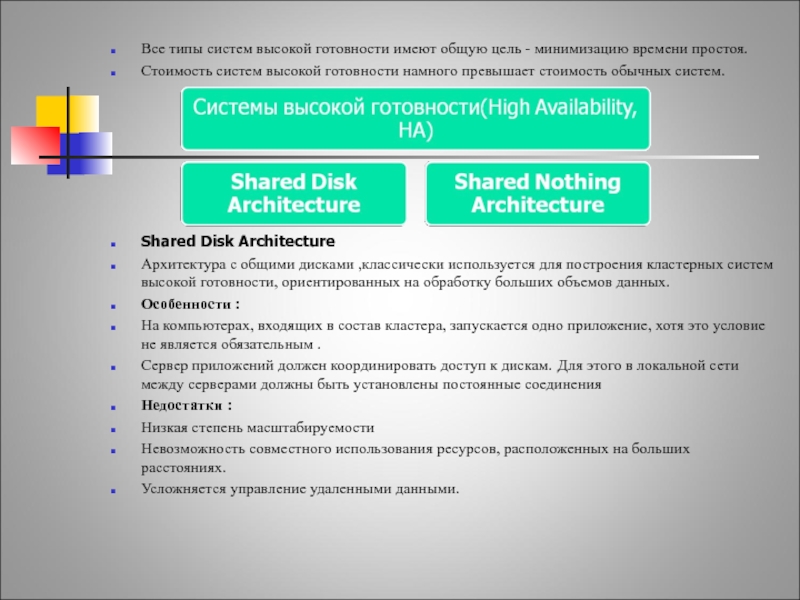

Все типы систем высокой готовности имеют общую цель

- минимизацию времени простоя.

Стоимость систем высокой готовности намного превышает стоимость

обычных систем.

Shared Disk Architecture

Архитектура с общими дисками ,классически используется для построения кластерных систем высокой готовности, ориентированных на обработку больших объемов данных.

Особенности :

На компьютерах, входящих в состав кластера, запускается одно приложение, хотя это условие не является обязательным .

Сервер приложений должен координировать доступ к дискам. Для этого в локальной сети между серверами должны быть установлены постоянные соединения

Недостатки :

Низкая степень масштабируемости

Невозможность совместного использования ресурсов, расположенных на больших расстояниях.

Усложняется управление удаленными данными.

Слайд 8Системы высокой готовности.

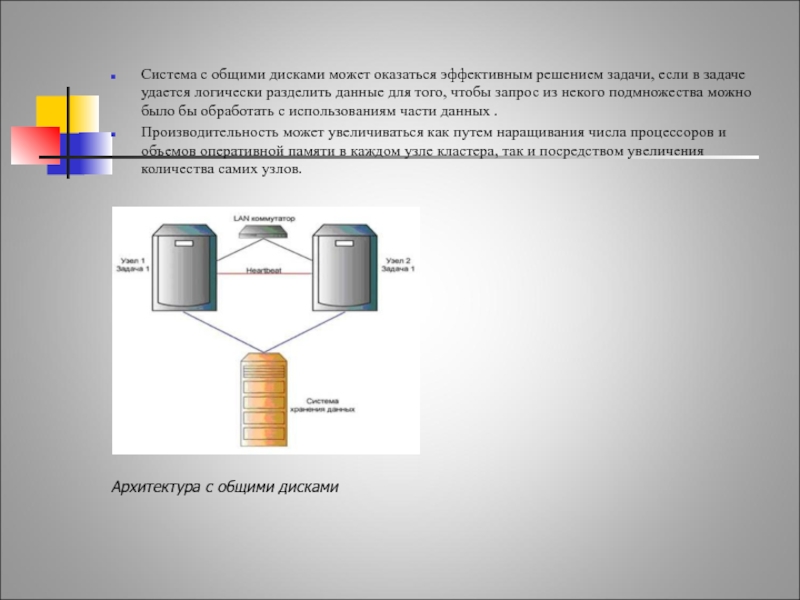

Система с общими дисками может оказаться эффективным решением

задачи, если в задаче удается логически разделить данные для того,

чтобы запрос из некого подмножества можно было бы обработать с использованиям части данных .

Производительность может увеличиваться как путем наращивания числа процессоров и объемов оперативной памяти в каждом узле кластера, так и посредством увеличения количества самих узлов.

Архитектура с общими дисками

Слайд 9Системы высокой готовности.

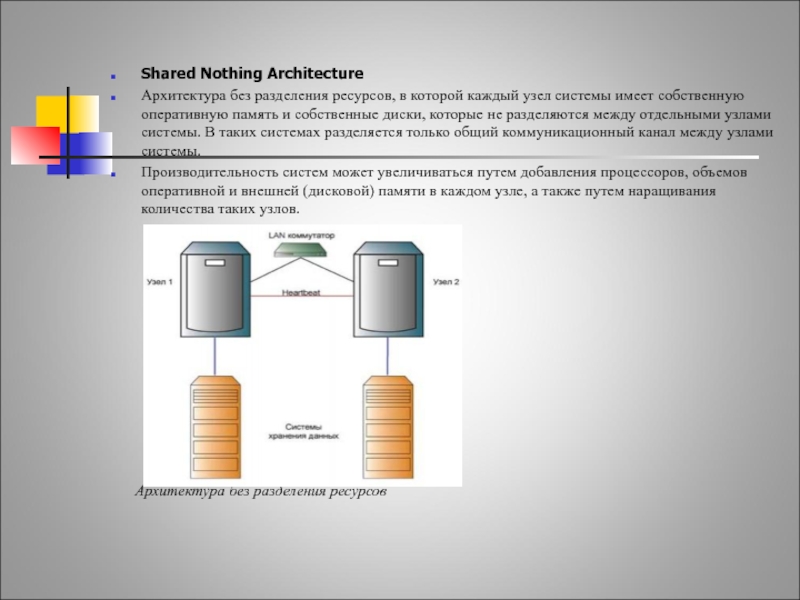

Shared Nothing Architecture

Архитектура без разделения ресурсов, в

которой каждый узел системы имеет собственную оперативную память и собственные

диски, которые не разделяются между отдельными узлами системы. В таких системах разделяется только общий коммуникационный канал между узлами системы.

Производительность систем может увеличиваться путем добавления процессоров, объемов оперативной и внешней (дисковой) памяти в каждом узле, а также путем наращивания количества таких узлов.

Архитектура без разделения ресурсов

Слайд 10Высокоскоростные системы.

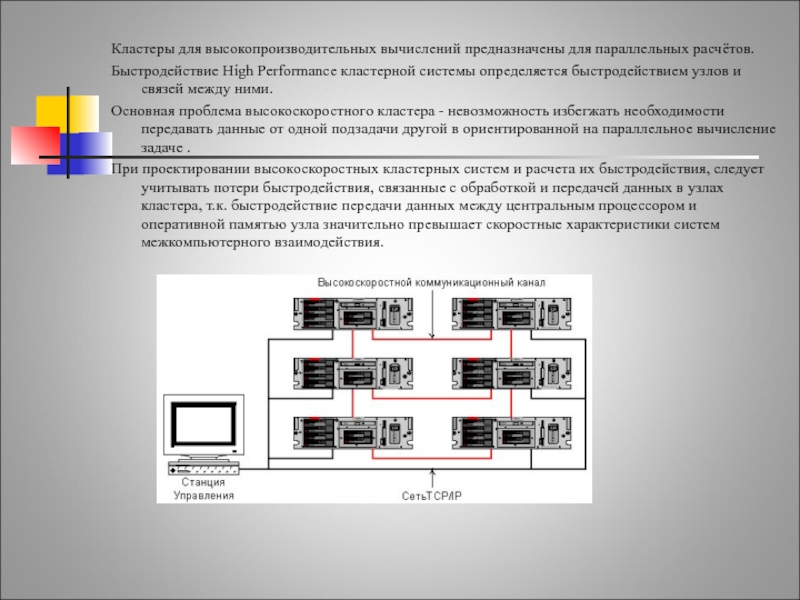

Кластеры для высокопроизводительных вычислений предназначены для параллельных расчётов.

Быстродействие High

Performance кластерной системы определяется быстродействием узлов и связей между ними.

Основная

проблема высокоскоростного кластера - невозможность избегжать необходимости передавать данные от одной подзадачи другой в ориентированной на параллельное вычисление задаче .

При проектировании высокоскоростных кластерных систем и расчета их быстродействия, следует учитывать потери быстродействия, связанные с обработкой и передачей данных в узлах кластера, т.к. быстродействие передачи данных между центральным процессором и оперативной памятью узла значительно превышает скоростные характеристики систем межкомпьютерного взаимодействия.

Слайд 11Проблемы выполнения сети связи процессоров в кластерной системе.

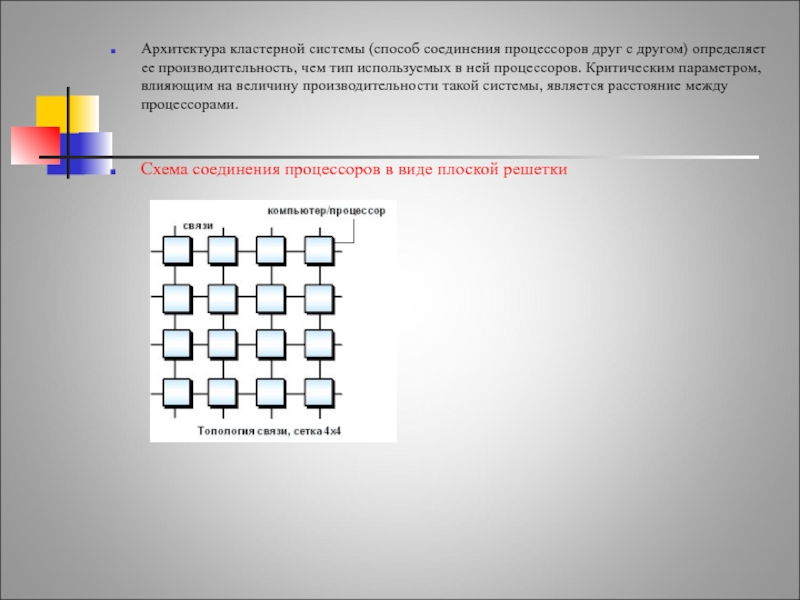

Архитектура кластерной системы

(способ соединения процессоров друг с другом) определяет ее производительность, чем

тип используемых в ней процессоров. Критическим параметром, влияющим на величину производительности такой системы, является расстояние между процессорами.

Схема соединения процессоров в виде плоской решетки

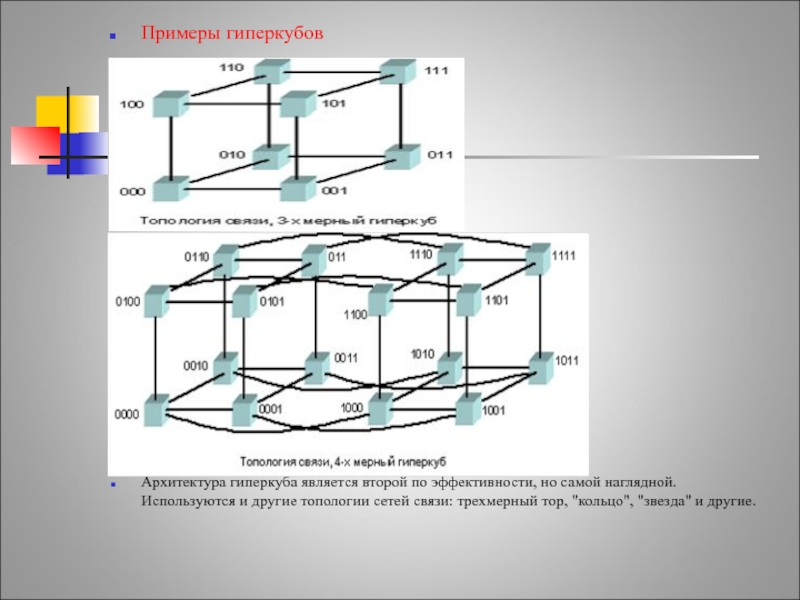

Слайд 12Примеры гиперкубов

Архитектура гиперкуба является второй по эффективности, но самой наглядной.

Используются и другие топологии сетей связи: трехмерный тор, "кольцо", "звезда"

и другие.

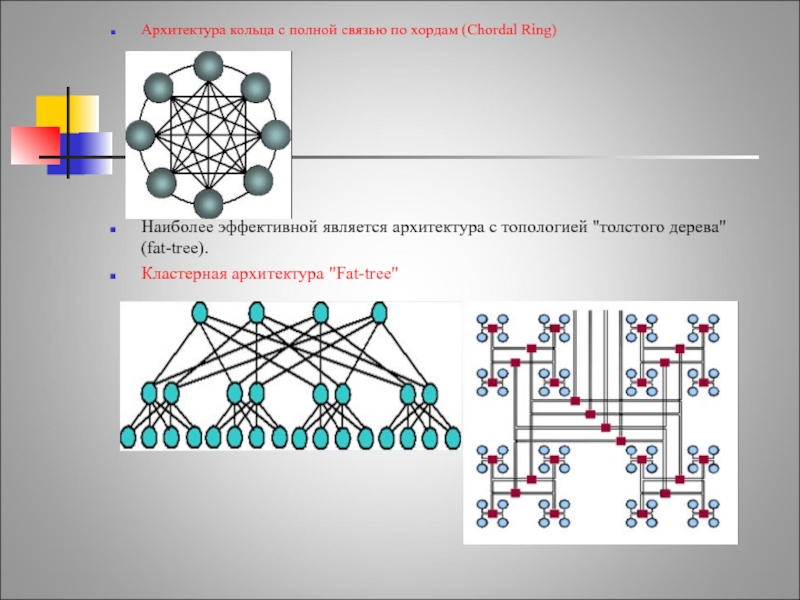

Слайд 13Архитектура кольца с полной связью по хордам (Chordal Ring)

Наиболее эффективной

является архитектура с топологией "толстого дерева" (fat-tree).

Кластерная архитектура "Fat-tree"

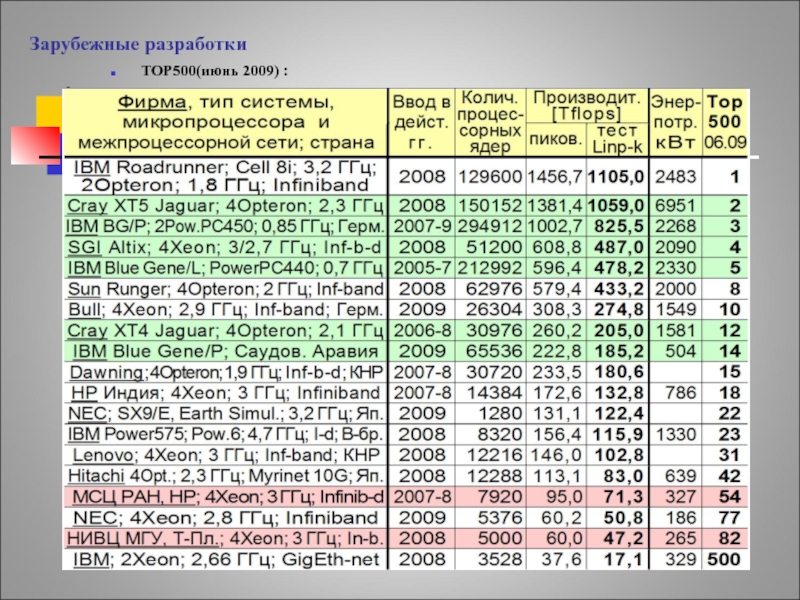

Слайд 14Зарубежные разработки

TOP500(июнь 2009) :

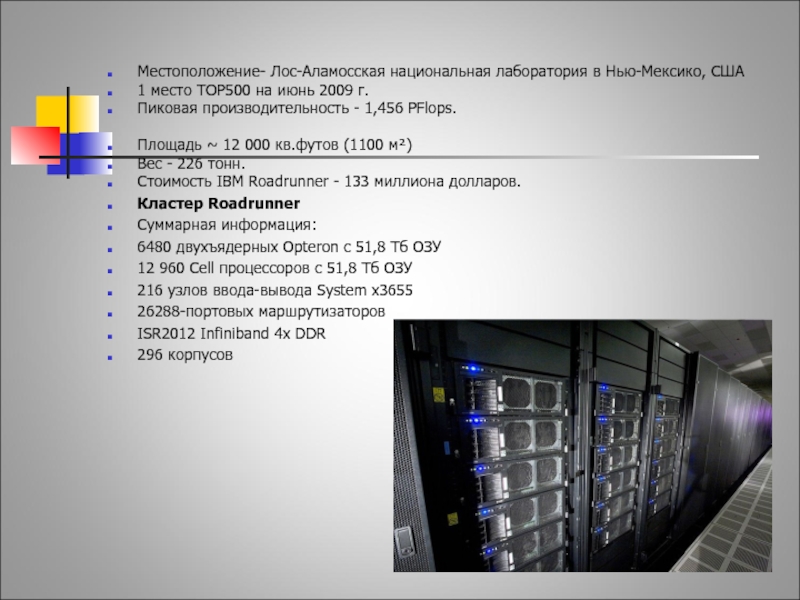

Слайд 15IBM-roadrunner

Местоположение- Лос-Аламосская национальная лаборатория в Нью-Мексико, США

1 место TOP500

на июнь 2009 г.

Пиковая производительность - 1,456 PFlops.

Площадь ~ 12 000

кв.футов (1100 м²)

Вес - 226 тонн.

Стоимость IBM Roadrunner - 133 миллиона долларов.

Кластер Roadrunner

Суммарная информация:

6480 двухъядерных Opteron с 51,8 Тб ОЗУ

12 960 Cell процессоров с 51,8 Тб ОЗУ

216 узлов ввода-вывода System x3655

26288-портовых маршрутизаторов

ISR2012 Infiniband 4x DDR

296 корпусов

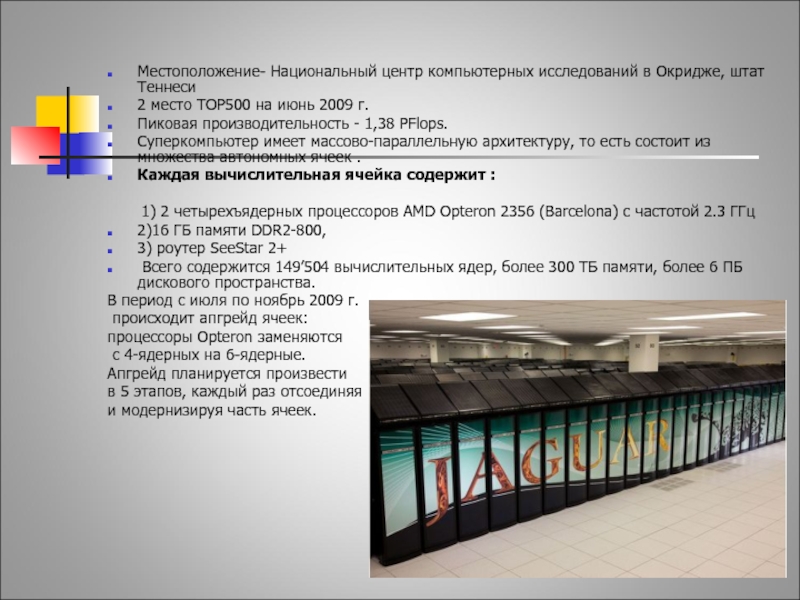

Слайд 16Cray Jaguar

Местоположение- Национальный центр компьютерных исследований в Окридже, штат

Теннеси

2 место TOP500 на июнь 2009 г.

Пиковая производительность - 1,38

PFlops.

Суперкомпьютер имеет массово-параллельную архитектуру, то есть состоит из множества автономных ячеек .

Каждая вычислительная ячейка содержит :

1) 2 четырехъядерных процессоров AMD Opteron 2356 (Barcelona) с частотой 2.3 ГГц

2)16 ГБ памяти DDR2-800,

3) роутер SeeStar 2+

Всего содержится 149’504 вычислительных ядер, более 300 ТБ памяти, более 6 ПБ дискового пространства.

В период с июля по ноябрь 2009 г.

происходит апгрейд ячеек:

процессоры Opteron заменяются

с 4-ядерных на 6-ядерные.

Апгрейд планируется произвести

в 5 этапов, каждый раз отсоединяя

и модернизируя часть ячеек.

Слайд 17Отечественные разработки

TOP500(июнь 2009) :

СНГ — Тор50(июнь 2009):

1. МВС-100K (МСЦ РАН,НP)

– 54 позиция ТОП500

2. СКИФ МГУ - 82 позиция ТОП500

Слайд 18МВС-100K

Пиковая производительность - 95,04 TFlops.

Технические средства "МВС-100K":

990 вычислительных модулей (7920 процессорных ядер)

Вычислительный модуль

4-х процессорный сервер HP Proliant :

1. 2 4-х микропроцессора Intel Xeon, работающих на частоте 3 ГГц;

2. оперативную память DDR2 > 4 ГБайт;

3. жёсткий диск объёмом > 36 ГБайт;

4. интерфейсная плата HP Mezzanine Infiniband DDR;

5. два интегрированных контроллера Gigabit Ethernet.

управляющая станция и узел доступа на

базе двух процессоров Intel Xeon;

коммуникационная сеть Infiniband DDR,

построенная с использованием коммутаторов

Voltaire и Cisco;

транспортная сеть Gigabit Ethernet;

управляющая сеть Gigabit Ethernet;

системная консоль;

Слайд 19СКИФ МГУ

июнь 2008 -1-ое место ТОП 50

июнь 2009 -2-ое место

совместная

разработка МГУ, Института программных систем (ИПС) РАН и компании «Т-Платформы»

.

является 7-м по мощности среди всех суперкомпьютеров, использующихся в мировой системе образования.

Общая стоимость проекта - 231 млн. руб.

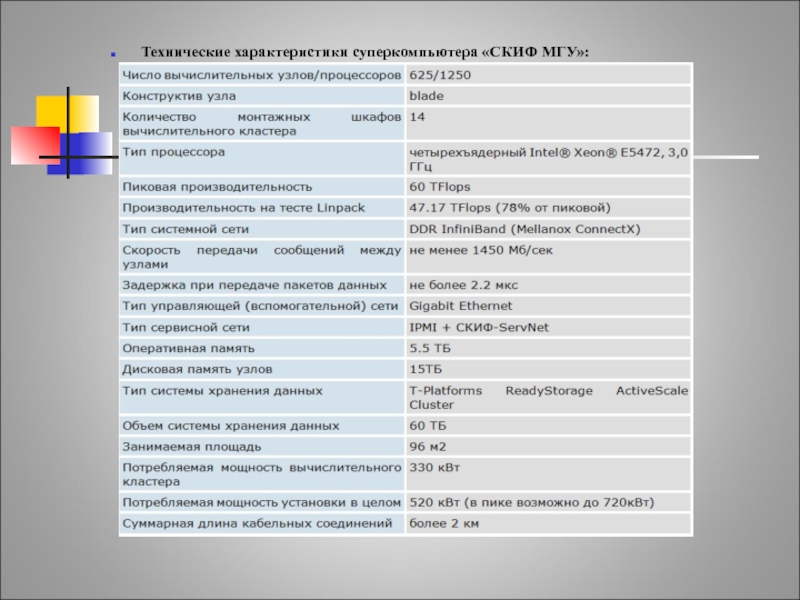

Слайд 20СКИФ МГУ

Технические характеристики суперкомпьютера «СКИФ МГУ»:

Слайд 21Отечественные разработки

На данный момент в России

42 установки с производительностью > 1 TFLOPS.

Для попадания в список Тоp50 теперь требуется производительность в тесте Linpack не менее 432 GFLOPS.

Cистем в списке ТОП50 :

Intel - 38

AMD -6

IBM-5

HP-1