Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Машинное обучение. Нейронные сети

Содержание

- 1. Машинное обучение. Нейронные сети

- 2. Слайд 2

- 3. Слайд 3

- 4. Слайд 4

- 5. Слайд 5

- 6. Нейронные сетиМодель ЦНСЛинейная функция с нелинейным «принятием решения»Удобное метод «подбора» коэффициентов линейной функцииУдобный инструмент обучения

- 7. НС. ПрименениеГибкая модель для аппроксимации многомерных функций.Средство

- 8. НС. Базисы1) ЦНС высших млекопитающих состоит из

- 9. НС. Базисы2) Концепция обучения.В процессе обучения с

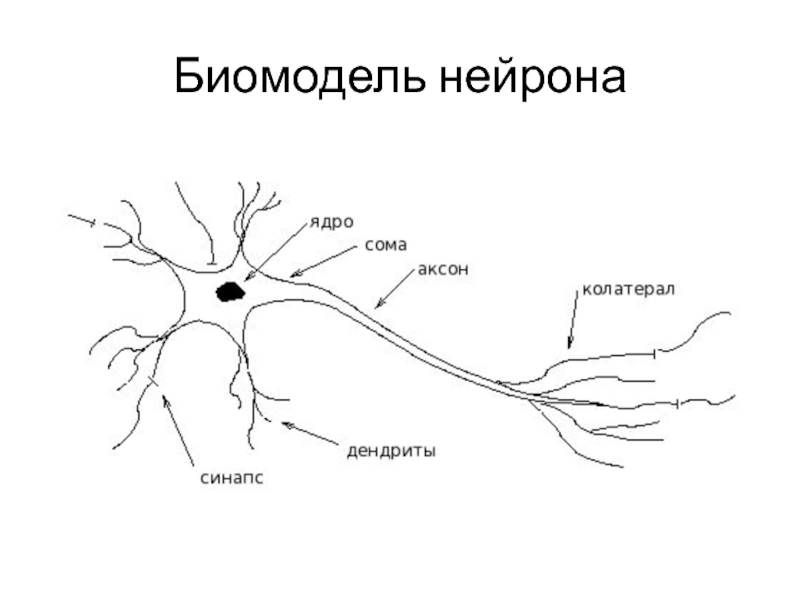

- 10. Биомодель нейрона

- 11. Слайд 11

- 12. Слайд 12

- 13. Слайд 13

- 14. Слайд 14

- 15. Функции активацииЖесткая ступенька

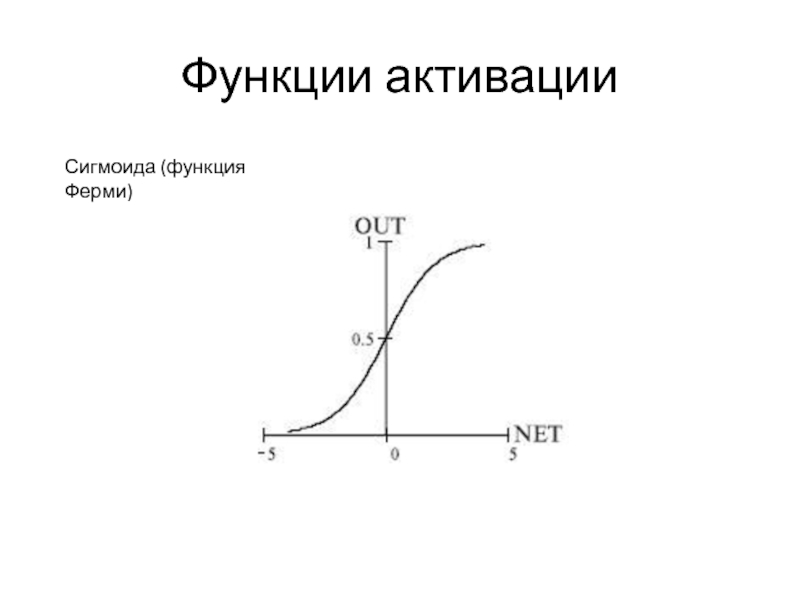

- 16. Функции активацииСигмоида (функция Ферми)

- 17. Функции активацииГиперболический тангенс

- 18. Функции активацииSOFTMAX

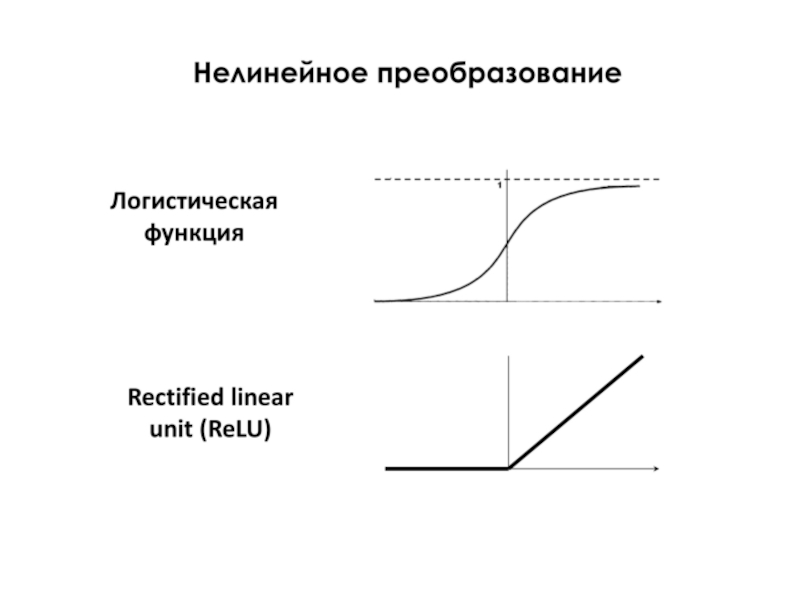

- 19. Функции активации

- 20. НС. ОграниченияВычисления нейрона происходят мгновенно, не внося

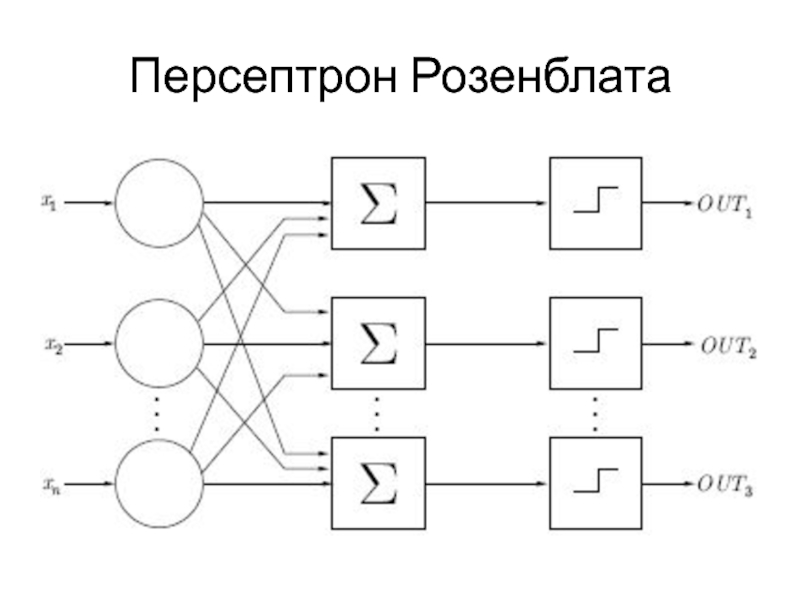

- 21. Персептрон Розенблата

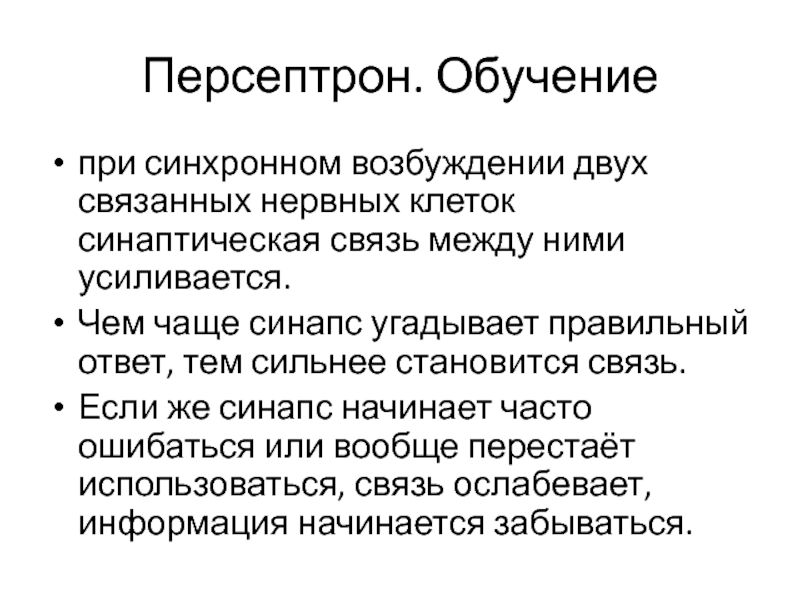

- 22. Персептрон. Обучениепри синхронном возбуждении двух связанных нервных

- 23. Персептрон. ОбучениеПеред началом обучения вектор весов некоторым

- 24. Персептрон. Обучение

- 25. Персептрон. ОбучениеПусть классы помечены числами −1 и

- 26. Персептрон. Обучение

- 27. Персептрон. Логическое ИЛИ

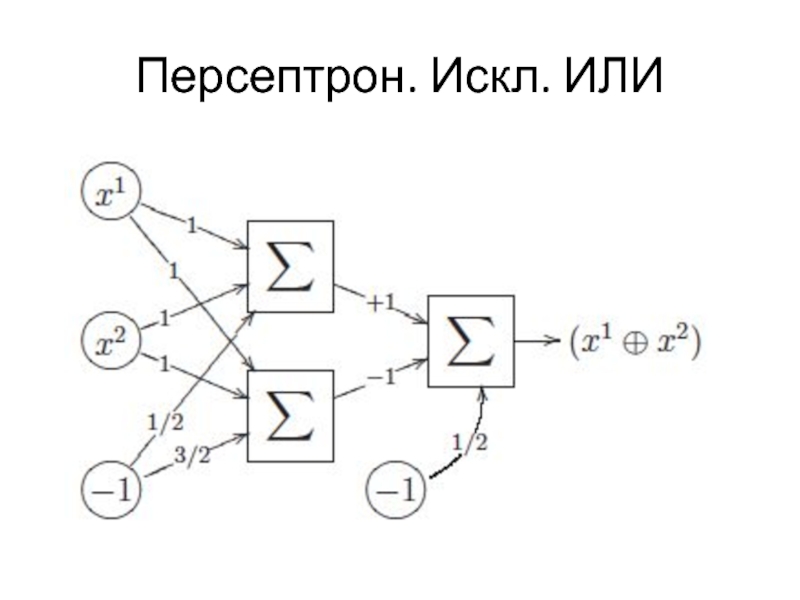

- 28. Персептрон. Искл. ИЛИ

- 29. Многослойный персептрон

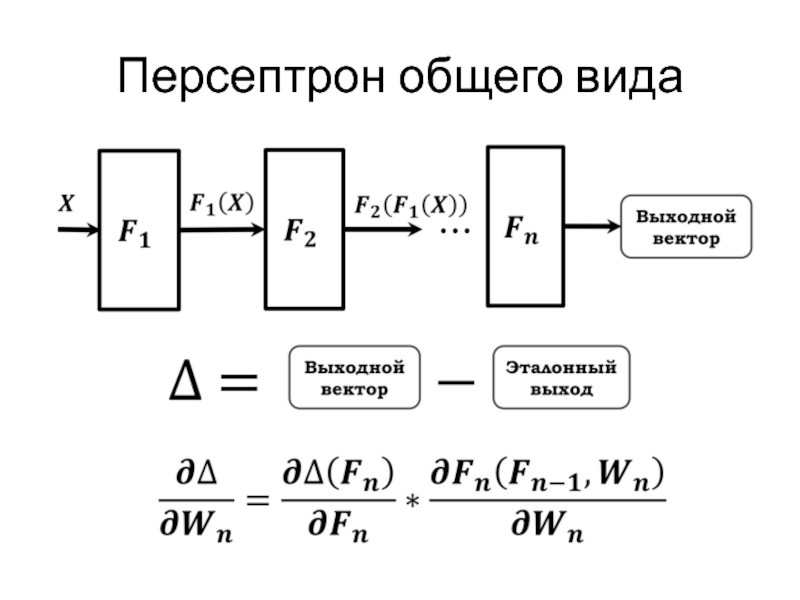

- 30. Персептрон общего вида

- 31. Скачать презентанцию

Нейронные сетиМодель ЦНСЛинейная функция с нелинейным «принятием решения»Удобное метод «подбора» коэффициентов линейной функцииУдобный инструмент обучения

Слайды и текст этой презентации

Слайд 6Нейронные сети

Модель ЦНС

Линейная функция с нелинейным «принятием решения»

Удобное метод «подбора»

коэффициентов линейной функции

Слайд 7НС. Применение

Гибкая модель для аппроксимации многомерных функций.

Средство прогнозирования во времени

процессов, зависящих от большого количества переменных.

Средство распознавания образов

Инструмент для поиска

по ассоциациямМодель для поиска закономерностей в массивах данных

Слайд 8НС. Базисы

1) ЦНС высших млекопитающих состоит из клеток — нейрон

связанных друг с другом из всевозможными клетками рецепторами (зрительные, слуховые,

тд). Общее количество таких клеток порядка 10^10.Связь между нейронами осуществляется с помощью контактов — сИнапсы.

Сила связи между двумя нейронами пропорциональна концентрации вещества — нейромедиатор.

Деятельность головного мозга высших млекопитающих представляет собой пребывание в возбуждённом состоянии.

Нейрон становиться активным, тогда. когда количество активных нейронов связанных синапсами превышает определенный порог.

Слайд 9НС. Базисы

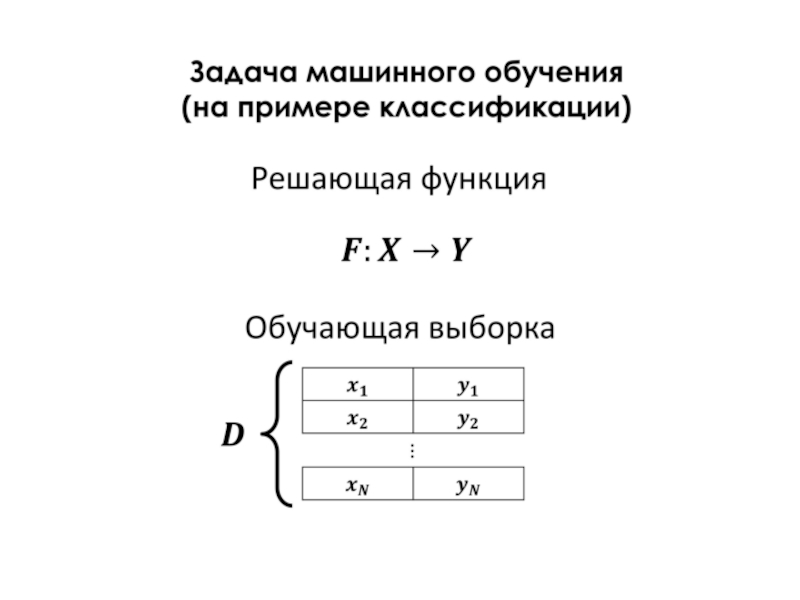

2) Концепция обучения.

В процессе обучения с помощью резких внешних

стимулов существенно корректируется картина мира записанная в голове.

Таким образом для

осуществления обучения мы должны иметь набор векторов характеризующих картину мира и все возможные реакции на нашу действительность.Такой набор векторов получил название — обучающая выборка.

Чем более адекватная картина мира записанная в нейронах головного мозга, тем меньше истинная реакция окружающей среды будет отличаться от реакции предсказания.

С нейрофизиологической точки зрение обучение может происходить двояко, это отмирание связей и изменение силы связи.

Слайд 20НС. Ограничения

Вычисления нейрона происходят мгновенно, не внося задержку.

Нет четких алгоритмов

для выбора функции активации.

Нет механизмов регулирующих работу сети в целом,

на подобии гормональной регуляции активности в нервных клетках.Модель формального нейрона не является биоподобной и это скорее математическая абстракция.

Слайд 22Персептрон. Обучение

при синхронном возбуждении двух связанных нервных клеток синаптическая связь

между ними усиливается.

Чем чаще синапс угадывает правильный ответ, тем

сильнее становится связь. Если же синапс начинает часто ошибаться или вообще перестаёт использоваться, связь ослабевает, информация начинается забываться.

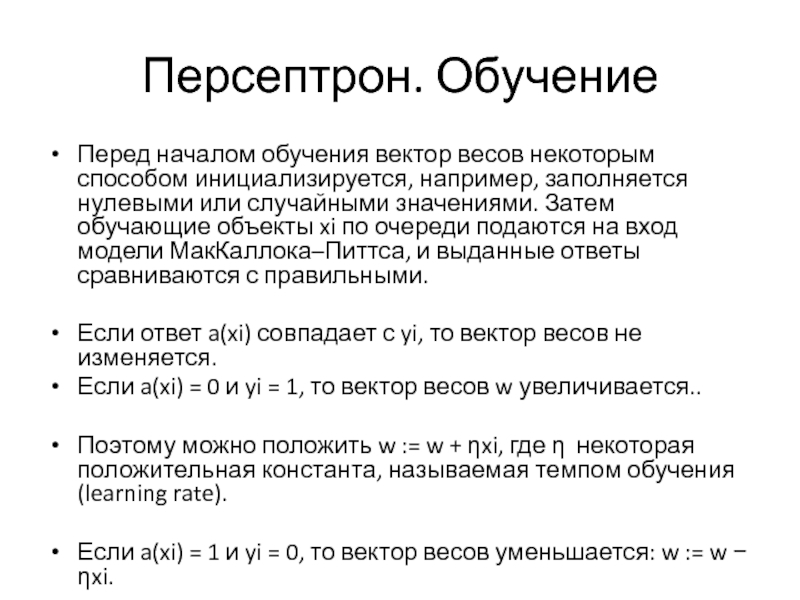

Слайд 23Персептрон. Обучение

Перед началом обучения вектор весов некоторым способом инициализируется, например,

заполняется нулевыми или случайными значениями. Затем обучающие объекты xi по

очереди подаются на вход модели МакКаллока–Питтса, и выданные ответы сравниваются с правильными.Если ответ a(xi) совпадает с yi, то вектор весов не изменяется.

Если a(xi) = 0 и yi = 1, то вектор весов w увеличивается..

Поэтому можно положить w := w + ηxi, где η некоторая положительная константа, называемая темпом обучения (learning rate).

Если a(xi) = 1 и yi = 0, то вектор весов уменьшается: w := w − ηxi.