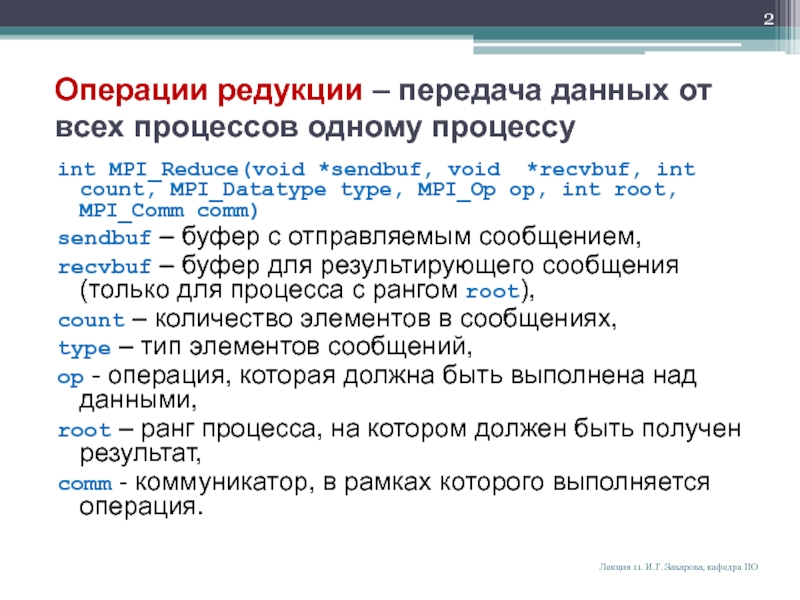

MPI_Reduce(void *sendbuf, void *recvbuf, int count, MPI_Datatype type, MPI_Op op,

int root, MPI_Comm comm)sendbuf – буфер с отправляемым сообщением,

recvbuf – буфер для результирующего сообщения (только для процесса с рангом root),

count – количество элементов в сообщениях,

type – тип элементов сообщений,

op - операция, которая должна быть выполнена над данными,

root – ранг процесса, на котором должен быть получен результат,

comm - коммуникатор, в рамках которого выполняется операция.

Лекция 11. И.Г. Захарова, кафедра ПО

![Презентация на тему Примерstatic long num_steps = 100000; void main (int argc, char *argv[]) { int i, my_id, numprocs; double x, pi, step, sum = 0.0 ; step = 1.0/(double) num_steps ; MPI_Init(&argc, &argv) ; MPI_Comm_Rank(MPI_COMM_WORLD, &my_id) ; MPI_Comm_Size(MPI_COMM_WORLD, &numprocs) ; for (i=my_id+1; i Примерstatic long num_steps = 100000; void main (int argc, char *argv[]) { int i, my_id, numprocs; double x, pi, step, sum = 0.0 ; step = 1.0/(double) num_steps ; MPI_Init(&argc, &argv) ; MPI_Comm_Rank(MPI_COMM_WORLD, &my_id) ; MPI_Comm_Size(MPI_COMM_WORLD, &numprocs) ; for (i=my_id+1; i](/img/thumbs/3b4bf96f1d6510c9c9ef15e7f272dbc9-800x.jpg)