Разделы презентаций

- Разное

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

компьютерное распознавание и машинное обучение

Содержание

- 1. компьютерное распознавание и машинное обучение

- 2. Содержание курса «Компьютерные методы обработки информации»

- 3. Содержание лекции Обучение с учителем. Пространство признаков.

- 4. Обучение с учителем Компоненты задачи: пространство объектов

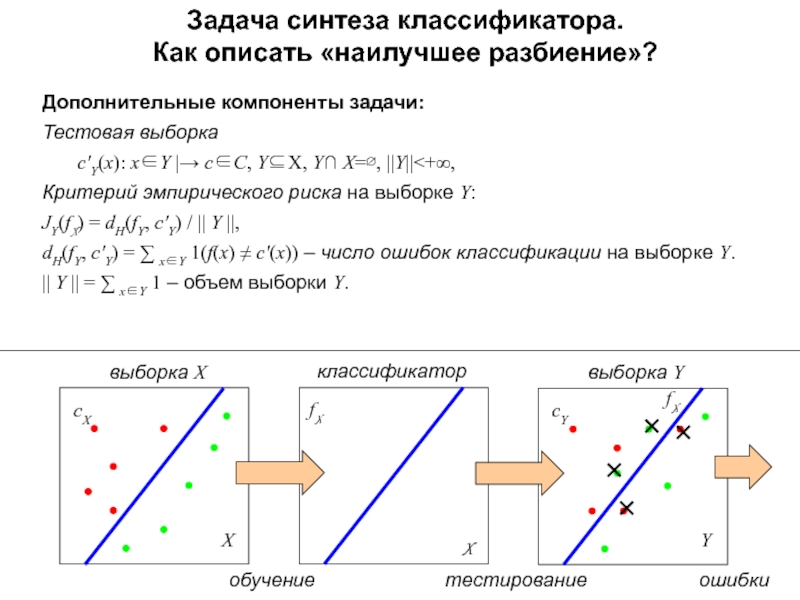

- 5. Задача синтеза классификатора. Как описать «наилучшее разбиение»?

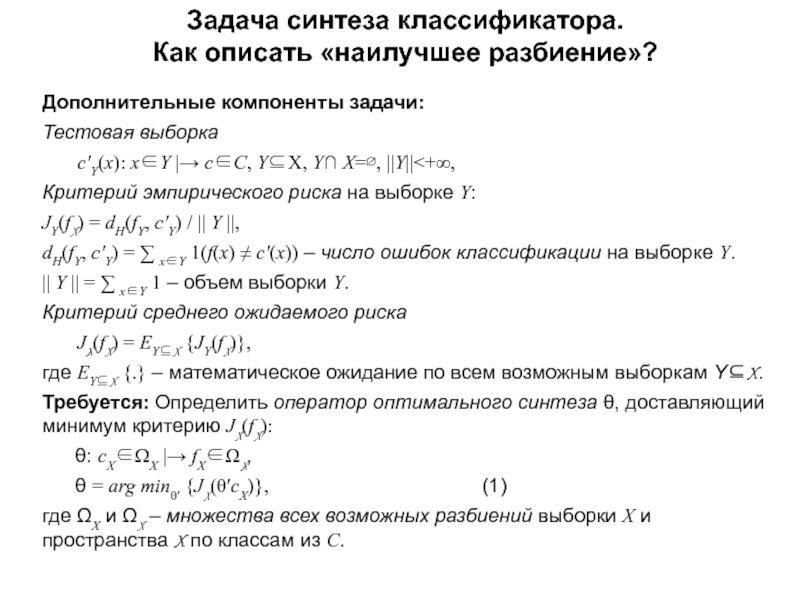

- 6. Задача синтеза классификатора. Как описать «наилучшее разбиение»?

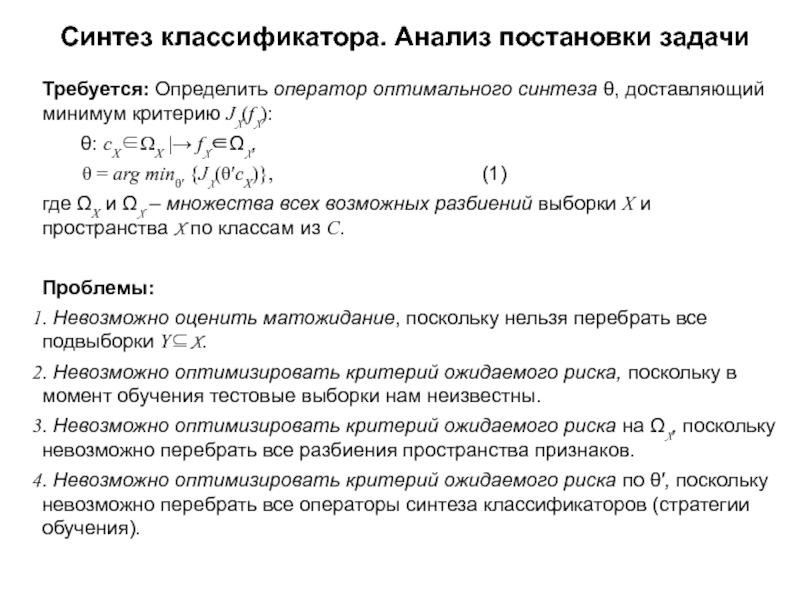

- 7. Синтез классификатора. Анализ постановки задачи Требуется: Определить

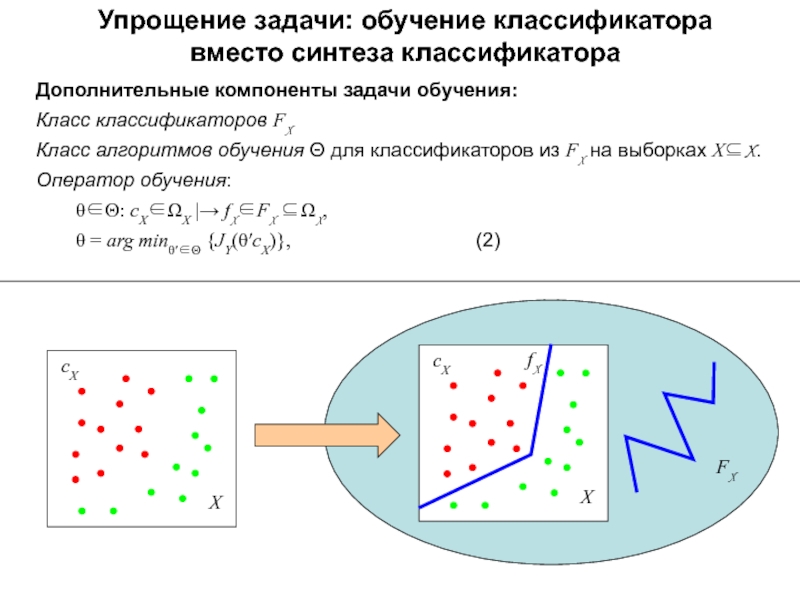

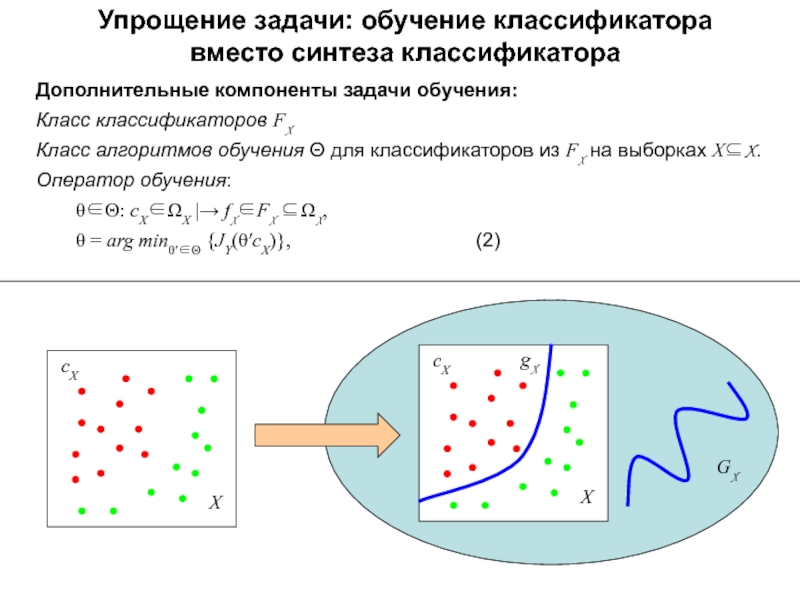

- 8. Упрощение задачи: обучение классификатора вместо синтеза классификатора

- 9. Упрощение задачи: обучение классификатора вместо синтеза классификатора

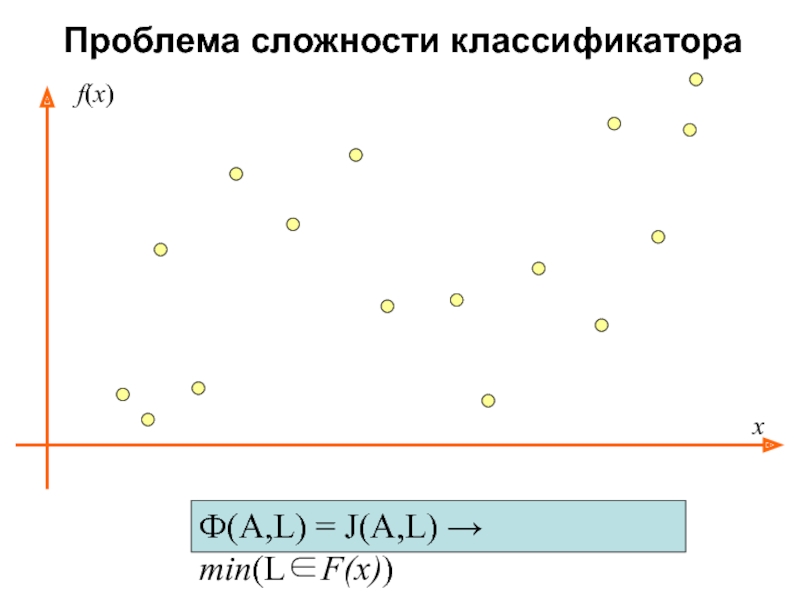

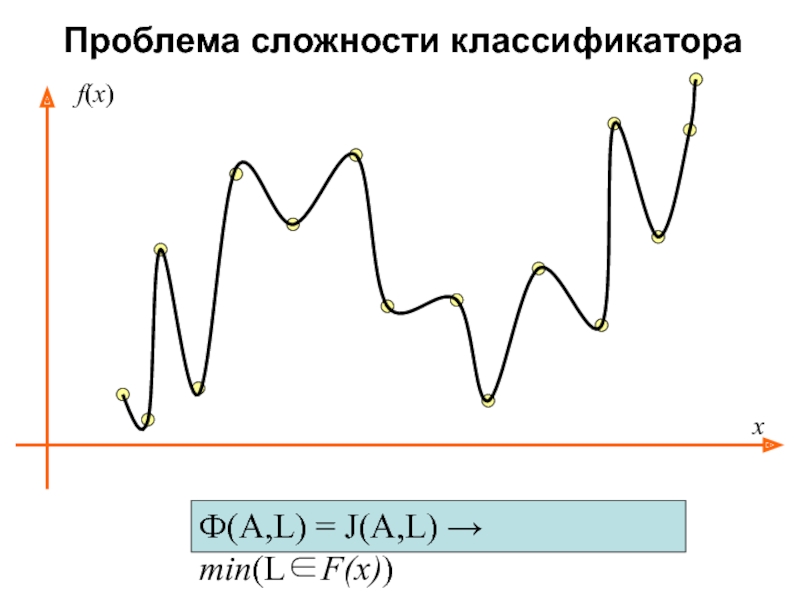

- 10. Проблема сложности классификатора Ф(A,L) = J(A,L) → min(L∈F(x))xf(x)

- 11. Проблема сложности классификатораФ(A,L) = J(A,L) → min(L∈F(x))xf(x)

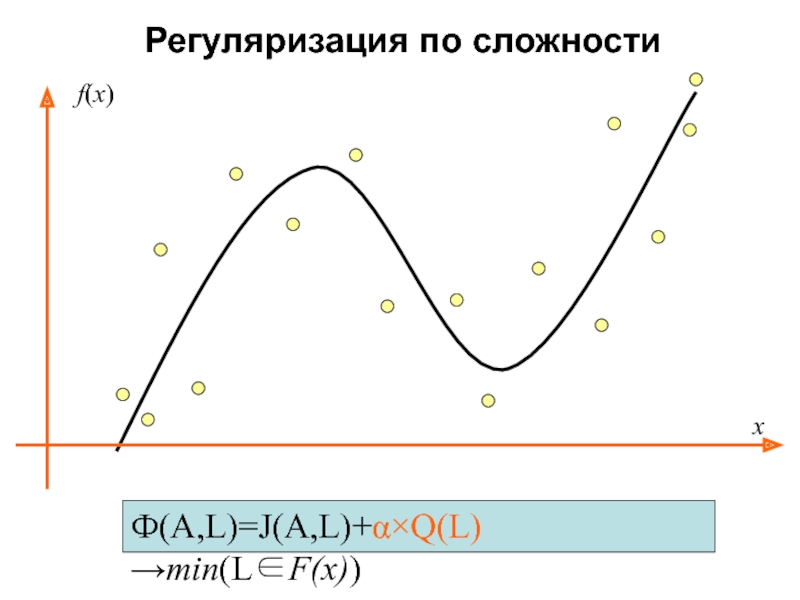

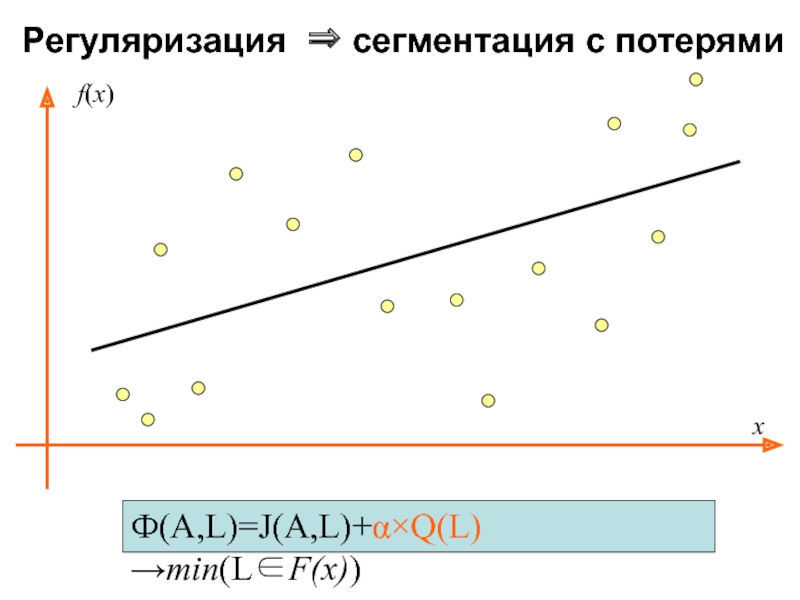

- 12. Регуляризация по сложности Ф(A,L)=J(A,L)+α×Q(L)→min(L∈F(x))xf(x)

- 13. Регуляризация ⇒ сегментация с потерями Ф(A,L)=J(A,L)+α×Q(L)→min(L∈F(x))xf(x)

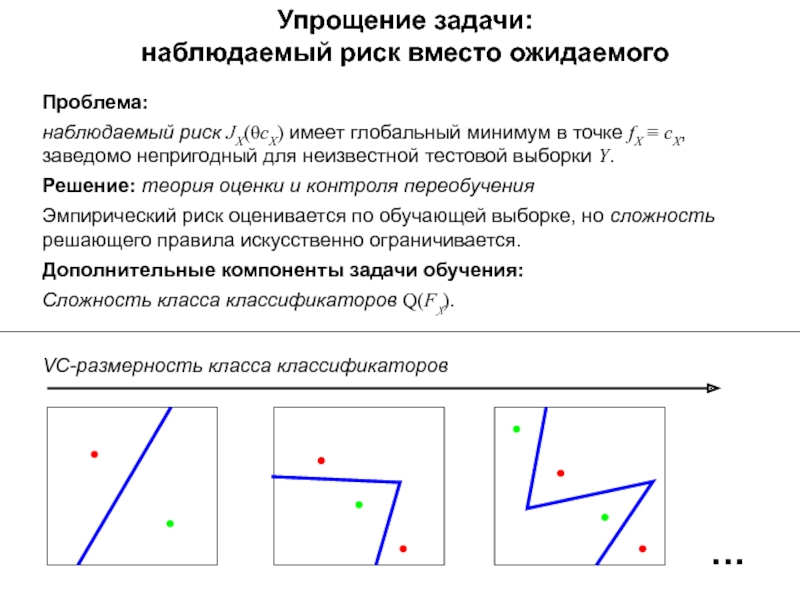

- 14. Упрощение задачи: наблюдаемый риск вместо ожидаемого Проблема:наблюдаемый

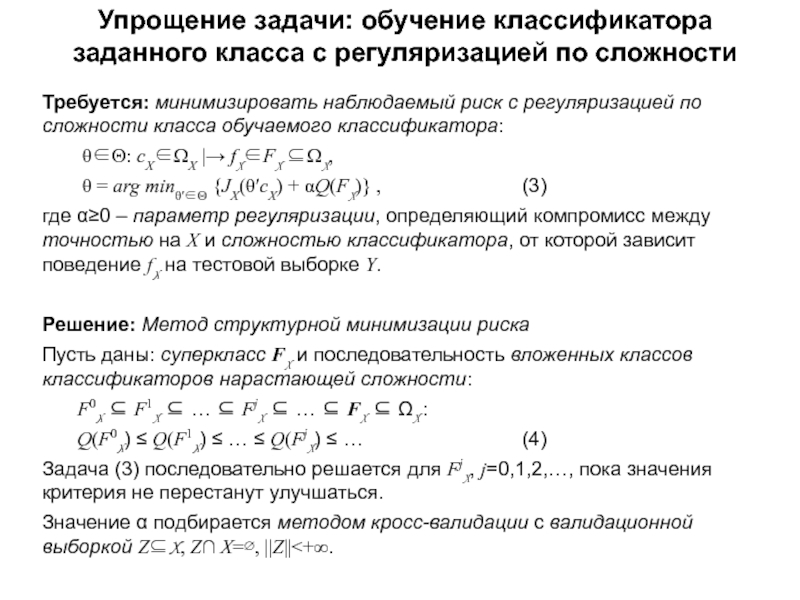

- 15. Упрощение задачи: обучение классификатора заданного класса с

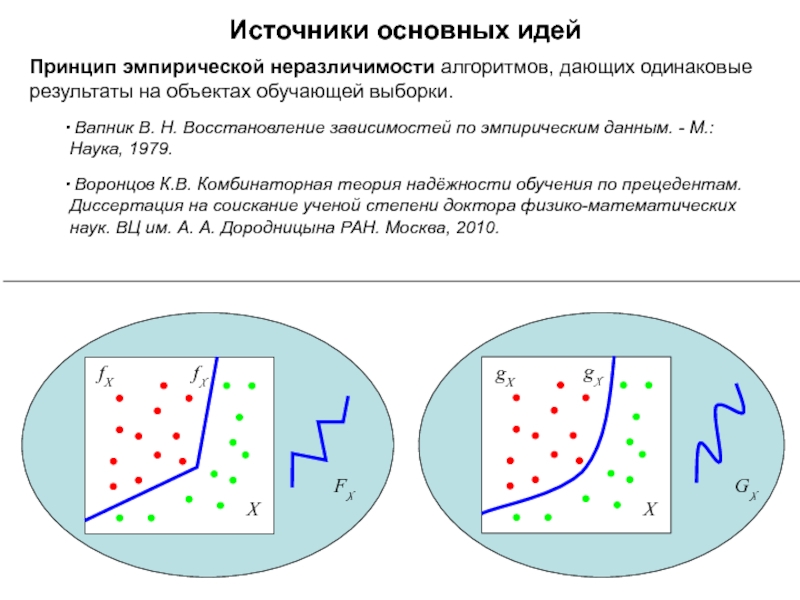

- 16. GXИсточники основных идейПринцип эмпирической неразличимости алгоритмов, дающих

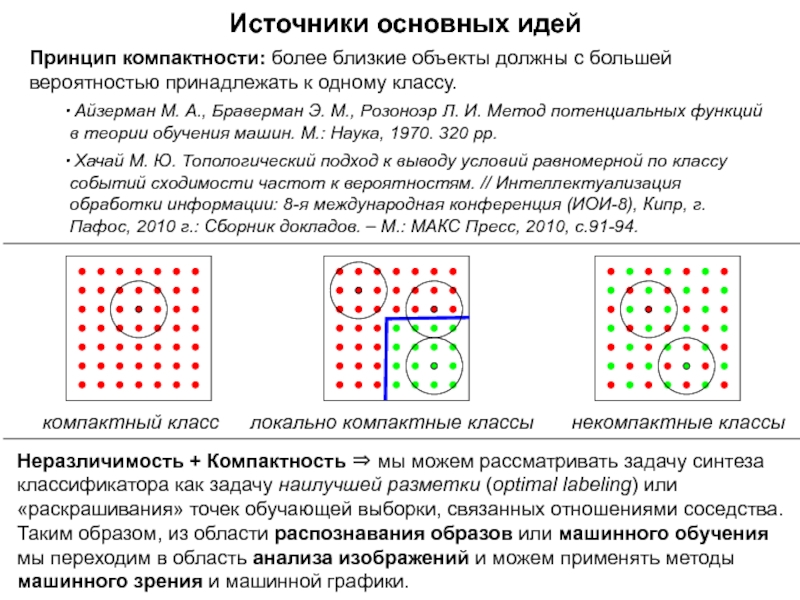

- 17. Источники основных идейПринцип компактности: более близкие объекты

- 18. Слайд 18

- 19. Слайд 19

- 20. Источники основных идейсXfXВозможность 01Возможность 10случайные опытыдетерминированная возможность

- 21. Следующие несколько разделов мы изучаем по книге

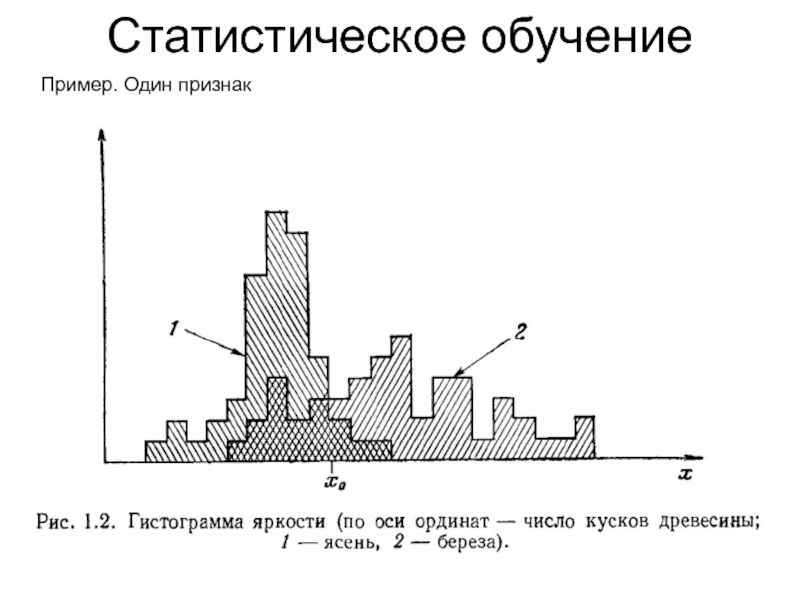

- 22. Статистическое обучение Пример. Один признак

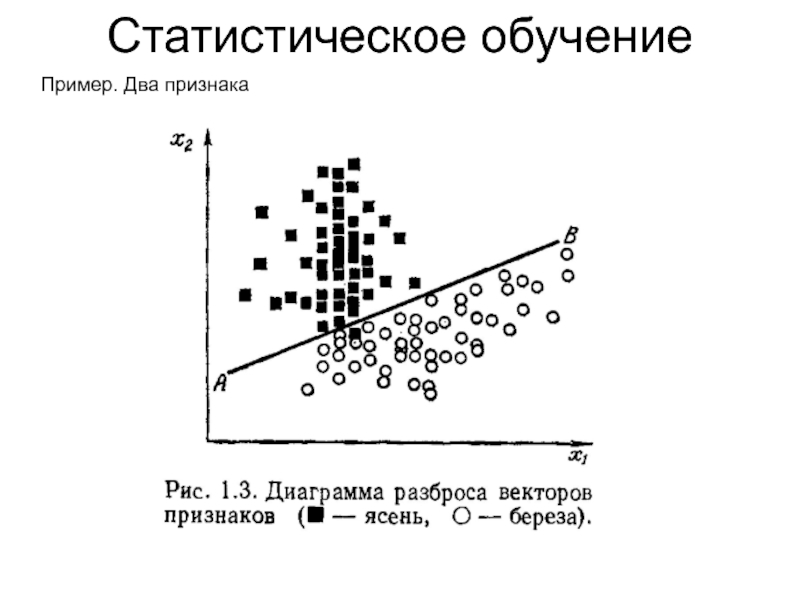

- 23. Статистическое обучение Пример. Два признака

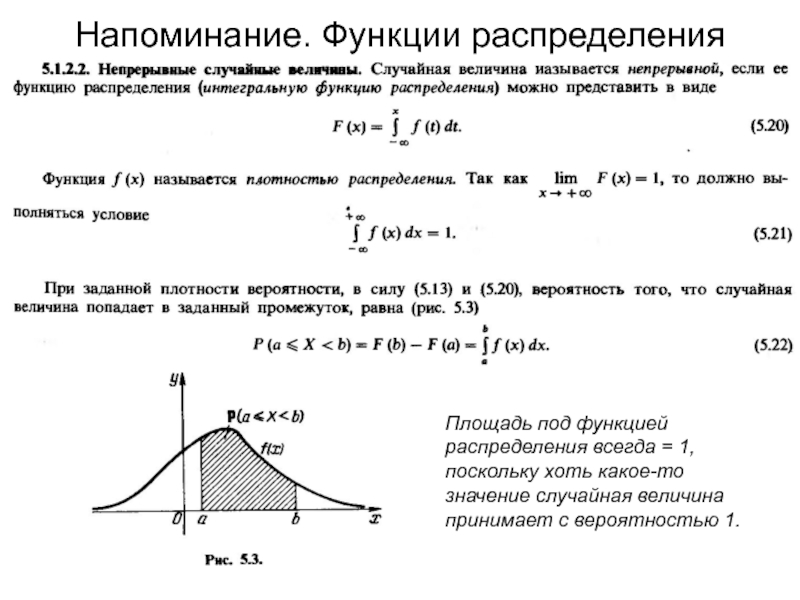

- 24. Напоминание. Функции распределения Площадь под функцией распределения

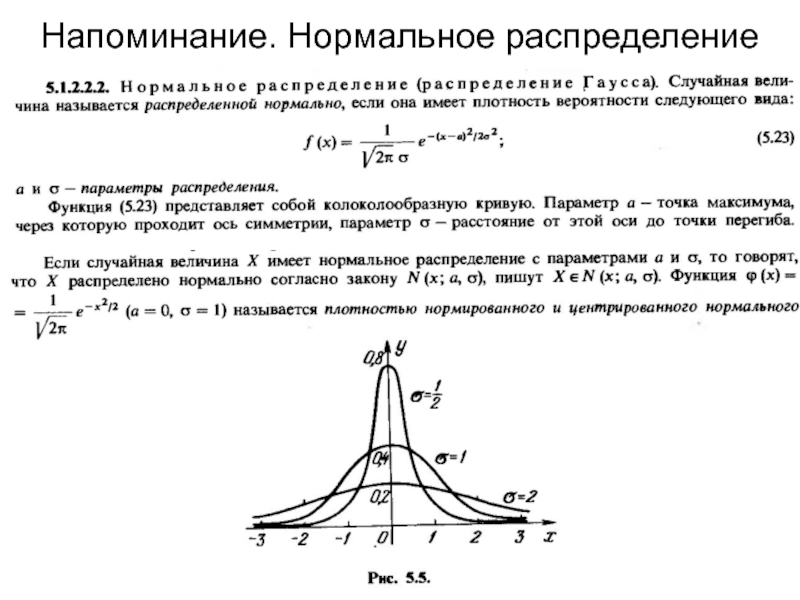

- 25. Напоминание. Нормальное распределение

- 26. Статистическое обучение Плотности распределения и случайные выборки

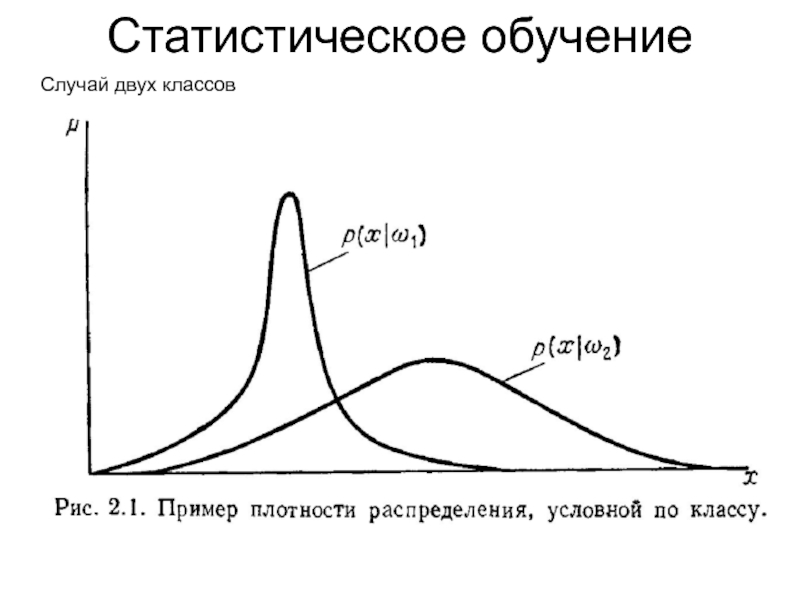

- 27. Статистическое обучение Случай двух классов

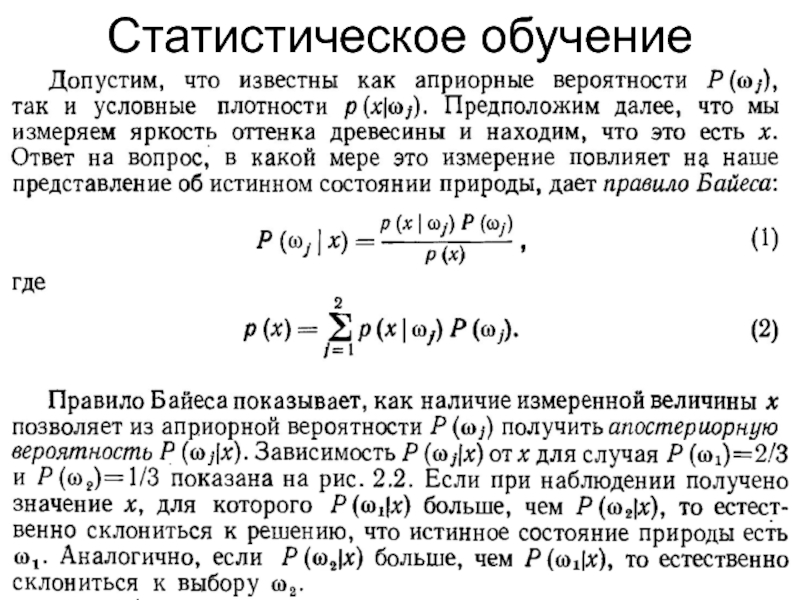

- 28. Статистическое обучение Случай двух классов

- 29. Статистическое обучение Случай двух классов. Ошибки 1 и 2 рода

- 30. Статистическое обучение

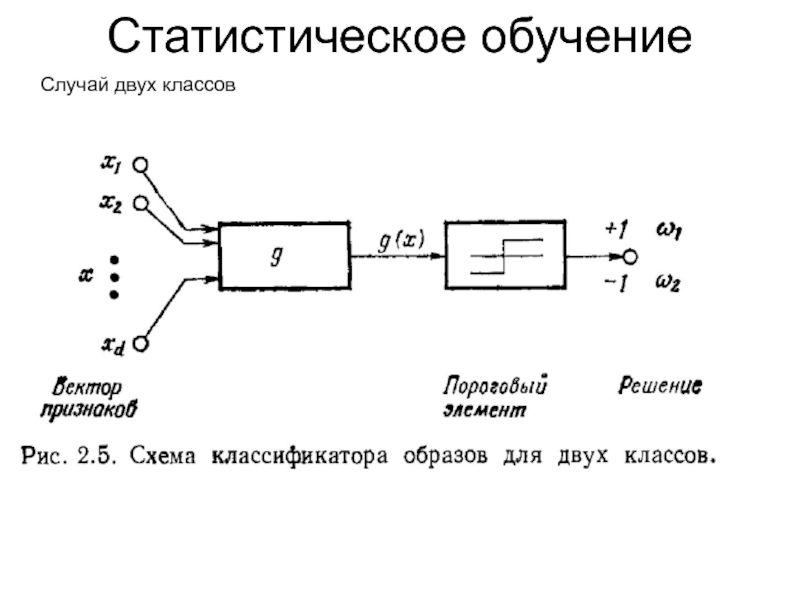

- 31. Статистическое обучение Случай двух классов

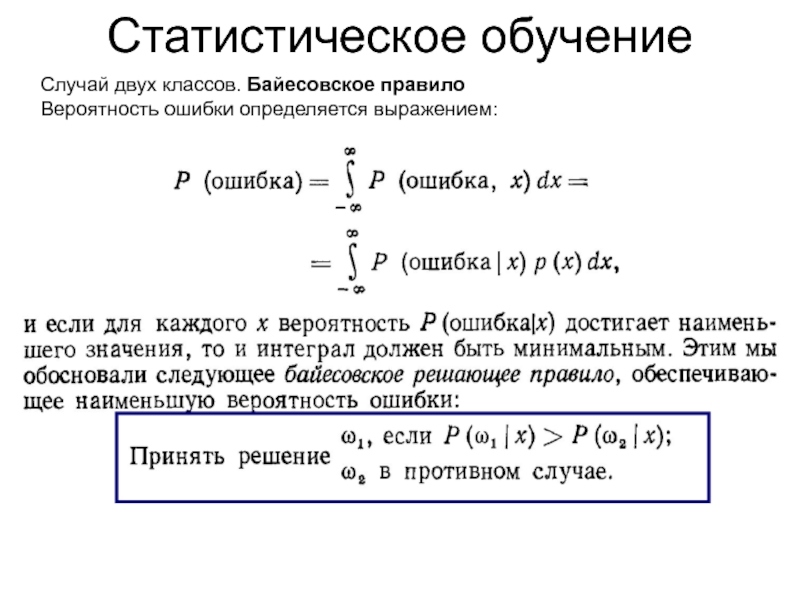

- 32. Статистическое обучение Случай двух классов. Байесовское правилоВероятность ошибки определяется выражением:

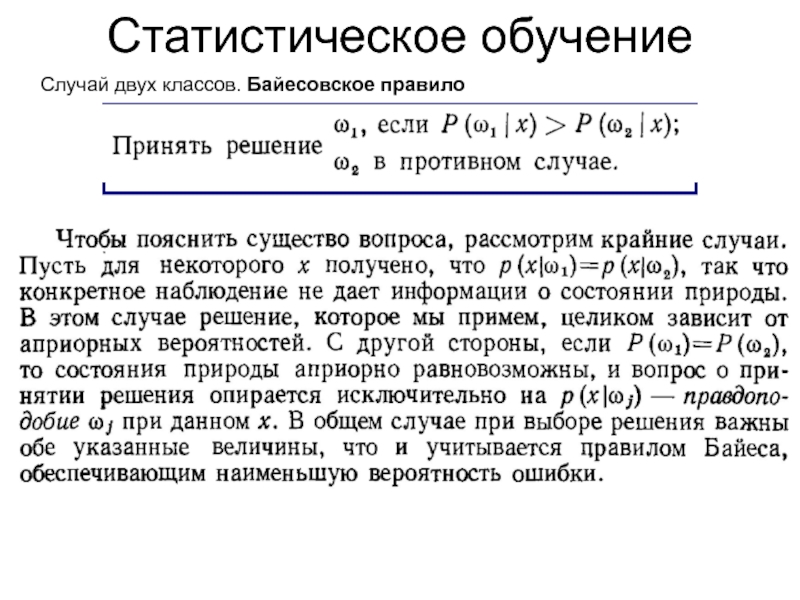

- 33. Статистическое обучение Случай двух классов. Байесовское правило

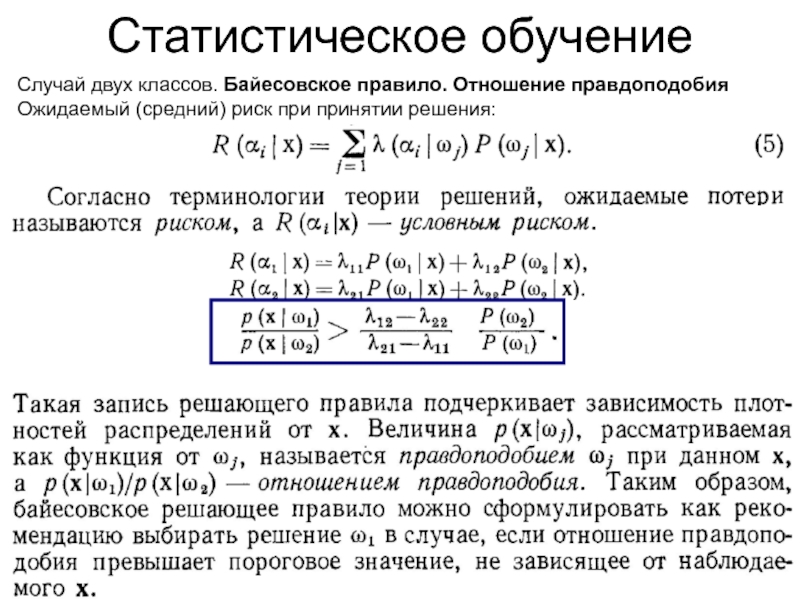

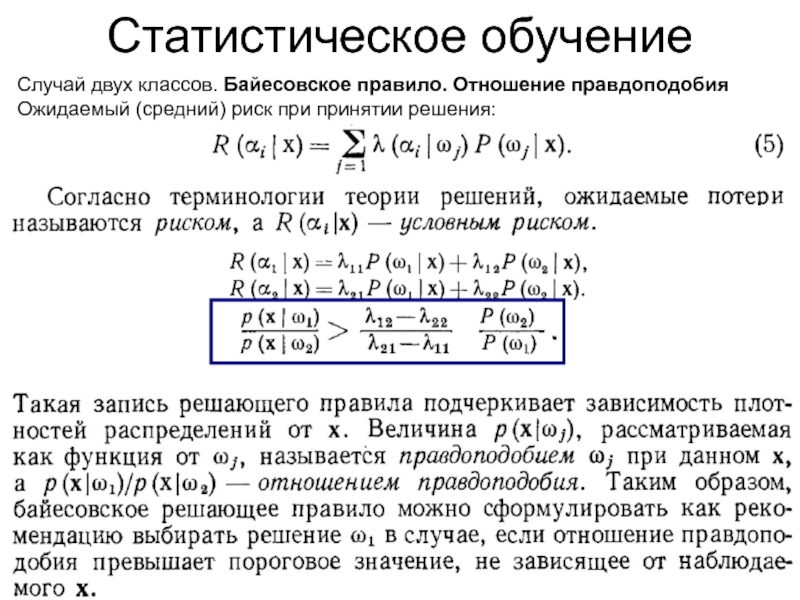

- 34. Статистическое обучение Случай двух классов. Байесовское правило. Отношение правдоподобияОжидаемый (средний) риск при принятии решения:

- 35. Статистическое обучение Случай двух классов. Байесовское правило. Отношение правдоподобияОжидаемый (средний) риск при принятии решения:

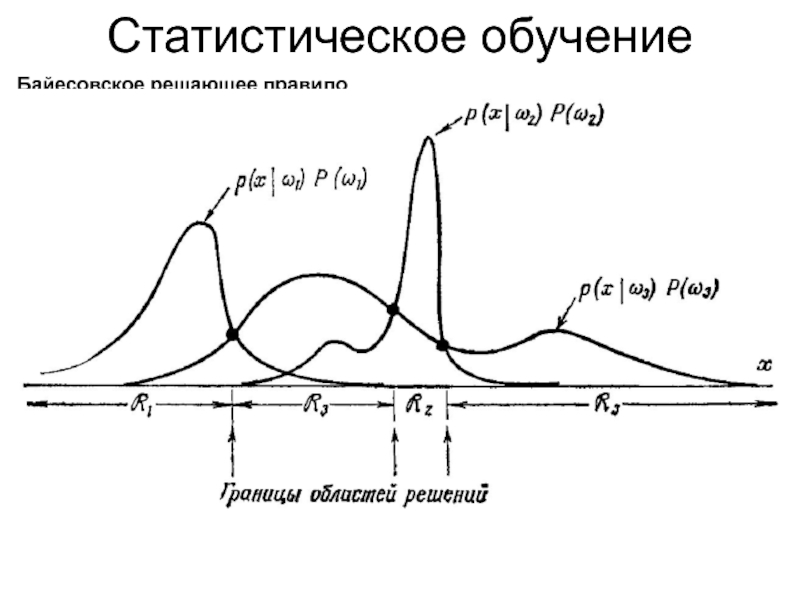

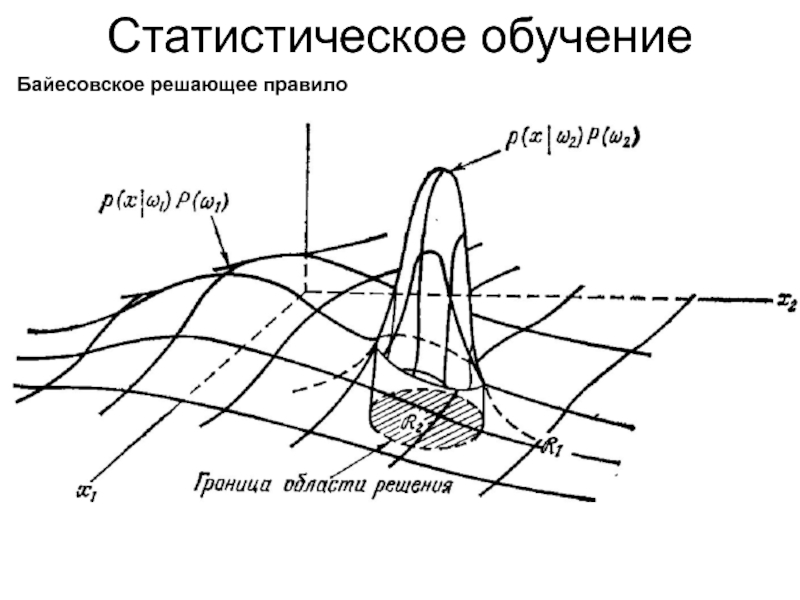

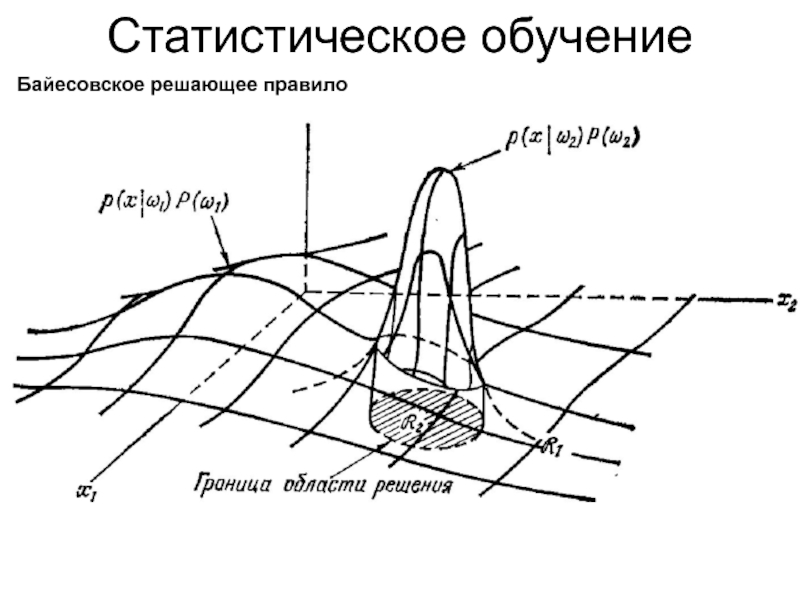

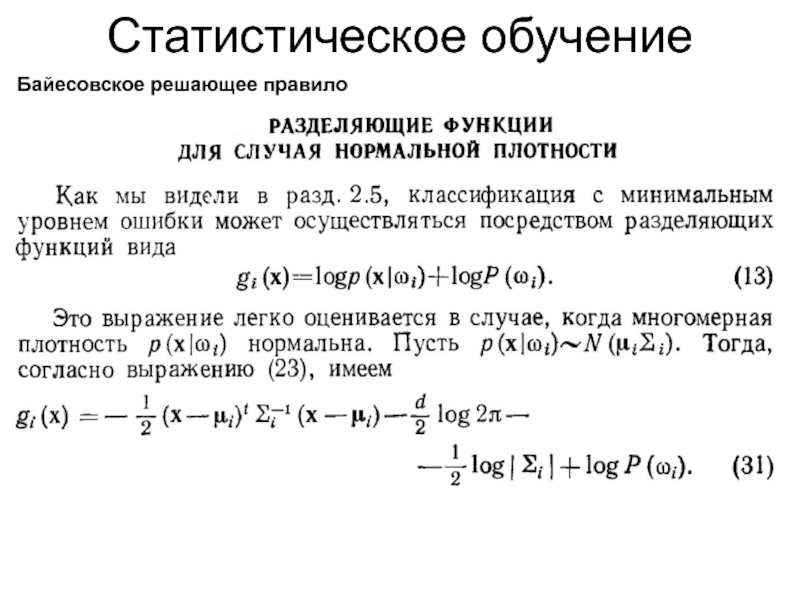

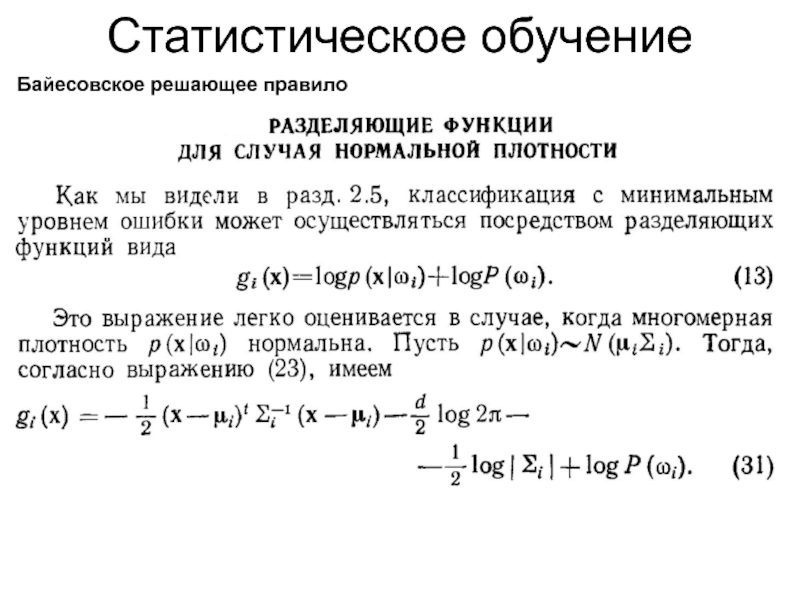

- 36. Статистическое обучение Байесовское решающее правило

- 37. Статистическое обучение Байесовское решающее правило

- 38. Статистическое обучение Байесовское решающее правило

- 39. Статистическое обучение Байесовское решающее правило

- 40. Статистическое обучение Байесовское решающее правило

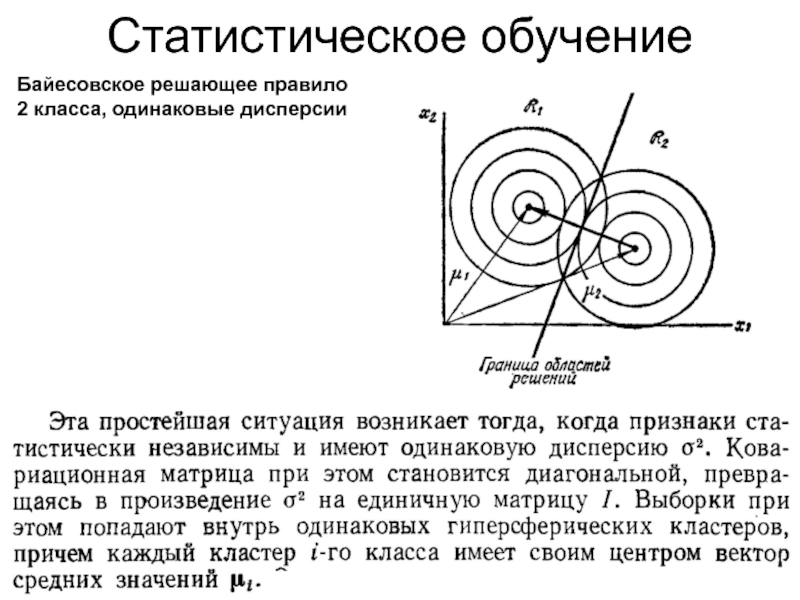

- 41. Статистическое обучение Байесовское решающее правило2 класса, одинаковые дисперсии

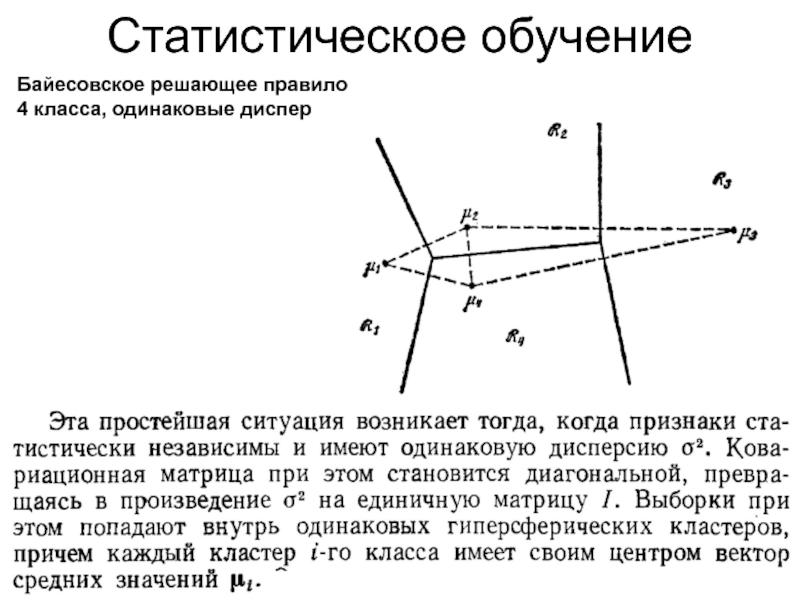

- 42. Статистическое обучение Байесовское решающее правило4 класса, одинаковые дисперсии

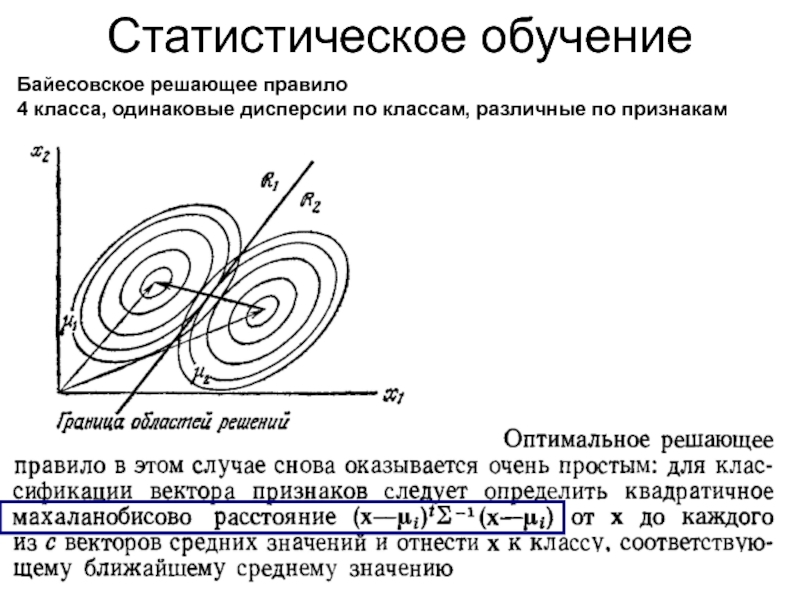

- 43. Статистическое обучение Байесовское решающее правило4 класса, одинаковые дисперсии по классам, различные по признакам

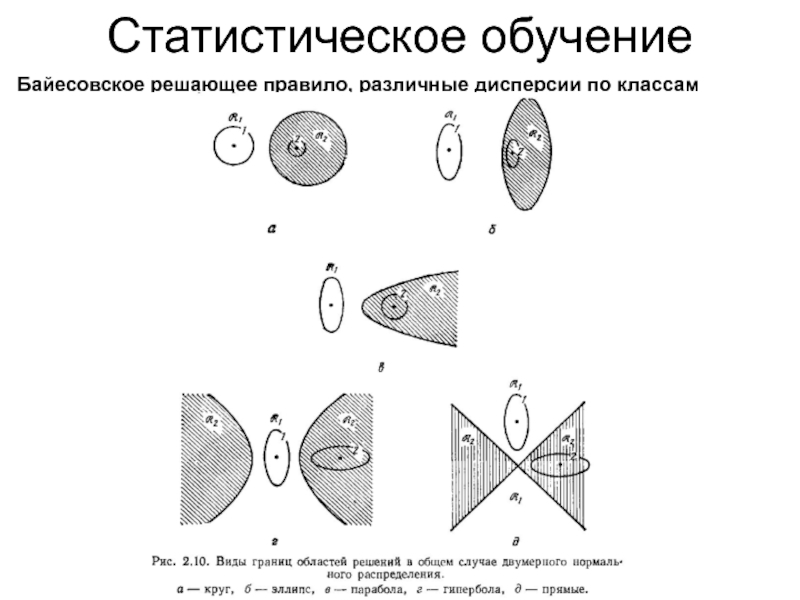

- 44. Статистическое обучение Байесовское решающее правило, различные дисперсии по классам

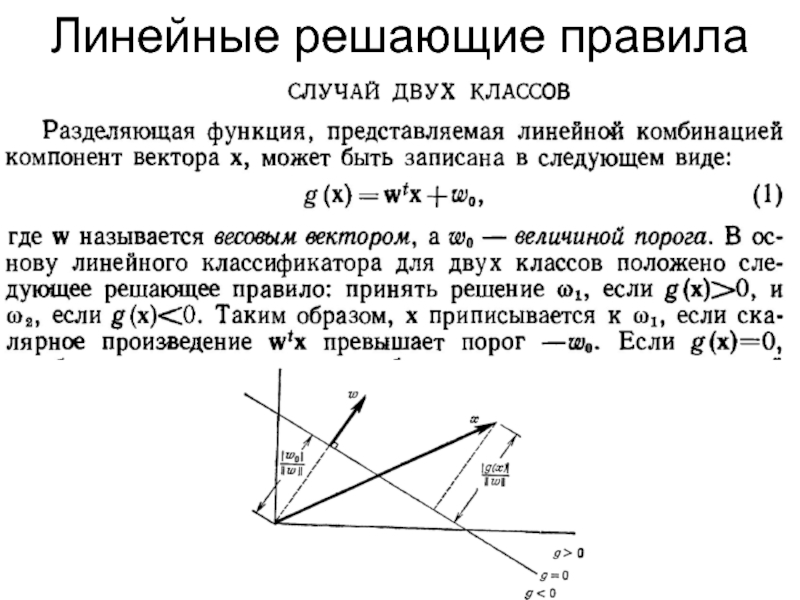

- 45. Линейные решающие правила

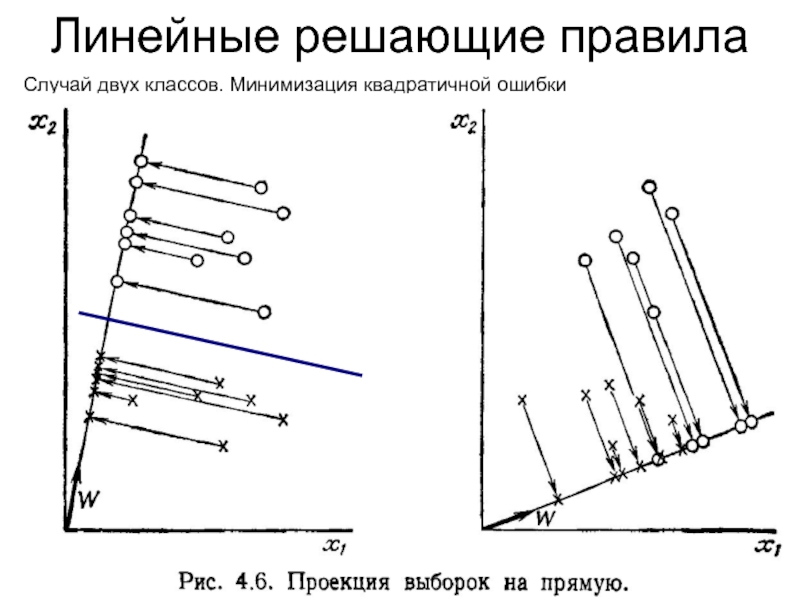

- 46. Линейные решающие правила Случай двух классов. Минимизация квадратичной ошибки

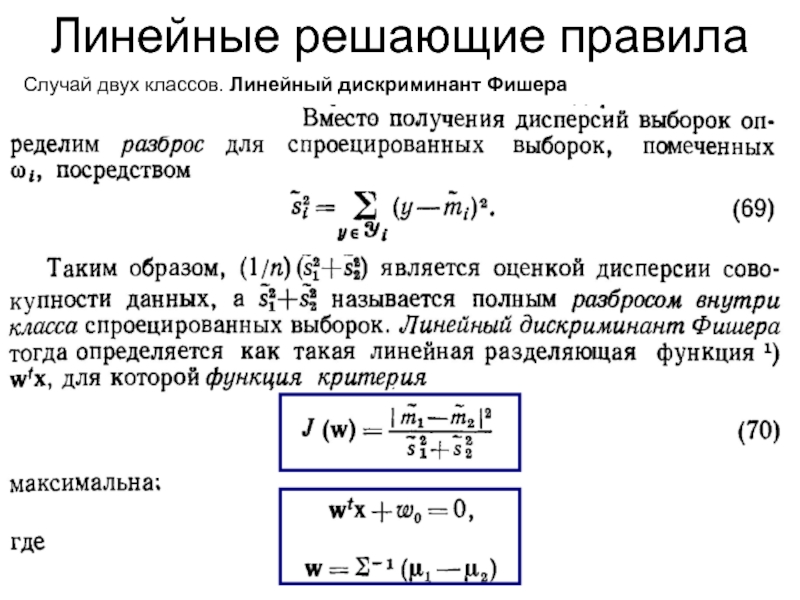

- 47. Линейные решающие правила Случай двух классов. Линейный дискриминант Фишера:

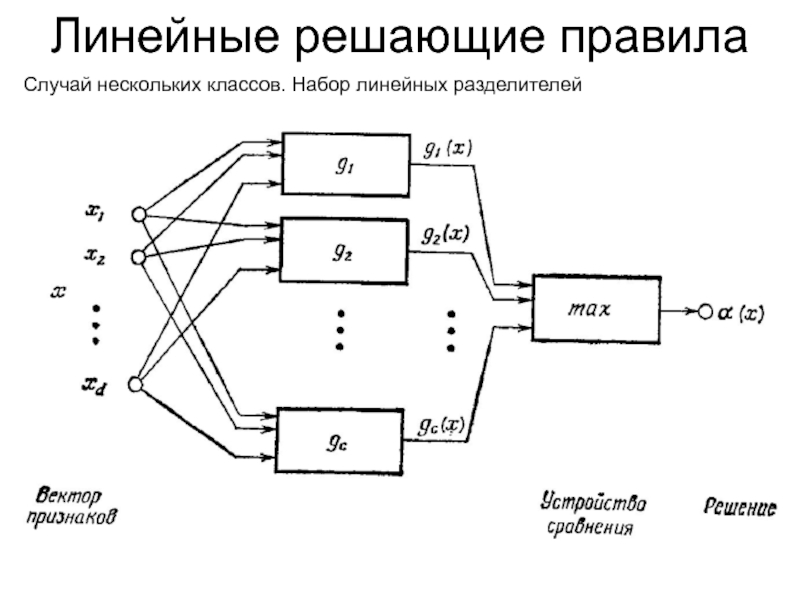

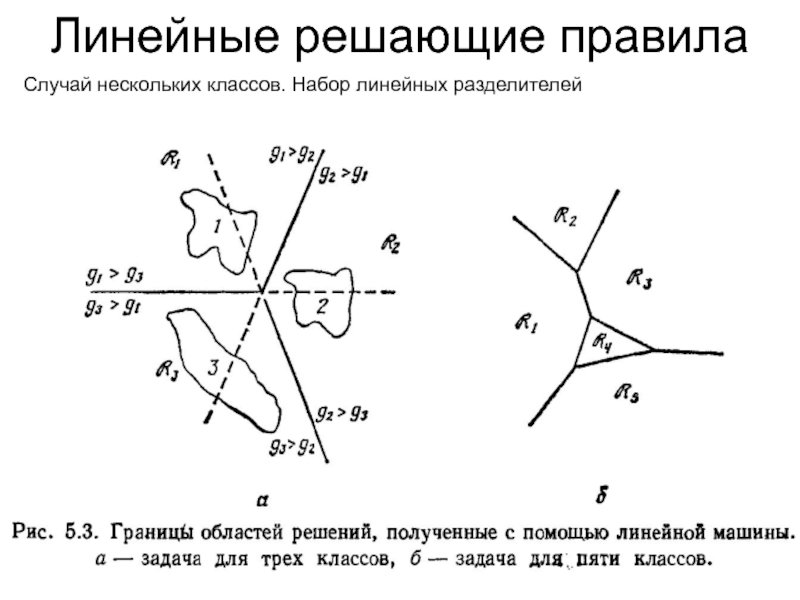

- 48. Линейные решающие правила Случай нескольких классов. Набор линейных разделителей

- 49. Линейные решающие правила Случай нескольких классов. Набор линейных разделителей

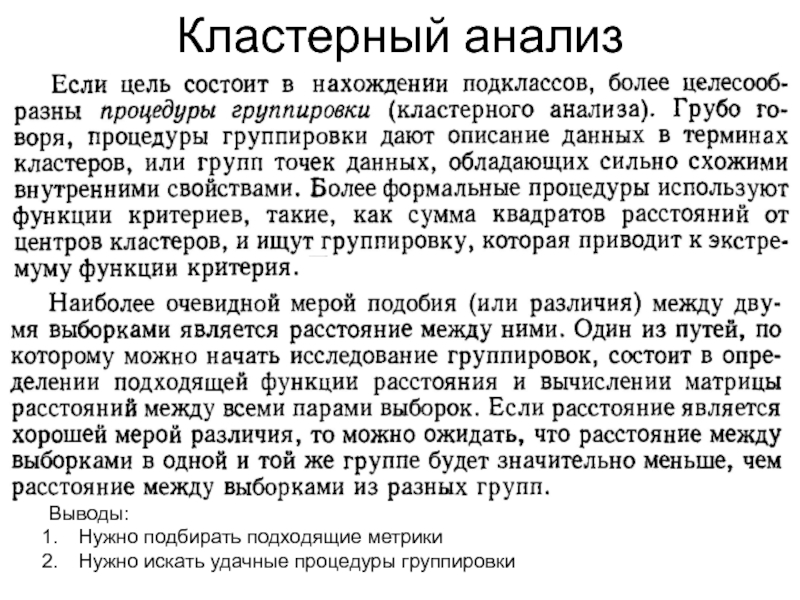

- 50. Кластерный анализ Выводы:Нужно подбирать подходящие метрикиНужно искать удачные процедуры группировки

- 51. Напоминание: Метрики (расстояния) Метрики в нормированных линейных пространствахЕдиничный шар в метриках Минковского:

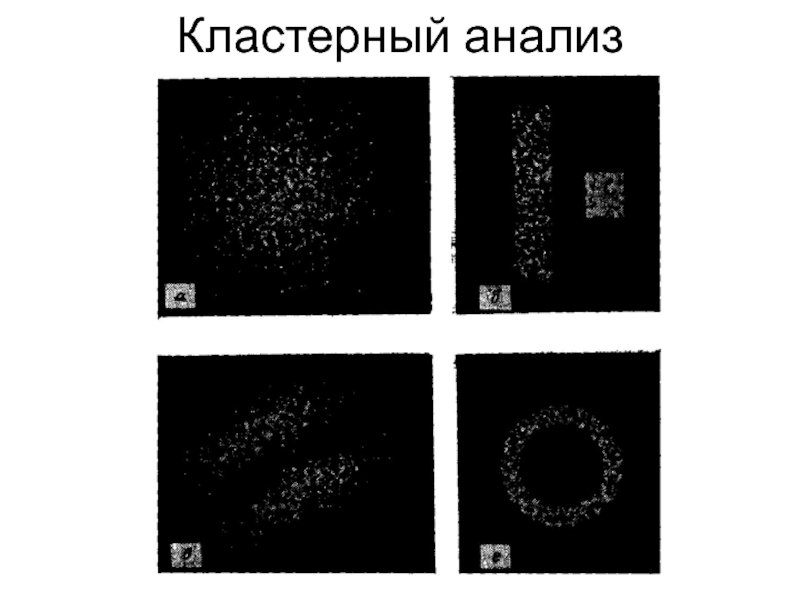

- 52. Кластерный анализ

- 53. Кластерный анализ

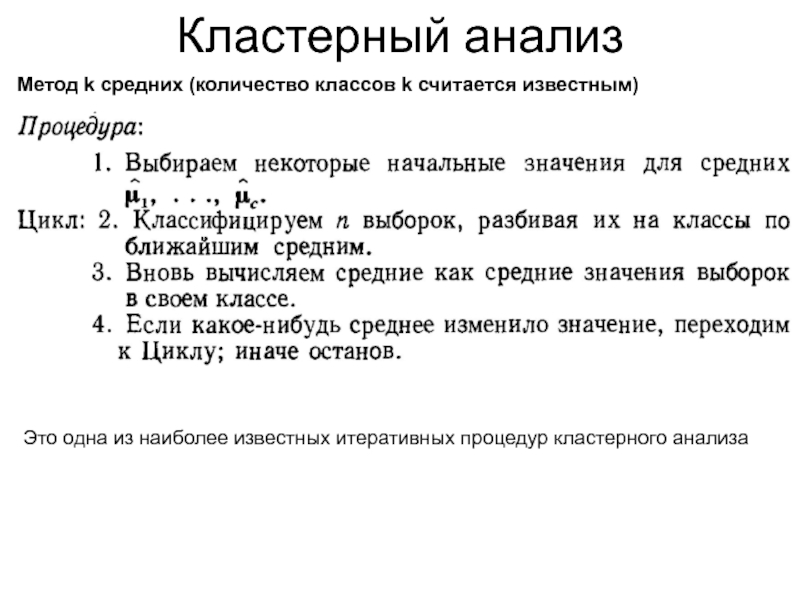

- 54. Кластерный анализ Метод k средних (количество классов

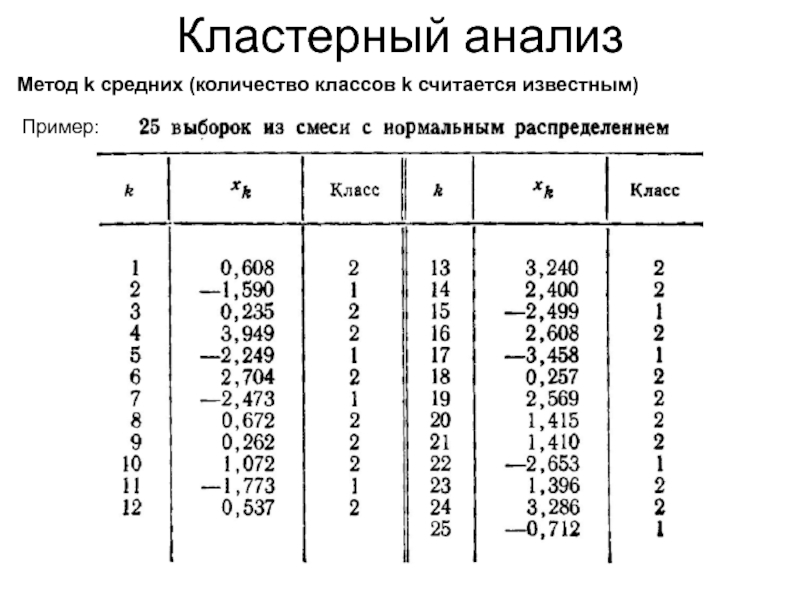

- 55. Кластерный анализ Метод k средних (количество классов k считается известным)Пример:

- 56. Кластерный анализ Метод k средних (количество классов k считается известным)

- 57. Кластерный анализ Метод k средних (количество классов k считается известным)

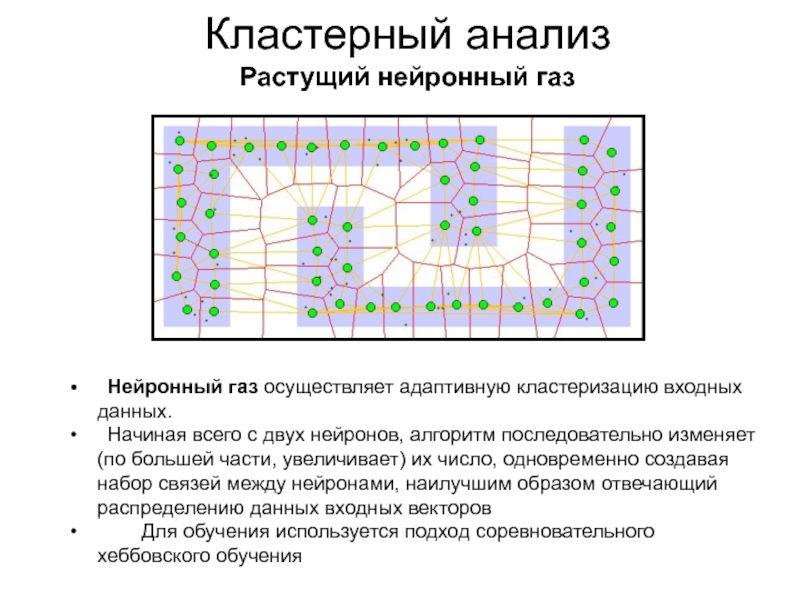

- 58. Кластерный анализ Растущий нейронный газ Нейронный газ осуществляет

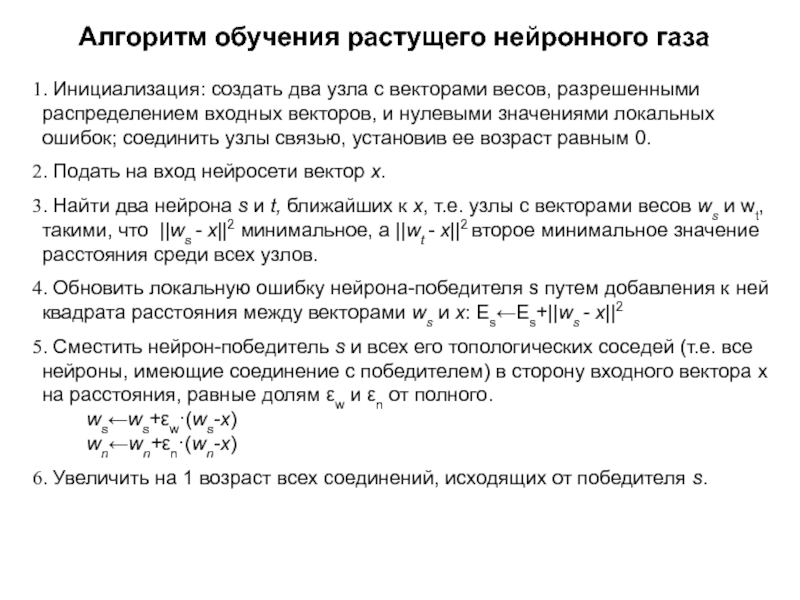

- 59. Алгоритм обучения растущего нейронного газа. Инициализация: создать

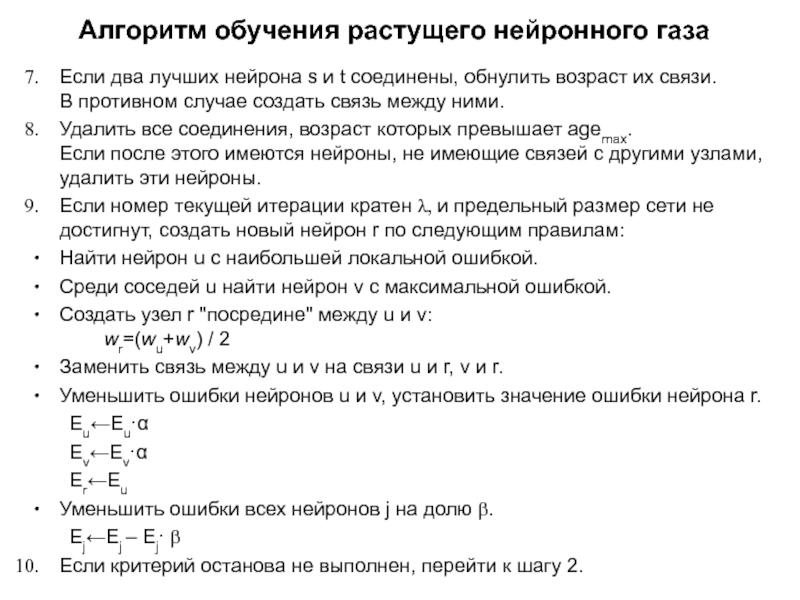

- 60. Алгоритм обучения растущего нейронного газаЕсли два лучших

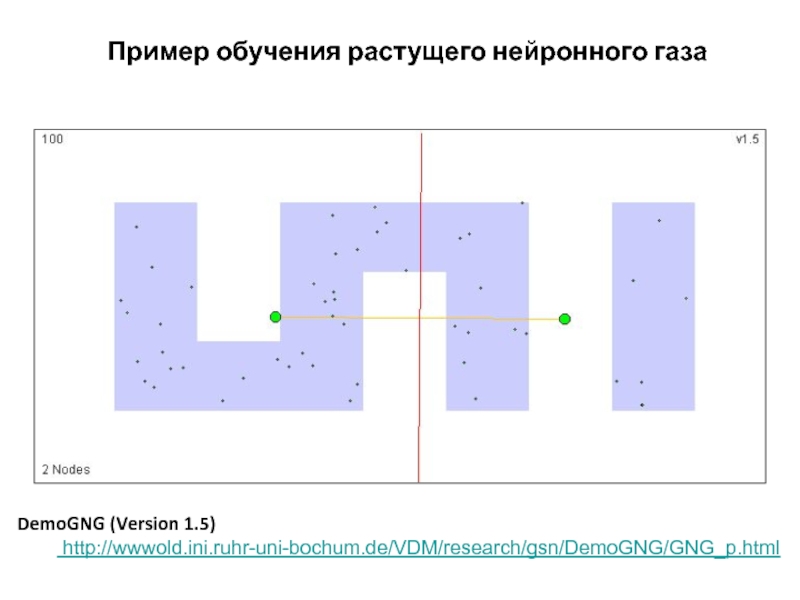

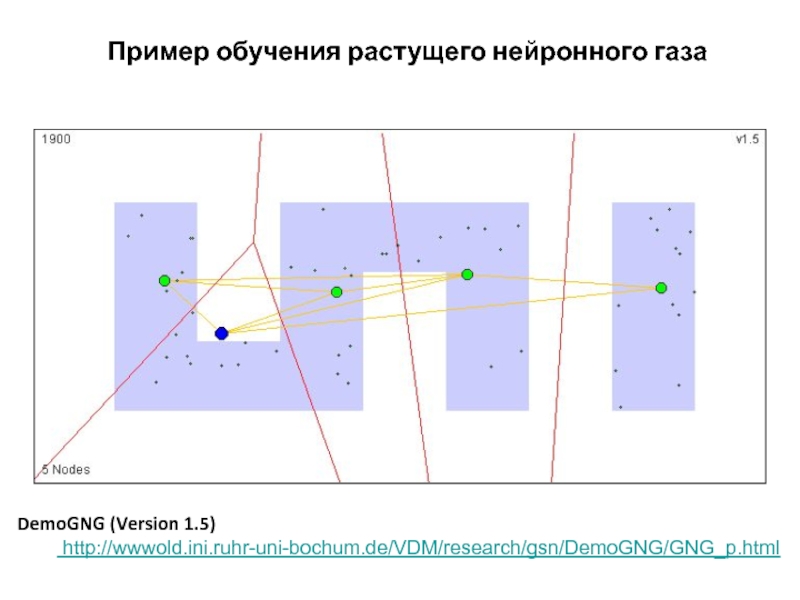

- 61. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

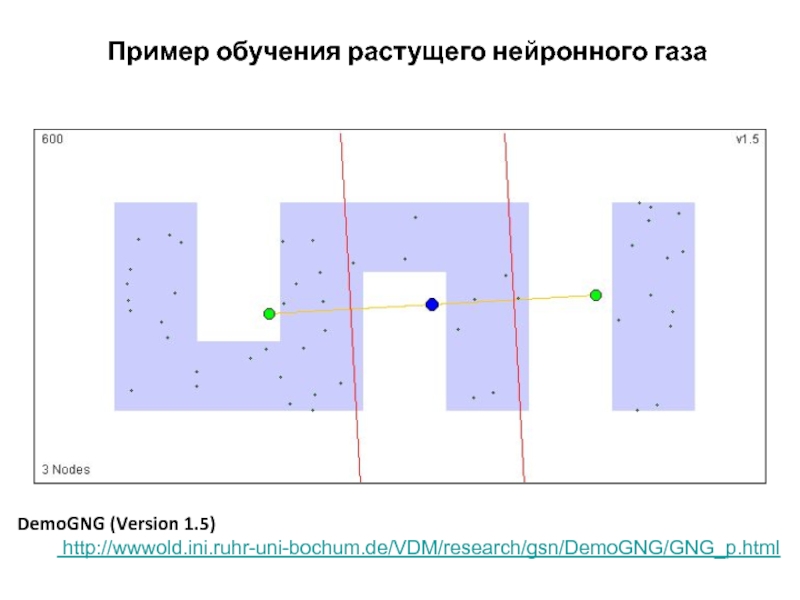

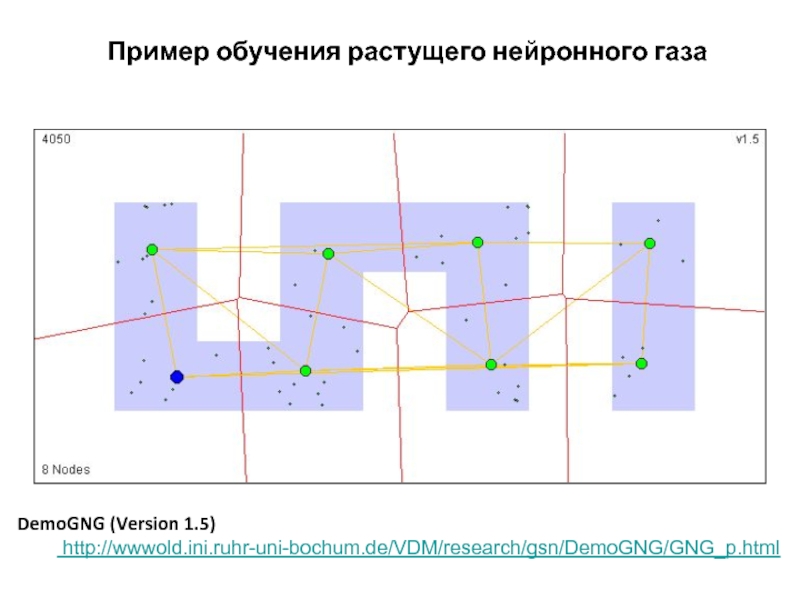

- 62. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

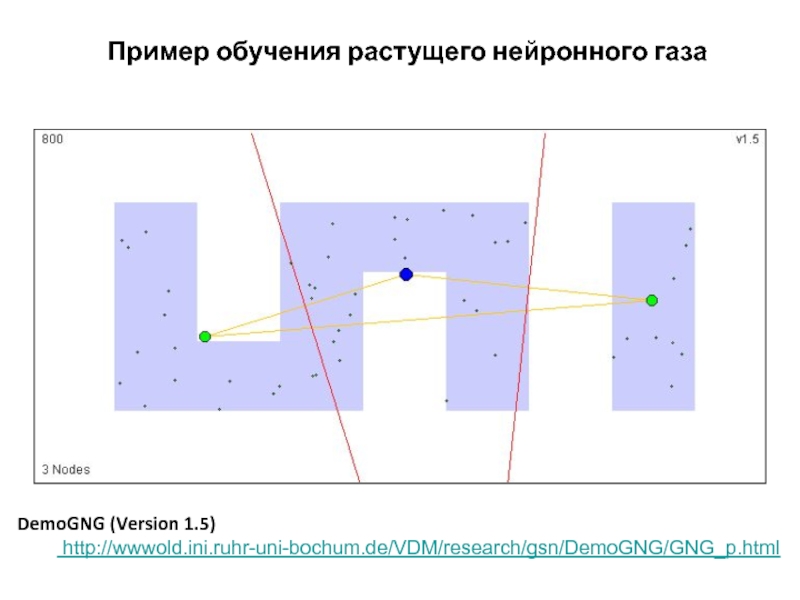

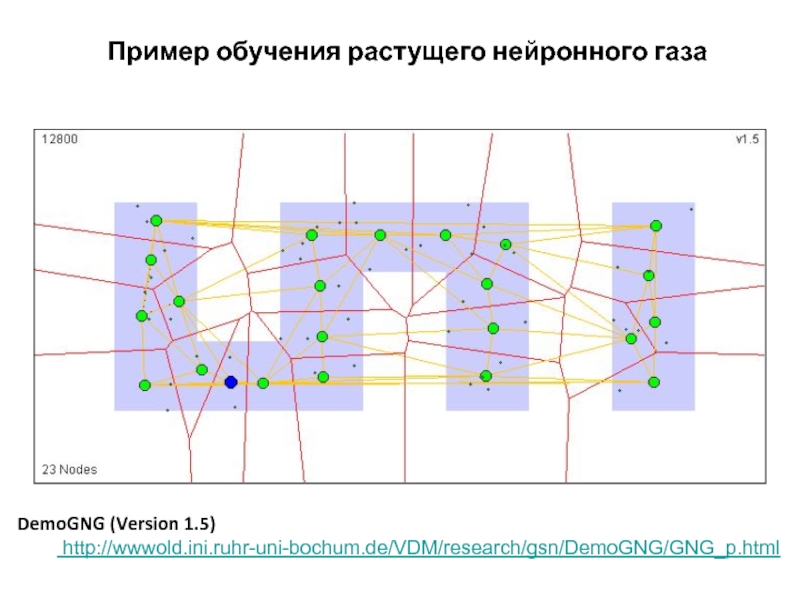

- 63. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

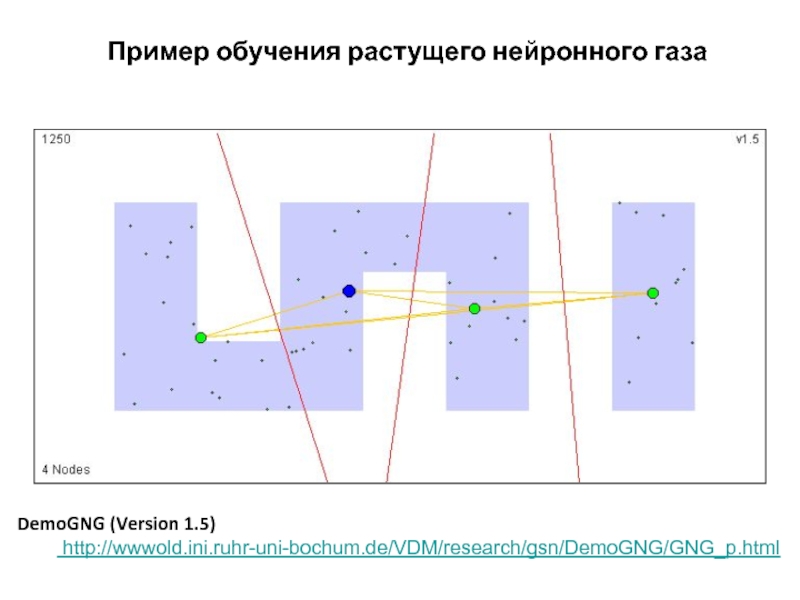

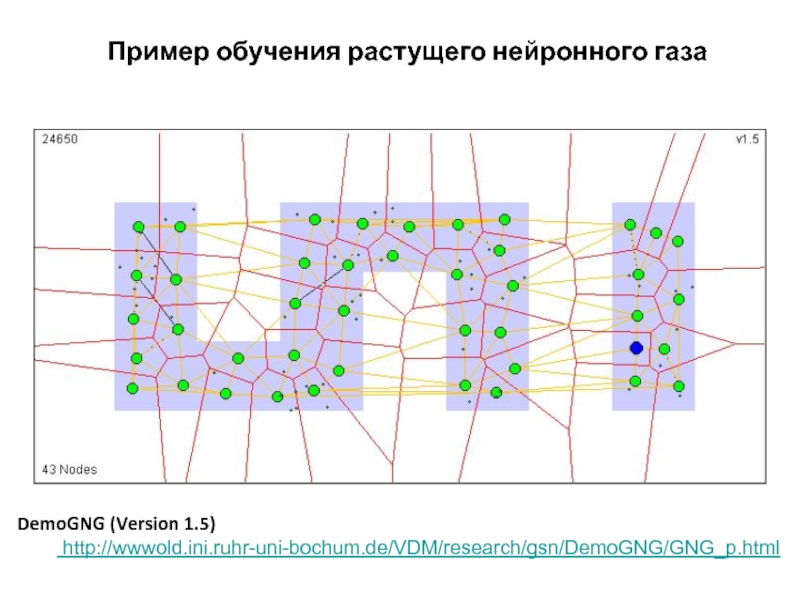

- 64. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

- 65. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

- 66. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

- 67. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

- 68. Пример обучения растущего нейронного газаDemoGNG (Version 1.5) http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

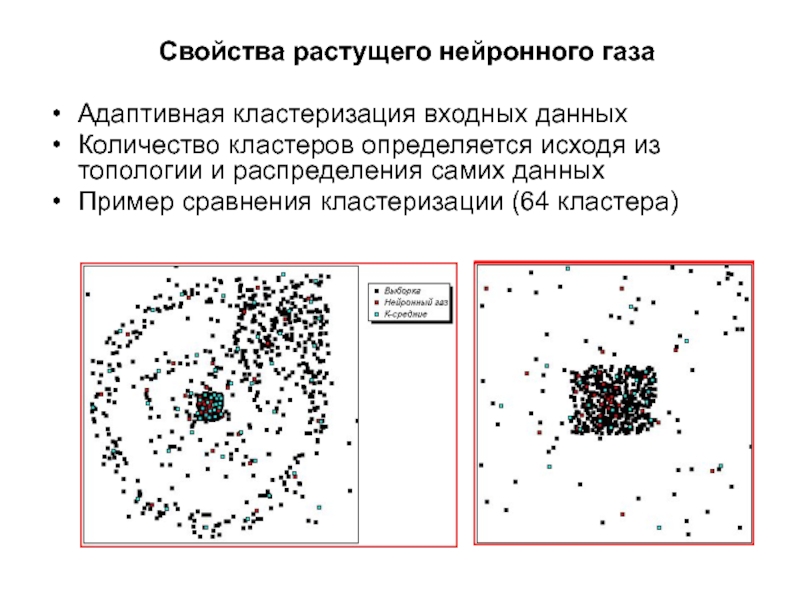

- 69. Свойства растущего нейронного газаАдаптивная кластеризация входных данных

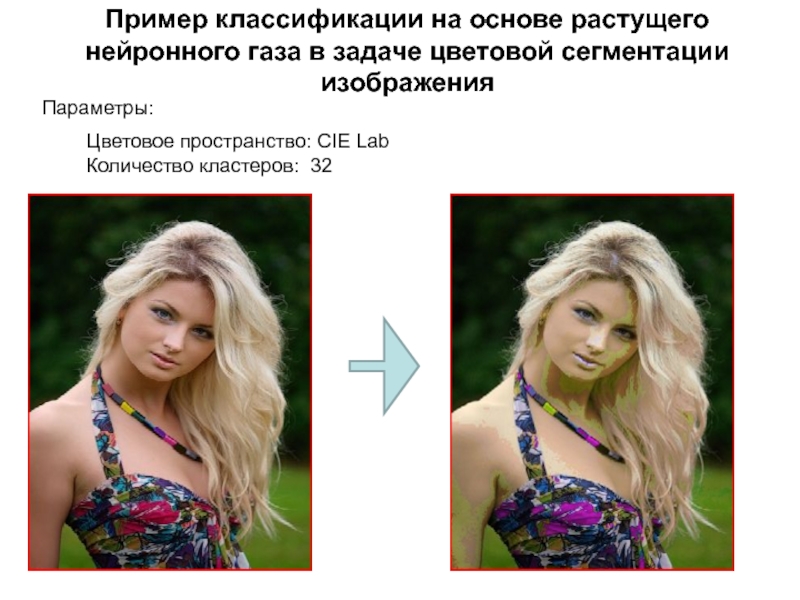

- 70. Пример классификации на основе растущего нейронного газа

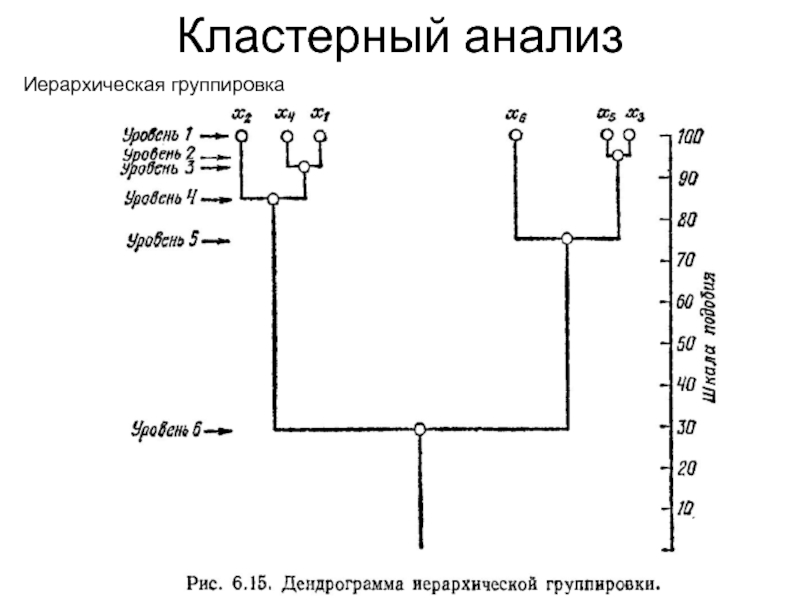

- 71. Кластерный анализ Иерархическая группировка

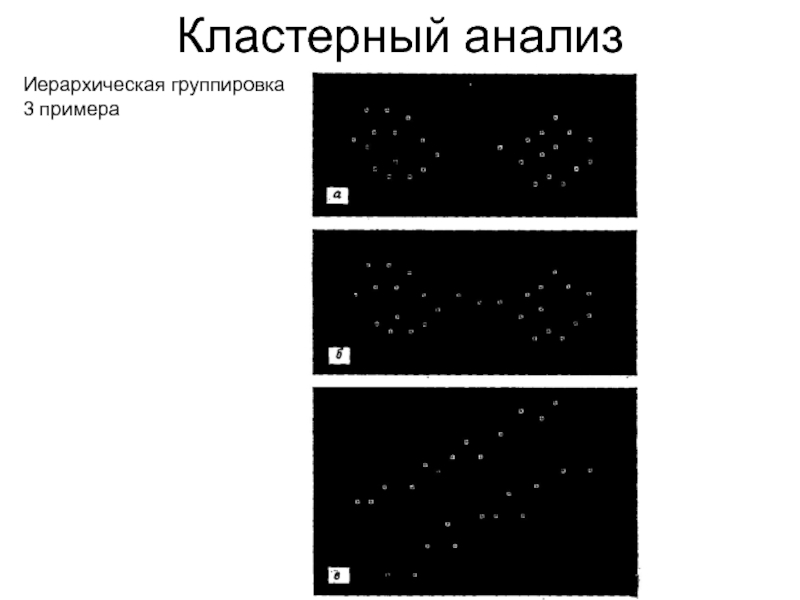

- 72. Кластерный анализ Иерархическая группировка3 примера

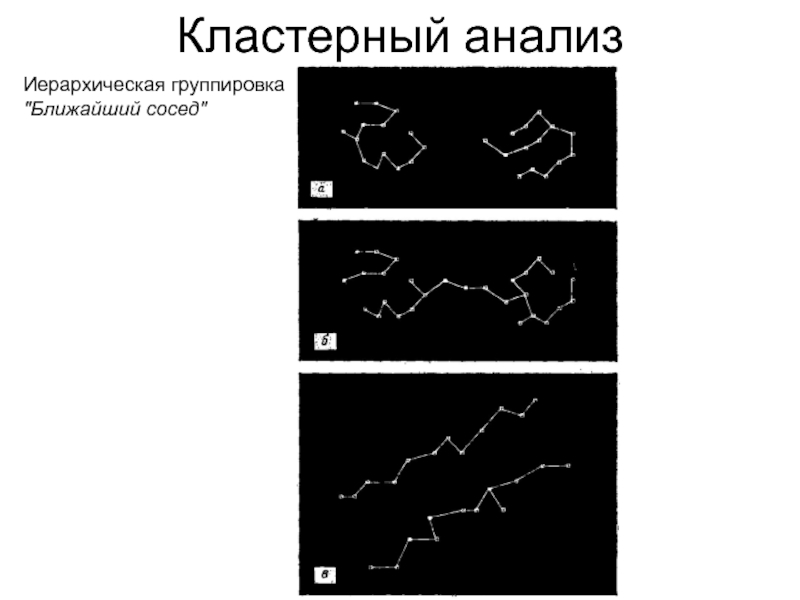

- 73. Кластерный анализ Иерархическая группировка"Ближайший сосед"

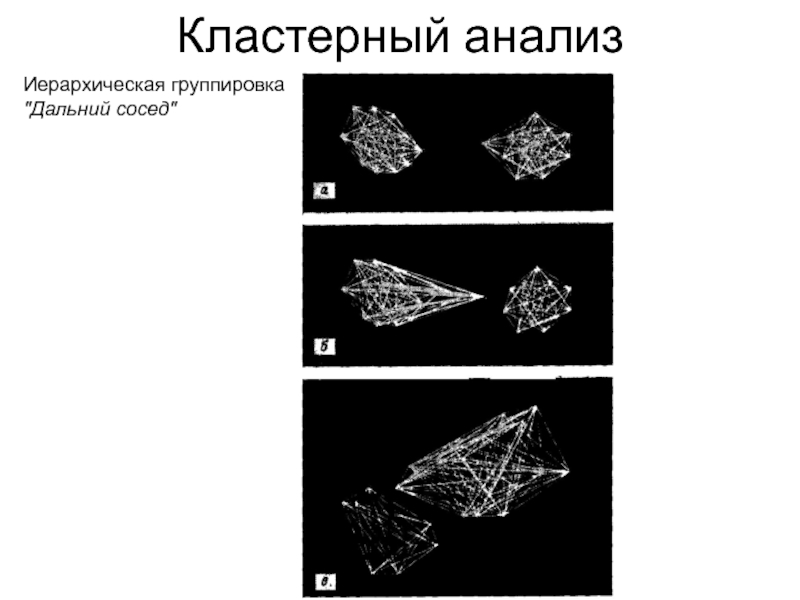

- 74. Кластерный анализ Иерархическая группировка"Дальний сосед"

- 75. Кластерный анализ Иерархическая группировкаМинимальное покрывающеедерево

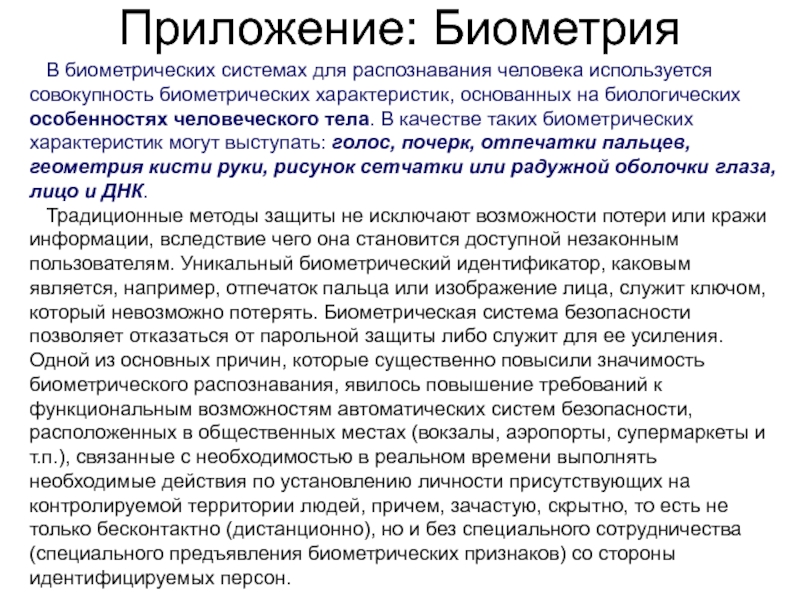

- 76. Приложение: Биометрия В биометрических системах для

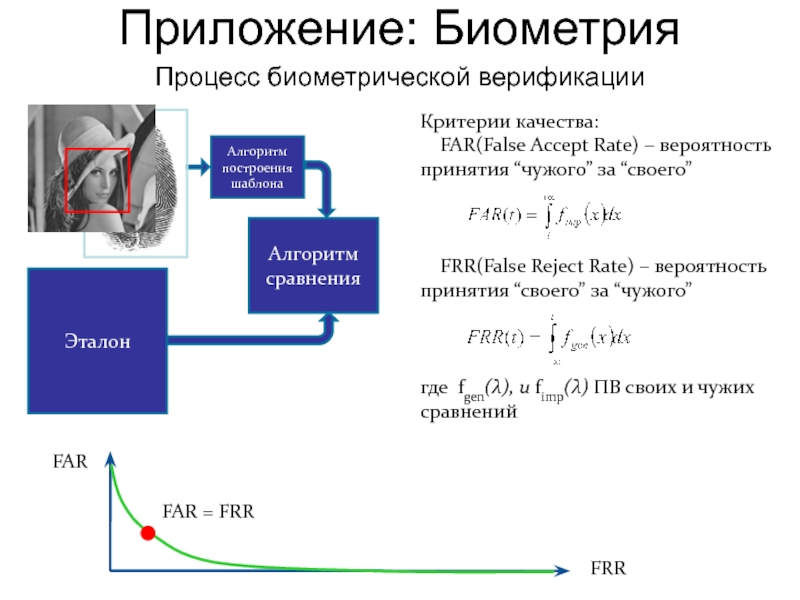

- 77. Процесс биометрической верификацииАлгоритм построения шаблонаАлгоритм сравненияКритерии качества:

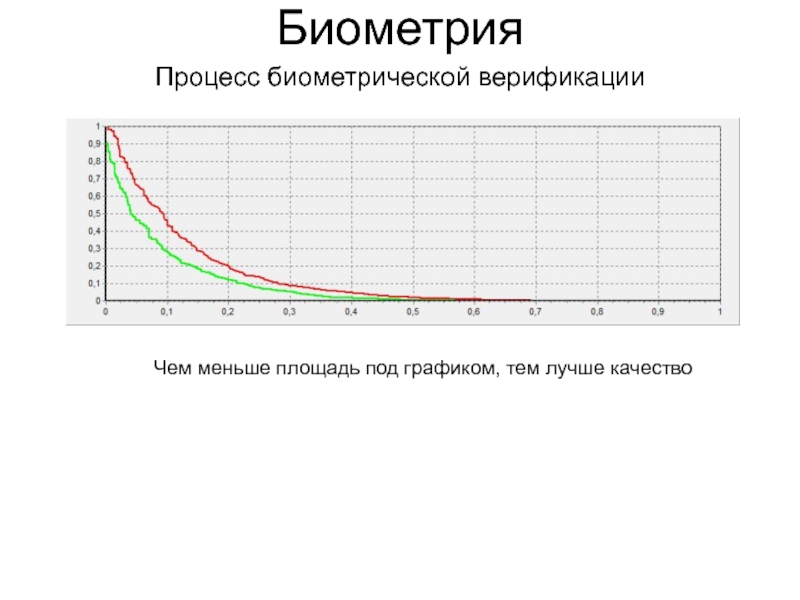

- 78. Процесс биометрической верификацииБиометрияЧем меньше площадь под графиком, тем лучше качество

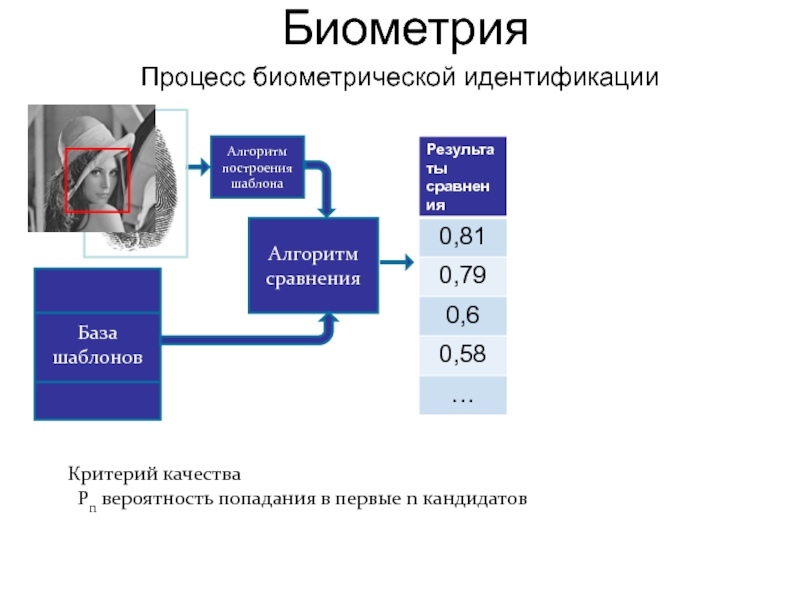

- 79. Процесс биометрической идентификацииАлгоритм построения шаблонаАлгоритм сравненияБаза шаблоновКритерий качества Pn вероятность попадания в первые n кандидатовБиометрия

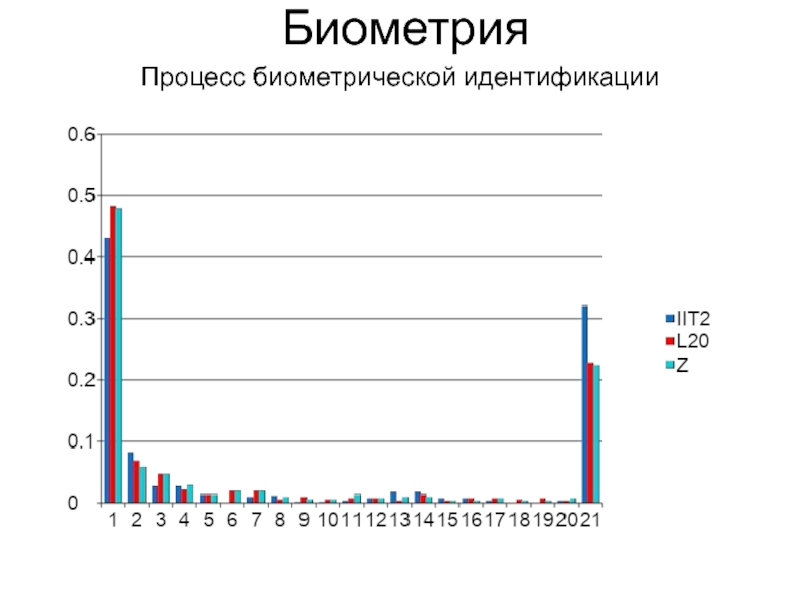

- 80. Процесс биометрической идентификацииБиометрия

- 81. Дальнейшее – в отдельном файле…Биометрия

- 82. Скачать презентанцию

Слайды и текст этой презентации

Слайд 1КОМПЬЮТЕРНЫЕ МЕТОДЫ ОБРАБОТКИ ИНФОРМАЦИИ

Лекция 13-14 (С)

Компьютерное распознавание образов и

машинное обучение

Слайд 2Содержание курса

«Компьютерные методы обработки информации»

Раздел 1. «Базовые методы

компьютерной обработки информации»

Принципы построения систем компьютерной обработки информации

Методы компьютерного

представления информации Численные методы решения задач. Отыскание оптимальных решений

Раздел 2. «Методы обработки сигналов и изображений»

Случайности, шумы, искажения. Оценивание, фильтрация

Цифровые преобразования сигналов и изображений

Сравнение данных. Поиск данных

Сегментация и описание данных. Описание формы изображений

Анализ динамически меняющихся данных

Раздел 3. «Методы интеллектуального анализа данных»

Компьютерное моделирование человеческих рассуждений

Компьютерное распознавание образов и машинное обучение

Слайд 3Содержание лекции

Обучение с учителем. Пространство признаков. Классы. Обучающая и

тестовая выборки. Гипотеза компактности. Методы ближайших соседей. Переобучение и регуляризация.

Статистические методы. Линейные разделители. Максимизация правдоподобия и апостериорной вероятности. Байесовское обучение. Автоматическое распознавание. Ошибки первого и второго рода.

Обучение без учителя. Кластерный анализ. Иерархическая группировка. Методы, основанные на теории графов.

Биометрия. Критерии качества биометрической верификации и идентификации. Дактилоскопия. Обнаружение и распознавания лиц.

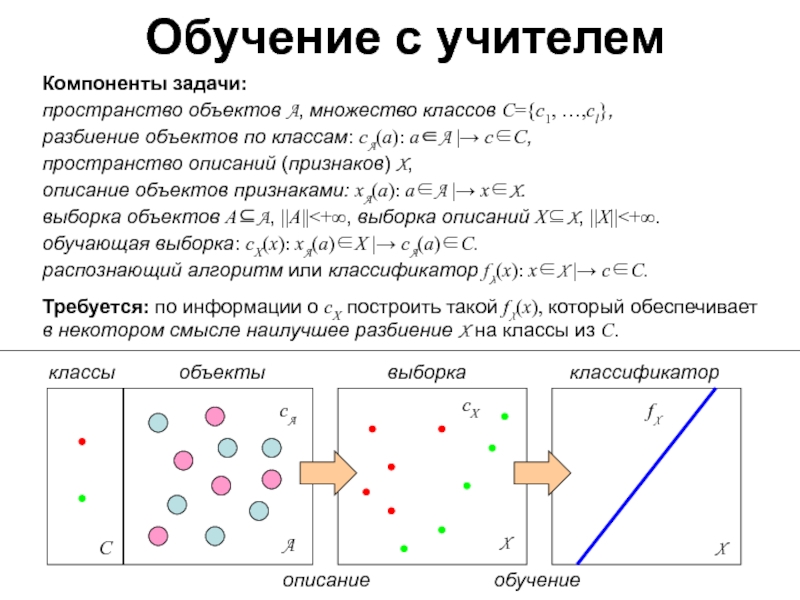

Слайд 4Обучение с учителем

Компоненты задачи:

пространство объектов A, множество классов С={c1,

…,cl}, разбиение объектов по классам: сA(a): a∈A |→ с∈С, пространство описаний (признаков)

X, описание объектов признаками: xA(a): a∈A |→ x∈X. выборка объектов A⊆A, ||A||<+∞, выборка описаний X⊆X, ||X||<+∞. обучающая выборка: сX(x): xA(a)∈X |→ сA(a)∈С. распознающий алгоритм или классификатор fX(x): x∈X |→ с∈С.Требуется: по информации о сX построить такой fX(x), который обеспечивает в некотором смысле наилучшее разбиение X на классы из C.

A

X

X

С

сA

fX

сX

описание

обучение

объекты

выборка

классификатор

классы

Слайд 5Задача синтеза классификатора.

Как описать «наилучшее разбиение»?

Дополнительные компоненты задачи:

Тестовая выборка

с′Y(x): x∈Y |→ с∈С, Y⊆X, Y∩ X=∅,

||Y||<+∞,Критерий эмпирического риска на выборке Y:

JY(fX) = dH(fY, с′Y) / || Y ||,

dH(fY, с′Y) = ∑ x∈Y 1(f(x) ≠ с′(x)) – число ошибок классификации на выборке Y.

|| Y || = ∑ x∈Y 1 – объем выборки Y.

X

X

fX

сX

обучение

выборка X

классификатор

Y

сY

выборка Y

тестирование

ошибки

fX

Слайд 6Задача синтеза классификатора.

Как описать «наилучшее разбиение»?

Дополнительные компоненты задачи:

Тестовая выборка

с′Y(x): x∈Y |→ с∈С, Y⊆X, Y∩ X=∅,

||Y||<+∞,Критерий эмпирического риска на выборке Y:

JY(fX) = dH(fY, с′Y) / || Y ||,

dH(fY, с′Y) = ∑ x∈Y 1(f(x) ≠ с′(x)) – число ошибок классификации на выборке Y.

|| Y || = ∑ x∈Y 1 – объем выборки Y.

Критерий среднего ожидаемого риска

JX(fX) = EY⊆X {JY(fX)},

где EY⊆X {.} – математическое ожидание по всем возможным выборкам Y⊆X.

Требуется: Определить оператор оптимального синтеза θ, доставляющий минимум критерию JX(fX):

θ: сX∈ΩX |→ fX∈ΩX,

θ = arg minθ′ {JX(θ′сX)}, (1)

где ΩX и ΩX – множества всех возможных разбиений выборки X и пространства X по классам из C.

Слайд 7Синтез классификатора. Анализ постановки задачи

Требуется: Определить оператор оптимального синтеза

θ, доставляющий минимум критерию JX(fX):

θ: сX∈ΩX

|→ fX∈ΩX,θ = arg minθ′ {JX(θ′сX)}, (1)

где ΩX и ΩX – множества всех возможных разбиений выборки X и пространства X по классам из C.

Проблемы:

. Невозможно оценить матожидание, поскольку нельзя перебрать все подвыборки Y⊆X.

. Невозможно оптимизировать критерий ожидаемого риска, поскольку в момент обучения тестовые выборки нам неизвестны.

. Невозможно оптимизировать критерий ожидаемого риска на ΩX, поскольку невозможно перебрать все разбиения пространства признаков.

. Невозможно оптимизировать критерий ожидаемого риска по θ′, поскольку невозможно перебрать все операторы синтеза классификаторов (стратегии обучения).

Слайд 8

Упрощение задачи: обучение классификатора

вместо синтеза классификатора

Дополнительные компоненты задачи обучения:

Класс

классификаторов FX

Класс алгоритмов обучения Θ для классификаторов из FX на

выборках X⊆X.Оператор обучения:

θ∈Θ: сX∈ΩX |→ fX∈FX ⊆ΩX,

θ = arg minθ′∈Θ {JY(θ′сX)}, (2)

X

сX

X

сX

FX

fX

Слайд 9

Упрощение задачи: обучение классификатора

вместо синтеза классификатора

Дополнительные компоненты задачи обучения:

Класс

классификаторов FX

Класс алгоритмов обучения Θ для классификаторов из FX на

выборках X⊆X.Оператор обучения:

θ∈Θ: сX∈ΩX |→ fX∈FX ⊆ΩX,

θ = arg minθ′∈Θ {JY(θ′сX)}, (2)

X

сX

X

сX

GX

gX

Слайд 14Упрощение задачи:

наблюдаемый риск вместо ожидаемого

Проблема:

наблюдаемый риск JX(θсX) имеет глобальный

минимум в точке fX ≡ сX, заведомо непригодный для неизвестной

тестовой выборки Y.Решение: теория оценки и контроля переобучения

Эмпирический риск оценивается по обучающей выборке, но сложность решающего правила искусственно ограничивается.

Дополнительные компоненты задачи обучения:

Сложность класса классификаторов Q(FX).

…

VC-размерность класса классификаторов

Слайд 15Упрощение задачи: обучение классификатора заданного класса с регуляризацией по сложности

Требуется: минимизировать наблюдаемый риск с регуляризацией по сложности класса обучаемого

классификатора:θ∈Θ: сX∈ΩX |→ fX∈FX ⊆ΩX,

θ = arg minθ′∈Θ {JX(θ′сX) + αQ(FX)} , (3)

где α≥0 – параметр регуляризации, определяющий компромисс между точностью на X и сложностью классификатора, от которой зависит поведение fX на тестовой выборке Y.

Решение: Метод структурной минимизации риска

Пусть даны: суперкласс FX и последовательность вложенных классов классификаторов нарастающей сложности:

F0X ⊆ F1X ⊆ … ⊆ FjX ⊆ … ⊆ FX ⊆ ΩX :

Q(F0X) ≤ Q(F1X) ≤ … ≤ Q(FjX) ≤ … (4)

Задача (3) последовательно решается для FjX, j=0,1,2,…, пока значения критерия не перестанут улучшаться.

Значение α подбирается методом кросс-валидации с валидационной выборкой Z⊆X, Z∩ X=∅, ||Z||<+∞.

Слайд 16

GX

Источники основных идей

Принцип эмпирической неразличимости алгоритмов, дающих одинаковые результаты на

объектах обучающей выборки.

Вапник В. Н. Восстановление зависимостей по эмпирическим

данным. - М.: Наука, 1979.Воронцов К.В. Комбинаторная теория надёжности обучения по прецедентам. Диссертация на соискание ученой степени доктора физико-математических наук. ВЦ им. А. А. Дородницына РАН. Москва, 2010.

X

gX

gX

X

fX

FX

fX

Слайд 17

Источники основных идей

Принцип компактности: более близкие объекты должны с большей

вероятностью принадлежать к одному классу.

Айзерман М. А., Браверман Э.

М., Розоноэр Л. И. Метод потенциальных функций в теории обучения машин. М.: Наука, 1970. 320 pp.Хачай М. Ю. Топологический подход к выводу условий равномерной по классу событий сходимости частот к вероятностям. // Интеллектуализация обработки информации: 8-я международная конференция (ИОИ-8), Кипр, г.Пафос, 2010 г.: Сборник докладов. – М.: МАКС Пресс, 2010, с.91-94.

Неразличимость + Компактность ⇒ мы можем рассматривать задачу синтеза классификатора как задачу наилучшей разметки (optimal labeling) или «раскрашивания» точек обучающей выборки, связанных отношениями соседства.

Таким образом, из области распознавания образов или машинного обучения мы переходим в область анализа изображений и можем применять методы машинного зрения и машинной графики.

компактный класс

локально компактные классы

некомпактные классы

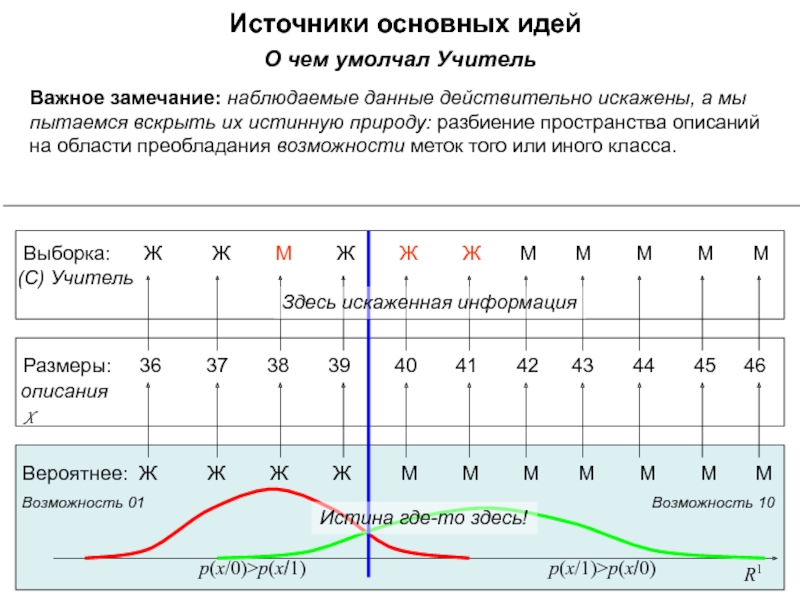

Слайд 18

О

чем умолчал УчительВажное замечание: наблюдаемые данные действительно искажены, а мы пытаемся вскрыть их истинную природу: разбиение пространства описаний на области преобладания возможности меток того или иного класса.

Источники основных идей

Размеры: 36 37 38 39 40 41 42 43 44 45 46

A

описания

объекты

X

Обувь:

Пол: Ж Ж М Ж Ж Ж М М М М М

(С) Учитель

Слайд 19

О

чем умолчал УчительВажное замечание: наблюдаемые данные действительно искажены, а мы пытаемся вскрыть их истинную природу: разбиение пространства описаний на области преобладания возможности меток того или иного класса.

Источники основных идей

Размеры: 36 37 38 39 40 41 42 43 44 45 46

описания

X

Выборка: Ж Ж М Ж Ж Ж М М М М М

(С) Учитель

R1

p(x/0)>p(x/1)

Возможность 01

Возможность 10

p(x/1)>p(x/0)

Вероятнее: Ж Ж Ж Ж М М М М М М М

Истина где-то здесь!

Здесь искаженная информация

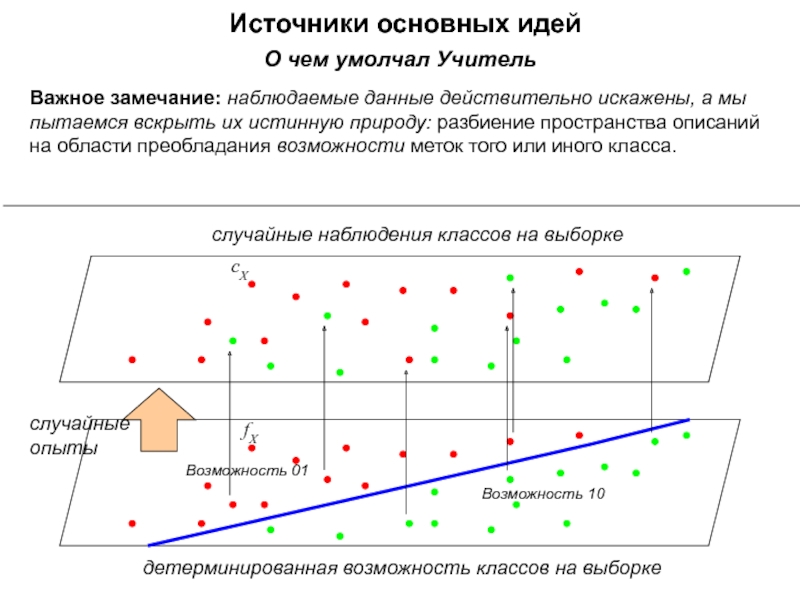

Слайд 20Источники основных идей

сX

fX

Возможность 01

Возможность 10

случайные

опыты

детерминированная возможность классов на выборке

случайные наблюдения

классов на выборке

О чем умолчал УчительВажное замечание: наблюдаемые данные действительно искажены, а мы пытаемся вскрыть их истинную природу: разбиение пространства описаний на области преобладания возможности меток того или иного класса.

Слайд 24Напоминание. Функции распределения

Площадь под функцией распределения всегда = 1,

поскольку хоть какое-то значение случайная величина принимает с вероятностью 1.

Слайд 32Статистическое обучение

Случай двух классов. Байесовское правило

Вероятность ошибки определяется выражением:

Слайд 34Статистическое обучение

Случай двух классов. Байесовское правило. Отношение правдоподобия

Ожидаемый (средний)

риск при принятии решения:

Слайд 35Статистическое обучение

Случай двух классов. Байесовское правило. Отношение правдоподобия

Ожидаемый (средний)

риск при принятии решения:

Слайд 43Статистическое обучение

Байесовское решающее правило

4 класса, одинаковые дисперсии по классам,

различные по признакам

Слайд 50Кластерный анализ

Выводы:

Нужно подбирать подходящие метрики

Нужно искать удачные процедуры группировки

Слайд 51Напоминание: Метрики (расстояния)

Метрики в нормированных линейных пространствах

Единичный шар в

метриках Минковского:

Слайд 54Кластерный анализ

Метод k средних (количество классов k считается известным)

Это

одна из наиболее известных итеративных процедур кластерного анализа

Слайд 58Кластерный анализ

Растущий нейронный газ

Нейронный газ осуществляет адаптивную кластеризацию входных данных.

Начиная всего с двух нейронов, алгоритм последовательно изменяет (по большей

части, увеличивает) их число, одновременно создавая набор связей между нейронами, наилучшим образом отвечающий распределению данных входных векторовДля обучения используется подход соревновательного хеббовского обучения

Слайд 59Алгоритм обучения растущего нейронного газа

. Инициализация: создать два узла с

векторами весов, разрешенными распределением входных векторов, и нулевыми значениями локальных

ошибок; соединить узлы связью, установив ее возраст равным 0.. Подать на вход нейросети вектор x.

. Найти два нейрона s и t, ближайших к x, т.е. узлы с векторами весов ws и wt, такими, что ||ws - x||2 минимальное, а ||wt - x||2 второе минимальное значение расстояния среди всех узлов.

. Обновить локальную ошибку нейрона-победителя s путем добавления к ней квадрата расстояния между векторами ws и x: Es←Es+||ws - x||2

. Сместить нейрон-победитель s и всех его топологических соседей (т.е. все нейроны, имеющие соединение с победителем) в сторону входного вектора x на расстояния, равные долям εw и εn от полного. ws←ws+εw·(ws-x) wn←wn+εn·(wn-x)

. Увеличить на 1 возраст всех соединений, исходящих от победителя s.

Слайд 60Алгоритм обучения растущего нейронного газа

Если два лучших нейрона s и

t соединены, обнулить возраст их связи. В противном случае создать связь

между ними.Удалить все соединения, возраст которых превышает agemax. Если после этого имеются нейроны, не имеющие связей с другими узлами, удалить эти нейроны.

Если номер текущей итерации кратен λ, и предельный размер сети не достигнут, создать новый нейрон r по следующим правилам:

Найти нейрон u с наибольшей локальной ошибкой.

Среди соседей u найти нейрон v с максимальной ошибкой.

Создать узел r "посредине" между u и v: wr=(wu+wv) / 2

Заменить связь между u и v на связи u и r, v и r.

Уменьшить ошибки нейронов u и v, установить значение ошибки нейрона r.

Eu←Eu·α

Ev←Ev·α

Er←Eu

Уменьшить ошибки всех нейронов j на долю β.

Ej←Ej – Ej· β

Если критерий останова не выполнен, перейти к шагу 2.

Слайд 61Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 62Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 63Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 64Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 65Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 66Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 67Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 68Пример обучения растущего нейронного газа

DemoGNG (Version 1.5)

http://wwwold.ini.ruhr-uni-bochum.de/VDM/research/gsn/DemoGNG/GNG_p.html

Слайд 69

Свойства растущего нейронного газа

Адаптивная кластеризация входных данных

Количество кластеров определяется

исходя из топологии и распределения самих данных

Пример сравнения кластеризации

(64 кластера)Слайд 70

Пример классификации на основе растущего нейронного газа в задаче цветовой

сегментации изображения

Цветовое пространство: CIE Lab

Количество кластеров: 32

Параметры:

Слайд 76

Приложение: Биометрия

В биометрических системах для распознавания человека используется

совокупность биометрических характеристик, основанных на биологических особенностях человеческого тела. В

качестве таких биометрических характеристик могут выступать: голос, почерк, отпечатки пальцев, геометрия кисти руки, рисунок сетчатки или радужной оболочки глаза, лицо и ДНК.Традиционные методы защиты не исключают возможности потери или кражи информации, вследствие чего она становится доступной незаконным пользователям. Уникальный биометрический идентификатор, каковым является, например, отпечаток пальца или изображение лица, служит ключом, который невозможно потерять. Биометрическая система безопасности позволяет отказаться от парольной защиты либо служит для ее усиления. Одной из основных причин, которые существенно повысили значимость биометрического распознавания, явилось повышение требований к функциональным возможностям автоматических систем безопасности, расположенных в общественных местах (вокзалы, аэропорты, супермаркеты и т.п.), связанные с необходимостью в реальном времени выполнять необходимые действия по установлению личности присутствующих на контролируемой территории людей, причем, зачастую, скрытно, то есть не только бесконтактно (дистанционно), но и без специального сотрудничества (специального предъявления биометрических признаков) со стороны идентифицируемых персон.

Слайд 77Процесс биометрической верификации

Алгоритм построения шаблона

Алгоритм сравнения

Критерии качества:

FAR(False Accept

Rate) – вероятность принятия “чужого” за “своего”

FRR(False Reject

Rate) – вероятность принятия “своего” за “чужого”где fgen(λ), и fimp(λ) ПВ своих и чужих сравнений

Эталон

Приложение: Биометрия

FAR

FRR

FAR = FRR