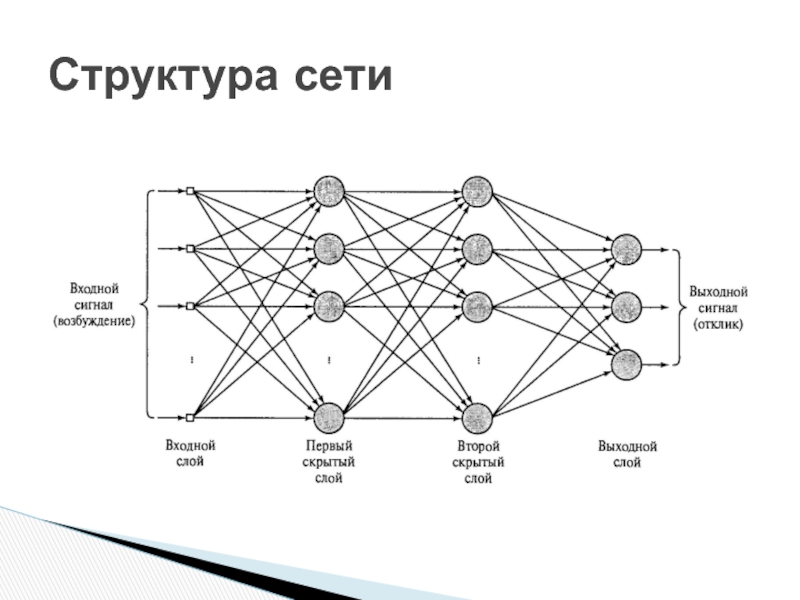

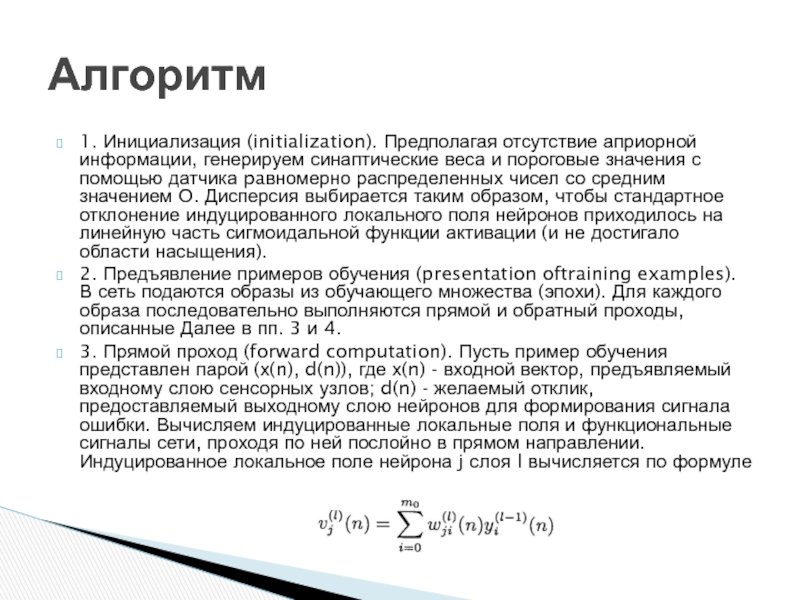

Когда сигнал проходит по сети слева направо, считается, что нейрон

j находится на один слой правеенейрона i, а нейрон k - еще на один слой правее нейрона j, если последний принадлежит скрытому слою.

Итерация (такт времени) n соответствует n-му обучающему образу (примеру), поданному на вход сети.

Символ Е(n) означает текущую сумму квадратов ошибок (или энергию ошибки) на итерации n. Среднее значение Е(n) по всем значениям n (т.е. по всему обучающему множеству) называется средней энергией ошибки Еav

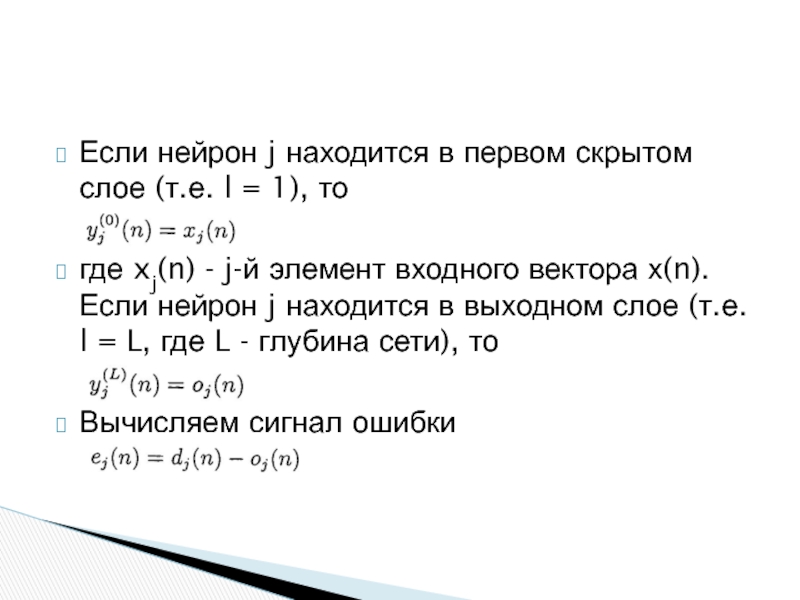

Символ ej(n) описывает сигнал ошибки на выходе нейрона j на итерации n.

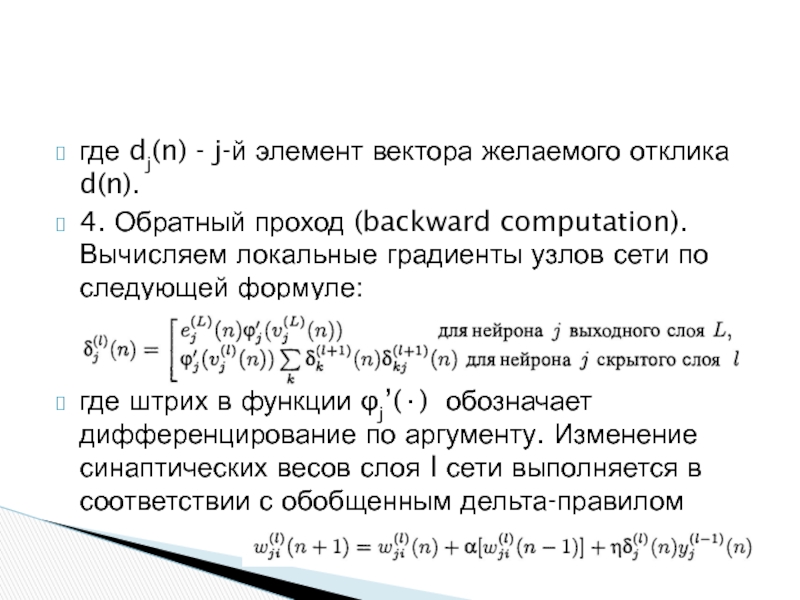

Символ dj(n) означает желаемый отклик нейрона j и используется для вычисления ej(n).

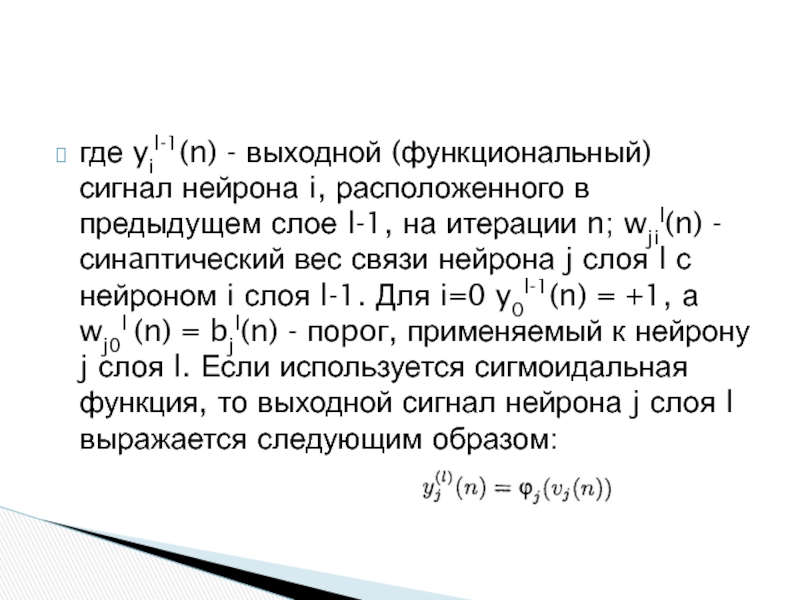

Символ yj(n) описывает функциональный сигнал, генерируемый на выходе нейрона J на итерации n.

Символ wji(n) используется для обозначения синаптическоrо веса, связывающего выход нейрона i со входом нейрона j на итерации n. Коррекция, применяемая к этому весу на шаге n, обозначается Δwji(n)

Обозначения

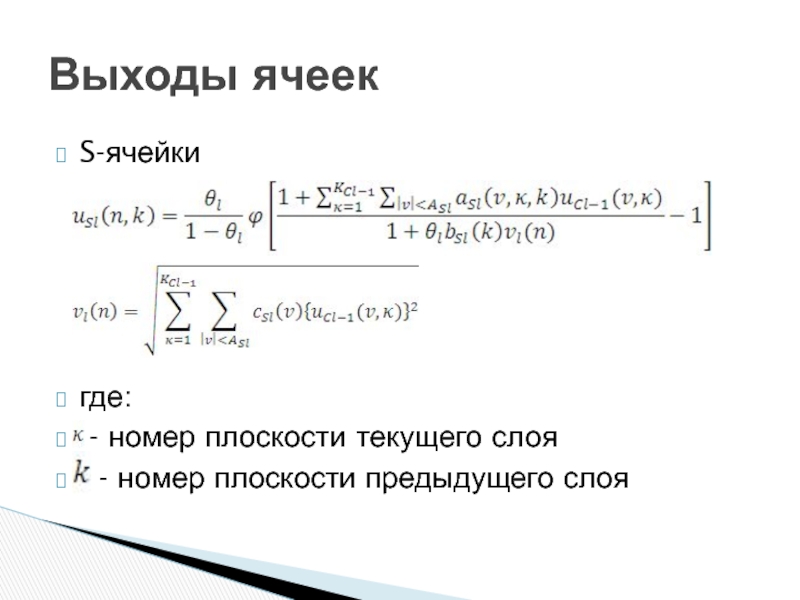

![Искусственные нейронные сети где: -индекс связи; - выход ячейки U0, связанной связью ; где: -индекс связи; - выход ячейки U0, связанной связью ; [x] = max(x; 0);](/img/thumbs/d721e3081103627407663920586bf6fa-800x.jpg)